Alles über die robots.txt Datei: Wie du sie richtig erstellst und überprüfst

Hast du dich jemals gefragt, wie Websites steuern, welche Bereiche für Suchmaschinen tabu sind? Die Antwort liegt in einer kleinen, aber mächtigen Datei namens „robots.txt“. Mit ihr kannst du mit den Bots kommunizieren, die deine Website durchsuchen. Um sie jedoch effektiv zu nutzen, ist ein tieferes Verständnis ihrer „Sprache“ und der Funktionsweise dieser Datei notwendig.

In diesem Artikel erfährst du alles, was du über das robots.txt Erstellen wissen musst: Wie du sie korrekt aufsetzt, Inhalte gezielt steuerst und ihre Wirkung in der SEO optimierst. Zudem geben wir allgemeine Richtlinien für den Inhalt einer robots.txt-Datei.

Lass uns loslegen!

-

Die robots.txt-Datei dient als Leitfaden für Suchmaschinen-Bots und gibt an, welche Seiten gecrawlt werden sollen oder nicht. Beachte jedoch, dass ein Bot diese Anweisungen möglicherweise ignorieren kann.

-

Robots.txt kann das Indexieren nicht direkt verhindern, aber beeinflusst die Entscheidung eines Bots, bestimmte Inhalte zu crawlen oder zu ignorieren.

-

Robots.txt, Meta-Robots-Tags und X-Robots-Tags steuern Suchmaschinen-Bots unterschiedlich: Robots.txt regelt das Crawling, Meta-Tags wirken auf Seitenebene, und X-Robots-Tags ermöglichen eine detailliertere Kontrolle über das Indexieren.

-

Mit der Disallow-Anweisung kannst du irrelevante Inhalte ausblenden, das Crawl-Budget sparen und verhindern, dass unerwünschte Seiten in den Suchergebnissen erscheinen.

-

Durch die Einhaltung der Syntaxregeln stellst du sicher, dass Bots deine robots.txt-Datei korrekt lesen und verstehen können.

-

Robots.txt-Dateien können mit Texteditoren, die UTF-8 unterstützen, oder mit integrierten Tools in gängigen CMS-Plattformen wie WordPress, Magento und Shopify erstellt werden.

-

Überprüfe deine robots.txt-Datei mit Tools wie der Google Search Console oder SEO-Plattformen wie SE Ranking, um potenzielle Probleme zu identifizieren und sicherzustellen, dass die Datei wie gewünscht funktioniert.

-

Häufige Probleme umfassen Formatfehler, falsche Platzierung der Datei, fehlerhafte Anweisungen und widersprüchliche Befehle.

-

Beachte, dass bei robots.txt-Direktiven zwischen Groß- und Kleinschreibung unterschieden wird. Jede Anweisung sollte in einer neuen Zeile stehen. Nutze Platzhalter für mehr Flexibilität, erstelle separate Dateien für unterschiedliche Domains und teste deine Website nach jeder Änderung an der robots.txt-Datei, um sicherzustellen, dass wichtige URLs nicht versehentlich blockiert werden.

Was ist eine robots.txt-Datei?

Eine robots.txt-Datei ist ein Textdokument im Stammverzeichnis einer Website. Sie enthält spezifische Informationen für Suchmaschinen-Crawler und gibt ihnen Anweisungen, welche URLs, einschließlich Seiten, Dateien, Ordner usw., gecrawlt werden dürfen und welche nicht. Obwohl diese Datei für die Funktion einer Website nicht zwingend erforderlich ist, muss sie für eine effektive SEO korrekt eingerichtet sein.

Die Entscheidung, robots.txt zu verwenden, wurde 1994 im Rahmen des Robots Exclusion Standard getroffen. Laut Google Search Central dient die Datei primär nicht dazu, Webseiten aus den Suchergebnissen zu entfernen, sondern die Anzahl der Anfragen von Bots an Websites zu begrenzen und die Serverlast zu reduzieren.

Grundsätzlich sollte der Inhalt der robots.txt-Datei als Empfehlung für Suchmaschinen-Crawler betrachtet werden, die die Regeln für das Crawlen einer Website festlegt. Um den Inhalt der robots.txt-Datei einer Website anzuzeigen, gib einfach „/robots.txt“ nach dem Domainnamen in die Browser-Adressleiste ein.

Wie funktioniert robots.txt?

Zunächst ist es wichtig zu verstehen, dass Suchmaschinen bestimmte Suchergebnisse, die in den SERPs angezeigt werden, crawlen und indexieren müssen. Um diese Aufgabe zu erfüllen, durchsuchen Web-Crawler systematisch das Internet und sammeln Daten von den besuchten Webseiten. Dieser Vorgang wird gelegentlich auch als „Spidering“ bezeichnet.

Wenn Crawler eine Website erreichen, überprüfen sie die robots.txt-Datei, die Anweisungen darüber enthält, welche Seiten auf der Website gecrawlt und indexiert werden sollen. Gibt es keine robots.txt-Datei oder enthält diese keine Anweisungen, die Aktivitäten bestimmter User-Agents verbieten, crawlen die Suchmaschinen-Bots die Website, bis sie das Crawl-Budget oder andere Einschränkungen erreichen.

Warum brauchst du eine robots.txt für SEO?

Die Hauptfunktion der robots.txt-Datei besteht darin, das Scannen von Seiten und Ressourcen zu verhindern, wodurch das Crawl-Budget effizienter genutzt werden kann. In den meisten Fällen verbirgt die robots.txt-Datei Informationen, die weder für Website-Besucher noch für Suchmaschinen-Bots von Wert sind. Zudem wird sie oft genutzt, um die Effizienz von Web-Crawling-Ressourcen zu verbessern.

Hinweis: Die Verwendung der „robots.txt disallow“-Anweisung garantiert nicht, dass eine bestimmte Seite nicht gecrawlt oder aus den SERPs ausgeschlossen wird. Google kann externe Faktoren wie eingehende Links berücksichtigen, um die Relevanz einer Seite zu bestimmen. Um das Indexieren explizit zu verhindern, solltest du das „noindex“-Meta-Tag oder den X-Robots-Tag HTTP-Header verwenden. Eine weitere Möglichkeit, die Indizierung zu verhindern, ist die Einrichtung eines Passwortschutzes.

Crawl-Budget optimieren

Das Crawl-Budget beschreibt die Anzahl der Webseiten, die ein Suchroboter auf einer Website crawlt. Um das Crawl-Budget effizienter zu nutzen, sollten Suchroboter nur auf die wichtigsten Inhalte gelenkt und von weniger relevanten Informationen ferngehalten werden.

Die Optimierung des Crawl-Budgets hilft Suchmaschinen, ihre begrenzten Ressourcen besser zu nutzen. Dies führt zu einer schnelleren Indexierung neuer Inhalte und einer besseren Sichtbarkeit in den Suchergebnissen. Es ist jedoch wichtig zu beachten, dass Seiten, die das Crawl-Budget übersteigen, möglicherweise nicht gecrawlt und damit nicht indexiert werden. Nicht indexierte Seiten erscheinen nicht in den SERPs. Es ist daher ratsam, das Crawl-Budget optimal zu nutzen, insbesondere bei großen Websites oder wenn viele Seiten nicht indexiert sind, um sicherzustellen, dass Suchmaschinen alle wichtigen Seiten abdecken.

Stell dir vor, deine Website enthält viele triviale Inhalte im Vergleich zu ihren Hauptseiten. In solchen Fällen kannst du das Crawl-Budget optimieren, indem du unerwünschte Ressourcen von der „Zu besuchen“-Liste des Crawlers ausschließt.

Du kannst so etwa die „Disallow“-Anweisung mit einer bestimmten Dateierweiterung wie „Disallow:/*.pdf“ verwenden, um Suchmaschinen daran zu hindern, PDF-Ressourcen auf deiner Website zu crawlen oder zu indexieren. Dies ist eine effektive Methode, solche Ressourcen auszublenden und sicherzustellen, dass sie nicht in den Suchmaschinenergebnissen erscheinen.

Ein weiterer Vorteil der robots.txt-Datei besteht darin, Probleme mit dem Content-Crawling auf deinem Server zu lösen. Beispielsweise können unendliche Kalenderskripte, die häufig von Bots aufgerufen werden, Probleme verursachen. Diese kannst du mithilfe der robots.txt-Datei vom Crawlen ausschließen.

Vielleicht fragst du dich, ob es besser ist, robots.txt zu verwenden, um Affiliate-Links zu blockieren und das Crawl-Budget zu verwalten, oder ob der Einsatz des noindex-Tags sinnvoller ist. Die Antwort ist einfach: Google erkennt und ignoriert korrekt markierte Affiliate-Links in der Regel selbst. Indem du robots.txt nutzt, um sie auszuschließen, behältst du mehr Kontrolle und kannst das Crawl-Budget potenziell effektiver sparen.

Beispiel für eine robots.txt in SEO

Eine Vorlage mit aktuellen Anweisungen kann dir dabei helfen, eine korrekt formatierte robots.txt für SEO zu erstellen, die die gewünschten Bots definiert und den Zugriff auf relevante Dateien einschränkt.

User-agent: [Bot-Name]

Disallow: /[Pfad zur Datei oder zum Ordner]/

Disallow: /[Pfad zur Datei oder zum Ordner]/

Disallow: /[Pfad zur Datei oder zum Ordner]/

Sitemap: [URL der Sitemap]

Schauen wir uns ein paar Beispiele an, wie eine robots.txt-Datei aussehen könnte.

1. Allen Webcrawlern den Zugriff auf alle Inhalte erlauben

Hier ist ein einfaches Beispiel für den Code einer robots.txt-Datei, der allen Web-Crawlern den Zugriff auf alle Inhalte der Website ermöglicht:

User-agent: *

Crawl-delay: 10

# Sitemaps

Sitemap: https://www.usa.gov/sitemap.xml

In diesem Beispiel wendet die Direktive „User-agent“ mit einem Sternchen (*) die Anweisungen auf alle Web-Crawler an. Die „Crawl-delay“-Direktive erlaubt ungehinderten Zugriff, bittet die Crawler jedoch, 10 Sekunden zwischen den Anfragen zu warten. Die Sitemap-Deklaration schränkt den Zugriff nicht ein, sondern weist die Crawler auf die Sitemap hin. Zeilen, die mit einem Rautezeichen beginnen, sind Kommentare, die von Crawlern ignoriert werden.

2. Einen bestimmten Web-Crawler für eine bestimmte Website sperren

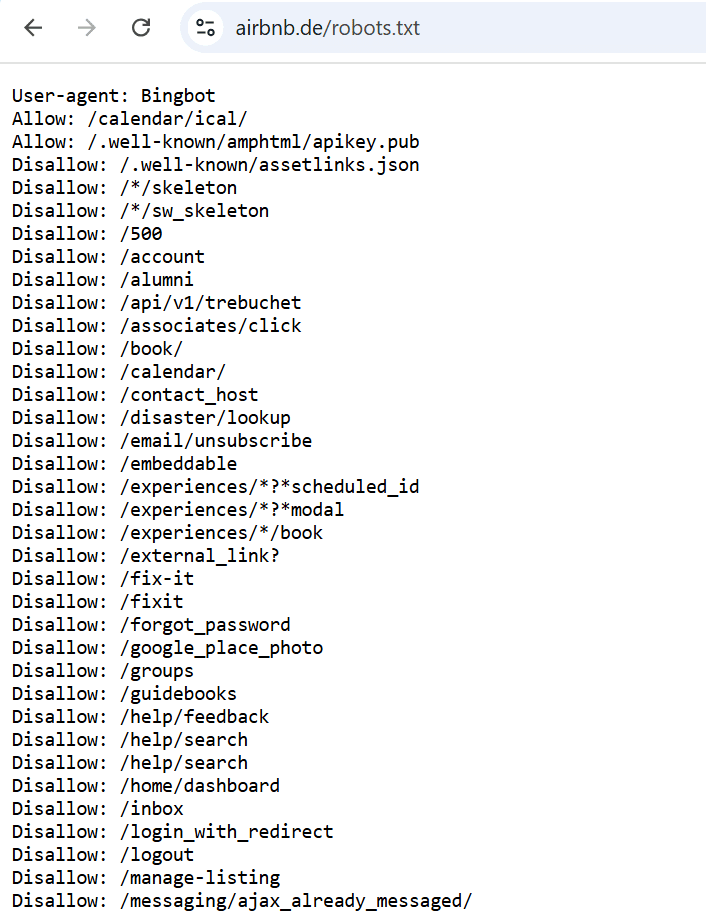

Das folgende Beispiel legt Zugriffsberechtigungen für den User-agent „Bingbot“ fest, den Web-Crawler der Suchmaschine Bing von Microsoft. Es enthält eine Liste von Website-Verzeichnissen, die für das Scannen gesperrt sind, sowie einige Verzeichnisse und Seiten, die für den Zugriff erlaubt sind.

3. Alle Web-Crawler für alle Inhalte sperren

User-agent: *

Disallow: /

In diesem Beispiel gilt die Direktive „User-agent” weiterhin für alle Web-Crawler. Die Direktive „Disallow“ verwendet jedoch einen Schrägstrich (/) als Wert, was bedeutet, dass alle Inhalte der Website für jeden Web-Crawler gesperrt werden sollen. Dies teilt allen Bots effektiv mit, keine Seiten der Website zu crawlen.

Bitte beachte, dass das Sperren aller Web-Crawler vom Zugriff auf die Inhalte einer Website mit der robots.txt-Datei eine extreme Maßnahme ist und in den meisten Fällen nicht empfohlen wird. Dies kann nützlich sein, wenn eine neue Website noch in Entwicklung ist und noch nicht für Suchmaschinen zugänglich sein soll. In anderen Fällen wird die robots.txt-Datei in der Regel verwendet, um den Zugriff auf bestimmte Teile der Website zu steuern, z. B. durch das Sperren bestimmter Verzeichnisse oder Dateien, anstatt alle Inhalte zu blockieren.

Wie findet man die robots.txt-Datei?

Es gibt verschiedene Methoden, um die robots.txt-Datei einer Website zu finden:

Um die robots.txt-Datei zu finden, füge „/robots.txt“ zum Domainnamen der Website hinzu, die du überprüfen möchtest. Wenn die Domain beispielsweise „example.com“ lautet, gib „example.com/robots.txt“ in die Adressleiste deines Browsers ein. So gelangst du direkt zur robots.txt-Datei, falls sie auf der Website existiert.

Eine weniger häufig verwendete, aber dennoch übliche Methode für CMS-Nutzer besteht darin, die robots.txt-Datei direkt im System zu finden und zu bearbeiten. Schauen wir uns einige gängige Systeme an.

1. Eine robots.txt in WordPress erstellen

Um eine robots.txt-Datei in WordPress zu finden und zu bearbeiten, kannst du sie entweder manuell erstellen oder ein Plugin verwenden.

Um eine manuell zu erstellen:

- Erstelle eine Textdatei mit dem Namen „robots.txt“.

- Lade sie über einen FTP-Client in dein Stammverzeichnis hoch.

Mit dem Yoast SEO Plugin:

- Gehe zu Yoast SEO > Tools.

- Klicke auf Datei-Editor (stelle sicher, dass die Dateibearbeitung aktiviert ist).

- Klicke auf die Schaltfläche robots.txt-Datei erstellen.

- Dort kannst du die robots.txt-Datei anzeigen oder bearbeiten.

Mit dem All in One SEO Plugin:

- Gehe zu All in One SEO > Tools.

- Klicke auf Robots.txt-Editor.

- Aktiviere die benutzerdefinierte robots.txt, indem du den Schalter umlegst.

- Dort kannst du die robots.txt-Datei anzeigen oder bearbeiten.

2. Eine robots.txt in Magento erstellen

Magento generiert automatisch eine Standard-robots.txt-Datei.

So bearbeitest du die Datei:

- Melde dich im Magento-Admin-Panel an.

- Gehe zu Inhalt > Design > Konfiguration.

- Klicke auf Bearbeiten für die Hauptwebsite.

- Erweitere den Abschnitt Suchmaschinenroboter.

- Bearbeite den Inhalt im Feld Benutzerdefinierte Anweisungen der robots.txt-Datei bearbeiten.

- Speichere die Konfiguration.

3. Eine robots.txt in Shopify erstellen

Shopify generiert ebenfalls automatisch eine Standard-robots.txt-Datei.

So bearbeitest du die Datei:

- Melde dich im Shopify-Admin-Panel an.

- Klicke auf Einstellungen > Apps und Verkaufskanäle.

- Gehe zu Online-Shop > Themes.

- Klicke auf die …-Schaltfläche neben deinem aktuellen Theme und wähle Code bearbeiten.

- Klicke auf Neues Template hinzufügen > robots.

- Klicke auf Template erstellen.

- Bearbeite den Inhalt nach Bedarf.

- Speichere deine Änderungen.

Wie Suchmaschinen deine robots.txt-Datei finden

Suchmaschinen verwenden spezifische Mechanismen, um die robots.txt-Datei auf deiner Website zu finden und darauf zuzugreifen. So funktioniert es in der Regel:

1. Besuchen einer Website: Suchmaschinen-Crawler durchforsten kontinuierlich das Internet, besuchen Websites und folgen Links, um neue Seiten zu entdecken.

2. Abrufen der robots.txt-Datei: Wenn ein Suchmaschinen-Crawler eine Website besucht, sucht er nach der robots.txt-Datei, indem er „/robots.txt“ an die Domain der Website anhängt.

Hinweis: Nachdem du deine robots.txt-Datei erfolgreich hochgeladen und getestet hast, erkennen Googles Crawler sie automatisch und beginnen, die Anweisungen zu befolgen. Es sind keine weiteren Schritte notwendig. Solltest du jedoch Änderungen an deiner robots.txt-Datei vornehmen und möchtest, dass Google die aktualisierte Version umgehend erkennt, musst du lernen, wie man eine aktualisierte robots.txt-Datei einreicht.

3. Abrufen der robots.txt-Datei: Falls sich eine robots.txt-Datei am angegebenen Speicherort befindet, lädt der Crawler die Datei herunter und analysiert sie, um die Crawling-Direktiven zu ermitteln.

4. Befolgen der Anweisungen: Nach dem Abrufen der robots.txt-Datei hält sich der Suchmaschinen-Crawler an die darin festgelegten Anweisungen.

Robots.txt vs. Meta-Robots-Tags vs. X-Robots-Tags

Die robots.txt-Datei, das Meta-Robots-Tag und der X-Robots-Tag haben ähnliche Zwecke, nämlich Suchmaschinen-Crawlern Anweisungen zu geben. Sie unterscheiden sich jedoch in ihrer Anwendung und ihrem Kontrollbereich.

Wenn es darum geht, Inhalte vor den Suchergebnissen zu verbergen, reicht es oft nicht aus, sich allein auf die robots.txt-Datei zu verlassen. Wie bereits erwähnt, stellt die robots.txt-Datei lediglich eine Empfehlung für Web-Crawler dar und informiert darüber, welche Bereiche einer Website sie besuchen dürfen. Sie garantiert jedoch nicht, dass Inhalte von Suchmaschinen nicht indexiert werden. Um das Indexieren zu verhindern, sollten Webmaster zusätzliche Methoden anwenden.

Robots-Meta-Tag

Eine effektive Methode zur Steuerung der Indexierung ist die Verwendung des Robots-Meta-Tags, das im <head>-Bereich des HTML-Codes einer Seite platziert wird. Mit einem Meta-Tag und der “noindex”-Direktive können Webmaster Suchmaschinen-Bots explizit mitteilen, dass der Inhalt einer Seite nicht indexiert werden soll. Diese Methode bietet eine präzisere Kontrolle über einzelne Seiten und deren Indexierungsstatus im Vergleich zu den allgemeinen Anweisungen der robots.txt-Datei.

Hier ein Beispiel für einen Codeausschnitt, der die Indexierung durch Suchmaschinen auf Seitenebene verhindert:

<meta name="robots" content="noindex">

Ähnlich wie die robots.txt-Datei erlaubt auch dieses Meta-Tag die Einschränkung bestimmter Bots. Um beispielsweise einen spezifischen Bot (z. B. Googlebot) einzuschränken, kannst du verwenden:

<meta name="googlebot" content="noindex">

X-Robots-Tag

Das X-Robots-Tag kann in der Konfigurationsdatei der Website genutzt werden, um die Indexierung von Seiten weiter einzuschränken. Diese Methode bietet eine zusätzliche Kontroll- und Flexibilitätsebene bei der granularen Verwaltung der Indexierung.

Wenn du mehr über dieses Thema erfahren möchtest, lies unseren vollständigen Leitfaden zum Robots-Meta-Tag und X-Robots-Tag.

Seiten und Dateien, die häufig über robots.txt gesperrt werden

1. Admin-Dashboard und Systemdateien

Interne und Servicedateien, mit denen nur Website-Administratoren oder Webmaster interagieren sollten.

2. Hilfsseiten, die nur nach bestimmten Nutzeraktionen angezeigt werden.

Seiten, die Kunden nach dem erfolgreichen Abschluss einer Bestellung, dem Ausfüllen von Formularen, der Autorisierung oder der Passwortwiederherstellung angezeigt werden.

3. Suchseiten.

Seiten, die angezeigt werden, nachdem ein Website-Besucher eine Anfrage in die Suchleiste der Website eingegeben hat, werden in der Regel für Suchmaschinen-Crawler gesperrt.

4. Filterseiten.

Ergebnisse, die mit einem angewendeten Filter (Größe, Farbe, Hersteller usw.) angezeigt werden, sind separate Seiten und können als doppelter Inhalt betrachtet werden. SEO-Experten verhindern in der Regel, dass diese Seiten gecrawlt werden, es sei denn, sie generieren Traffic für Marken-Keywords oder andere Zielanfragen. Aggregator-Websites können hier eine Ausnahme darstellen.

5. Dateien eines bestimmten Formats.

Dateien wie Fotos, Videos, .PDF-Dokumente oder JS-Dateien. Mithilfe der robots.txt-Datei kannst du das Scannen einzelner Dateien oder solcher mit einer bestimmten Dateierweiterung einschränken.

Syntax der robots.txt-Datei

Webmaster müssen die Syntax und Struktur der robots.txt-Datei verstehen, um die Sichtbarkeit ihrer Webseiten in Suchmaschinen zu steuern. Die robots.txt-Datei enthält in der Regel eine Reihe von Regeln, die bestimmen, welche Dateien auf einer Domain oder Subdomain von Crawlern aufgerufen werden dürfen. Diese Regeln können den Zugriff auf bestimmte Dateipfade entweder blockieren oder erlauben. Standardmäßig sind alle Dateien für das Crawlen erlaubt, sofern dies nicht ausdrücklich in der robots.txt-Datei angegeben ist.

Die robots.txt-Datei besteht aus Gruppen, die jeweils mehrere Regeln oder Anweisungen enthalten. Diese Regeln werden zeilenweise aufgelistet. Jede Gruppe beginnt mit einer „User-agent“-Zeile, die die Zielgruppe der Regeln angibt.

Eine Gruppe enthält folgende Informationen:

- Der User-Agent, auf den sich die Regeln beziehen.

- Die Verzeichnisse oder Dateien, auf die der User-Agent zugreifen darf.

- Die Verzeichnisse oder Dateien, auf die der User-Agent nicht zugreifen darf.

Crawler arbeiten die robots.txt-Datei von oben nach unten ab. Ein User-Agent kann nur einem Regelset zugeordnet werden. Wenn mehrere Gruppen denselben User-Agent ansprechen, werden diese Gruppen vor der Verarbeitung zu einer einzigen Gruppe zusammengeführt.

Hier ist ein Beispiel für eine einfache robots.txt-Datei mit zwei Regeln:

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Allow: /

Sitemap: https://www.example.com/sitemap.xml

Um das Verhalten von Webcrawlern genauer zu steuern, kannst du reguläre Ausdrücke zusammen mit flexiblen Anweisungen für Crawler verwenden.

Ein häufig verwendetes Symbol in regulären Ausdrücken für robots.txt-Dateien ist das Sternchen (*), das als Platzhalter fungiert und jede beliebige Variation eines Wertes repräsentiert.

Ein weiteres Symbol, das in regulären Ausdrücken für robots.txt-Dateien verwendet werden kann, ist das Dollarzeichen ($), das das Ende des URL-Pfads angibt. Zum Beispiel würde ein URL-Muster „/blog/$“ nur mit URLs übereinstimmen, die mit „/blog/“ enden, wie „/blog/“ oder „/category/blog/“. Es würde nicht mit URLs wie „/blog/article“ oder „/blog/page/2“ übereinstimmen.

Du kannst auch den Zugriff auf alle URLs innerhalb eines bestimmten Verzeichnisses erlauben, indem du das Muster „/example/“ in deiner robots.txt-Datei verwendest. Dieses Muster passt zu URLs wie „/example/page1.html“, „/example/subdirectory/page2.html“ und so weiter, wodurch Web-Roboter diese URLs crawlen können.

Nun werfen wir einen genaueren Blick auf die verschiedenen Elemente der robots.txt-Syntax.

Die User-agent-Direktive

Die User-agent-Direktive ist obligatorisch und definiert, für welchen Suchroboter die Regeln gelten. Jede Regelgruppe beginnt mit dieser Direktive, wenn es mehrere Bots gibt.

Google hat mehrere Bots, die für verschiedene Arten von Inhalten verantwortlich sind:

- Googlebot: Crawlt Websites für Desktop- und Mobilgeräte.

- Googlebot Image: Crawlt Bilder von Websites, um sie im Bereich „Bilder“ und bei bildbasierten Produkten anzuzeigen.

- Googlebot Video: Scannt und zeigt Videos an.

- Googlebot News: Wählt nützliche und qualitativ hochwertige Artikel für den Bereich „News“ aus.

- Google-InspectionTool: Ein URL-Testtool, das Googlebot imitiert, indem es alle zugänglichen Seiten crawlt.

- Google StoreBot: Scannt verschiedene Seitentypen, wie Produktdetails, Warenkorb- und Checkout-Seiten.

- GoogleOther: Ruft öffentlich zugängliche Inhalte von Websites ab, einschließlich einmaliger Crawls für interne Forschung und Entwicklung.

- Google-CloudVertexBot: Crawlt Websites auf Anfrage von Website-Betreibern, die Vertex AI Agents erstellen.

- Google-Extended: Ein eigenständiger Produkt-Token, der steuert, ob Websites helfen, Gemini Apps, Vertex AI generative APIs und zukünftige Modelle zu verbessern.

Es gibt auch eine separate Gruppe von Bots, sogenannte „Special-Case-Crawler“, wie AdSense, Google-Safety und andere. Diese Bots können sich im Verhalten und in den Berechtigungen von den gängigen Crawlern unterscheiden.

Die vollständige Liste der Google-Roboter (User-agents) findest du in der offiziellen Hilfedokumentation.

Andere Suchmaschinen haben ähnliche Bots, zum Beispiel Bingbot für Bing, Slurp für Yahoo!, Baiduspider für Baidu und viele mehr. Insgesamt gibt es über 500 Suchmaschinen-Bots.

Beispiel

- User-agent: * \ gilt für alle existierenden Roboter.

- User-agent: Googlebot gilt für Googles Roboter.

- User-agent: Bingbot gilt für Bings Roboter.

- User-agent: Slurp gilt für Yahoos Roboter.

Die Disallow-Direktive

Disallow ist ein wichtiger Befehl, der Suchmaschinen-Bots anweist, eine Seite, Datei oder einen Ordner nicht zu scannen. Die Namen der Dateien und Ordner, auf die der Zugriff beschränkt werden soll, werden nach dem „/“-Symbol angegeben.

Beispiel 1: Angabe verschiedener Parameter nach Disallow.

Disallow: /link zur Seite verbietet den Zugriff auf eine bestimmte URL.

Disallow: /ordnername/ sperrt den Zugriff auf den Ordner.

Disallow: /*.png$ sperrt den Zugriff auf Bilder im PNG-Format.

Disallow: /. Das Fehlen von Anweisungen nach dem „/“-Symbol bedeutet, dass die gesamte Website vom Scannen ausgeschlossen wird, was während der Entwicklung einer Website nützlich sein kann.

Beispiel 2: Sperrung des Scannens aller .PDF-Dateien auf der Website.

User-agent: Googlebot

Disallow: /*.pdf$

Die Allow-Direktive

In der robots.txt-Datei funktioniert die Allow-Direktive entgegengesetzt zu Disallow, indem sie den Zugriff auf Website-Inhalte erlaubt. Diese Befehle werden oft zusammen verwendet, insbesondere wenn der Zugriff auf bestimmte Informationen wie ein Foto in einem geschützten Medienverzeichnis geöffnet werden soll.

Beispiel 1: Verwendung von Allow, um ein Bild in einem geschlossenen Album zu scannen.

Gib die Allow-Direktive mit der Bild-URL an und auf einer anderen Zeile die Disallow-Direktive mit dem Namen des Ordners, in dem sich die Datei befindet. Die Reihenfolge der Zeilen ist wichtig, da Crawler Gruppen von oben nach unten verarbeiten.

Disallow: /album/

Allow: /album/bild1.jpg

Die „robots.txt Allow All“-Direktive wird normalerweise verwendet, wenn es keine spezifischen Einschränkungen oder Verbote für Suchmaschinen gibt. Es ist jedoch wichtig zu beachten, dass die „Allow: /“-Direktive kein notwendiger Bestandteil der robots.txt-Datei ist. Tatsächlich verzichten einige Webmaster vollständig darauf und verlassen sich auf das Standardverhalten der Suchmaschinen-Crawler.

Die Allow-Direktive ist kein Bestandteil der ursprünglichen robots.txt-Spezifikation. Das bedeutet, dass sie möglicherweise nicht von allen Bots unterstützt wird. Während viele bekannte Crawler wie Googlebot die Allow-Direktive erkennen und respektieren, tun dies andere möglicherweise nicht.

Laut dem Standard for Robots Exclusion „werden nicht erkannte Header ignoriert“. Das bedeutet, dass Bots, die die „Allow“-Direktive nicht erkennen, ein anderes Verhalten zeigen können, als vom Webmaster erwartet. Dies sollte bei der Erstellung von robots.txt-Dateien berücksichtigt werden.

Die Sitemap-Direktive

Die Sitemap-Direktive in der robots.txt-Datei gibt den Pfad zur Sitemap an. Diese Direktive kann weggelassen werden, wenn die Sitemap einen standardisierten Namen hat, im Stammverzeichnis liegt und über den Link „Seitenname“/sitemap.xml zugänglich ist – ähnlich wie die robots.txt-Datei.

Beispiel:

Sitemap: https://website.com/sitemap.xml

Während die robots.txt-Datei in erster Linie dazu dient, das Crawlen deiner Website zu steuern, hilft die Sitemap den Suchmaschinen, die Organisation und die hierarchische Struktur deines Inhalts zu verstehen. Indem du einen Link zu deiner Sitemap in die robots.txt-Datei einfügst, erleichterst du den Suchmaschinen-Crawlern das Auffinden und Analysieren der Sitemap. Dies führt zu effizienterem Crawlen und Indexieren deiner Website. Es ist daher nicht zwingend erforderlich, wird jedoch dringend empfohlen, einen Verweis auf die Sitemap in die robots.txt-Datei aufzunehmen.

Kommentare

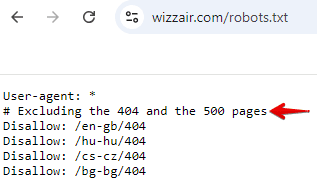

Du kannst der robots.txt-Datei Kommentare hinzufügen, um spezifische Direktiven zu erklären, Änderungen oder Aktualisierungen der Datei zu dokumentieren, verschiedene Abschnitte zu organisieren oder anderen Teammitgliedern Kontext zu bieten. Kommentare beginnen mit dem Symbol „#“. Diese Zeilen werden von Bots ignoriert, wenn die Datei verarbeitet wird. Sie helfen dir und deinem Team, die Datei besser zu verstehen, beeinflussen jedoch nicht, wie Bots sie lesen.

Hier ein Beispiel aus der robots.txt-Datei von Wizzair:

Als Reaktion auf den Aufstieg von KI-Technologien sucht Google nach Möglichkeiten, ein ergänzendes robots.txt-Protokoll zu entwickeln. Ziel ist es, Web-Publishern mehr Kontrolle über die Nutzung ihrer Inhalte zu geben, insbesondere in KI- und Forschungsanwendungen.

Diese Initiative zeigt, dass sich Web-Standards weiterentwickeln, um den neuen Herausforderungen durch KI-Technologien zu begegnen. Es ist wichtig, über diese Entwicklungen informiert zu bleiben, da sie die Art und Weise beeinflussen könnten, wie Inhalte zukünftig gecrawlt, abgerufen und genutzt werden.

Wie man eine robots.txt für SEO erstellt

Eine gut gestaltete robots.txt-Datei bildet die Grundlage für technisches SEO.

Da die Datei die Erweiterung .txt hat, reicht ein einfacher Texteditor mit UTF-8-Unterstützung aus. Die einfachsten Optionen sind Notepad (Windows) oder TextEdit (Mac).

Wie bereits erwähnt, bieten die meisten CMS-Plattformen Lösungen zum Erstellen einer robots.txt-Datei. WordPress erstellt beispielsweise standardmäßig eine virtuelle robots.txt-Datei, die online einsehbar ist, indem man „/robots.txt“ an die Domain der Website anhängt. Um diese Datei jedoch zu bearbeiten, muss eine eigene Version erstellt werden. Dies kann entweder über ein Plugin (z. B. Yoast oder All in One SEO Pack) oder manuell erfolgen.

Auch Magento und Wix generieren als CMS-Plattformen automatisch eine robots.txt-Datei, die jedoch nur grundlegende Anweisungen für Web-Crawler enthält. Daher wird empfohlen, benutzerdefinierte Anweisungen innerhalb dieser Systeme zu erstellen, um das Crawl-Budget optimal zu nutzen.

Tools wie der Robots.txt Generator von SE Ranking ermöglichen ebenfalls die Erstellung einer benutzerdefinierten robots.txt-Datei basierend auf den angegebenen Informationen. Dabei hast du die Wahl, die Datei von Grund auf neu zu erstellen oder eine der vorgeschlagenen Vorlagen zu verwenden.

Wenn du eine robots.txt-Datei von Grund auf neu erstellst, kannst du sie auf folgende Weise personalisieren:

- Durch das Konfigurieren von Direktiven für Crawling-Berechtigungen.

- Durch das Festlegen spezifischer Seiten und Dateien mithilfe des Pfadparameters.

- Durch die Bestimmung, welche Bots diese Anweisungen befolgen sollen.

Alternativ können vordefinierte robots.txt-Vorlagen ausgewählt werden, die allgemeine und CMS-spezifische Direktiven enthalten. Es ist auch möglich, eine Sitemap in die Datei aufzunehmen. Dieses Tool spart Zeit, indem es eine fertige robots.txt-Datei zum Herunterladen bereitstellt.

Dateiname und Größe

Die robots.txt-Datei sollte exakt wie angegeben benannt werden, ohne Großbuchstaben zu verwenden. Laut den Google-Richtlinien sollte die Dateigröße 500 KiB nicht überschreiten. Wird dieses Limit überschritten, kann dies dazu führen, dass die Datei nur teilweise verarbeitet wird, die gesamte Website nicht gecrawlt wird oder der gesamte Inhalt der Website gescannt wird.

Wo die Datei platziert werden sollte

Die robots.txt-Datei muss im Stammverzeichnis des Website-Hosts abgelegt werden und ist über FTP zugänglich. Es wird empfohlen, die ursprüngliche robots.txt-Datei vor Änderungen in ihrer Originalform herunterzuladen.

Wie man die robots.txt-Datei überprüft

Fehler in der robots.txt-Datei können dazu führen, dass wichtige Seiten nicht im Suchindex erscheinen oder die gesamte Website für Suchmaschinen unsichtbar wird. Andererseits könnten unerwünschte Seiten, die privat bleiben sollten, ebenfalls indexiert werden.

Die Robots.txt-Datei kann einfach mit dem kostenlosen Robots.txt Tester von SE Ranking überprüft werden. Gib bis zu 100 URLs ein, um zu testen, ob sie zum Scannen freigegeben sind.

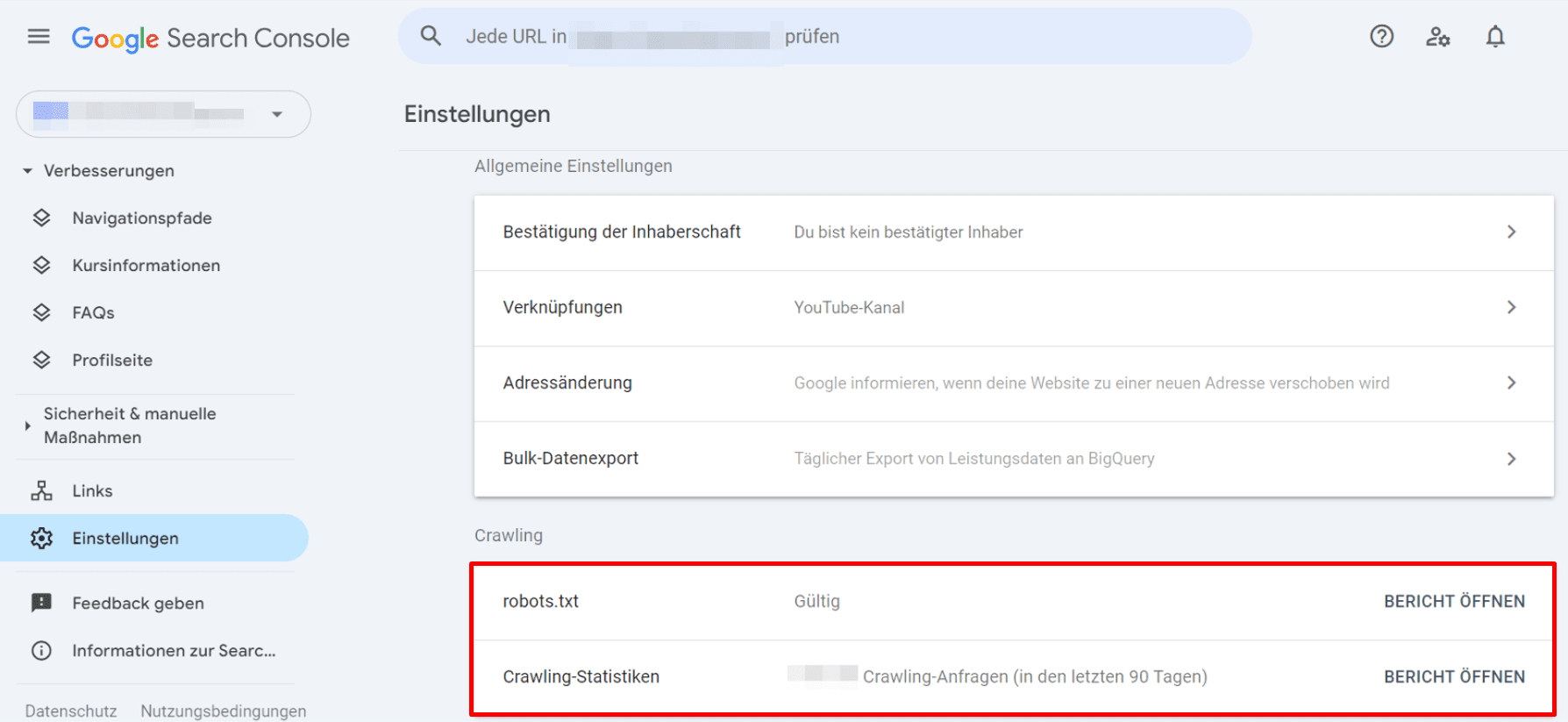

Alternativ kannst du in der Google Search Console einen robots.txt-Bericht abrufen. Gehe dazu zu Einstellungen > Crawling > robots.txt.

Das Öffnen eines robots.txt-Berichts zeigt die robots.txt-Dateien, die Google für die 20 wichtigsten Hosts deiner Website gefunden hat. Du siehst, wann Google sie zuletzt überprüft hat, den Abrufstatus und eventuelle Probleme. Zudem kannst du diesen Bericht nutzen, um Google zu bitten, eine robots.txt-Datei schnell erneut zu crawlen, falls dies dringend erforderlich ist.

Häufige Probleme mit robots.txt und SEO

Während du die robots.txt-Datei deiner Website verwaltest, können verschiedene Probleme die Interaktion von Suchmaschinen-Crawlern mit deiner Website beeinträchtigen. Zu den häufigsten Problemen gehören:

- Falsches Format: Web-Crawler können die Datei nicht erkennen und analysieren, wenn sie nicht im .txt-Format erstellt wurde.

- Falsche Platzierung: Deine robots.txt-Datei sollte sich im Stammverzeichnis befinden. Wenn sie beispielsweise in einem Unterordner liegt, können Suchbots sie möglicherweise nicht finden und darauf zugreifen.

- Fehlerhafte Verwendung von „/“ in der Disallow-Direktive: Eine Disallow-Direktive ohne Inhalt erlaubt Bots den Zugriff auf alle Seiten deiner Website. Eine Disallow-Direktive mit „/“ sperrt deine gesamte Website für Bots. Überprüfe deine robots.txt-Datei stets sorgfältig, um sicherzustellen, dass die Disallow-Direktiven deinen Absichten entsprechen.

- Leere Zeilen in der robots.txt-Datei: Achte darauf, dass zwischen den Direktiven keine leeren Zeilen vorhanden sind, da Web-Crawler sonst Schwierigkeiten haben könnten, die Datei zu analysieren. Leere Zeilen sind nur zulässig, bevor ein neuer User-Agent angegeben wird.

- Seite in robots.txt blockieren und gleichzeitig eine „noindex“-Direktive hinzufügen: Dies erzeugt widersprüchliche Signale. Suchmaschinen könnten die Absicht nicht verstehen oder die „noindex“-Anweisung vollständig ignorieren. Es ist besser, entweder robots.txt zu verwenden, um das Crawlen zu blockieren, oder „noindex“, um das Indexieren zu verhindern – jedoch nicht beides gleichzeitig.

Zusätzliche Tools/Berichte zur Überprüfung von Problemen

Es gibt viele Möglichkeiten, deine Website auf mögliche Probleme mit der robots.txt-Datei zu überprüfen. Hier sind die am häufigsten genutzten:

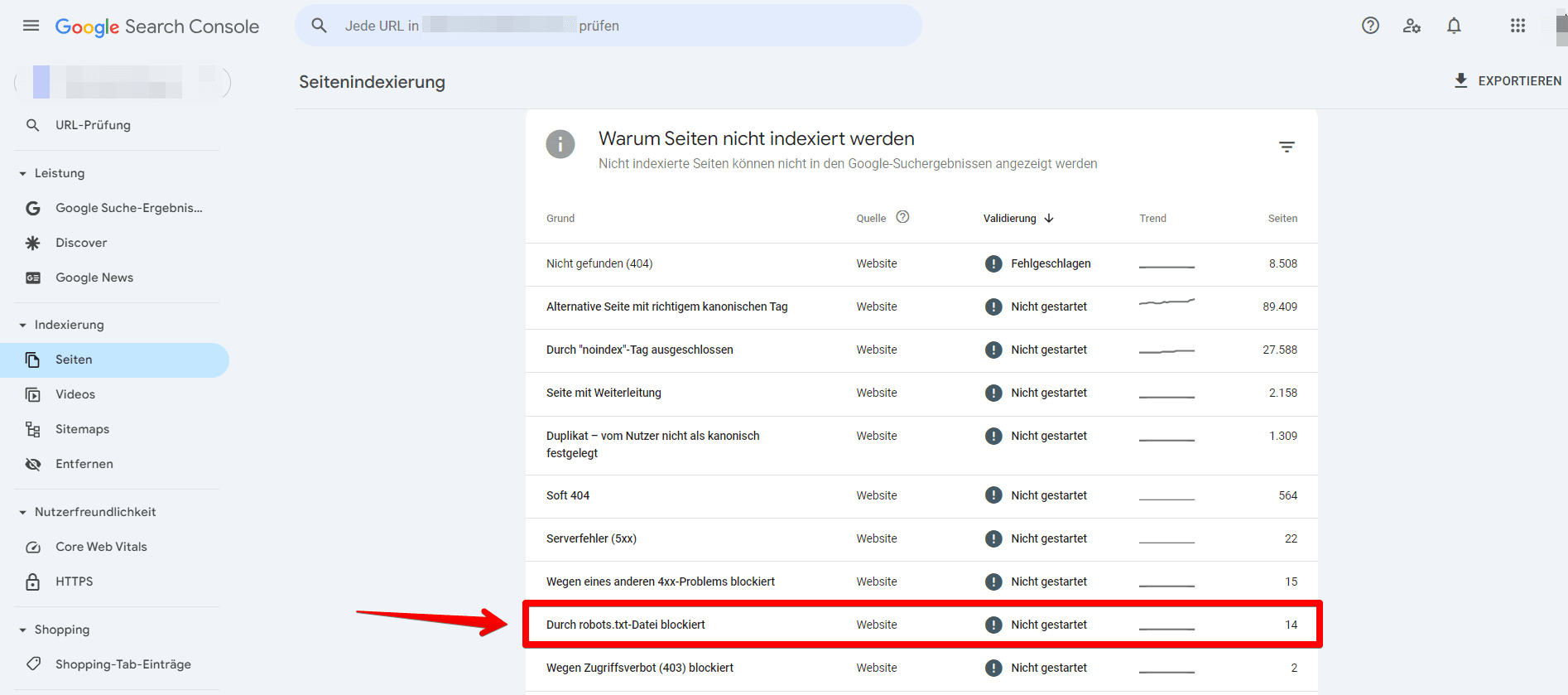

1. Google Search Console Seitenbericht

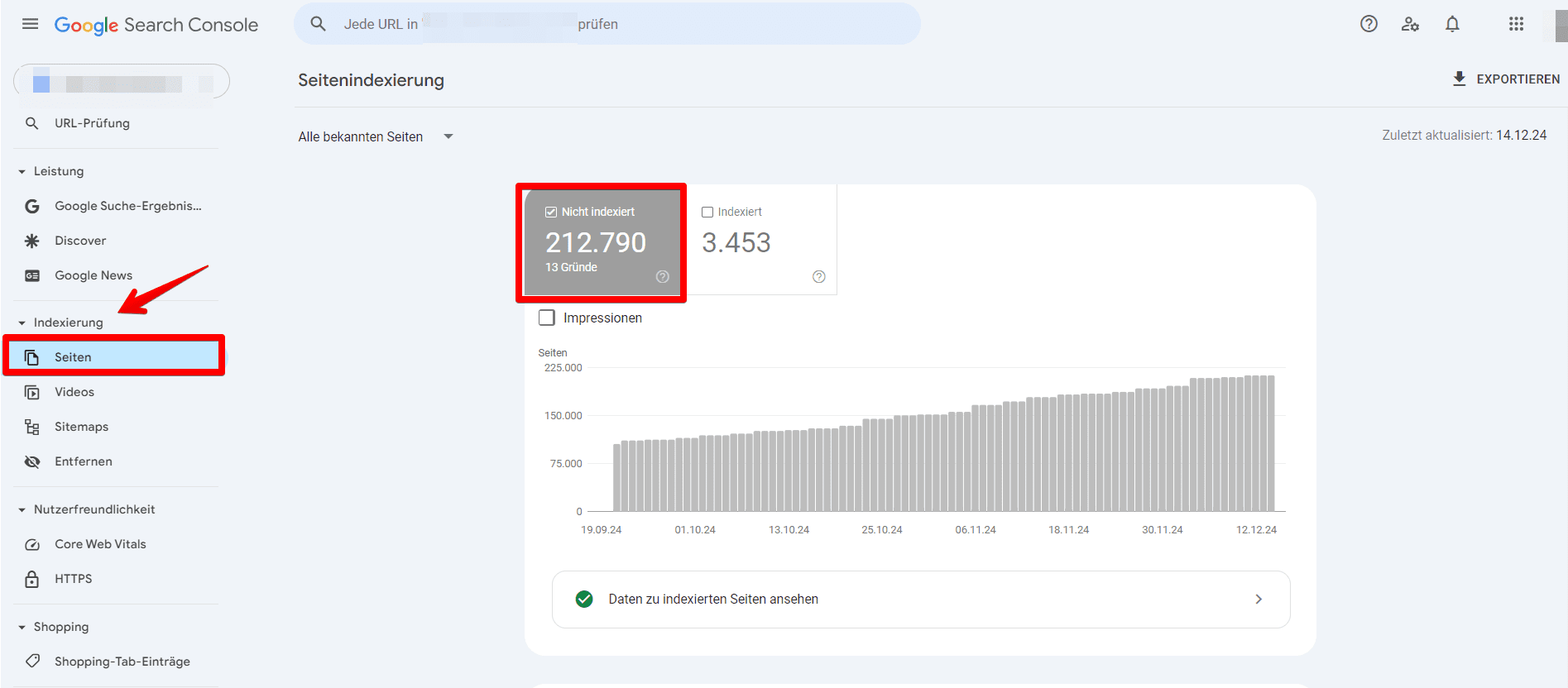

Der Bereich Seiten in der Google Search Console enthält wertvolle Informationen über deine robots.txt-Datei.

Um zu überprüfen, ob die robots.txt-Datei deiner Website Googlebot daran hindert, eine Seite zu crawlen, gehe wie folgt vor:

- Rufe den Bereich Seiten auf und navigiere zur Kategorie Nicht indexiert.

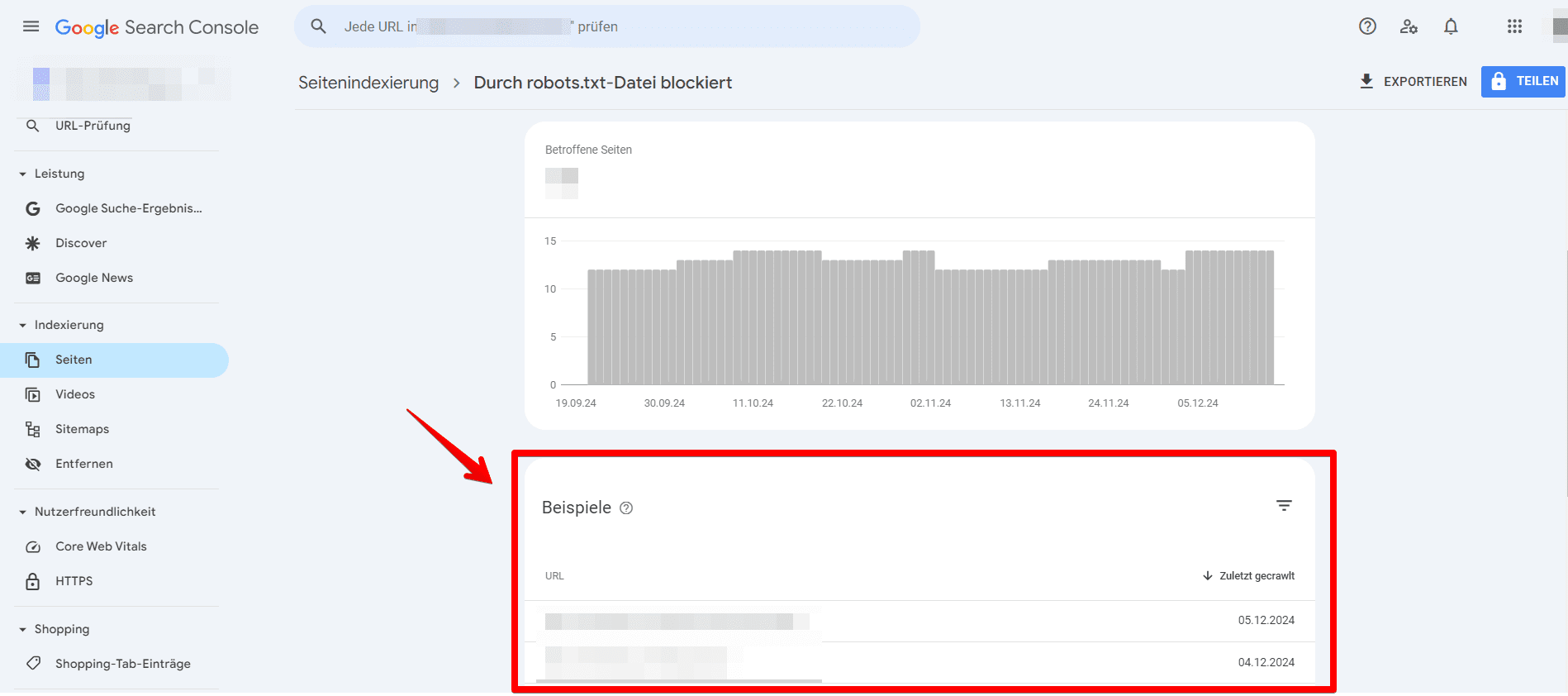

- Suche nach dem Fehler mit der Bezeichnung Durch robots.txt blockiert und wähle ihn aus.

- Klick auf diesen Bereich zeigt dir eine Liste der Seiten, die derzeit durch die robots.txt-Datei deiner Website blockiert werden. Stelle sicher, dass dies die beabsichtigten blockierten Seiten sind.

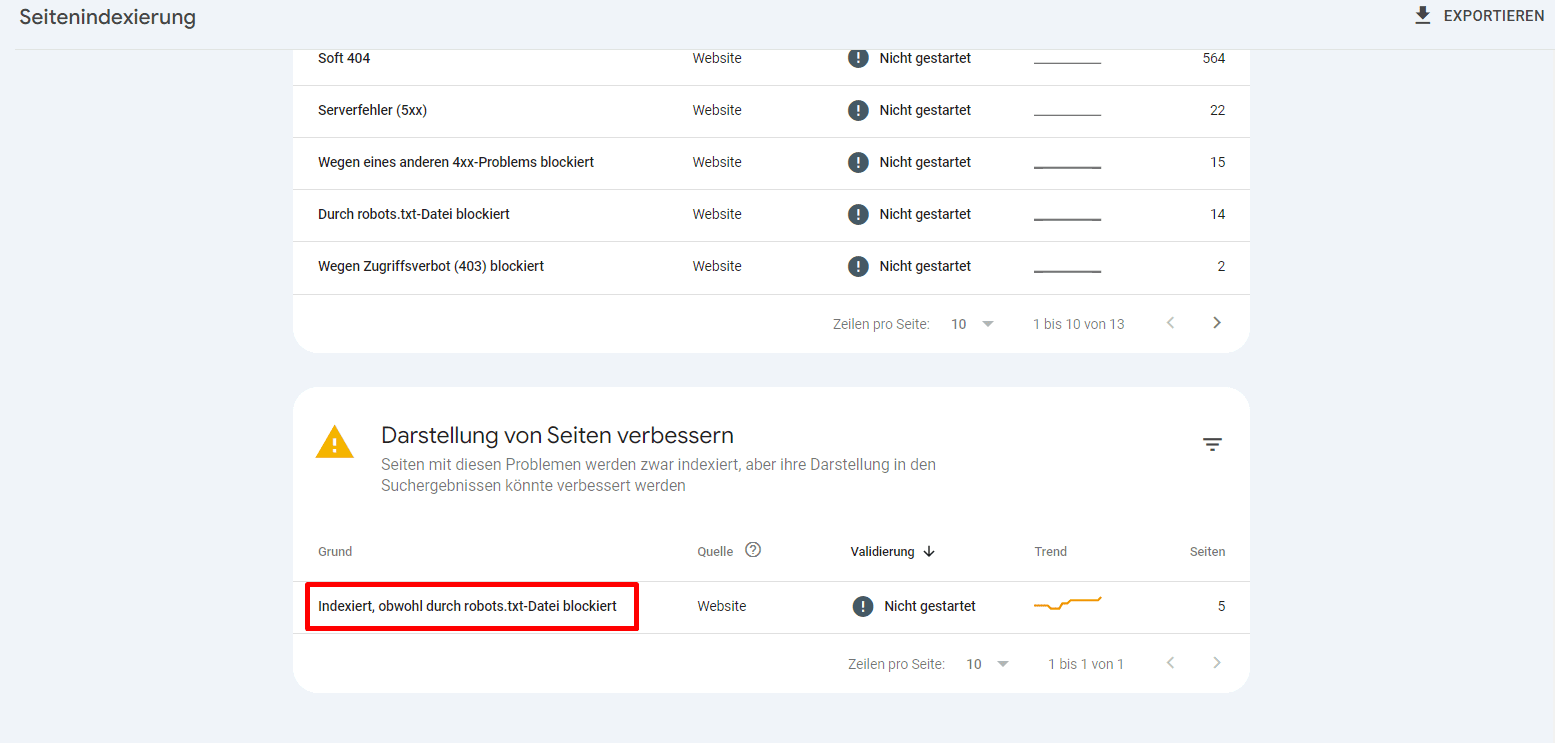

Überprüfe außerdem, ob in diesem Bereich das folgende Problem vorliegt: Indexiert, obwohl durch robots.txt blockiert.

Du kannst auch prüfen, ob einzelne URLs indexiert sind, indem du sie in das Suchfeld des URL-Inspektionstools in der Google Search Console einfügst. Dies kann dir helfen, potenzielle Indexierungsprobleme zu erkennen, die durch widersprüchliche Direktiven oder falsch konfigurierte robots.txt-Regeln verursacht werden.

Hier ist ein vollständiger Leitfaden zur Google Search Console, um indexierungsbezogene Probleme zu erkennen und zu beheben.

2. Website-Audit von SE Ranking

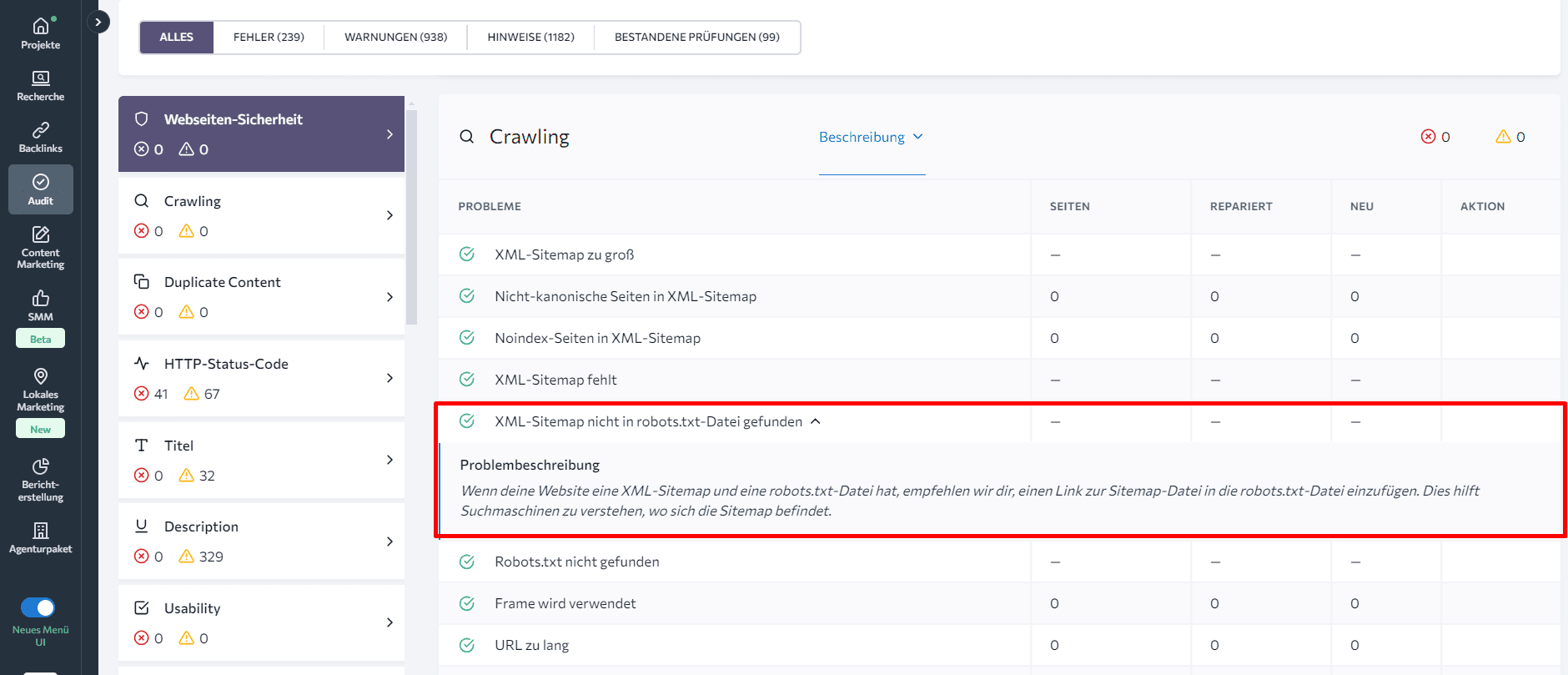

Das Website-Audit-Tool von SE Ranking (und ähnliche Tools) bietet einen umfassenden Überblick über deine robots.txt-Datei, einschließlich Informationen über Seiten, die durch die Datei blockiert sind. Es hilft dir auch, Indexierungs- und XML-Sitemap-bezogene Probleme zu identifizieren.

Um wertvolle Einblicke in deine robots.txt-Datei zu erhalten, beginne mit der Analyse des Problemberichts, den das Tool generiert. Unter den über 120 analysierten Metriken findest du den Parameter Durch robots.txt blockiert im Abschnitt Crawling. Ein Klick darauf zeigt eine Liste der vom Crawling blockierten Webseiten sowie Problembeschreibungen und Tipps zur schnellen Behebung.

Mit diesem Tool kannst du außerdem leicht überprüfen, ob du einen Link zur Sitemap-Datei in der robots.txt-Datei hinzugefügt hast. Kontrolliere einfach den Status XML-Sitemap nicht in robots.txt-Datei gefunden im selben Abschnitt.

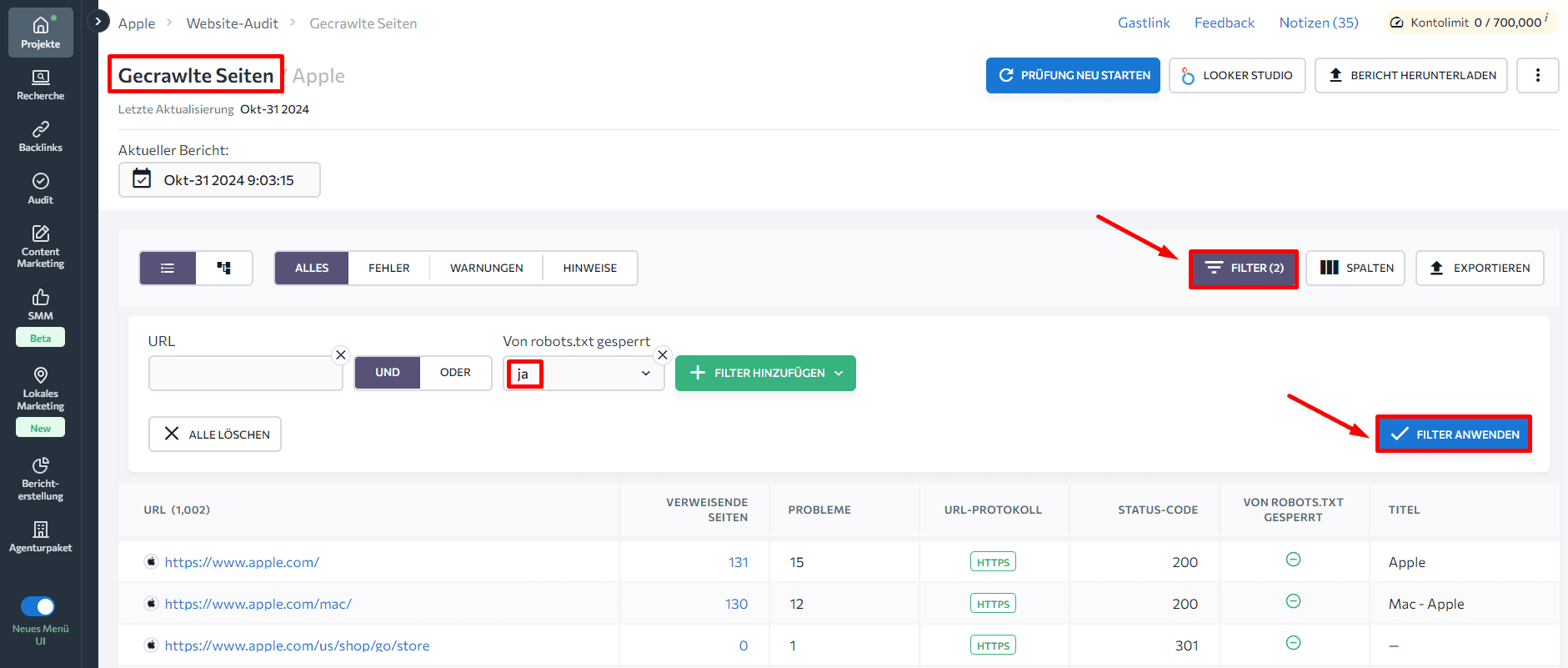

Wenn du im Menü auf der linken Seite zum Tab Gecrawlte Seiten navigierst, kannst du die technischen Parameter jeder Seite einzeln analysieren. Wende Filter an, um dich auf die Lösung kritischer Probleme auf den wichtigsten Seiten zu konzentrieren. Zum Beispiel zeigt der Filter Durch robots.txt blockiert > Ja alle Seiten, die durch die Datei blockiert sind.

SEO Best Practices

Um sicherzustellen, dass Web-Crawler die Inhalte deiner Website korrekt indexieren und sie optimal performt, solltest du diese SEO-Best Practices befolgen:

- Achte auf korrekte Groß- und Kleinschreibung in der robots.txt-Datei: Web-Crawler interpretieren Ordner- und Abschnittsnamen case-sensitiv. Die richtige Schreibweise ist entscheidend, um Verwirrung zu vermeiden und ein genaues Crawling und Indexieren zu gewährleisten.

- Beginne jede Anweisung in einer neuen Zeile, mit nur einem Parameter pro Zeile.

- Vermeide Leerzeichen, Anführungszeichen oder Semikolons beim Schreiben von Anweisungen.

- Verwende die Disallow-Direktive, um alle Dateien innerhalb eines bestimmten Ordners oder Verzeichnisses vom Crawling auszuschließen. Diese Methode ist effizienter, als jede Datei einzeln aufzulisten.

- Setze Wildcard-Zeichen für flexiblere Anweisungen in der robots.txt-Datei ein. Das Sternchen (*) steht für beliebige Variationen, während das Dollarzeichen ($) das Ende des URL-Pfads kennzeichnet.

- Erstelle eine separate robots.txt-Datei für jede Domain. So werden Crawl-Richtlinien für jede Website individuell festgelegt.

- Teste immer eine robots.txt-Datei, um sicherzustellen, dass wichtige URLs nicht blockiert werden.

Fazit

Wir haben alle wichtigen Aspekte der robots.txt-Datei behandelt – von der Syntax über Best Practices bis hin zu häufigen Problemen. Jetzt weißt du, warum eine gut konfigurierte robots.txt-Datei für effektives SEO und Website-Management unerlässlich ist. Sie optimiert das Crawl-Budget, führt Suchmaschinen zu wichtigen Inhalten und schützt sensible Bereiche.

Denke daran, deine robots.txt-Datei regelmäßig zu überprüfen und zu aktualisieren, während sich deine Website weiterentwickelt. Nutze die vorgestellten Tools und Techniken, um sicherzustellen, dass deine Datei wie gewünscht funktioniert.