Robots.txt testen

Während du wartest ...

Starte ein SEO-Audit für mit einem kostenlosen Testkonto!

- Prüfe, welche Seiten durch robots.txt oder auf andere Weise blockiert werden

- Erkenne Indexierungsfehler, Duplikate, Kannibalisierungsprobleme und mehr

- Analysiere den Website-Traffic, die besten Keywords und Seiten

- Untersuche Backlinks, Rankings, SERP-Features und KI-Übersichten

Wie liest man eine robots.txt-Datei?

Wie verwendet man den Online Robots.txt Tester?

Warum ist eine Robots.txt-Datei notwendig?

Die robots.txt-Datei gibt Suchmaschinen wichtige Informationen über das Crawlen von Dateien und Webseiten. Sie wird hauptsächlich verwendet, um den Crawler-Verkehr auf deiner Website zu steuern und zu verhindern, dass deine Website durch zu viele Anfragen überlastet wird.

Du kannst zwei Probleme damit lösen:

- Du reduzierst die Wahrscheinlichkeit, dass bestimmte Seiten gecrawlt, indiziert und in den Suchergebnissen angezeigt werden.

- Du sparst Crawling-Budget, indem du Seiten blockierst, die nicht indexiert werden sollten.

Wenn du jedoch verhindern möchtest, dass eine Seite oder ein anderes digitales Asset in der Google-Suche erscheint, wäre eine zuverlässigere Option, das noindex-Attribut zum Robots-Meta-Tag hinzuzufügen.

Wie stelle ich sicher, dass meine robots.txt-Datei korrekt funktioniert?

Eine schnelle und einfache Methode, um sicherzustellen, dass deine robots.txt-Datei richtig funktioniert, ist die Verwendung spezieller Tools.

So kannst du mit unserem Tool deine robots.txt checken: Gib bis zu 100 URLs ein, und es zeigt dir an, ob die Datei das Crawlen bestimmter URLs auf deiner Website blockiert.

Um schnell Fehler in der robots.txt-Datei zu erkennen, kannst du auch die Google Search Console verwenden.

Häufige Probleme mit robots.txt

- Falsches Format: Die Datei ist nicht im .txt-Format. In diesem Fall können Bots deine robots.txt-Datei aufgrund des Formatfehlers nicht finden und crawlen.

- Falscher Speicherort: Die robots.txt-Datei befindet sich nicht im Root-Verzeichnis. Die Datei muss im obersten Verzeichnis der Website abgelegt werden. Befindet sie sich in einem Unterordner, ist deine robots.txt-Datei wahrscheinlich für Such-Bots nicht sichtbar. Um dieses Problem zu beheben, verschiebe deine robots.txt-Datei in das Stammverzeichnis.

In der Disallow-Direktive musst du bestimmte Dateien oder Seiten angeben, die nicht in den SERPs erscheinen sollen. Sie kann zusammen mit der User-agent-Direktive verwendet werden, um die Website für einen bestimmten Crawler zu blockieren.

- Leere Disallow-Direktive: Eine leere Disallow-Direktive teilt den Bots mit, dass sie alle Seiten der Website crawlen dürfen.

- Leere Zeilen in der robots.txt-Datei. Vermeide leere Zeilen zwischen den Regeln. Andernfalls können Bots die Datei nicht richtig crawlen. Leere Zeilen sollten nur vor der Angabe eines neuen User-Agents eingefügt werden.

Best Practices für robots.txt

- Achte auf korrekte Schreibweise: Bots unterscheiden bei Ordner- und Abschnittsnamen zwischen Groß- und Kleinschreibung. Ein Ordnername, der mit einem Großbuchstaben beginnt, führt zu Problemen, wenn der Crawler denselben Ordner mit einem Kleinbuchstaben sucht – und umgekehrt.

- Neue Zeile für jede Regel: Jede Regel muss mit einer neuen Zeile beginnen, und pro Zeile darf nur ein Parameter stehen.

- Keine Leerzeichen oder Sonderzeichen: Die Verwendung von Leerzeichen am Anfang einer Zeile, Anführungszeichen oder Semikolons bei Anweisungen ist strengstens untersagt.

- Vermeide die vollständige Auflistung von Dateien: Es ist nicht notwendig, jede Datei, die du blockieren möchtest, einzeln aufzulisten. Gib einfach den entsprechenden Ordner oder das Verzeichnis in der Disallow-Direktive an, und alle Dateien innerhalb dieses Ordners werden ebenfalls vom Crawling ausgeschlossen.

- Verwendung von regulären Ausdrücken: Nutze reguläre Ausdrücke für flexiblere Anweisungen in deiner robots.txt.

- Der Asterisk (*) steht für eine beliebige Wertvariation.

- Das Dollarzeichen ($) funktioniert ähnlich wie ein Asterisk und wird verwendet, um das Ende des URL-Pfades anzugeben.

- Verwende serverseitige Authentifizierung, um den Zugriff auf private Inhalte zu blockieren. So kannst du sicherstellen, dass wichtige Daten vor unbefugtem Zugriff geschützt sind.

- Verwende eine robots.txt-Datei pro Domain. Wenn du Crawling-Richtlinien für verschiedene Sites festlegen musst, erstelle eine separate robots.txt für jede davon.

Andere Möglichkeiten, deine robots.txt-Datei zu testen

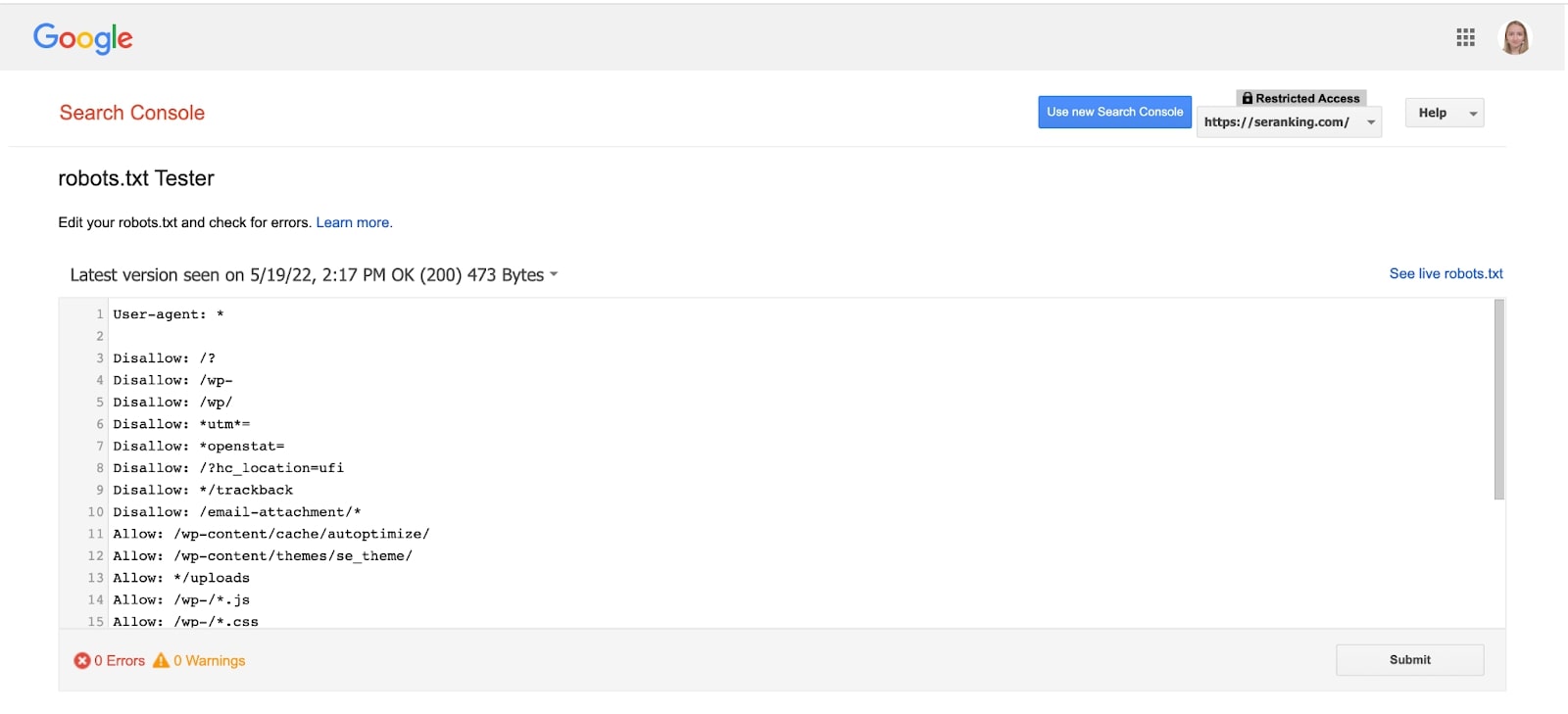

Du kannst deine robots.txt-Datei mit dem Google Search Console-Tool analysieren.

Dieser robots.txt-Tester zeigt dir, ob deine robots.txt-Datei Google-Crawler daran hindert, auf bestimmte URLs deiner Website zuzugreifen. Das Tool ist in der neuen Version von GSC nicht verfügbar, aber du kannst darauf zugreifen, indem du diesen Link anklickst.

Wähle deine Domain aus, und das Tool zeigt dir die robots.txt-Datei sowie alle Fehler und Warnungen.

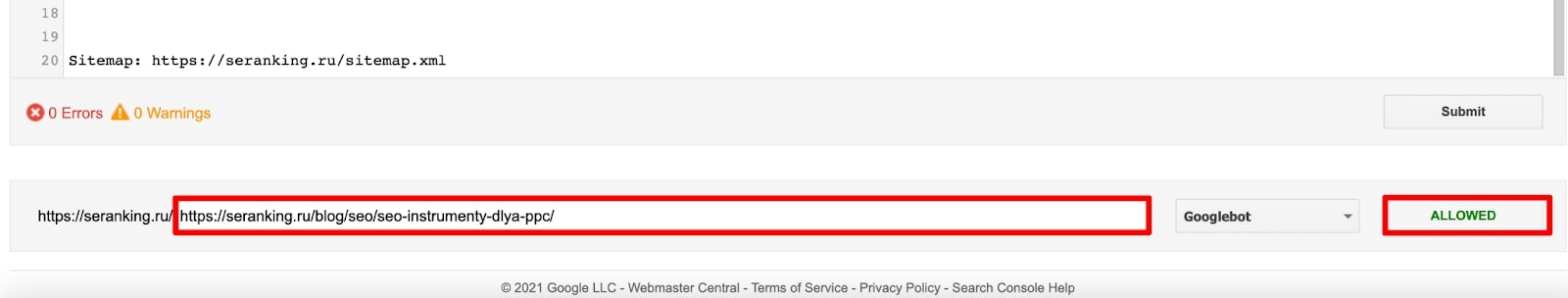

Unten auf der Seite kannst du die URL einer Seite in das Textfeld eingeben. Der robots.txt-Tester prüft dann, ob die URL korrekt durch deine robots.txt-Datei blockiert wurde.

Was sollte in einer robots.txt-Datei stehen?

Eine robots.txt-Datei enthält Anweisungen, die Crawlern helfen zu bestimmen, wie sie mit einer bestimmten Website interagieren sollen. Sie beginnt mit einer User-agent-Direktive (Regel), die den Suchbot spezifiziert, auf den die Regeln anwendbar sind. Danach folgen Direktiven, die angeben, welche Seiten und Dateien für Crawler erlaubt oder gesperrt sind. Am Ende einer robots.txt-Datei kann optional ein Link zur Sitemap hinzugefügt werden.

Können Bots robots.txt ignorieren?

Crawler beziehen sich immer auf eine vorhandene robots.txt-Datei, wenn sie eine Website besuchen. Obwohl die robots.txt-Datei Regeln für Bots bereitstellt, kann sie die Anweisungen nicht durchsetzen. Die robots.txt-Datei selbst ist eine Liste von Richtlinien für Crawler – keine strikten Regeln. Daher können Bots in einigen Fällen diese Anweisungen ignorieren.

Wie repariere ich robots.txt?

Eine robots.txt-Datei ist eine einfache Textdatei, die mit einem Texteditor bearbeitet werden kann. Ändere die Datei nach Bedarf und lade sie dann wieder in das Stammverzeichnis deiner Website hoch. Viele Content Management Systeme (CMS), wie zum Beispiel WordPress, bieten Plugins an, mit denen du die robots.txt-Datei direkt über das Admin-Dashboard bearbeiten kannst, ohne die Datei manuell auf dem Server zu ändern.