¿Qué es un archivo robots.txt, para qué sirve y cómo crearlo para SEO?

El archivo robots.txt es uno de los más importantes de cualquier sitio web. Bien configurado te permite crear las indicaciones que tú consideres necesarias para que los bots de Google rastreen tu página sin perder tiempo ni presupuesto.

Aunque también debes tener cuidado de no cometer ningún error con él, porque un pequeño fallo puede hacer que los motores de búsqueda dejen de acceder a contenidos importantes dentro de tu sitio. Y esto, como sabes, puede interferir en la indexación de tu sitio web.

Hoy queremos hablarte del archivo robots.txt. Veremos qué es, cómo puedes crearlo y cuáles son los elementos que componen este archivo tan importante.

¿Qué es el robots.txt?

El Robots.txt es un archivo de texto que se crea y se sube a una web para indicarle a los robots de los diferentes buscadores las páginas que no son accesibles, es decir, los contenidos que no queremos que sean rastreados, indexadas y mostrados en sus resultados de búsqueda.

Este protocolo de exclusión se utiliza para especificar los directorios, subdirectorios, URLs y/o archivos que tienen un acceso restringido dentro de un sitio. En definitiva, aquí se deja claro a los bots, arañas o crawlers de los motores de búsqueda por donde si pueden ir y por donde no.

Si tus páginas no tienen creado este archivo y bien configurado, los robots de los motores de búsqueda tendrán la libertad de rastrear absolutamente todo el contenido al completo del sitio web.

¿Por qué es importante el robots.txt?

Uno de los motivos principales por el que debes crear y configurar el archivo robots.txt en tu página web es para optimizar el tiempo o presupuesto de rastreo de los motores de búsqueda.

Esto quiere decir que tienes que priorizar el rastreo hacia los contenidos que más te interesen, como todo lo nuevo que vas publicando en tu web o lo más relevante de ella.

Aunque es cierto que este presupuesto no afecta demasiado a los sitios web más pequeñas, cuando estamos ante un sitio con un gran número de URL si es probable que los robots de los buscadores tengan problemas para rastrear todo el sitio al completo.

Aun así, el hecho de tener una web pequeña no significa que el archivo robots.txt no te resulte útil. Siempre te da más control sobre las partes de tu web que no quieres que rastreen los motores de búsqueda, además de ayudarte en diferentes situaciones.

Ventajas de configurar robots.txt

- Te ayuda a prevenir el rastreo de contenido duplicado.

- Puedes mantener las secciones de tu web que tú elijas en modo privado (esto es muy interesante si tienes una sección de membresía de pago o para que puedas crear un sitio de pruebas).

- También previenes la aparición de contenidos, archivos de recursos o imágenes en los resultados de búsqueda de Google.

- Además, puedes prevenir el rastreo de páginas de resultados de búsqueda interna.

¿Cuáles son los elementos que componen este archivo .txt?

El nombre del archivo robots.txt debe verse exactamente así, sin el uso de letras mayúsculas.

Según las pautas de Google, el tamaño de documento permitido es de 500 KB. Exceder este límite puede resultar en que el robot de búsqueda procese parcialmente el documento, no rastree el sitio web en absoluto o, por el contrario, escanee el contenido de un sitio web en su totalidad.

El aspecto que presenta un archivo robots.txt es el siguiente:

Sitemap: [URL donde está ubicado el Sitemap]

User-agent: [identificador de bot]

[directiva 1]

[directiva 2]

[directiva x]

User-agent: [identificador de bot diferente al anterior]

[directiva 1]

[directiva 2]

[directiva x]

El archivo está formado por grupos, los User-agents que, a su vez, están formados por las diferentes directivas que indican las instrucciones para los bots, es decir, si puede o no puede acceder.

Veamos con detalle los dos elementos que forman los grupos del archivo robots.txt.

1. User-agent

Cada motor de búsqueda está identificado con un user-agent concreto. Por ejemplo, el user-agent de Google es Googlebot, y el de Google Images es Googlebot-Image. Y por ponerte algunos ejemplos más, el de Bing es Bingbot y el de Yahoo es Slupr, entre otros.

A la hora de crearlos, si deseas crear una directiva para todos los motores de búsqueda puedes rellenar el campo con un *, en lugar de crear user-agents para cada uno de los bots.

En la creación de tu archivo robots.txt puedes incluir los user-agents que necesites con las directivas que darán las instrucciones al motor de búsqueda determinado. Recuerda que los user-agents distinguen entre mayúsculas y minúsculas.

2. Directivas

Las directivas son las reglas que quieres que sigan los user-agents que creas en tu archivo robots.txt.

Directivas admitidas por Google

Existen 3 directivas que están admitidas por Google en este momento:

Disallow

Esta directiva está indicando al bot que no rastree la información que estás especificando. Por ejemplo, imagina que no quieres que ningún motor de búsqueda rastree el blog de tu sitio web.

En este caso, debes dejarlo indicado así:

User-agent: *

Disallow: /blog

Allow

Está indicando a los motores de búsqueda justo lo contrario que la directiva anterior. Incluso, puedes dejar indicado que rastreen un contenido que está por debajo de una URL que está bloqueada.

Siguiendo con el ejemplo anterior, si quieres que un contenido del blog sí sea rastreado, entonces debes indicarlo así en tu robots.txt:

User-agent: *

Disallow: /blog

Allow: /blog/post-que-quiero-que-rastrees

Sitemap

Siempre es bueno que dejes indicado a los motores de búsqueda la ubicación de tu sitemap. Puedes incluir esta directiva en cualquier parte de tu archivo robots.txt, aunque lo más habitual es ponerla en la parte final.

Y en caso de que tu sitio web tenga más de un sitemap, también puedes dejarlo indicado:

Sitemap: https://tudominio.com/sitemap1.xml

Sitemap: https://tudominio.com/sitemap2.xml

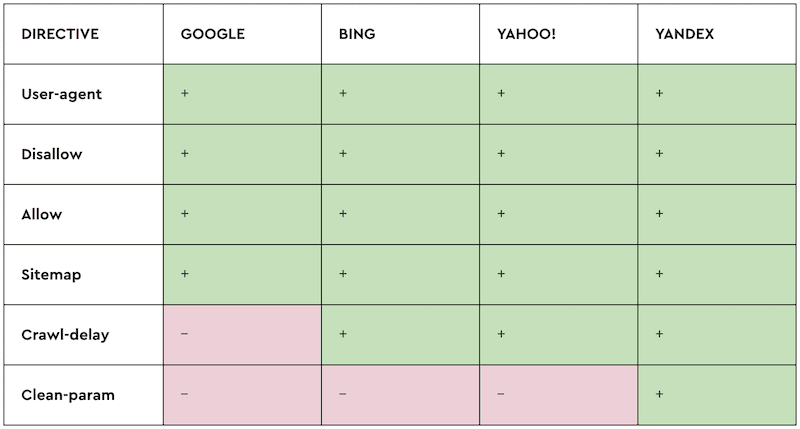

Directivas no admitidas por Google

Existen algunas directivas que ya no están admitidas por Google y es importante que las tengas en cuenta para evitar posibles errores en tu archivo robots.txt:

Crawl-delay

Se utilizaba para retardar el rastreo de una web durante 5 segundos. Esto resultaba muy útil en sitios web pequeños porque ahorraba ancho de banda. Sin embargo, Google ya no la admite a pesar de que Bing sí que reconoce esta directiva.

Noindex

Es una directiva que no está admitida por Google desde el 1 de septiembre de 2019. Si quieres que alguna parte de tu web no sea indexada por los motores de búsqueda, ahora tienes que utilizar la etiqueta meta robots o el encabezado HTTP x-robots.

Nofollow

Estamos ante otra directiva que fue excluida del soporte oficial de Google el 1 de septiembre de 2019. Los SEO la utilizaban para indicarle al bot del buscador que no siguiera enlaces en páginas con una ruta específica.

Utiliza la meta tag robots o el encabezado x-robots si quieres que los bots no sigan ningún enlace de una página. Y para que no rastreen un enlace concreto, usa el atributo de enlace rel=”nofollow”.

También te puede interesar:

¿Cómo crear el archivo robots.txt?

A la hora de crear el archivo robots.txt debes tener muy en cuenta que no puede tener formato. Por eso, lo mejor es que abras el bloc de notas de tu ordenador y empieces a escribir todas las directivas.

Guarda este documento como “robots.txt” y súbelo al directorio raíz del subdominio al que aplique.

Es muy importante que sepas cuáles son las URL que quieres dejar fuera del rastreo de los motores de búsqueda. Puede que, a priori, pienses que es bueno que Google rastree toda tu página. Sin embargo, depende de muchos factores.

Piensa que el número de contenidos que rastrea Google a diario es limitado, ¿te interesa que también se detenga en lugares que no son relevantes para ti, a pesar de que es tu sitio web?

Evita que los bots pasen por contenidos duplicados o de valor muy escaso, y aprovecha los contenidos de valor y todo lo nuevo que vas incorporando a tu web para que lo rastreen los motores de búsqueda.

A continuación, te compartimos 7 consejos que te ayudarán a crear tu archivo de manera correcta.

1. Crea un archivo robots.txt para cada subdominio

El archivo robots.txt controla el rastreo de los motores de búsqueda solo en el dominio donde está instalado. Si necesitas comprobar el rastreo en otros subdominios, tienes que crear otro archivo y subirlo al directorio raíz de este.

Por ejemplo, imagina que tu web está en dominio.com y el blog lo tienes en blog.dominio.com. Necesitas crear dos archivos para controlar el rastreo.

2. Especifica muy bien las directivas

Tómate tu tiempo a la hora de escribir las directivas de los user-agents. Así evitarás errores incómodos que pueden perjudicarte.

Veamos un ejemplo. Imagina que estás creando tu website en otro idioma y vas a dejarlo en el subdirectorio /en/. Como está en construcción y no quieres que lo rastreen los motores de búsqueda utilizas la directiva Disallow para indicar a los bots que no rastreen, así:

User-agent: Googlebot

Disallow: /en

En principio, esta directiva está diciéndole a los motores de búsqueda que no entre a esta subcarpeta y todo lo que contiene. Pero también está restringiendo el acceso a cualquier página o archivo que empiece con /en. Soluciona este problema añadiendo una “/” detrás: /en/.

3. Utiliza una línea para cada directiva

Cada directiva tiene que ir en una línea diferente, de lo contrario, los motores de búsqueda entrarán en conflicto y no cumplirán con tus indicaciones.

No pongas: User-agent: * Disallow: /blog/

Lo correcto es así:

User-agent: *

Disallow: /blog/

4. Utiliza cada user-agent con una sola directiva

Puede que estés pensando que es bueno poner todas las directivas bajo el mismo user-agent. Sin embargo, esto puede confundir al motor de búsqueda.

Tienes que abrir un user-agent para cada directiva que vayas creando. Por ejemplo:

User-agent: Googlebot

Disallow: /a/

User-agent: Googlebot

Disallow: /b/

5. Los asteriscos te ayudan a simplificar las instrucciones

Ya sabes que un asterisco en un user-agent es como lanzar el mensaje para todos los motores de búsqueda, no solo Google.

Puedes hacer lo mismo en las directivas. Por ejemplo, si quieres que los bots de Google no rastreen las URL que hay en una subcarpeta, no necesitas crear una directiva para cada una de ellas, la forma más eficiente de hacerlo es esta:

User-agent: *

Disallow: /productos/*?

El ejemplo bloquea todas las URL bajo la carpeta /productos/ que contengan un signo de interrogación.

6. El símbolo $ bloquea las terminaciones de las URL

Cuando incluyes el símbolo del dólar en una directiva, estás diciéndole al motor de búsqueda que no acceda a las URL de tu web que tienen esa terminación.

Por ejemplo, imagina que no quieres rastrear los archivos en formato pdf. Debes hacer este user-agent:

User-agent: *

Disallow: /*.pdf$

Con esta instrucción estás diciéndole al motor de búsqueda que no rastree las URL cuya terminación es .pdf. Sin embargo, si en tu web hay alguna URL del estilo /documento.pdf?id=e87u3434 los bots sí la rastrearán porque no termina en .pdf.

7. Deja comentarios

Dentro del archivo robots.txt puedes incluir comentarios con lo que quieras escribir. Por ejemplo, puede ser muy útil si estás trabajando en un proyecto muy grande y participáis más de un SEO.

En una línea nueva pon el símbolo # y escribe la aclaración que necesites. Cuando lleves muchas directivas te ayudará mucho tener esa breve explicación de por qué lo hiciste.

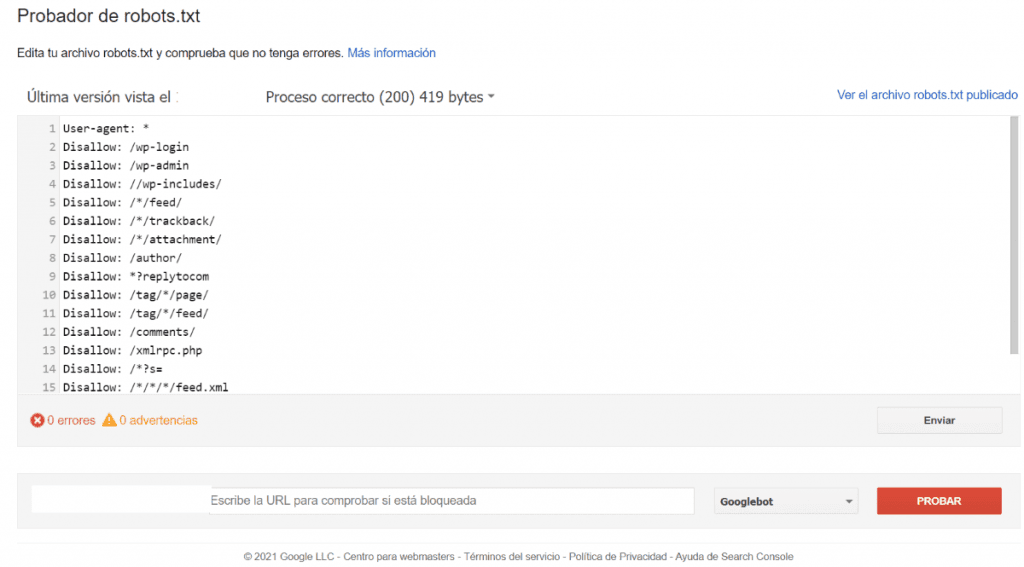

¿Cómo verificar este archivo con el Probador de robots.txt?

Dentro de Google Search Console puedes comprobar el estado de tu archivo. Una vez que abres el Probador de robots.txt puedes escribir la URL para que la aplicación te confirme si está bloqueada, o no, para su rastreo.

Además, la propia herramienta de Google te muestra tu archivo robots.txt con todas las directivas.

Conclusión

El archivo robots.txt afecta de forma directa a una de las partes más importantes del SEO, el rastreo. Ya hemos visto en este artículo que una pequeña equivocación en su configuración puede traer consecuencias muy negativas para un sitio web.

Nuestro mejor consejo es que antes de comenzar a crear el robots.txt de tu web, te sientes con tranquilidad a analizar qué URL quieres dejar fuera del rastreo.

¿Tienes controlado los archivos robots.txt de tu sitio web?

¿Qué páginas o contenido has decidido bloquear en el rastreo de Google?

Cuéntanos en comentarios