Hoe stel je het robots.txt-bestand in? Alles wat je moet weten!

Het robots.txt-bestand helpt de bots van zoekmachines door hen te vertellen welke pagina’s wel en niet gecrawld moeten worden. Houd er hierbij echter rekening mee, dat een bot deze instructies kan negeren.

Het robots.txt-bestand kan de indexering van pagina’s en bestanden op een website niet altijd voorkomen, maar hier wel invloed op uitoefenen.

Hoewel robots.txt, meta robots en x-robots de bots van zoekmachines instrueren, verschillen ze in hun toepassing: robots.txt regelt het crawlen van een website, meta robots-tags werken op paginaniveau en de X-Robots-tag biedt meer gedetailleerde controle over indexering.

Door voor de gebruiker nutteloze content op een website te verbergen met de disallow-functie, wordt je crawl budget efficiënter ingezet. Tegelijkertijd wordt zo voorkomen dat content ongewenst in de zoekresultaten verschijnt.

Door de syntaxis regels te volgen, zorgen we ervoor dat zoekrobots je robots.txt-bestand correct kunnen lezen en deze begrijpen.

Je kunt een robots.txt-bestand zelf maken met teksteditors die UTF-8-codering ondersteunen, of via ingebouwde tools in populaire CMS-platforms zoals WordPress, Magento en Shopify. Kijk ook eens naar een voorbeeld van een bestaand robots.txt-bestand.

Controleer je gecreëerde robots.txt-file met tools zoals Google Search Console of die van SEO-platforms zoals SE Ranking. Het helpt je potentiële problemen snel te identificeren en zorgt ervoor dat het bestand werkt zoals bedoeld.

Problemen die zich vaak voordoen hebben betrekking op onjuistheden in de opmaak, een onjuiste plaatsing van het bestand, een verkeerd gebruik van instructies of het toepassen van tegenstrijdigheden daarin.

Houd er rekening mee dat de instructies in een robots.txt-bestand hoofdlettergevoelig zijn. Zorg er daarbij voor dat elke instructie op een nieuwe regel staat, gebruik wildcards voor flexibiliteit, creëer aparte bestanden voor verschillende domeinen en test je website na het updaten van het robots.txt-bestand om ervoor te zorgen dat belangrijke URL’s niet per ongeluk geblokkeerd worden.

Wat is een robots.txt bestand?

Een robots.txt-bestand is een tekstdocument dat zich in de hoofdmap van een website op de server bevindt. De informatie die het bestand bevat, is specifiek bedoeld voor de crawlers van zoekmachines. Het instrueert hen over welke URL’s, verwijzend naar zowel pagina’s, als bestanden en bijvoorbeeld mappen, gecrawld moeten worden en welke niet. Hoewel de aanwezigheid van dit bestand geen voorwaarde is om een website te laten functioneren, is het wel zaak deze correct in te stellen voor een goede SEO ervan.

Het besluit om te starten met robots.txt werd in 1994 genomen als onderdeel van de Robot Exclusion Standard. Volgens Google Search Central is het primaire doel van dit bestand niet om webpagina’s te verbergen in de zoekresultaten, maar om het aantal verzoeken van robots aan websites te beperken en daarmee de serverbelasting te verminderen.

In algemene zin kun je de inhoud van het robots.txt-bestand zien als een aanbeveling voor crawlers van zoekmachines, waarin de instructies voor het crawlen van websites gedefinieerd worden. Om toegang te krijgen tot de inhoud van het robots.txt-bestand van een website, typ je “/robots.txt” na de domeinnaam in de browser.

Hoe werkt robots.txt?

Allereerst is het belangrijk om op te merken dat zoekmachines de zoekresultaten in de SERP’s moeten crawlen en indexeren. Om deze taak te volbrengen, browsen webcrawlers systematisch over het web en verzamelen ze data van elke webpagina die ze tegenkomen. De term “spideren” wordt af en toe gebruikt om deze activiteit van de crawlers te beschrijven.

Wanneer deze crawlers een website bereiken, bekijken ze het robots.txt-bestand, dat instructies bevat over hoe pagina’s op de website gecrawld en geïndexeerd moeten worden. Als er echter geen robots.txt-bestand op de website voorkomt, of als deze geen instructies bevat die user agent-activiteit verbieden, zullen zoekrobots de website blijven crawlen totdat het crawl budget of andere beperkingen zijn bereikt.

Waarom heb je robots.txt nodig?

De primaire functie van het robots.txt-bestand is om het scannen van specifieke pagina’s en bijvoorbeeld losse bestanden te voorkomen, waardoor het crawl budget efficiënter kan worden toegewezen. In de overgrote meerderheid van de gevallen verbergt het robots.txt-bestand informatie die geen waarde biedt aan websitebezoekers en zoekrobots.

Note: Het gebruik van de “robots.txt disallow”-functie garandeert niet dat een bepaalde webpagina of een bestand niet gecrawld of uitgesloten wordt in de SERP. Google behoudt zich het recht voor om verschillende externe factoren, zoals inkomende links, te overwegen bij het bepalen van de relevantie van een webpagina en de opname ervan in de zoekresultaten. Om expliciet te voorkomen dat een pagina wordt geïndexeerd, wordt aanbevolen om de robots-metatag “noindex” of de HTTP-header X-Robots-Tag te gebruiken. Ook beveiliging middels een wachtwoord kan worden gebruikt om indexering te voorkomen.

Optimaliseren van het crawl budget

Het crawl budget verwijst naar het aantal pagina’s op een website dat een zoekrobot kan crawlen. Om het crawl budget efficiënter te gebruiken, is het zaak om zoekrobots uitsluitend naar de belangrijkste content op websites te gidsen.

Door de inzet van het crawl budget te optimaliseren, help je zoekmachines hun beperkte middelen efficiënt toe te wijzen. Dit resulteert in een snellere indexering van nieuwe content en daarmee een verbeterde zichtbaarheid van je website in de zoekresultaten. Het is belangrijk om te begrijpen dat wanneer je website meer pagina’s heeft dan je crawl budget toestaat, sommige pagina’s mogelijk niet gecrawld en daarmee ook niet geïndexeerd worden. Deze niet-geïndexeerde pagina’s zullen niet in de SERP verschijnen. Een optimalisatie van de instructies voor crawlers helpt zeker grote websites te verzekeren dat zoekmachines je belangrijkste pagina’s volledig dekken.

Neem een scenario waarbij je website relatief veel triviale content bevat, zoals losse bestanden, in verhouding tot het aantal primaire pagina’s. In gevallen als deze kun je jouw crawl budget optimaliseren door ongewenste bronnen uit te sluiten van de ‘te bezoeken’-lijst voor de crawler van zoekmachines.

Je kunt bijvoorbeeld de “Disallow”-instructie gebruiken, gevolgd door een specifieke bestandsextensie, zoals “Disallow:/*.pdf”, om te voorkomen dat zoekmachines PDF-bronnen op je website crawlen en indexeren. Dit biedt een effectieve manier om dergelijke bronnen te verbergen en ervoor te zorgen dat ze niet in de SERP van zoekmachines worden opgenomen.

Een ander veelvoorkomend voordeel van het gebruik van robots.txt is de mogelijkheid om problemen met het crawlen van content op je server aan te pakken, als deze zich voordoen. Wanneer je bijvoorbeeld oneindige kalender scripts hebt die problemen kunnen veroorzaken wanneer ze vaak door robots worden geopend, kun je het crawlen van die specifieke script via het robots.txt-bestand verbieden.

Je vraagt je misschien ook af of het zinvol is om robots.txt te gebruiken om affiliate links te blokkeren, of om de noindex tag te gebruiken om te voorkomen dat zoekmachines deze affiliate links indexeren. Het antwoord is simpel: Google zelf is al goed in het identificeren en negeren van deze affiliate links, vooral als ze correct zijn gemarkeerd. Al geldt dat door het robots.txt te gebruiken om ze te verbieden, je meer controle behoudt en je het crawl budget zodoende mogelijk effectiever kunt inzetten.

Voorbeeld van robots.txt-bestand

Een voorbeeld van robots.txt met up-to-date instructies kan je helpen dit bestand zelf op een correcte wijze op te stellen. Je kunt in onderstaand sjabloon de verschillende robots specificeren en de toegang tot relevante bestanden beperken.

User-agent: [bot name]

Disallow: /[path to file or folder]/

Disallow: /[path to file or folder]/

Disallow: /[path to file or folder]/

Sitemap: [Sitemap URL]

Laten we nu eens een paar voorbeelden bekijken van hoe een robots.txt-bestand eruit zou kunnen zien.

1. Iedere crawler toegang geven tot alle content.

Dit is een eenvoudig voorbeeld van een robots.txt-bestand dat alle webcrawlers toegang verleent tot alle websites:

User-agent: *

Crawl-delay: 10

# Sitemaps

Sitemap: https://www.usa.gov/sitemap.xml

In dit voorbeeld gebruikt de instructie “User-agent” een asterisk (*) om de instructies toe te passen op alle webcrawlers. Crawl-delay geeft crawlers ongehinderde toegang, maar vraagt hen om 10 seconden te wachten tussen het versturen van verzoeken. De instructie gerelateerd aan de sitemap beperkt de toegang niet, maar wijst crawlers direct naar de locatie van het bestand. Regels die beginnen met een hekje zijn opmerkingen die door crawlers worden genegeerd.

2. Een losse webcrawler de toegang tot een specifieke webpagina ontzeggen.

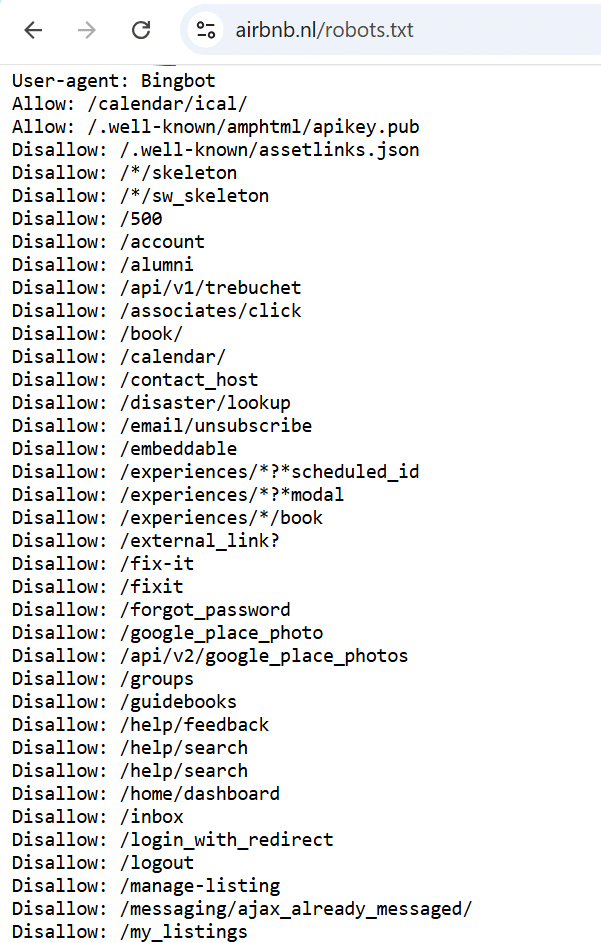

Het volgende voorbeeld specificeert toegangsrechten voor de “Bingbot” user agent. Dit is de webcrawler die wordt gebruikt door de zoekmachine van Microsoft, Bing. Het bestand bevat een lijst met directories die niet gescand mogen worden, evenals een paar directories en pagina’s die juist wel toegankelijk zijn voor de crawler.

3. Alle webcrawlers blokkeren voor alle content.

User-agent: *

Disallow: /

In dit voorbeeld heeft de “User-agent”-instructie opnieuw betrekking op alle webcrawlers, net als in het eerste voorbeeld. De “Disallow”-instructie gebruikt nu echter een slash (/) als waarde, wat de webcrawlers van alle zoekmachines vertelt dat de content op de website niet gescand mag worden.

Houd er rekening mee dat het op deze wijze, middels het robots.txt-bestand, blokkeren van de toegang tot pagina’s voor alle webcrawlers een extreme maatregel is en in de meeste gevallen niet wordt aanbevolen. Een situatie waarin dit wel nuttig is: bij de ontwikkeling van een nieuwe website, waarbij je de indexering ervan door zoekmachines in eerste instantie wilt voorkomen. In andere situaties gebruiken websites doorgaans het robots.txt-bestand om de toegang tot specifieke delen van hun website te beheren. Het maakt het mogelijk om bepaalde mappen of bestanden te blokkeren.

Zo vind je het robots.txt-bestand

Je kunt het robots.txt-bestand op een website op een aantal manieren vinden:

Zo kun je “/robots.txt” toevoegen aan de domeinnaam van de website die je wilt onderzoeken. Als het domein van de website bijvoorbeeld “example.com” is, typ je “example.com/robots.txt” in de adresbalk van je webbrowser. Dit brengt je rechtstreeks naar het robots.txt-bestand als dit op de website aanwezig is.

Een andere, minder vaak gebruikte methode voor CMS-gebruikers, is om robots.txt-bestanden in zo’n systeem op te sporen en te bewerken. Laten we eens een paar populaire doornemen.

Robots.txt binnen WordPress

Het opzoeken en bewerken van een robots.txt-bestand in WordPress doe je handmatig of via een plug-in.

Om er een handmatig te maken:

- Maak zelf een tekstbestand met de naam “robots.txt”

- Upload het bestand naar de hoofdmap van je website via een FTP-client

Gebruik de Yoast SEO plug-in:

- Ga naar Yoast SEO > Gereedschap

- Klik op Bestandseditor (zorg ervoor dat je bestandsbewerking hebt ingeschakeld)

- Klik op de Maak robots.txt bestand aan-button

- Bekijk of bewerk hier vervolgens de robots.txt

Gebruik de All in One SEO plug-in:

- Ga naar All in One SEO > Tools

- Klik op de Robots.txt Editor

- Klik op de schakelaar om Custom Robots.txt in te schakelen.

- Bekijk of bewerk hier vervolgens de robots.txt

Robots.txt binnen Magento

Magento genereert standaard automatisch een robots.txt-bestand.

Om deze te bewerken:

- Meld je aan bij het beheerderspaneel van Magento

- Ga naar Inhoud > Design > Configuratie

- Klik op Bewerken voor de gekozen website

- Klap de Search Engine Robots-sectie uit

- Bewerk het bestand via het Bewerk aangepaste instructies van robots.txt-bestand-veld

- Sla je bewerkingen op

Robots.txt binnen Shopify

Shopify genereert standaard automatisch een robots.txt-bestand.

Om deze te bewerken:

- Meld je aan bij het beheerderspaneel van Shopify

- Klik op Instellingen > Apps en verkoopkanalen

- Ga naar Online store > Verkoopkanaal openen > Thema’s

- Klik op de … button en daarna op Code bewerken

- Klik op Een nieuwe template toevoegen > robots

- Klik vervolgens op Template maken

- Bewerk de content op de manier zoals je wilt

- Sla je wijzigingen op

Hoe zoekmachines je robots.txt-bestand vinden

Zoekmachines hebben hun eigen mechanismen om het robots.txt-bestand op je website te vinden en te scannen. Dit is hoe ze het doorgaans aanpakken:

1. Website crawlen: Crawlers van zoekmachines doorzoeken voortdurend het web, bezoeken websites en volgen links om nieuwe webpagina’s te ontdekken.

2. Robots.txt opvragen: Wanneer de crawler van een zoekmachine een website bezoekt, zoekt hij naar de aanwezigheid van een robots.txt-bestand door “/robots.txt” toe te voegen aan het domein van de website.

Note: Nadat je jouw robots.txt-bestand succesvol geüpload en getest hebt, detecteren de crawlers van Google dit bestand automatisch en zullen ze de hierin opgegeven instructies gebruiken. Je hoeft geen verdere actie te ondernemen. Wil je echter dat de aangebrachte wijzigingen in een bestaand robots.txt-bestand de gecachte versie van Google overschrijven, dan is het zaak om te leren hoe je een bijgewerkt robots.txt-bestand indient.

3. Robots.txt ophalen: Als er op de opgevraagde locatie een robots.txt-bestand aanwezig is, downloadt en scant de crawler het bestand om de instructies voor het crawlen van de website te bepalen.

4. Opvolgen van instructies: Nadat de crawler van de zoekmachine het robots.txt-bestand gescand heeft, volgt hij de instructies die daarin beschreven staan.

Robots.txt vs. meta robots vs. x-robots

Hoewel het robots.txt-bestand, de robots-metatag en de X-Robots-Tag vergelijkbare doelen dienen wat betreft het instrueren van de spiderbots van zoekmachines, verschillen ze in hun toepassing en controlegebied.

Als het gaat om het verbergen van content op een website in zoekresultaten, is het waarschijnlijk niet voldoende om alleen op het robots.txt-bestand te vertrouwen. Zoals eerder vermeld, is het robots.txt-bestand voornamelijk een aanbeveling voor webcrawlers. Het informeert hen over welke delen van een website ze mogen bezoeken. Het garandeert echter niet dat sommige content niet door zoekmachines wordt geïndexeerd. Om indexering te voorkomen, moeten webmasters aanvullende methoden gebruiken.

Robots meta tag

Een van de mogelijke technieken hierbij is het gebruik van de robots-metatag, die in de <head>-sectie van de HTML-code van een pagina wordt geplaatst. Door een metatag met de “noindex”-instructie op te nemen, geven webmasters expliciet aan zoekmachine bots aan dat de inhoud van de pagina niet geïndexeerd mag worden. Deze methode biedt een uitgebreidere controle over individuele pagina’s en hun indexeringsstatus, in vergelijking met de algemene instructies die in het robots.txt-bestand worden opgenomen.

Dit is een voorbeeld van een stukje code dat helpt te voorkomen dat zoekmachines indexeren op paginaniveau:

<meta name=“robots” content=“noindex”>

Vergelijkbaar met robots.txt-bestanden, is het met deze metatag mogelijk om de toegang voor specifieke bots te beperken. Om de toegang voor bijvoorbeeld Googlebot te beperken, gebruik je:

<meta name=“googlebot” content=“noindex”>

X-Robots-Tag

Je kunt ook de X-Robots-Tag in het configuratiebestand van een website gebruiken om de indexering van een pagina te beperken. Deze methode biedt een extra laag van controle en flexibiliteit bij het beheren van de indexering op een granulair niveau.

Wil je meer weten over dit onderwerp? Bekijk dan onze complete gids over de robots-metatag en de X-Robots-Tag eens.

Pagina’s en bestanden die normaliter worden afgesloten via robots.txt

1. Dashboard voor beheerders en systeembestanden.

Interne- en servicebestanden waarmee alleen websitebeheerders of webmasters mogen werken.

2. Hulppagina’s die alleen verschijnen na specifieke gebruikersacties.

Pagina’s voor klanten die hun bestelling succesvol afronden, specifieke formulieren voor klanten en bijvoorbeeld pagina’s gerelateerd aan autorisatie of het herstel van wachtwoorden.

3. Pagina’s met zoekresultaten op een website.

Pagina’s die worden weergegeven nadat een bezoeker een zoekopdracht in het zoekvak van de website heeft ingevoerd, zijn vaak afgesloten voor de crawlers van zoekmachines.

4. Gefilterde pagina’s.

Resultaten die worden weergegeven met een toegepast filter (formaat, kleur, fabrikant, etc.) zijn afzonderlijke pagina’s en kunnen worden beschouwd als dubbele content. SEO-experts voorkomen doorgaans dat ze worden gecrawld, tenzij ze verkeer genereren via merkgerelateerde zoekwoorden of andere doel query’s. Verzamelwebsites, zoals Google News, vormen mogelijk een uitzondering.

5. Bestanden van een bepaald formaat.

Bestanden zoals foto’s, video’s, .PDF-documenten en JS-bestanden. Met behulp van robots.txt kun je het scannen van individuele of extensie-specifieke bestanden beperken.

Robots.txt syntax

Voor webmasters is het belangrijk om de syntaxis en structuur van het robots.txt-bestand te begrijpen om de zichtbaarheid van hun webpagina’s binnen zoekmachines te kunnen beheren. Het robots.txt-bestand bevat doorgaans een set regels die bepalen welke bestanden op een domein of subdomein toegankelijk zijn voor crawlers. Deze regels kunnen toegang tot specifieke bestandspaden blokkeren of toestaan. Standaard wordt het crawlers toegestaan om alle bestanden te crawlen, tenzij expliciet anders vermeld is in het robots.txt-bestand.

Het robots.txt-bestand bestaat uit groepen of secties, die elk meerdere regels of instructies bevatten. Deze regels worden ieder op hun eigen rij in het bestand vermeld. Elke groep begint met een User agent-regel die specificeert op wie de regels en instructies van toepassing zijn.

Een groep verstrekt de volgende informatie:

- De user agent waarop de regels van toepassing zijn.

- De mappen of bestanden waartoe de user agent toegang heeft.

- De mappen of bestanden waartoe de user agent geen toegang heeft.

Bij het verwerken van het robots.txt-bestand volgen crawlers een top-to-bottom-benadering. Houd er rekening mee dat een user agent slechts één regelset kan matchen. Als er meerdere groepen zijn die dezelfde user agent targeten, worden deze groepen samengevoegd tot één groep voordat ze worden verwerkt door de agent.

Dit is een voorbeeld van een eenvoudig robots.txt-bestand met twee regels:

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Allow: /

Sitemap: https://www.example.com/sitemap.xml

Als je een uitgebreide controle wilt over het gedrag van de crawler, kun je reguliere expressies gebruiken in combinatie met flexibele crawler instructies.

Een veelgebruikt symbool in reguliere expressies voor robots.txt-bestanden is de asterisk (*). Deze fungeert als wildcard en kan een eventuele variatie in de waarde aangeven.

Een ander symbool dat kan worden gebruikt in reguliere expressies voor robots.txt-bestanden is het dollarteken ($), dat het einde van het URL-pad aangeeft. Als je bijvoorbeeld een URL-patroon “/blog/$” hebt, omvat dit alleen URL’s die eindigen op “/blog/”, zoals “/blog/” of “/category/blog/”. Het omvat echter geen URL’s zoals “/blog/article” of “/blog/page/2”.

Je kunt ook toegang verlenen tot alle URL’s onder een specifieke directory, met behulp van het patroon “/example/” in je robots.txt-bestand. Dit omvat URL’s zoals “/example/page1.html”, “/example/subdirectory/page2.html”, enzovoorts, wat het voor robots mogelijk maakt om die URL’s te crawlen.

Laten we nu eens wat gedetailleerder naar de verschillende elementen van de robots.txt-syntaxis kijken.

De User Agent-instructie

De user agent-regel is verplicht en definieert de zoekrobot waarop de regels van toepassing zijn. Elke regelgroep begint met deze regel als er meerdere bots zijn.

Google heeft verschillende bots die verantwoordelijk zijn voor verschillende soorten content.

- Googlebot: crawlt websites voor desktop- en mobiele apparaten

- Googlebot Image: crawlt afbeeldingen op websites om deze weer te geven onder ‘Afbeeldingen’ en scant producten die voorzien zijn van een afbeelding

- Googlebot Video: scant en toont video’s

- Googlebot News: selecteert nuttige en kwalitatief hoogwaardige artikelen voor ‘Google Nieuws’

- Google-InspectionTool: een URL-testtool die de Googlebot nabootst door elke pagina te crawlen waartoe hij toegang heeft

- Google StoreBot: scant verschillende soorten webpagina’s, zoals productdetails, winkelwagen- en betaalpagina’s.

- GoogleOther: haalt openbaar toegankelijke content op van websites, inclusief eenmalige crawls voor intern onderzoek en ontwikkeling

- Google-CloudVertexBot: crawlt websites op verzoek van websitebeheerders bij het bouwen van Vertex AI Agents

- Google-Extended: een op zichzelf staand product dat wordt gebruikt om te kijken of websites bijdragen aan het verbeteren van Gemini Apps en Vertex AI generatieve API’s en toekomstige modellen

Er is ook een aparte groep bots, of speciale crawlers, waaronder AdSense, Google-Safety en anderen. Deze bots kunnen ander gedrag vertonen en andere rechten hebben dan gewone crawlers.

De volledige lijst met Google-robots (user agents) is beschikbaar in de officiële Help-documentatie.

Andere zoekmachines hebben vergelijkbare robots, zoals Bingbot voor Bing, Slurp voor Yahoo!, Baiduspider voor Baidu, en nog veel meer. Er zijn meer dan 500 verschillende zoekmachine bots.

Voorbeeld

- User-agent: * geldt voor alle bestaande robots.

- User-agent: Googlebot is van toepassing op de robot van Google.

- User-agent: Bingbot is van toepassing op de robot van Bing.

- User-agent: Slurp is van toepassing op de robot van Yahoo!.

De Disallow-instructie

Disallow is een belangrijke instructie, die robots van zoekmachines bewust instrueert om een pagina, bestand of map niet te scannen. De namen van de bestanden en mappen waartoe je de toegang wilt beperken, worden aangegeven na het symbool “/”.

Voorbeeld 1. Verschillende parameters na Disallow-instructie.

Disallow: /link naar pagina blokkeert toegang tot een specifieke URL.

Disallow: /mapnaam/ sluit de toegang tot de map.

Disallow: /*.png$ sluit de toegang tot afbeeldingen in PNG-formaat.

Disallow: /. Het ontbreken van instructies na het “/”-symbool geeft aan dat de website helemaal niet gescand mag worden, wat handig kan zijn tijdens de ontwikkeling van een nieuwe website.

Voorbeeld 2. Het scannen van alle .PDF-bestanden op een website verbieden.

User-agent: Googlebot

Disallow: /*.pdf$

De Allow-instructie

In het robots.txt-bestand functioneert de Allow-instructie tegenovergesteld aan de Disallow-instructie, door robots opdracht te geven de content op een website juist wel te scannen. Beide opdrachten worden vaak samen gebruikt, vooral wanneer je toegang wilt verlenen tot specifieke informatie, zoals een foto in een verder verborgen bestandsmap.

Voorbeeld. Met de Allow-instructie één afbeelding in een gesloten map laten scannen.

Geef de Allow-instructie op met de URL van de afbeelding en, op een andere regel, de Disallow-instructie samen met de mapnaam waar het bestand zich bevindt. De volgorde van de regels is belangrijk, omdat crawlers groepen van boven naar beneden verwerken.

Disallow: /album/

Allow: /album/picture1.jpg

De “robots.txt Allow All”-instructie wordt doorgaans gebruikt wanneer er geen specifieke beperkingen zijn voor zoekmachines. Het is echter belangrijk om op te merken dat de “Allow: /”-instructie geen noodzakelijk onderdeel is van het robots.txt-bestand. Sommige webmasters kiezen er zelfs voor om deze helemaal niet op te nemen en vertrouwen daarmee op het standaardgedrag van de crawlers van zoekmachines.

Houd er rekening mee dat de Allow-instructie geen deel uitmaakt van de originele robots.txt-specificatie. Dit betekent dat deze mogelijk niet door alle bots wordt ondersteund. Hoewel veel populaire crawlers zoals Googlebot de Allow-instructie herkennen en respecteren, geldt dit mogelijk niet voor anderen.

Volgens Standard for Robots Exclusion, worden niet-herkende headers genegeerd. Dit betekent dat voor bots die de “Allow”-instructie niet herkennen, het resultaat anders kan zijn dan wat een webmaster verwachtte. Houd hier rekening mee bij het maken van je robots.txt-bestanden.

De Sitemap-instructie

De sitemap-instructie in robots.txt geeft het pad naar de sitemap aan. Deze regel kan worden weggelaten als de sitemap een standaardnaam heeft, zich in de root-directory bevindt en toegankelijk is via de link “website”/sitemap.xml, vergelijkbaar met het robots.txt-bestand.

Voorbeeld

Sitemap: https://website.com/sitemap.xml

Waar het robots.txt-bestand voornamelijk wordt gebruikt om het scannen van je website te organiseren, helpt de sitemap zoekmachines de hiërarchische structuur van je content te doorgronden. Door een link naar je sitemap in het robots.txt-bestand op te nemen, help je crawlers van zoekmachines de sitemap te vinden en te analyseren, wat leidt tot het efficiënter crawlen en indexeren van je website. Het opnemen van deze regel in robots.txt is niet verplicht, maar wel sterk aanbevolen.

Opmerkingen

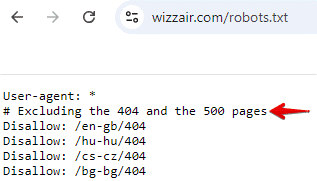

Je kunt opmerkingen toevoegen aan het robots.txt-bestand waarin je specifieke instructies nader uitlegt, wijzigingen of updates van het bestand documenteert, verschillende secties organiseert of context biedt aan andere teamleden. Opmerkingen zijn regels die beginnen met het “#”-symbool. Bots negeren deze regels bij het verwerken van het bestand. Ze helpen jou en andere teamleden het bestand te begrijpen, maar hebben geen invloed op hoe bots het lezen. Hier is een voorbeeld uit het robots.txt-bestand van Wizzair.

Als reactie op de opkomst van AI-technologie zoekt Google naar manieren om een aanvullend robots.txt-protocol te ontwikkelen. Het doel daarvan is om publishers meer controle te geven over het gebruik van hun content, met name in AI- en onderzoekstoepassingen.

Dit initiatief laat zien dat webstandaarden zich voortdurend evolueren om zich aan te passen aan nieuwe uitdagingen, zoals die van AI-technologie. Het is belangrijk om op de hoogte te blijven van deze ontwikkelingen, omdat ze van invloed kunnen zijn op hoe content later wordt gecrawld, gescand en gebruikt.

Hoe je robots.txt instellingen instelt

Een goed opgesteld robots.txt-bestand vormt de basis voor technische SEO.

Omdat het bestand een .txt-extensie heeft, is elke teksteditor die UTF-8-codering ondersteunt geschikt. De eenvoudigste opties zijn Kladblok (Windows) of TextEdit (Mac).

Zoals we eerder vermeldden, bieden ook de meeste CMS-platforms standaard oplossingen voor het maken van een robots.txt-bestand. WordPress creëert bijvoorbeeld standaard een virtueel robots.txt-bestand, dat online kan worden bekeken door “/robots.txt” toe te voegen aan de domeinnaam van de website. Het bewerken van dit bestand kan via een plug-in (bijvoorbeeld Yoast of All in One SEO) of handmatig.

Ook Magento en Wix genereren automatisch een robots.txt-bestand, maar dat bevat uitsluitend basisinstructies voor webcrawlers. Het is daarom raadzaam om aangepaste robots.txt-instructies te maken binnen deze systemen om het gebruik van je crawl budget te optimaliseren.

Een derde optie is het gebruik van tools als SE Ranking’s Robots.txt Generator, om een aangepast robots.txt-bestand te genereren op basis van de door jou opgegeven informatie. Je hebt de optie om een robots.txt-bestand vanaf nul te maken, of om een van de voorgestelde opties te kiezen.

Als je een robots.txt-bestand maakt, kun je het bestand op de volgende manieren personaliseren:

- Door instructies voor crawlrechten te configureren.

- Door specifieke pagina’s en bestanden op te geven via de padparameter.

- Door te bepalen welke bots zich aan deze richtlijnen moeten houden.

Als alternatief kunnen reeds bestaande robots.txt-sjablonen, waaronder de veelgebruikte algemene en CMS-instructies, worden geselecteerd. Het is ook mogelijk om een sitemap in het bestand op te nemen. Deze tool bespaart tijd door een kant-en-klaar robots.txt-bestand te bieden, die je direct kunt downloaden.

Documenttitel en omvang

Het robots.txt-bestand moet exact de naam hebben die is vermeld, zonder hoofdletters. Volgens de richtlijnen van Google mag de bestandsgrootte niet groter zijn dan 500 KiB. Een overschrijding van deze limiet kan resulteren in gedeeltelijke verwerking, volledige mislukking van het crawlen van de website of juist een ongewenste volledige scan van de content op de website.

Waar het bestand moet worden geplaatst

Het robots.txt-bestand moet zich in de rootdirectory van de website host bevinden en kan via FTP worden geopend. Voordat je wijzigingen aanbrengt, wordt aanbevolen het originele robots.txt-bestand in de originele vorm te downloaden als een back-up.

Hoe je jouw robots.txt-bestand kunt controleren

Fouten in het robots.txt-bestand kunnen ertoe leiden dat belangrijke pagina’s niet in de zoekindex verschijnen of zelfs de hele website onzichtbaar maken voor zoekmachines. Omgekeerd kunnen ongewenste pagina’s die privé zouden moeten zijn, plotseling geïndexeerd worden.

Je kunt jouw Robots.txt-bestand eenvoudig controleren met de gratis Robots.txt Tester van SE Ranking. Voer hierbij maximaal 100 URL’s in om deze te testen. Je controleert hiermee direct of ze gescand mogen worden.

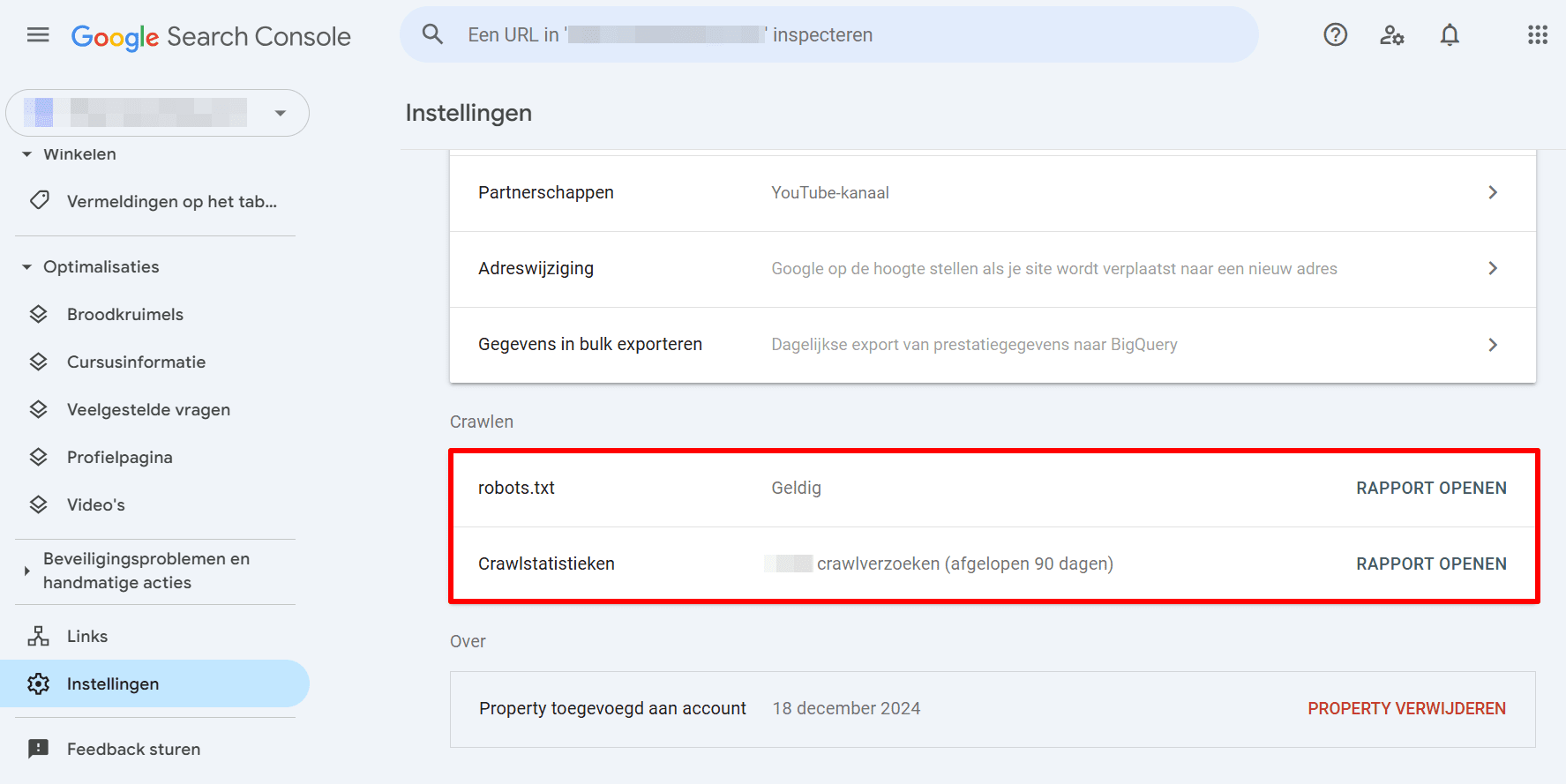

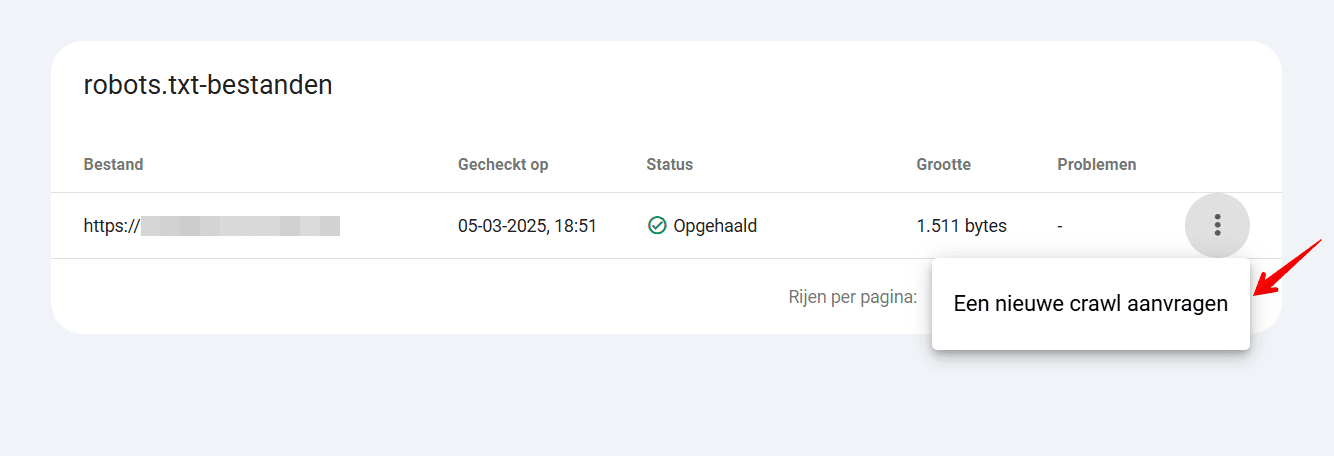

Je kunt ook een robots.txt-rapport openen in Google Search Console. Ga hiervoor naar Instellingen > Crawlen > robots.txt.

Als je een robots.txt-rapport opent, worden de robots.txt-bestanden weergegeven die Google heeft gevonden voor de top 20 hosts op je website. Je ziet wanneer deze voor het laatst gecontroleerd zijn, de fetch-status ervan en eventuele gevonden problemen. Je kunt dit rapport ook gebruiken om Google te vragen een robots.txt-bestand snel opnieuw te crawlen als de noodzaak daartoe dringend is, bijvoorbeeld na een belangrijke aanpassing.

Veelvoorkomende robots.txt-problemen

Terwijl je het robots.txt-bestand van je website doorontwikkelt, kunnen verschillende problemen invloed hebben op de manier waarop crawlers van zoekmachines met jouw website omgaan. Enkele veelvoorkomende problemen zijn:

- Mismatch in het format: webcrawlers kunnen het bestand niet detecteren en analyseren als het niet in .txt-formaat is gemaakt.

- Verkeerde plaatsing: je robots.txt-bestand moet zich in de root directory bevinden. Als het zich bijvoorbeeld in een submap bevindt, kunnen zoekrobots het mogelijk niet vinden en openen.

- Verkeer gebruik van “/” in de Disallow-instructie: een Disallow-instructie zonder inhoud impliceert dat bots toestemming hebben om alle pagina’s op je website te scannen. Een Disallow-instructie met “/” sluit je website juist volledig af voor bots. Het is belangrijk om je robots.txt-bestand te dubbelchecken om er zeker van te zijn dat de Disallow-instructies voorzien in je initiële bedoelingen.

- Lege regels in het robots.txt-bestand: zorg ervoor dat er geen lege regels tussen de verschillende instructies staan. Het zou ertoe kunnen leiden dat crawlers moeite hebben met het lezen van het bestand. Het enige geval waarin lege regels zijn toegestaan, is voordat een nieuwe user agent wordt aangegeven.

- Pagina blokkeren in robots.txt en een “noindex”-instructie toevoegen: dit zorgt voor conflicterende signalen. Crawlers van zoekmachines begrijpen de bedoeling mogelijk niet of negeren de “noindex”-instructie volledig. Het is het beste om robots.txt te gebruiken om crawlen te blokkeren of “noindex” om indexering te voorkomen, maar niet beide tegelijk.

Extra hulpmiddelen/rapporten om problemen te signaleren

Er zijn tal van manieren om je website te controleren op mogelijke problemen gerelateerd aan het robots.txt-bestand. Laten we de meest gebruikte tools bekijken.

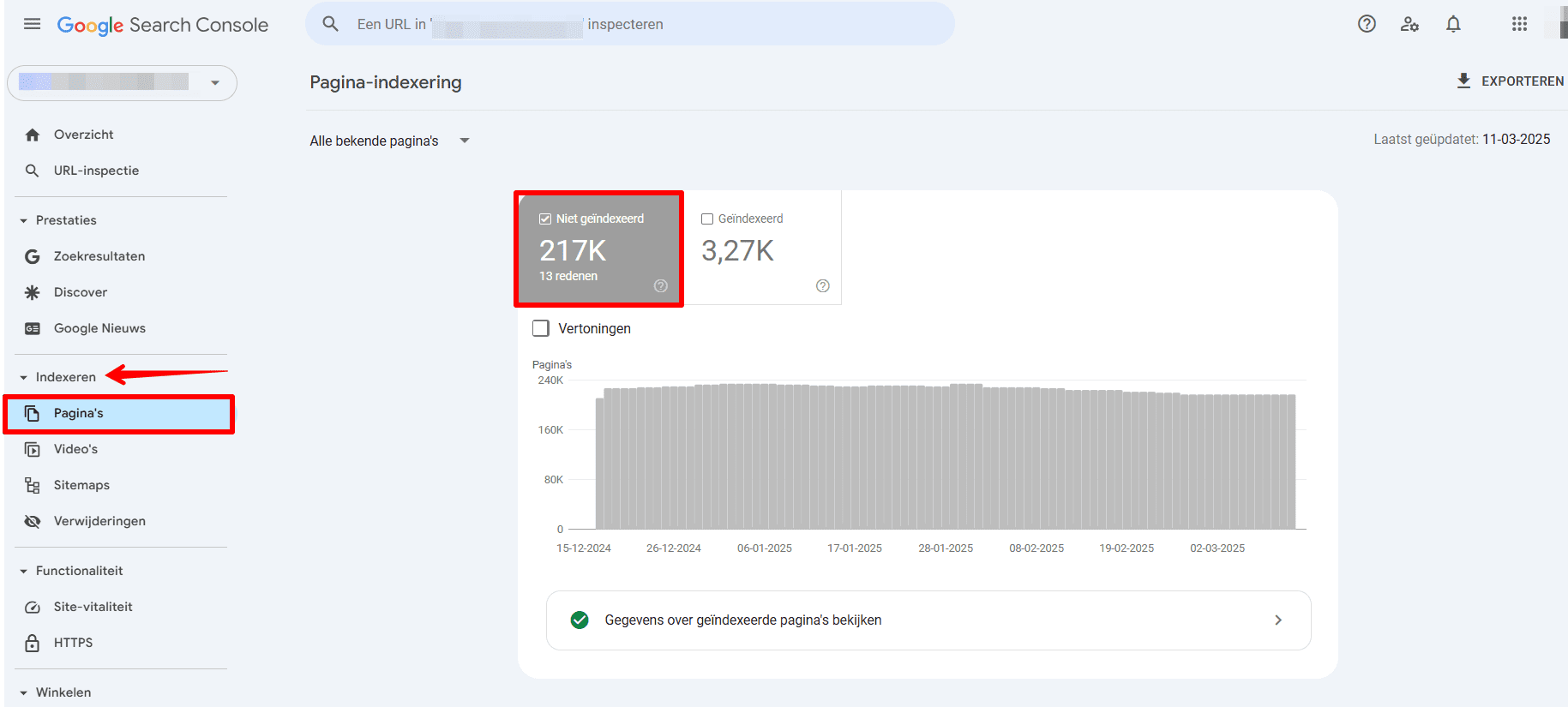

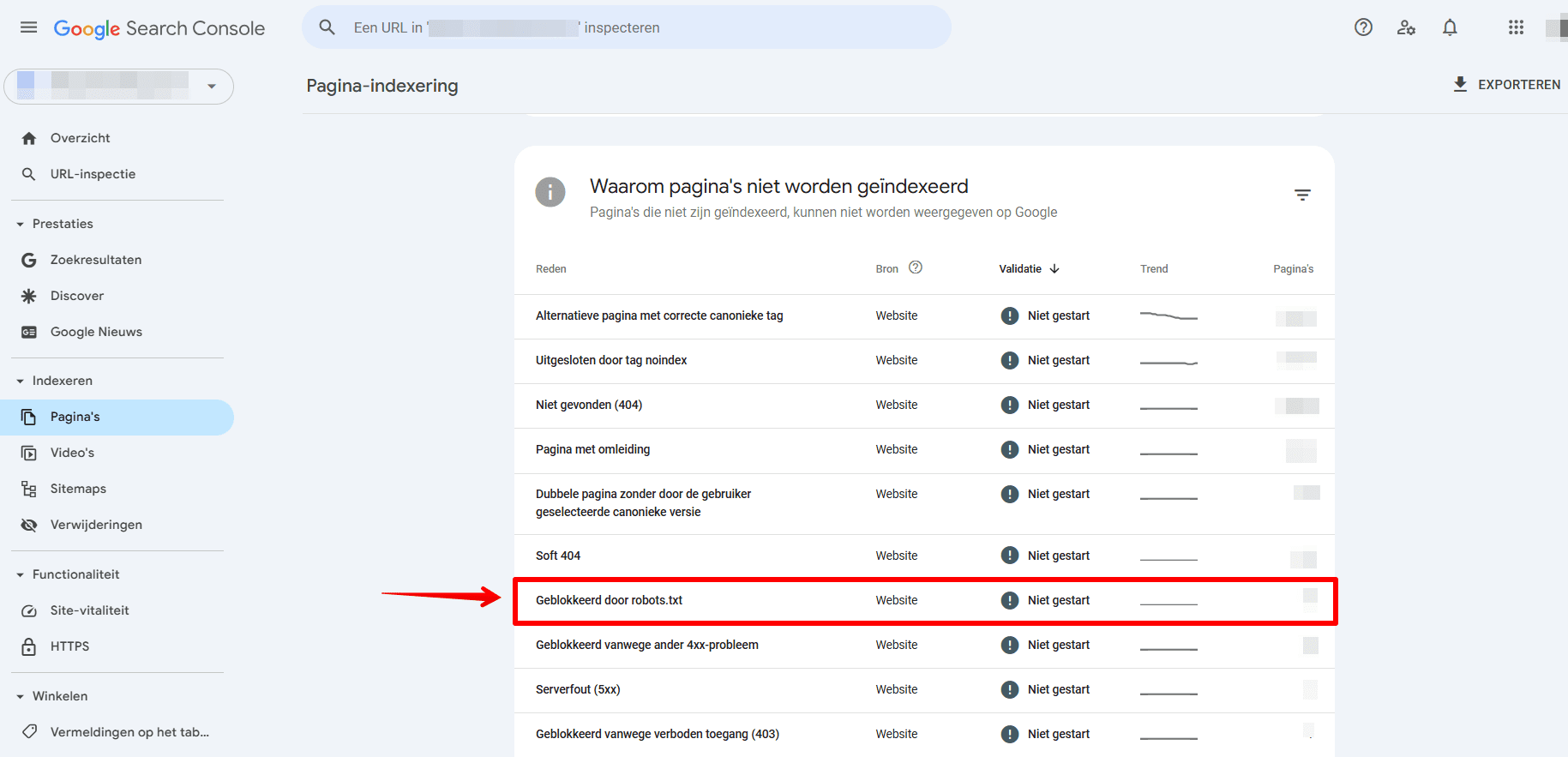

1. Google Search Console Pagina’s rapport.

Het gedeelte Pagina’s van GSC bevat waardevolle informatie over je robots.txt-bestand.

Volg deze stappen om te controleren of het robots.txt-bestand van je website Googlebot blokkeert bij het crawlen van een pagina:

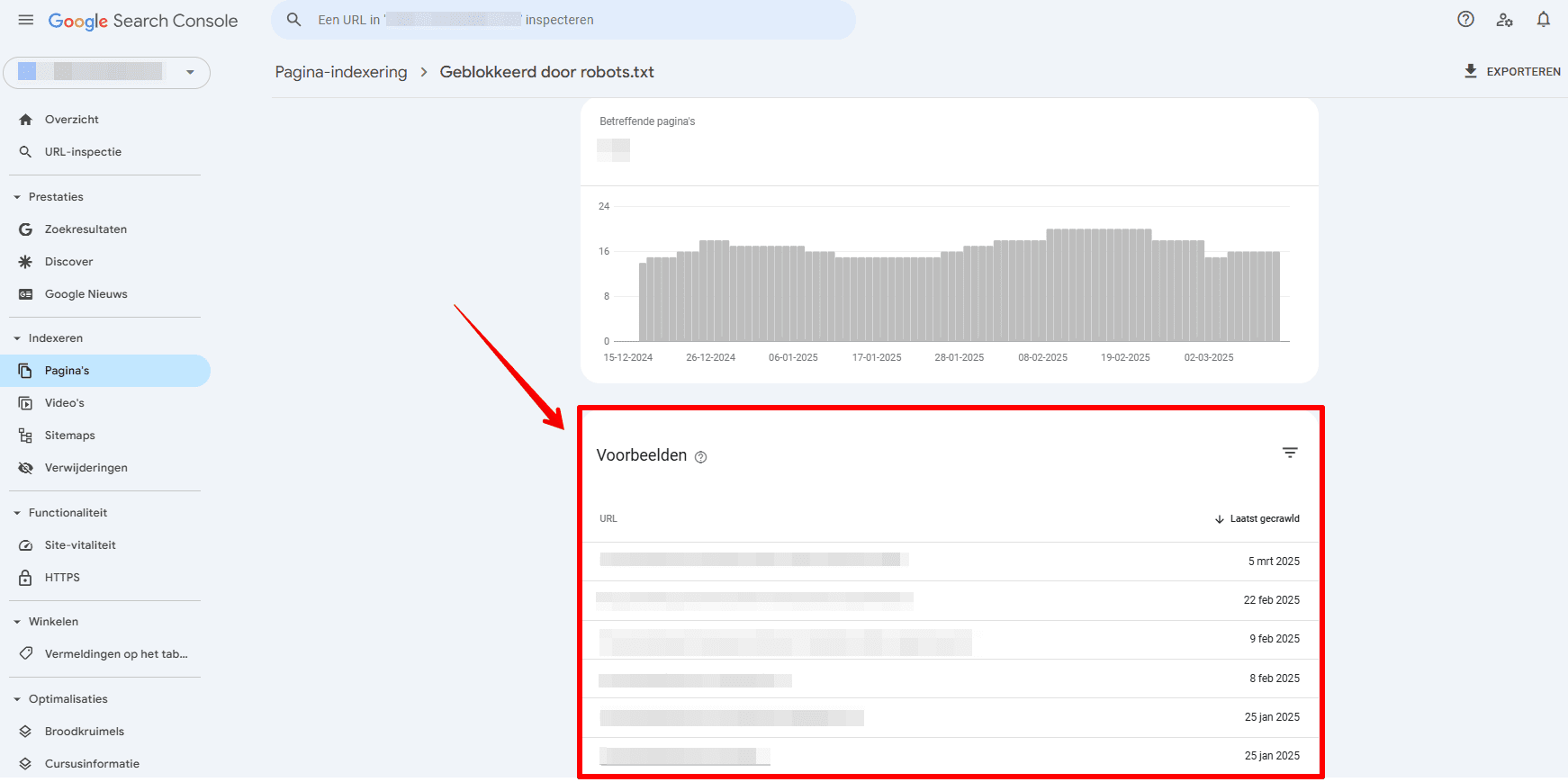

- Ga naar het gedeelte Pagina’s en navigeer naar de categorie Niet geïndexeerd.

- Zoek naar een fout met de tekst Geblokkeerd door robots.txt en selecteer deze.

- Als je op deze sectie klikt, zie je een lijst met pagina’s die momenteel geblokkeerd zijn door het robots.txt-bestand van je website. Controleer of dit de beoogde geblokkeerde pagina’s zijn.

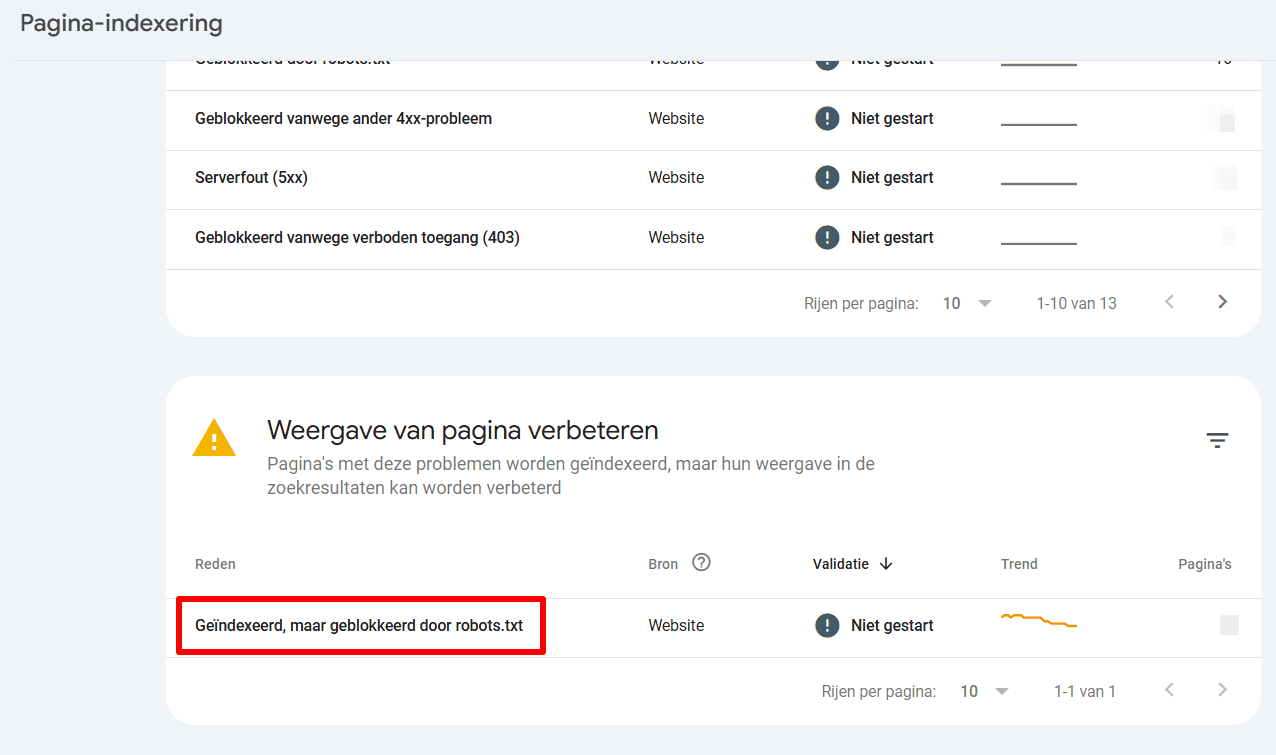

Controleer ook eens of het volgende probleem zich in deze sectie voordoet: Geïndexeerd, maar geblokkeerd door robots.txt.

Je kunt ook controleren of afzonderlijke URL’s zijn geïndexeerd door ze in het zoekvak in de URL Inspectietool van Google Search Console te plakken. Dit kan je helpen potentiële indexeringsproblemen te detecteren die worden veroorzaakt door conflicterende richtlijnen of verkeerd geconfigureerde robots.txt-regels.

Hier vind je een complete Google Search Console-gids over het detecteren en aanpakken van indexeringsproblemen.

2. SE Ranking’s Website Audit

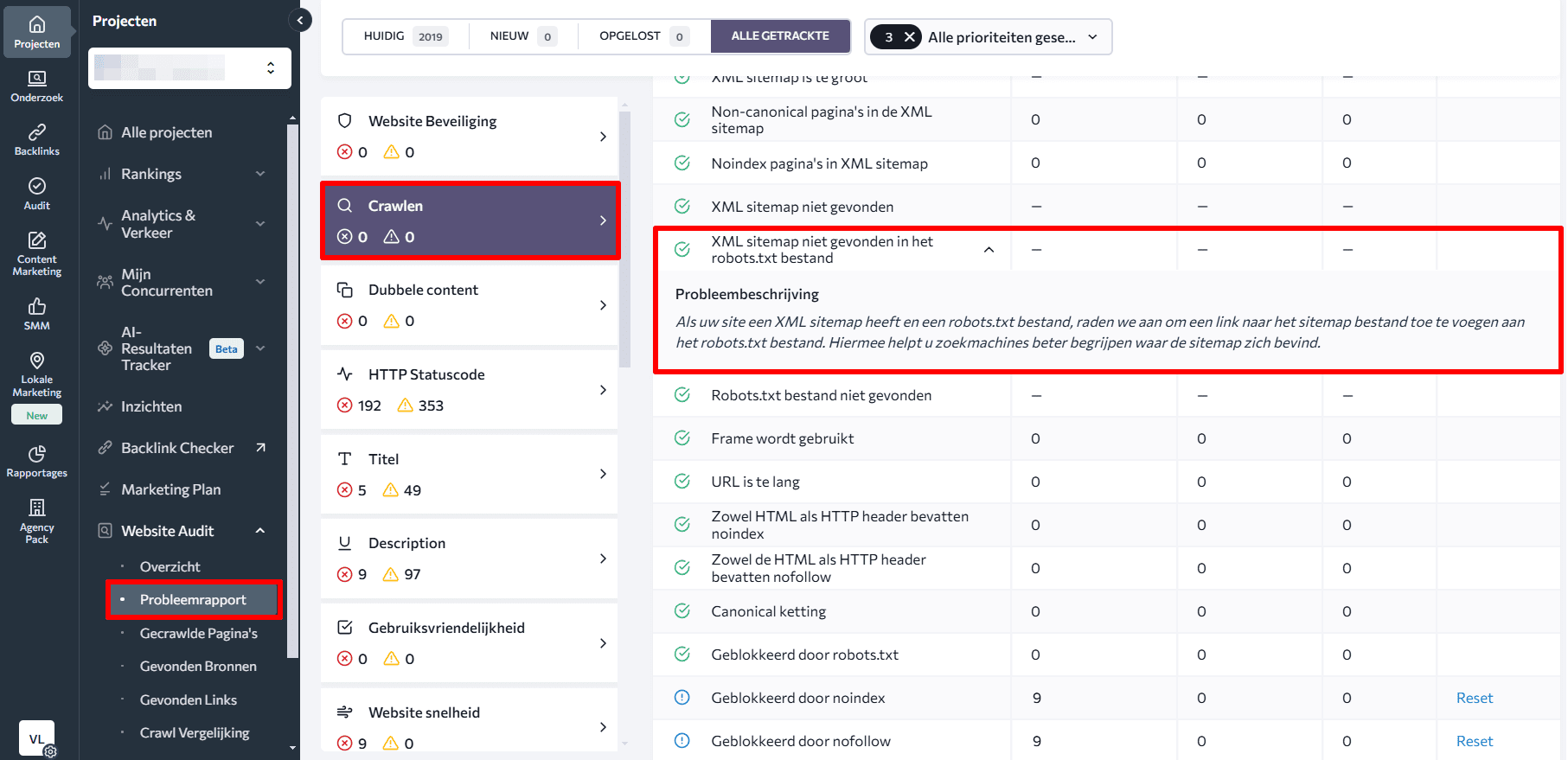

De Website Audit-tool van SE Ranking (en andere soortgelijke tools) bieden uitgebreide informatie over zowel je robots.txt-bestand, als over de pagina’s die door het bestand worden geblokkeerd. De tool kan je daarbij helpen bij het controleren van de indexering van pagina’s en XML-sitemap-gerelateerde problemen.

Om waardevolle inzichten te krijgen in je robots.txt-bestand, start je met het analyseren van het Issue Report dat door de tool is gegenereerd. Tussen de meer dan 120 beoordeelde statistieken vind je de parameter Blocked by robots.txt onder het gedeelte Crawling. Als je hierop klikt, wordt een lijst weergegeven met webpagina’s waarvoor het crawlen geblokkeerd is, samen met probleembeschrijvingen en snelle oplossingen.

Met deze tool stel je daarbij eenvoudig vast of je een link naar de sitemap in het robots.txt-bestand hebt toegevoegd. Controleer daarvoor de status XML-sitemap not found in robots.txt file onder dezelfde sectie.

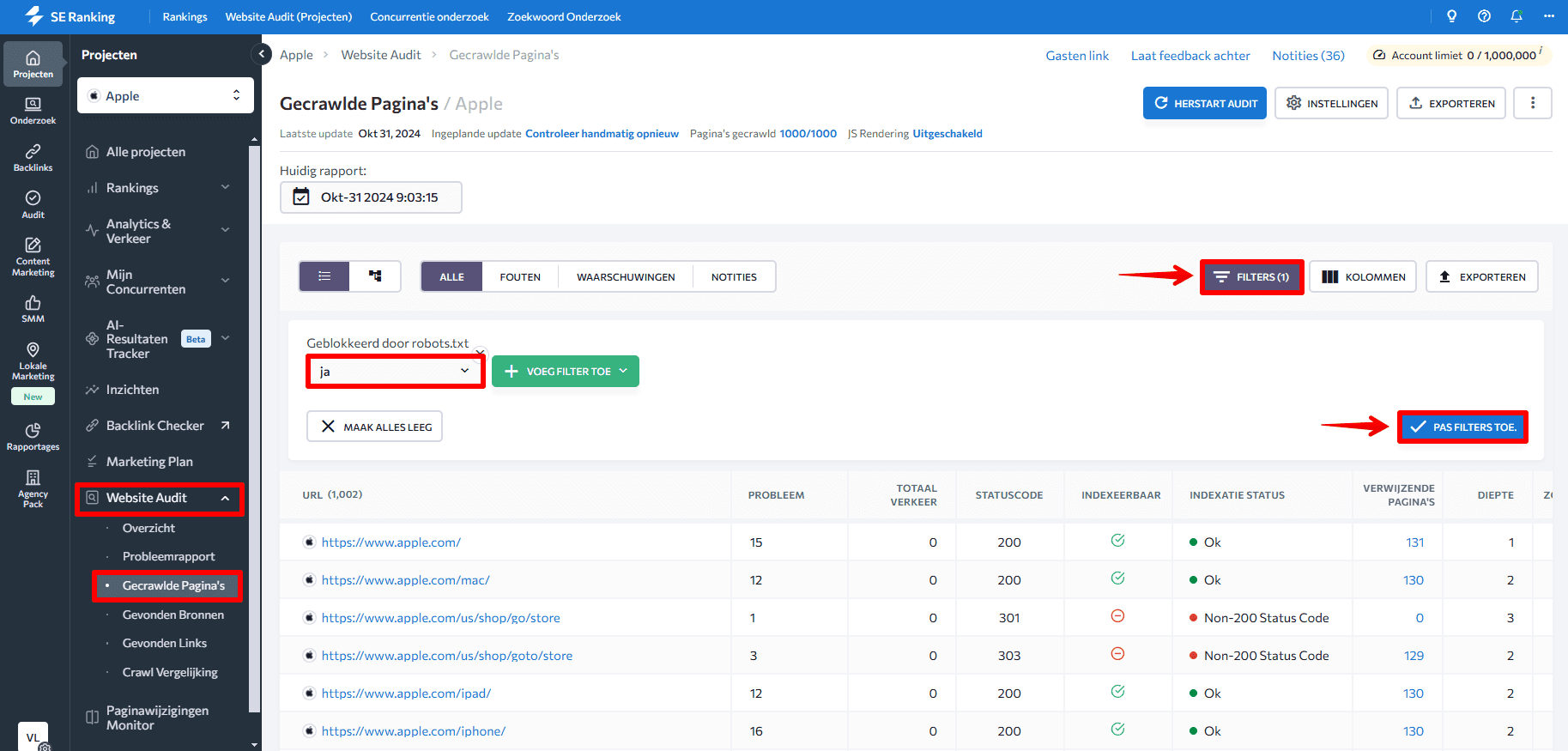

Wanneer je naar het tabblad Crawled Pages in het linker menu navigeert, kun je de technische parameters van elke pagina afzonderlijk analyseren. Pas filters toe om je te concentreren op het oplossen van kritieke problemen op de belangrijkste pagina’s. Als je bijvoorbeeld het filter Blocked by robots.txt > Yes toepast, worden alle pagina’s weergegeven die door het bestand zijn geblokkeerd.

SEO best practices

Om ervoor te zorgen dat crawlers de inhoud van je website kunnen indexeren en deze goed presteert, volg je deze SEO-best practices:

- Zorg voor het juiste gebruik van hoofd- en kleine letters in robots.txt: crawlers interpreteren map- en sectienamen op basis van hoofd- en kleine letters, zorg daarom voor het juiste gebruik daarvan.

- Begin elke instructie op een nieuwe regel, met met slechts één parameter per regel.

- Vermijd het gebruik van spaties, aanhalingstekens of puntkomma’s bij het uitwerken van instructies.

- Gebruik de Disallow-instructie om alle bestanden in een specifieke map of directory te blokkeren voor crawlen. Deze techniek is efficiënter dan elk bestand apart te vermelden.

- Gebruik wildcard tekens voor flexibelere instructies bij het creëren van het robots.txt-bestand. De asterisk (*) geeft elke variatie in waarde aan, terwijl het dollarteken ($) fungeert als een beperking en het einde van het URL-pad aangeeft.

- Maak een apart robots.txt-bestand voor elk domein. Dit stelt de crawl richtlijnen voor elke website afzonderlijk vast.

- Test een robots.txt-bestand altijd om er zeker van te zijn dat belangrijke URL’s er niet door worden geblokkeerd.

Conclusies

We hebben alle belangrijke aspecten van het robots.txt-bestand behandeld, van de syntaxis tot best practices en veelvoorkomende problemen. Nu weet je waarom een goed geconfigureerd robots.txt-bestand cruciaal is voor effectieve SEO en een correct beheer van je website. Het optimaliseert crawl budgetten, leidt zoekmachines naar de belangrijkste content en beschermt gevoelige data.

Vergeet niet om je robots.txt-bestand regelmatig te controleren en bij te werken naarmate je de website doorontwikkelt. Gebruik de tools en technieken die we hebben besproken om ervoor te zorgen dat je bestand werkt zoals bedoeld.