Alle URLs einer Website auslesen: Der SEO-Leitfaden

Weißt du wirklich, wie viele Seiten deine Website hat?

Viele Websites bestehen nicht aus ein paar Dutzend Seiten, sondern aus Hunderten oder Tausenden URLs – und längst nicht alle davon sind gewollt oder SEO-relevant.

Genau hier entstehen oft unsichtbare Probleme: indexierte Testseiten, veraltete URLs, Weiterleitungsketten, Paginierung mit doppelten Seiten oder Content, den niemand mehr auf dem Schirm hat.

In diesem Artikel erfährst du, wie du alle URLs deiner Website ausliest, welche Tools dir dabei helfen und wie du diese Daten nutzt, um SEO-Potenziale aufzudecken.

-

SE Ranking Website-Audit

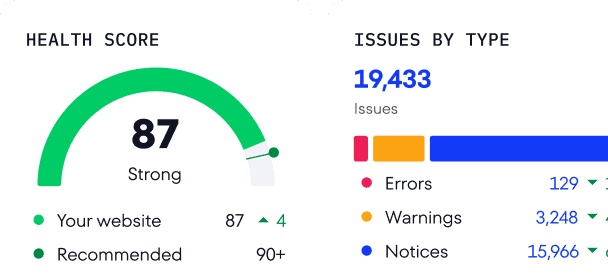

Das Website-Audit-Tool crawlt deine gesamte Website und erfasst alle URLs, die für Suchmaschinen erreichbar sind. Du kannst den Crawl gezielt auf bestimmte Bereiche beschränken und erhältst einen strukturierten Überblick über technische Fehler, URL-Strukturen, Weiterleitungen und den Indexierungsstatus einzelner Seiten.

-

Google Search Console

Die Google Search Console zeigt dir alle Seiten, die Google indexiert hat – inklusive URLs, die aufgrund von Fehlern oder Richtlinien nicht im Index gelandet sind. Die Daten lassen sich exportieren und eignen sich, um Indexierungsprobleme zu analysieren und die Sichtbarkeit zu verbessern.

-

Google Analytics

Google Analytics erfasst alle Seiten, die tatsächlich von Nutzern besucht wurden. Dadurch erhältst du Einblicke in URLs, die zwar Traffic generieren, im SEO-Alltag aber oft übersehen werden.

-

Bing Webmaster Tools

Die Bing Webmaster Tools zeigen dir, welche Seiten deiner Website von Bing indexiert wurden. Sie ergänzen die Google Search Console sinnvoll und helfen dabei, die Indexierung auch für andere Suchmaschinen zu optimieren.

-

Kommandozeile (z. B. Wget)

Mit Tools wie Wget kannst du alle URLs einer Website finden, herunterladen und auflisten, einschließlich solcher, die tief in der Seitenstruktur liegen.

-

Sitemap (sitemap.xml)

Über die Datei sitemap.xml kannst du alle URLs finden, die der Websitebetreiber zur Indexierung freigegeben hat.

-

WordPress-Plugins

Plugins wie List all URLs und Export All URLs ermöglichen es WordPress-Nutzern, alle Seiten schnell zu exportieren.

Warum alle URLs einer Website auslesen?

Suchmaschinen aktualisieren ihre Algorithmen regelmäßig und greifen bei Problemen auch manuell ein – oft auf Ebene einzelner URLs. Wenn du nicht genau weißt, welche Seiten zu deiner Website gehören, gehst du ein unnötiges SEO-Risiko ein.

Ein vollständiger Überblick über alle URLs deiner Website hilft dir dabei, die Seitenstruktur besser zu verstehen, technische Probleme zu erkennen und Optimierungspotenziale aufzudecken.

So kannst du unter anderem prüfen, ob die Breadcrumb-Navigation die Hierarchie deiner Seiten korrekt widerspiegelt.

Besonders wichtig ist es, alle URLs deiner Website zu kennen, wenn du:

Strukturelle Änderungen planst

- die Website-Struktur anpassen willst

- die Domain wechselst oder URLs neu aufsetzt

Technische SEO-Probleme analysierst

- verwaiste Seiten identifizieren möchtest

- doppelte Seiten oder Duplicate Content findest (oft verursacht durch URL-Parameter wie Filter- oder Tracking-Parameter)

- 404-Fehler aufspürst

- Weiterleitungen korrekt einrichtest

Indexierung und Steuerung prüfst

- Canonical- und Noindex-Tags kontrollierst

- hreflang-Tags erstellst oder überprüfst

- eine XML-Sitemap oder robots.txt pflegst

SEO-Potenziale ausschöpfen willst

- die interne Verlinkung gezielt aufbaust

- vernachlässigte, aber relevante Seiten identifizierst

💡 Tipp: Mit dem robots.txt Generator kannst du schnell eine saubere Datei erstellen, und der robots.txt Tester zeigt dir, ob Crawler alle wichtigen Seiten wie geplant erreichen.

Wie du alle URLs einer Website finden kannst

Um alle Seiten zu identifizieren, die zu einer Website gehören, stehen dir verschiedene Methoden und Tools zur Verfügung:

- Website-Audit von SE Ranking, um alle crawlbaren Seiten zu erfassen

- Google Search Console, um Seiten zu finden, die Google indexiert hat oder indexieren wollte

- Google Analytics, um alle Seiten zu erkennen, die tatsächlich besucht wurden

- Bing Webmaster Tools, um URLs zu entdecken, die von Bing erfasst wurden

- Kommandozeilen-Tools, um alle Seiten einer Website herunterzuladen und aufzulisten

- Sitemap.xml, um URLs zu sehen, die aktiv zur Indexierung freigegeben wurden

- WordPress oder andere Plugins, um alle Links einer Website anzeigen oder exportieren zu lassen

Im nächsten Schritt schauen wir uns an, wie du diese Tools kombinierst, um eine Website vollständig zu scannen und keine relevante URL zu übersehen.

Website-Audit von SE Ranking

Beginne damit, alle URLs zu erfassen, die für Nutzer und Suchmaschinen über interne Links erreichbar sind. Diese crawlbaren Seiten bilden die Grundlage jeder SEO-Analyse, da sie aktiv verlinkt sind und den größten Einfluss auf die Website-Performance haben.

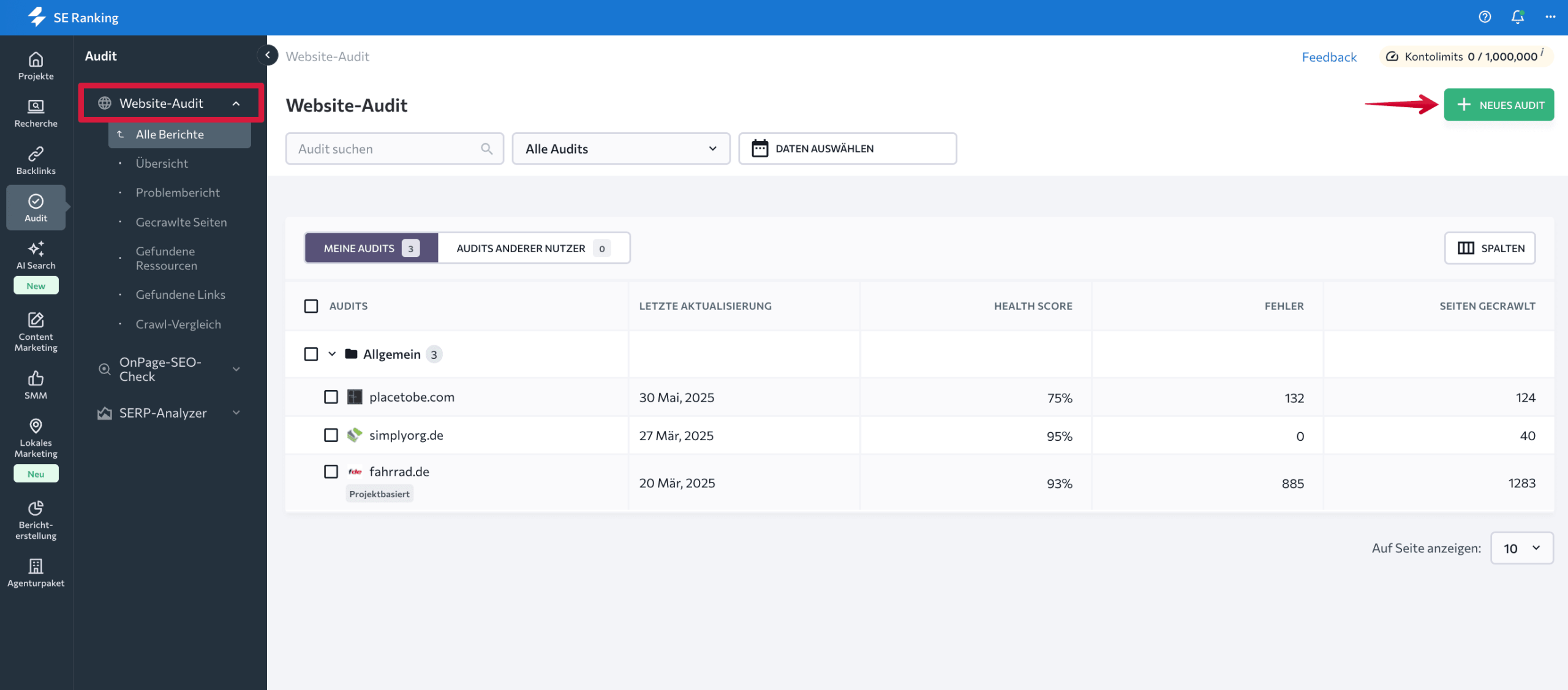

Öffne dazu SE Ranking, rufe das Website-Audit und starte ein neues Audit.

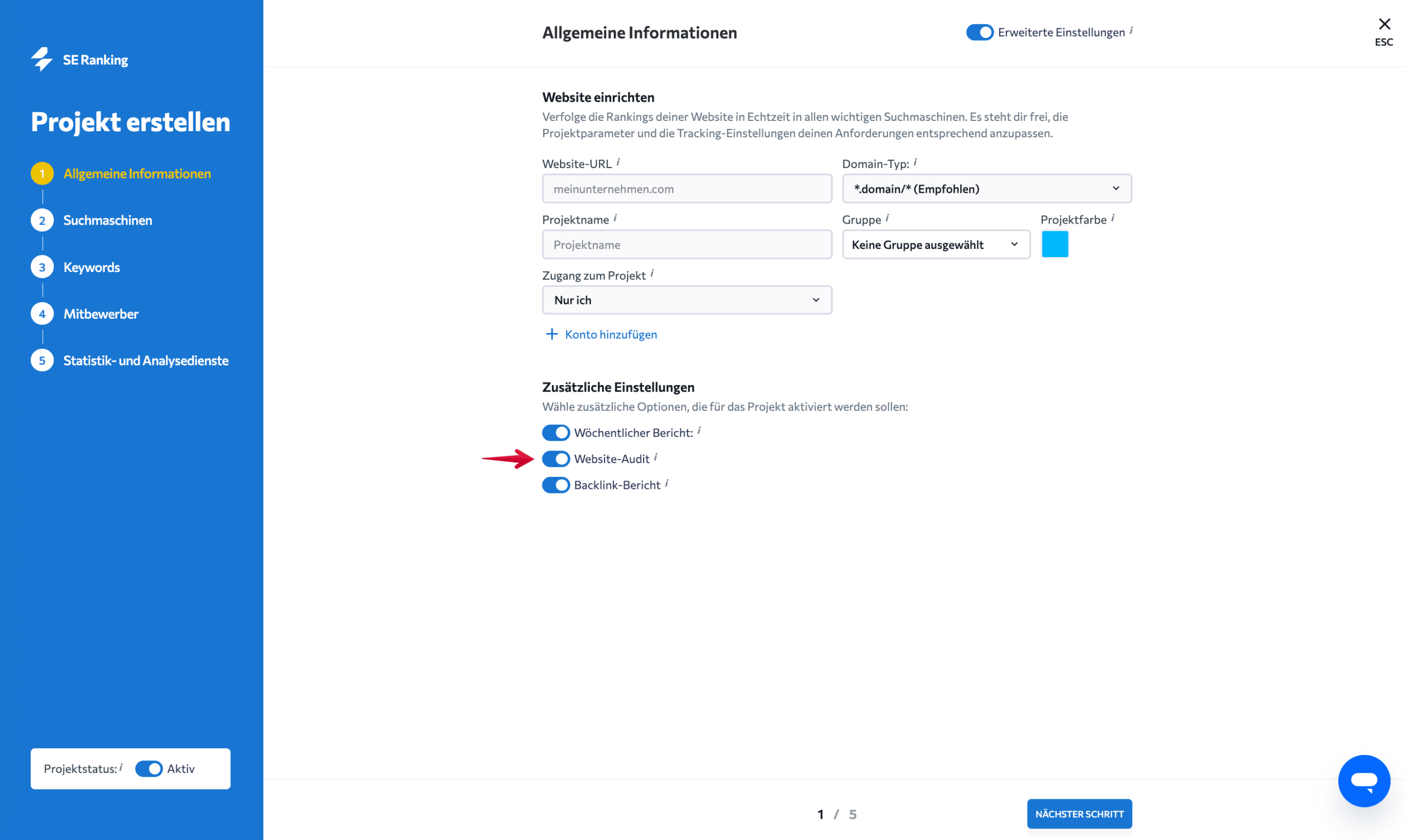

Alternativ kannst du in den erweiterten Einstellungen beim Anlegen des Projekts automatische Website-Audits festlegen.

Hinweis: Die 14-tägige Testphase gewährt dir Zugriff auf alle Funktionen von SE Ranking, einschließlich des Website-Audits.

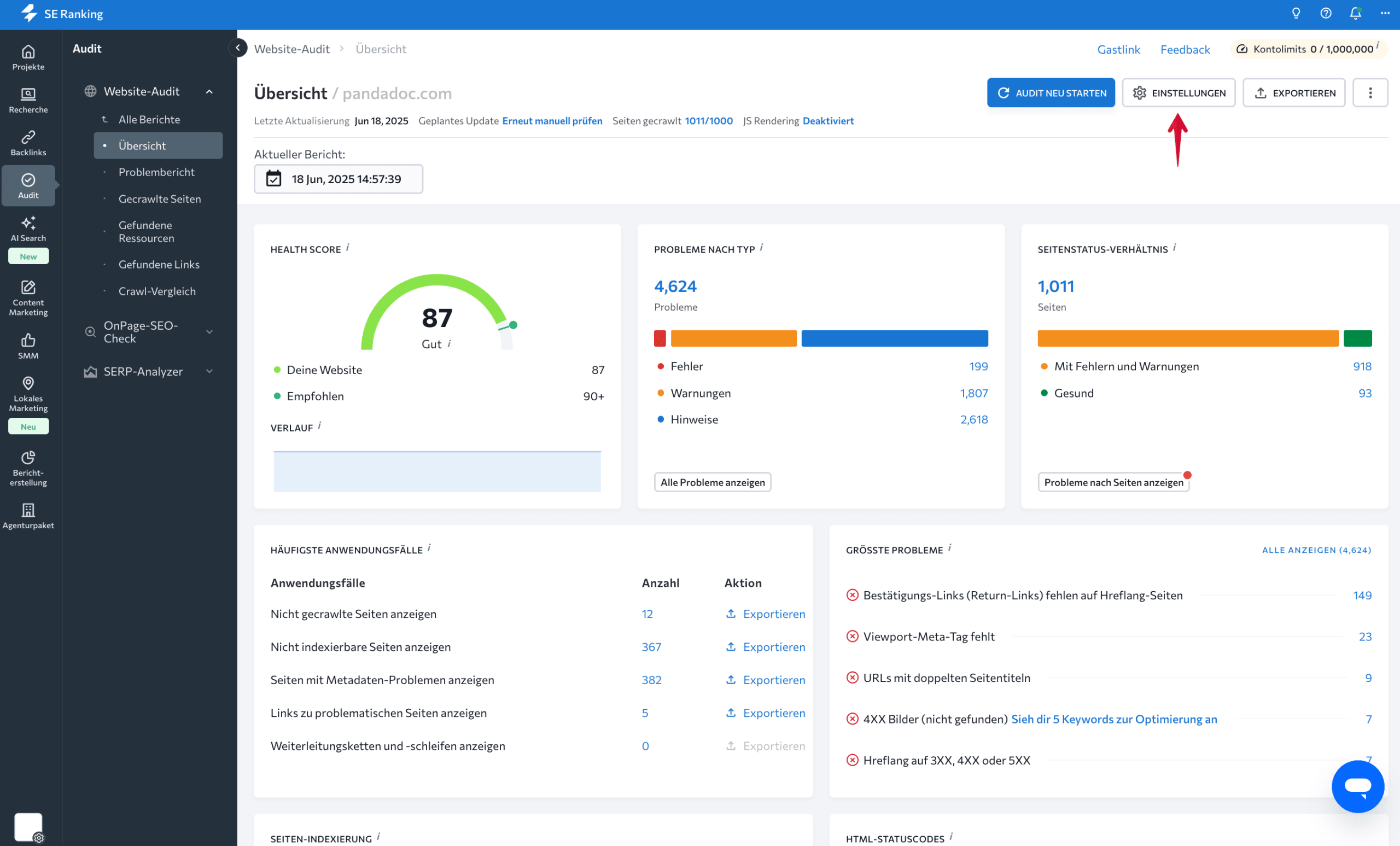

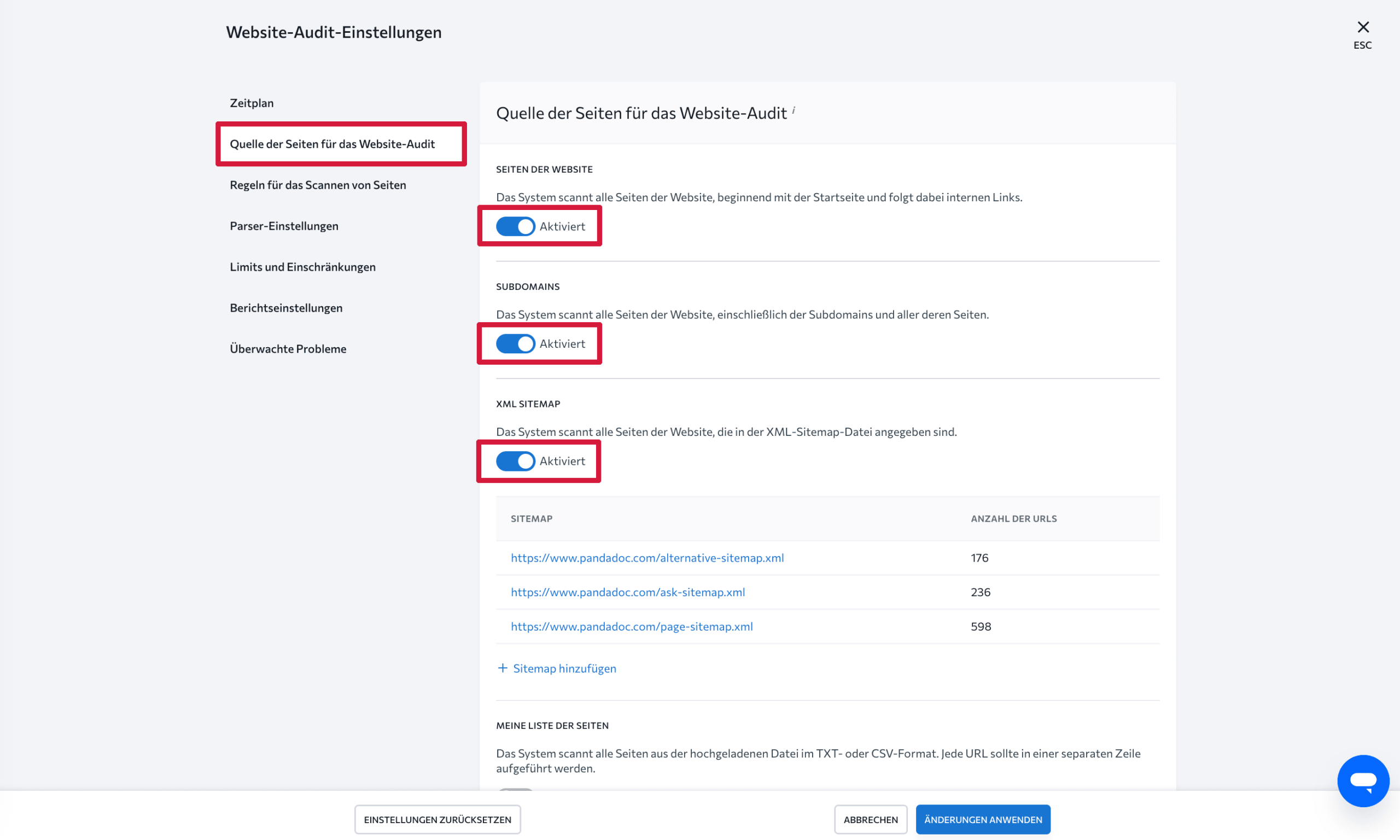

Damit der Crawler nur relevante Seiten erfasst, öffne die Audit-Einstellungen über das Zahnrad-Symbol und nimm folgende Anpassungen vor:

- Aktiviere als Quelle der Seiten für das Website-Audit:

- Seiten der Website

- Subdomains

- XML Sitemap

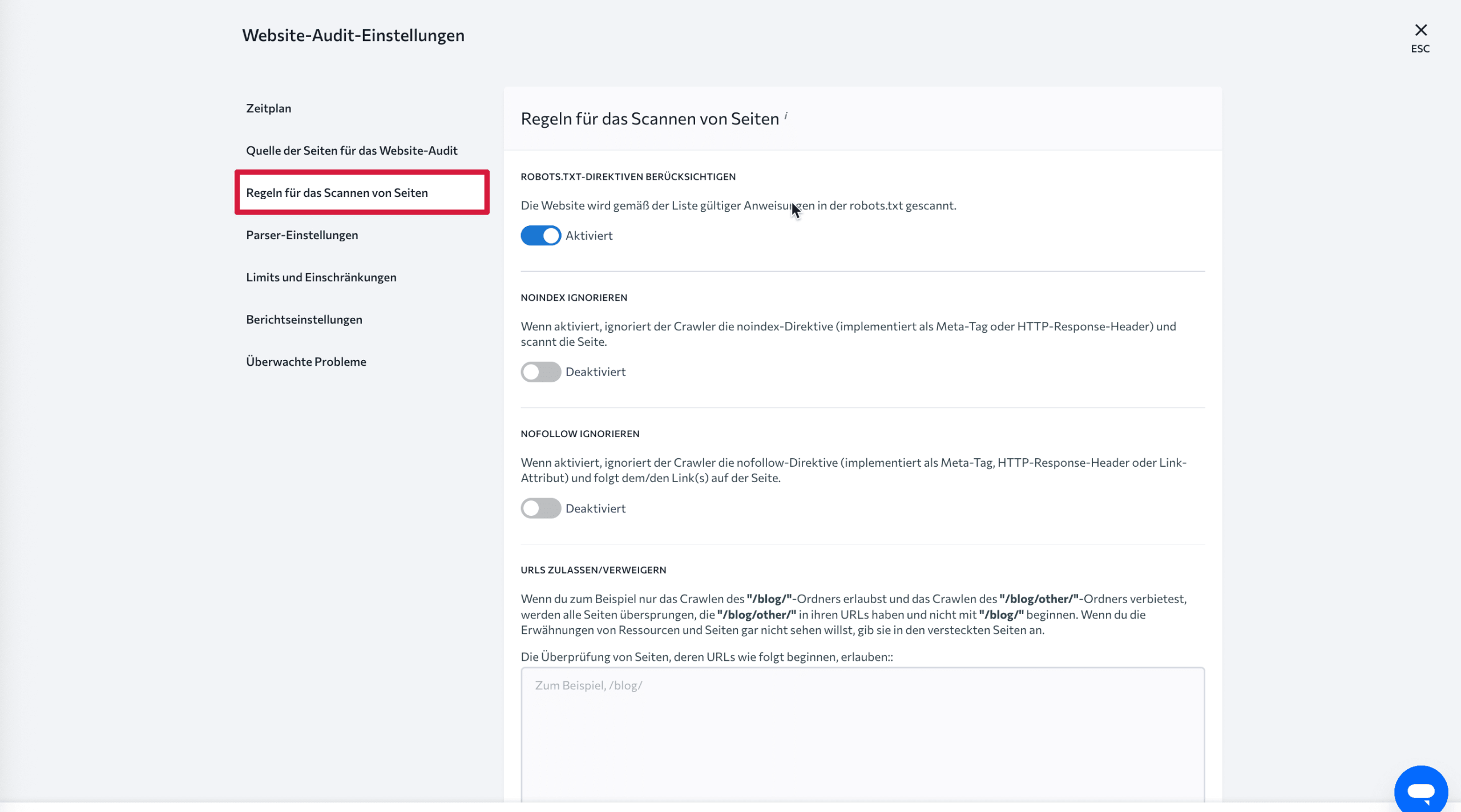

- Aktiviere unter den Regeln für das Scannen von Seiten die Option robots.txt-Direktiven berücksichtigen, damit der Crawler die Vorgaben deiner Website korrekt einhält. Klicke danach auf „Änderungen anwenden“.

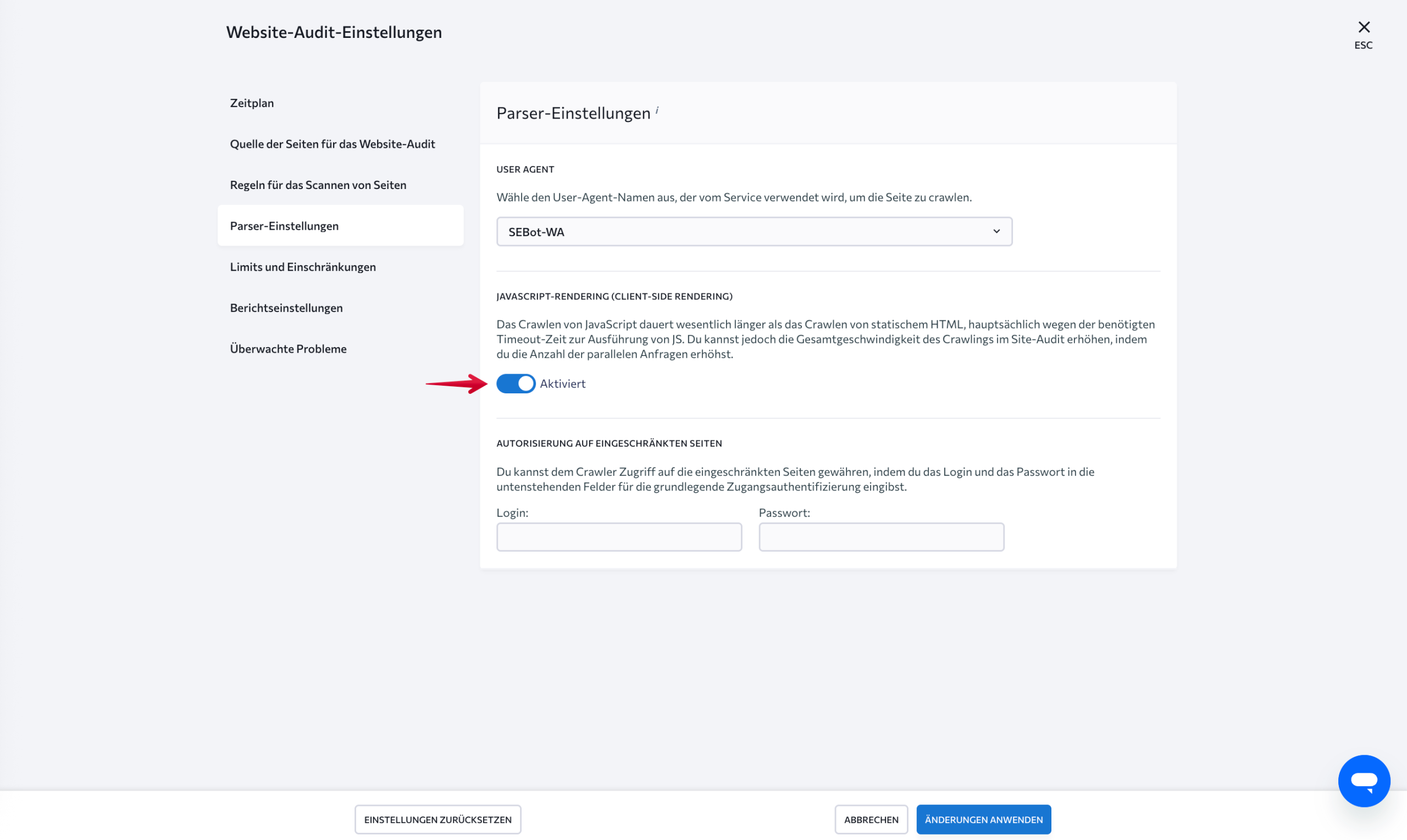

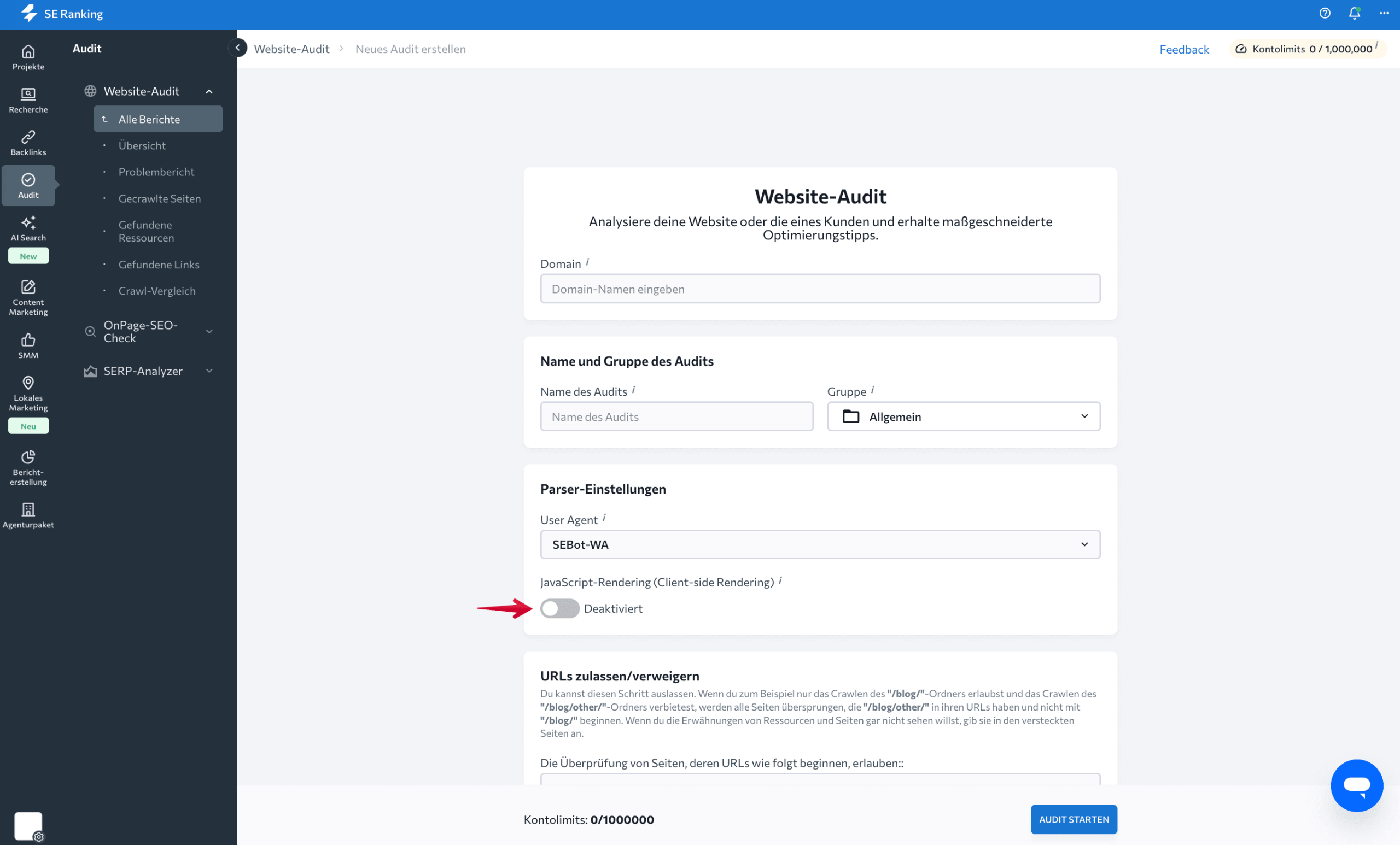

- Nutzt deine Website JavaScript, aktiviere zusätzlich JavaScript-Rendering, damit auch dynamisch geladene Inhalte erfasst werden.

Diese Einstellungen lassen sich auch direkt beim Start eines neuen Audits im Website-Audit-Assistenten festlegen.

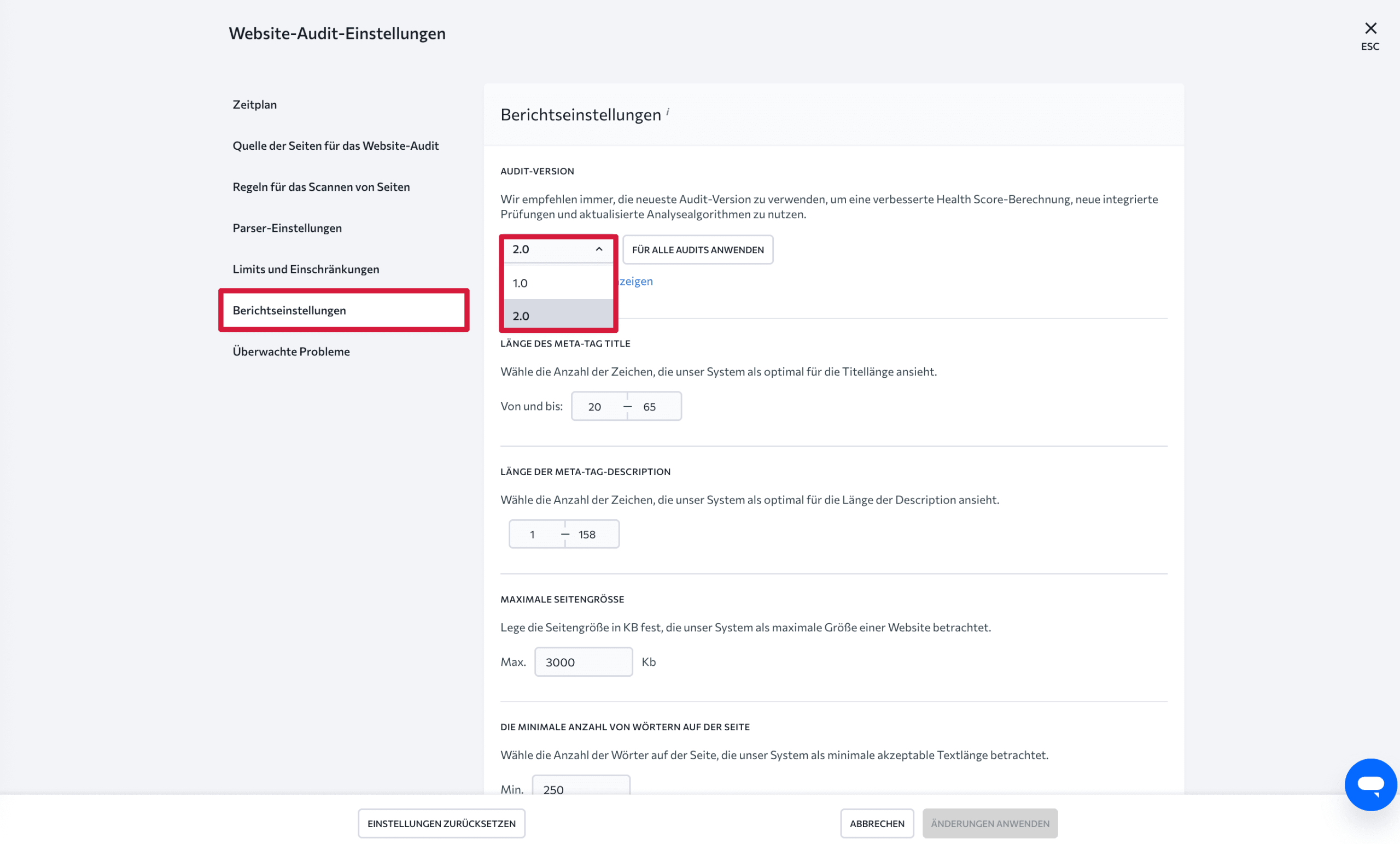

Hinweis: SE Ranking bietet das Website-Audit 2.0 mit verbesserter Fehlergewichtung, neuen Prüfungen und intelligenterer Priorisierung von Problemen. Du kannst in den Berichtseinstellungen auf die neue Version umstellen.

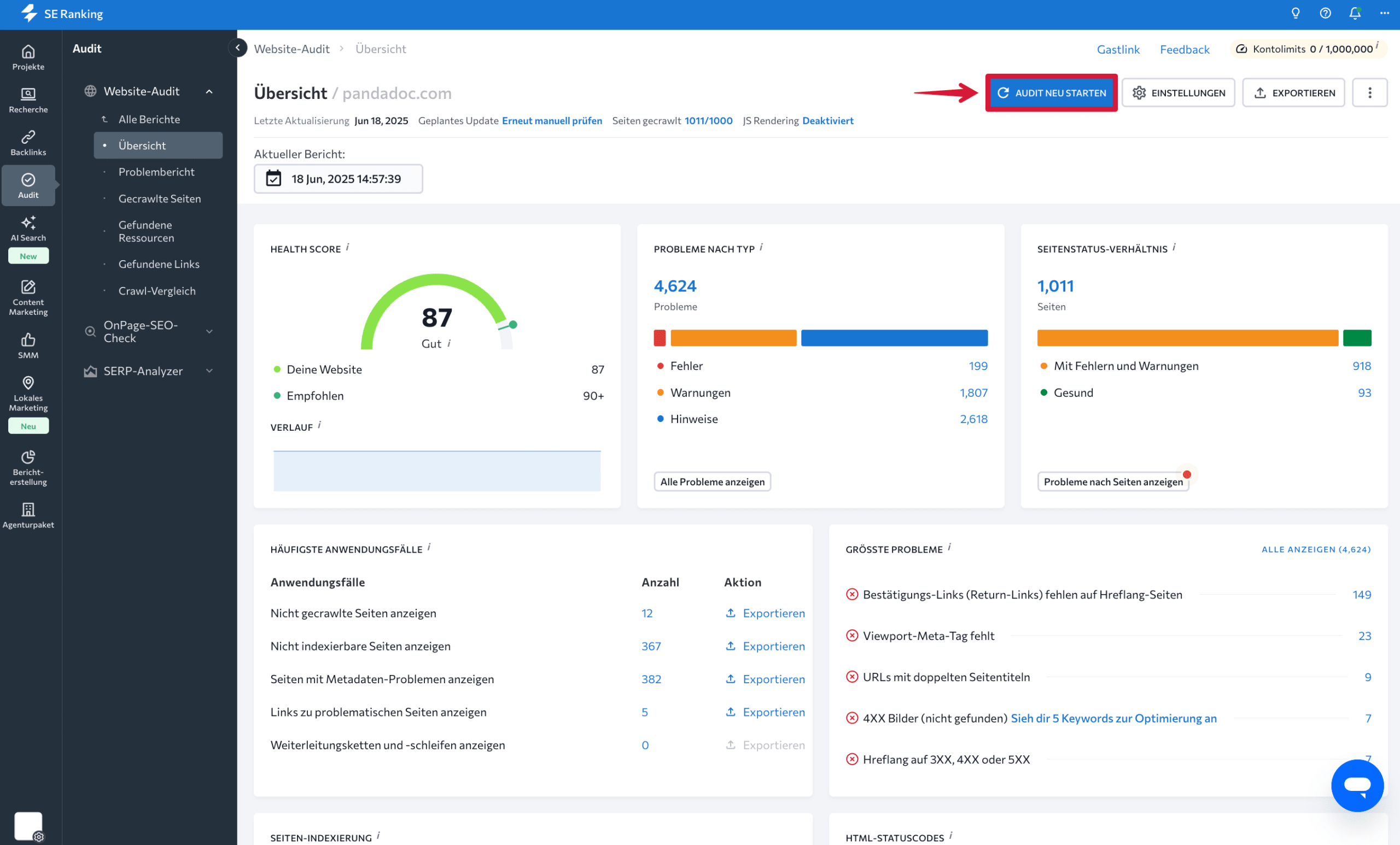

Wechsle jetzt zurück zum Tab „Übersicht“ und starte das Audit mit den neuen Einstellungen durch Klick auf „Audit neu starten“.

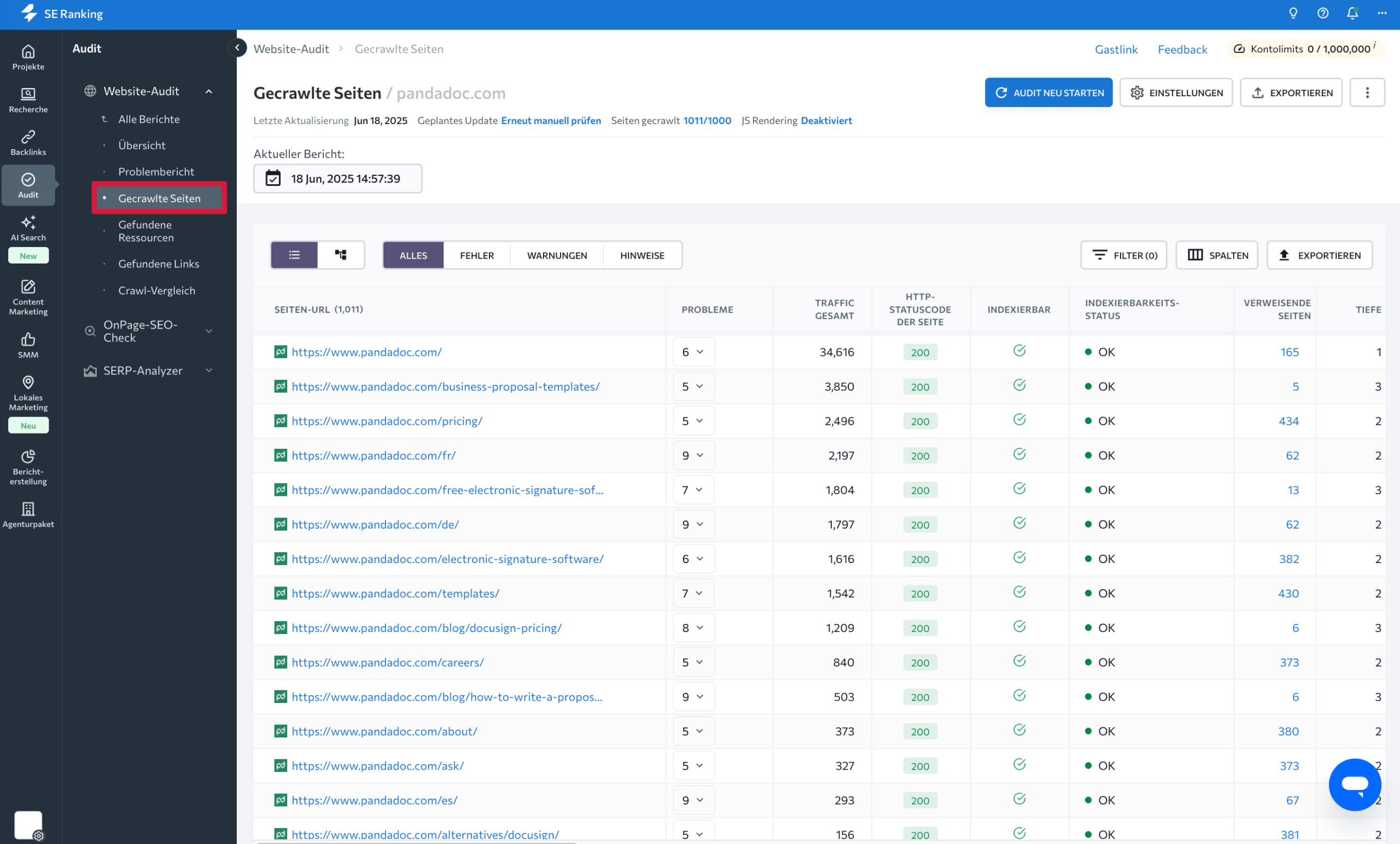

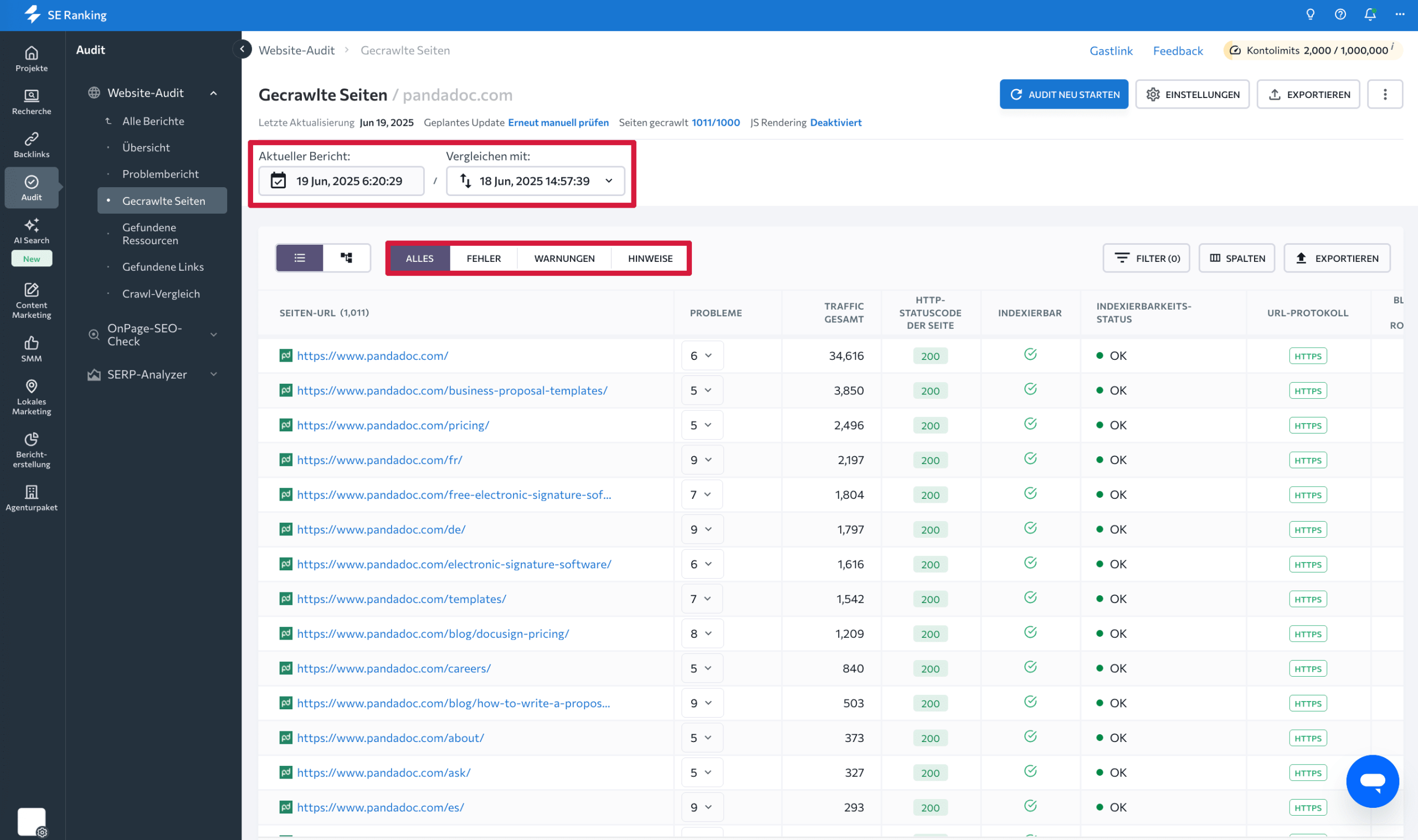

Nach Abschluss findest du im Bereich „Gecrawlte Seiten“ die vollständige Liste aller crawlbaren URLs.

Zu jeder URL stellt dir SE Ranking wichtige SEO-Kennzahlen bereit, darunter:

- Anzahl verweisender interner Seiten

- Technische Fehler und Warnungen

- Traffic- und Keyword-Daten

- Indexierbarkeitsstatus

- Anzahl der Zeichen in der URL der Seite

- Protokolltyp und -version der URL

- Ob die Seite in der Sitemap enthalten ist

- Serverantwortcodes

- Sitemap-Status und robots.txt-Blockierungen

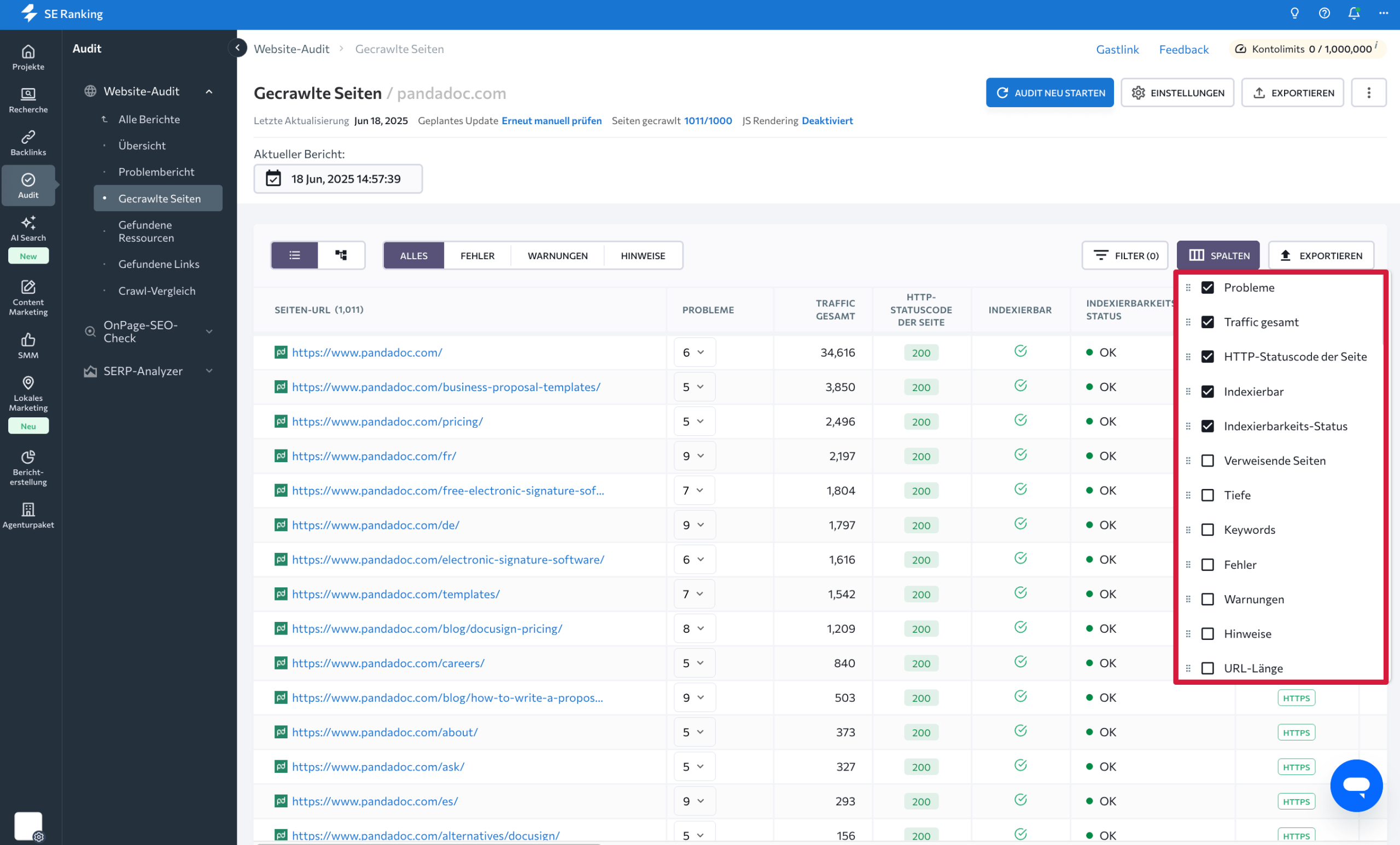

Diese Spalten kannst du flexibel anpassen, um genau die Metriken anzuzeigen, die für deine Analyse relevant sind.

Die gecrawlten Seiten lassen sich nach Fehlern, Warnungen und Hinweisen sortieren. So kannst du bei der Fehlerbehebung gezielt priorisieren. Nach mehreren Audits kannst du Berichte vergleichen und Veränderungen im Zeitverlauf analysieren.

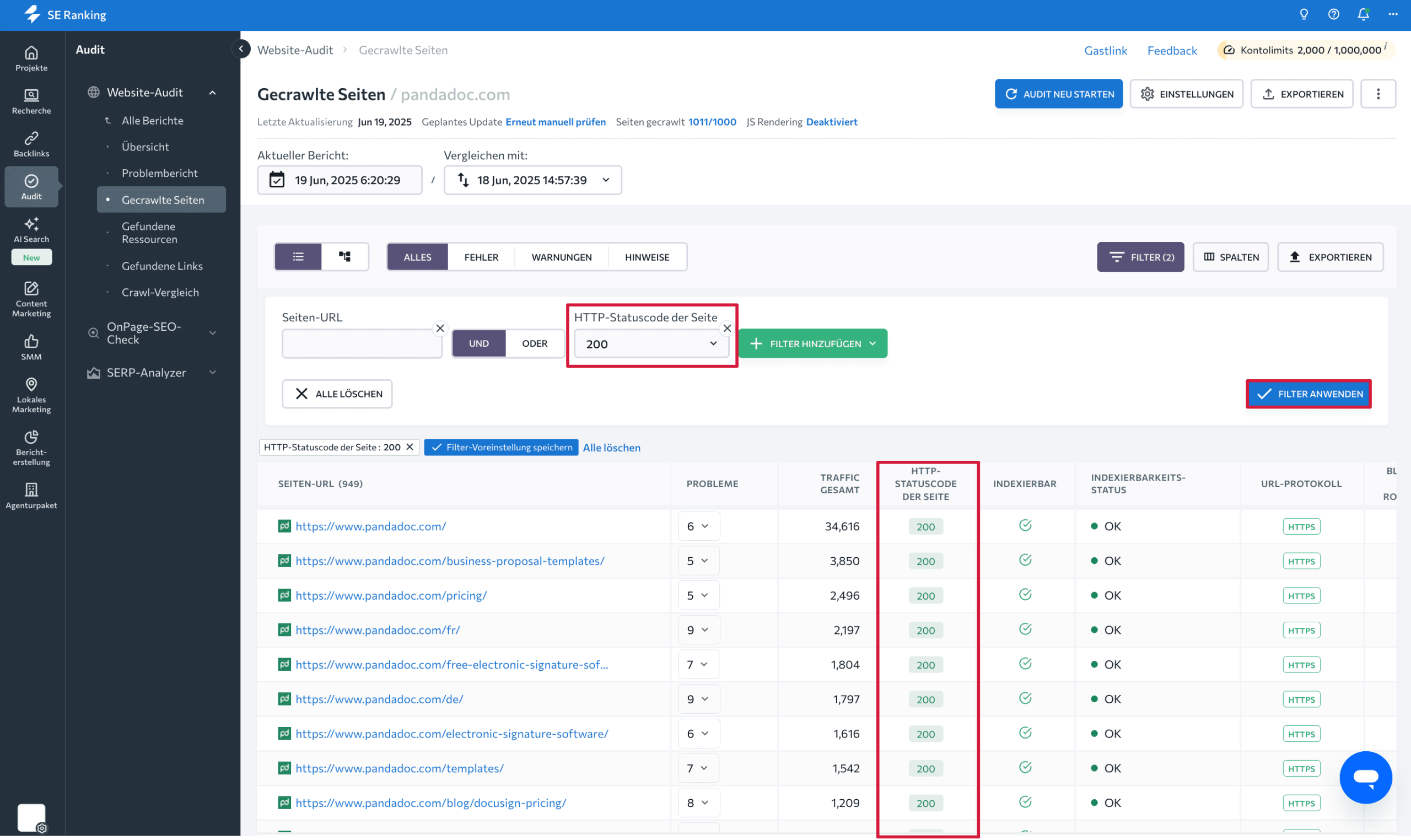

Über Filter kannst du die Liste zusätzlich eingrenzen, etwa auf Seiten mit Statuscode 200 oder auf URLs mit bestimmten technischen Eigenschaften.

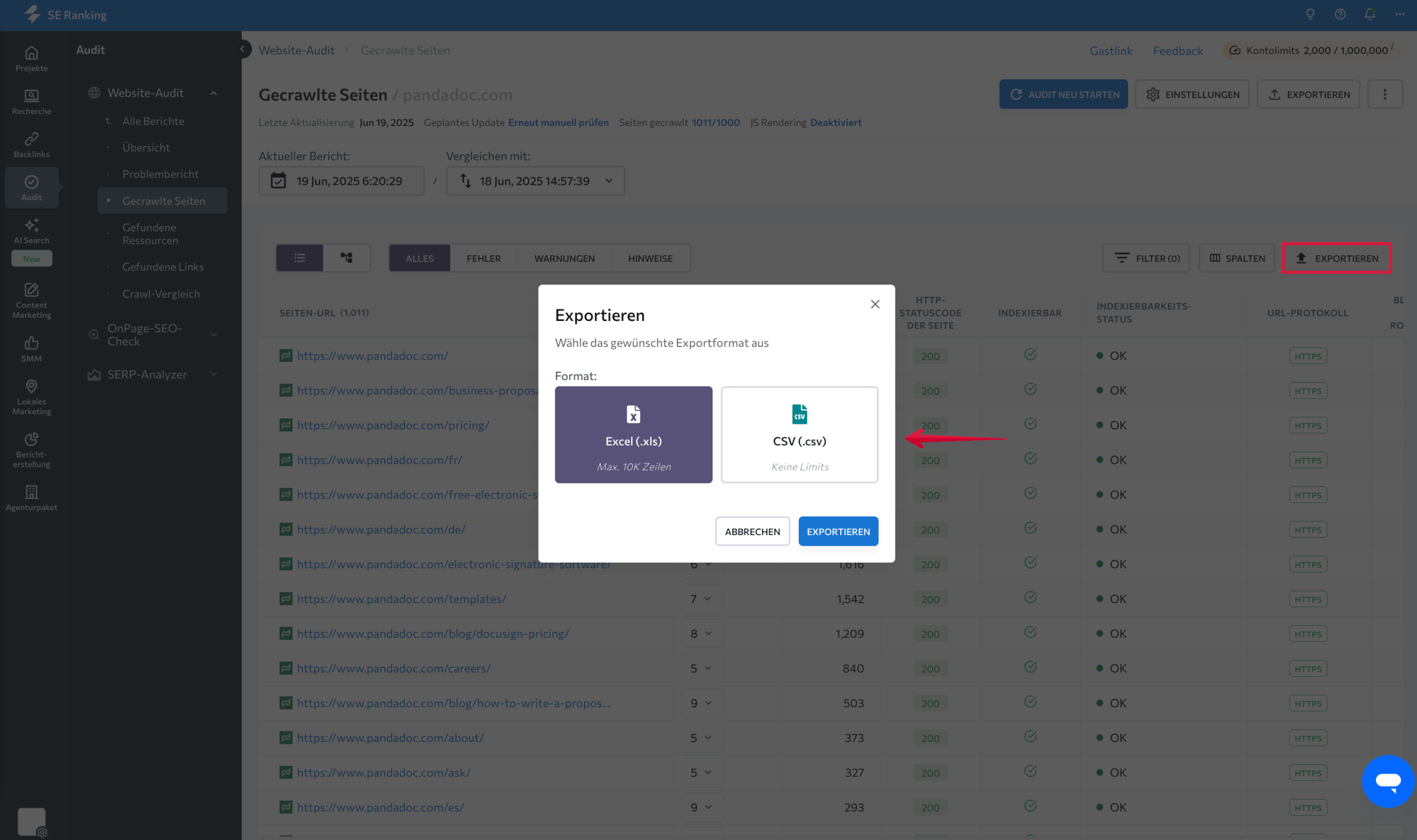

Zum Abschluss kannst du die URL-Liste exportieren. Klicke auf „Exportieren“ und speichere die Daten im .xls- oder .csv-Format, um sie weiter auszuwerten oder mit anderen Tools zu kombinieren.

Google Search Console

Ein weiteres Tool, mit dem du alle URLs einer Website auslesen kannst, ist die Google Search Console. Beachte jedoch, dass dir GSC nur Seiten anzeigt, auf die Google auch tatsächlich zugreifen kann.

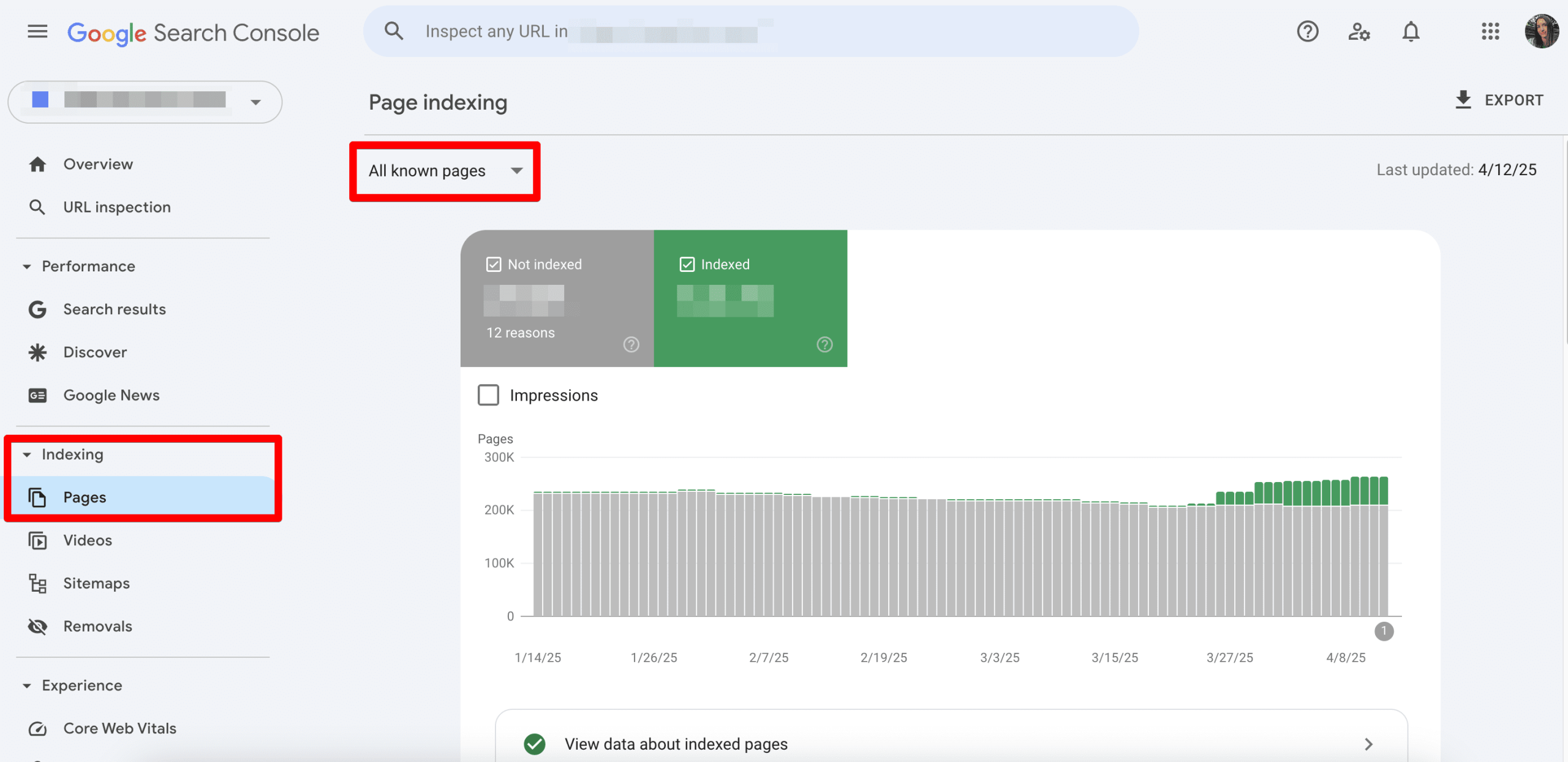

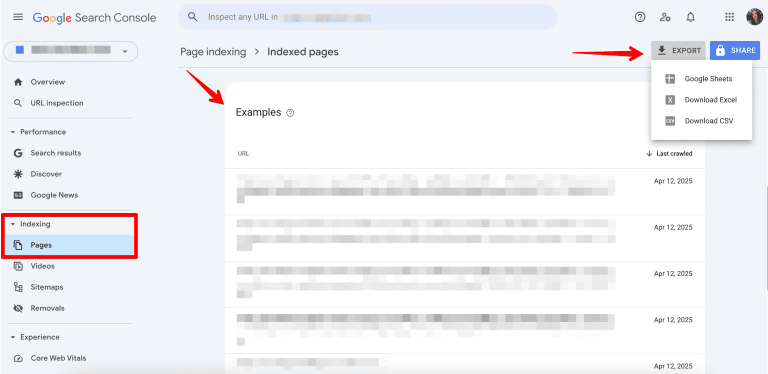

Öffne in der Google Search Console den Bereich „Indexierung“ und rufe den Bericht „Seiten“ auf. Wähle dort „Alle bekannten Seiten“, um sowohl indexierte als auch nicht indexierte URLs einzubeziehen.

Im Bereich „Indexiert“ siehst du die Anzahl aller URLs, die aktuell im Google-Index enthalten sind. Über den Link unter der Grafik kannst du dir die vollständige Liste dieser Seiten anzeigen lassen und inklusive Datum des letzten Crawls exportieren.

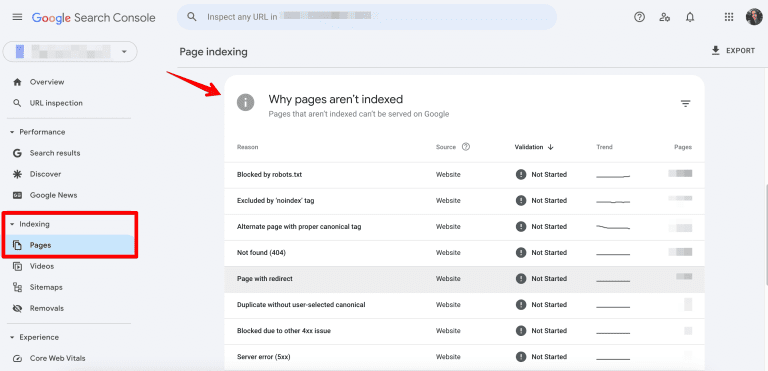

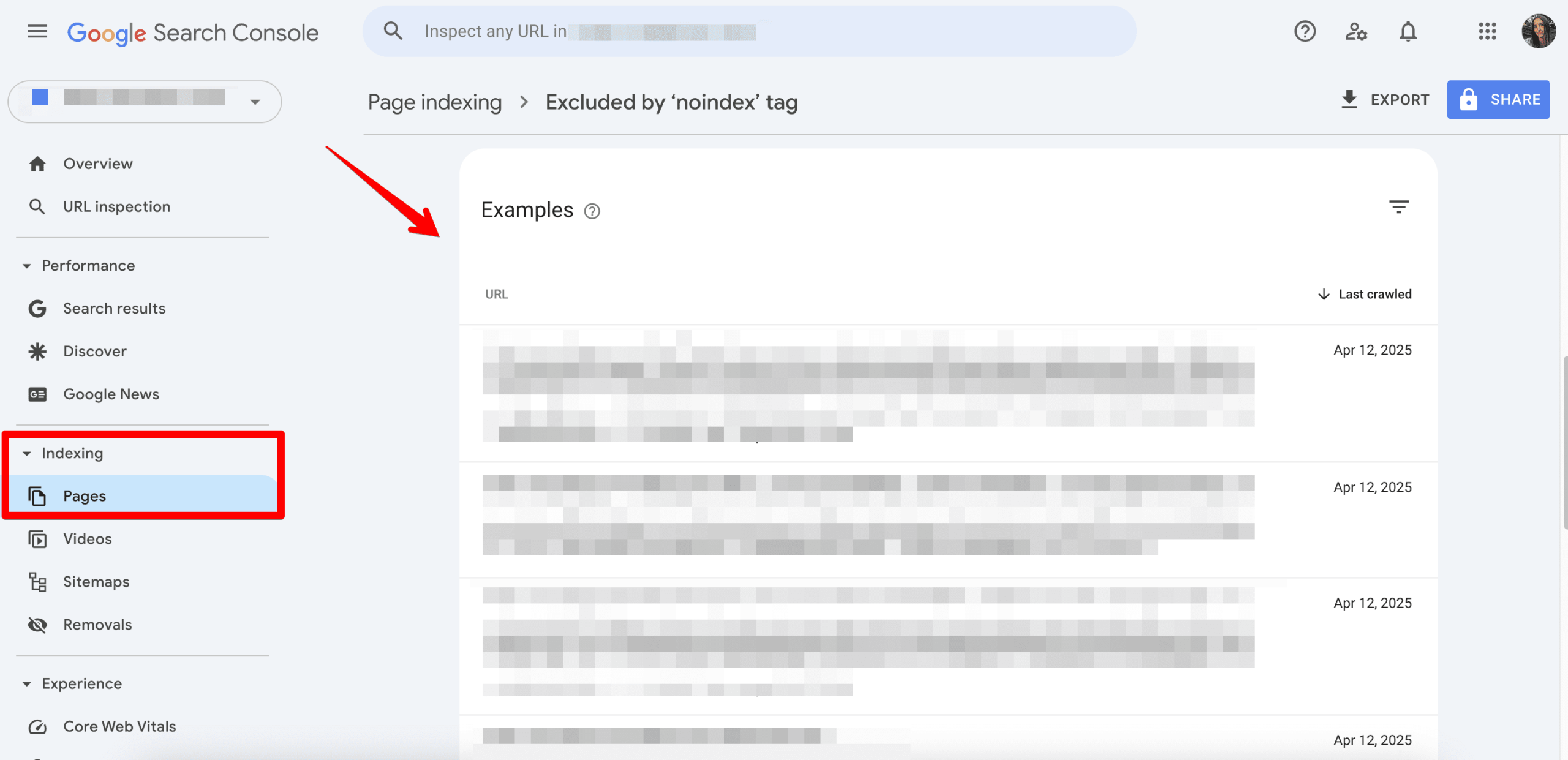

Ebenso wichtig sind die nicht indexierten Seiten (wechsle zurück zu den „Nur nicht eingereichte Seiten“). In den entsprechenden Kategorien zeigt dir Google, warum bestimmte URLs nicht im Index erscheinen – etwa aufgrund von:

- Weiterleitungen

- noindex-Tags

- Blockierungen durch robots.txt

- technischen Fehlern

Durch das Öffnen einzelner Kategorien erhältst du eine Liste aller betroffenen URLs und damit einen vollständigen Überblick über alle Seiten, die Google auf deiner Website gefunden hat.

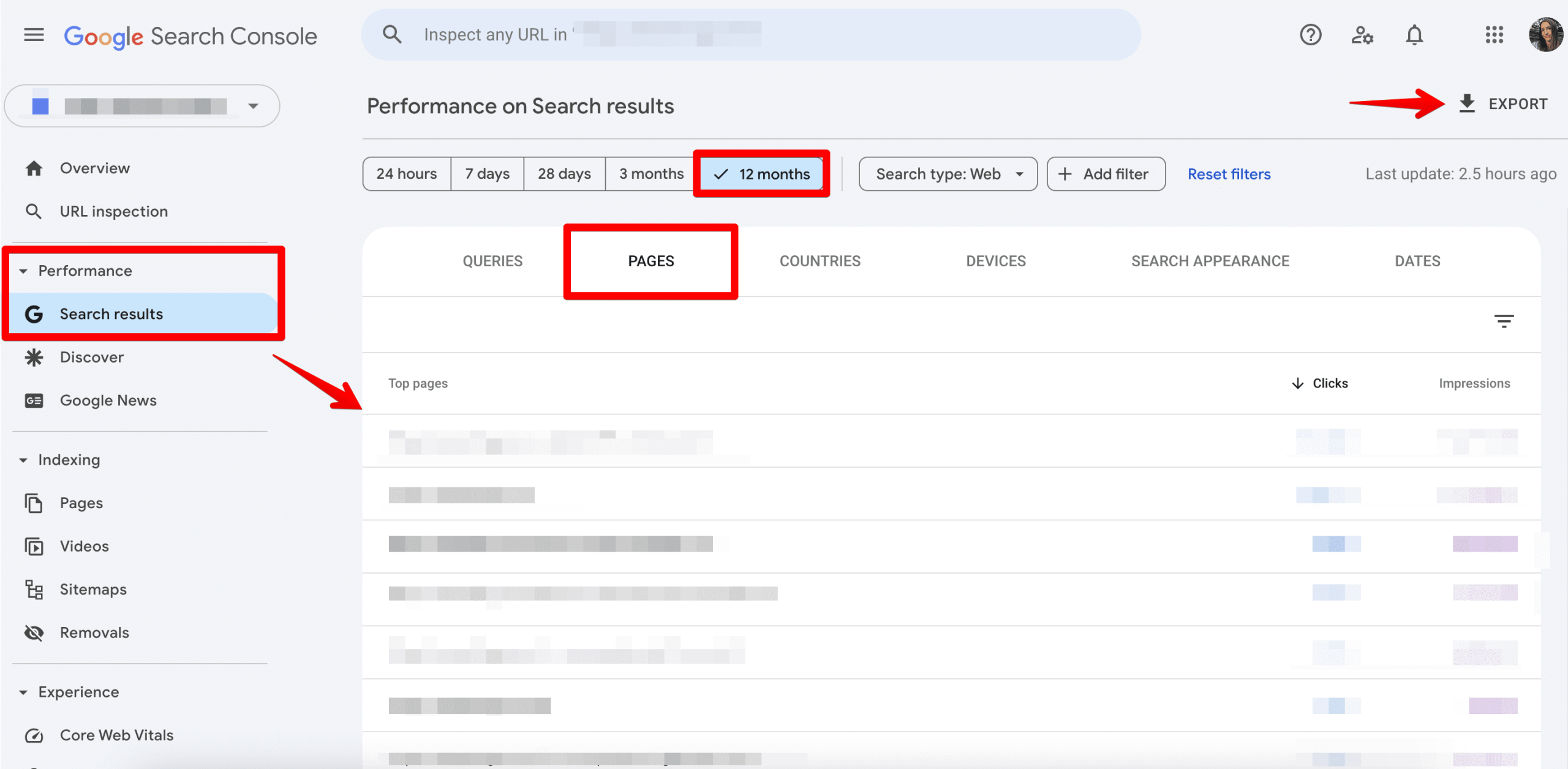

Ein weiterer hilfreicher Bericht ist der Suchergebnisse-Bericht. Er zeigt alle Seiten, die mindestens eine Impression in den Google-Suchergebnissen erhalten haben. erhalten haben. Wechsle dazu in den Bereich „Leistung“ → „Google Suche-Ergebnisse“, wähle den größtmöglichen Zeitraum aus und rufe den Tab „Seiten“ auf. Auch diesen Bericht kannst du exportieren und für deine Analyse nutzen.

Wenn du regelmäßig mit GSC-Daten arbeitest, kannst du das Add-on Search Analytics for Sheets verwenden. Damit lassen sich Daten aus der Google Search Console automatisiert in Google Sheets abrufen und als Backups speichern.

Google Analytics

Über Google Analytics kannst du alle Seiten deiner Website identifizieren, die tatsächlich von Nutzern besucht wurden. Voraussetzung ist, dass Google Analytics von Beginn an korrekt auf deiner Website eingerichtet war, damit entsprechende Daten erfasst werden konnten.

Die Logik ist einfach: Jede Seite, die mindestens einmal aufgerufen wurde, taucht in den Analytics-Daten auf. Da es sich dabei um reale Nutzerinteraktionen handelt, solltest du diese Seiten besonders prüfen und sicherstellen, dass sie einen klaren SEO- oder Marketingzweck erfüllen.

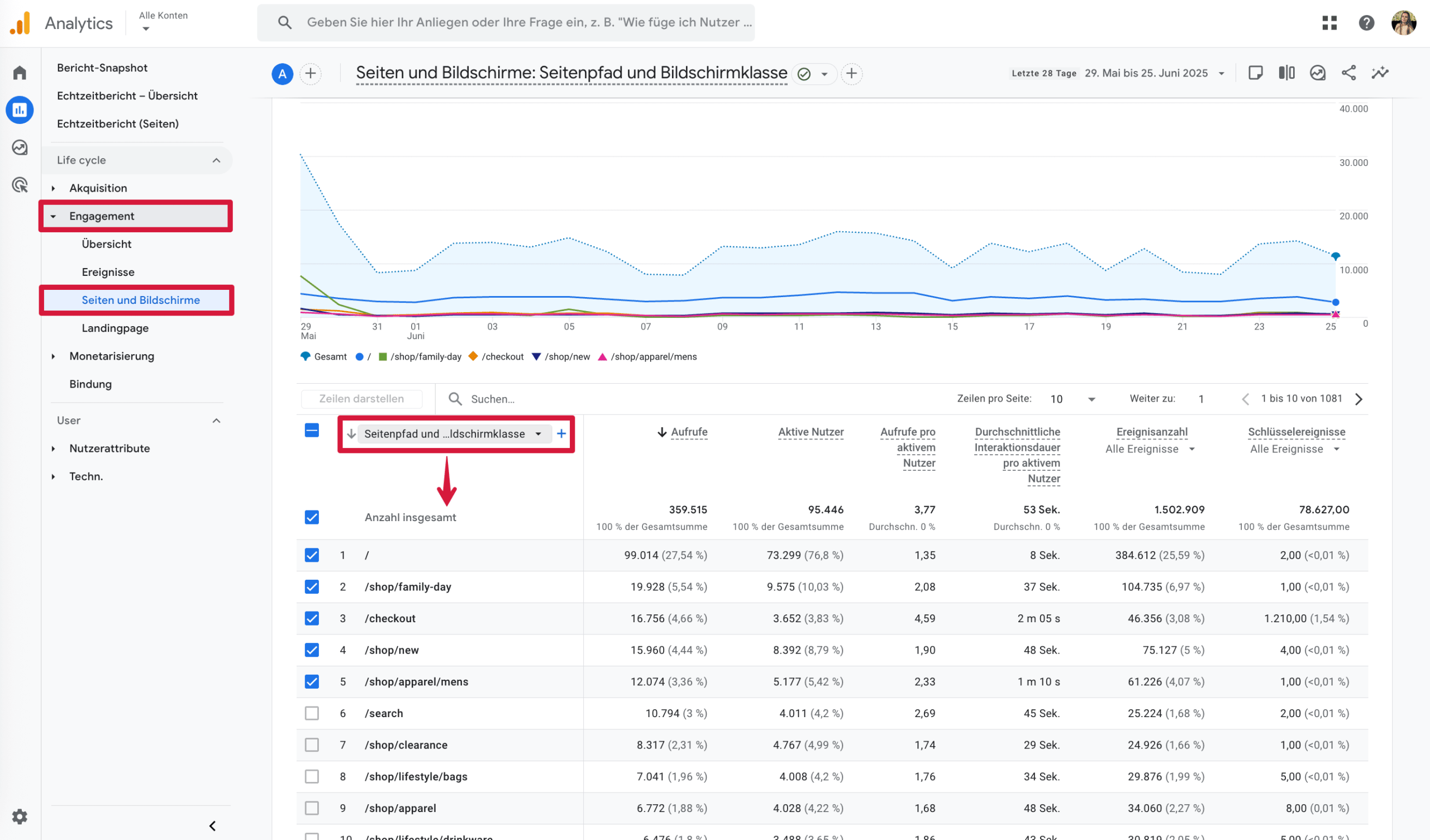

Rufe dazu in Google Analytics den Bereich Berichte → Engagement → Seiten und Bildschirme auf und wähle die Dimension Seitenpfad und Bildschirmklasse.

Über die Metrik Aufrufe kannst du die Tabelle sortieren und dir die Seiten entweder nach den meisten oder nach den wenigsten Seitenaufrufen anzeigen lassen. So erkennst du schnell, welche Seiten besonders relevant sind oder kaum genutzt werden.

Anschließend kannst du die Daten teilen oder als .csv-Datei exportieren.

Bing Webmaster Tools

Google gilt zwar als führende Suchmaschine, doch Bing ist nach wie vor die zweitbeliebteste. Im Januar 2025 lag der weltweite Marktanteil von Bing bei 4,04 %, was zeigt, dass es sich lohnt, die eigene Website auch für Bing zu optimieren.

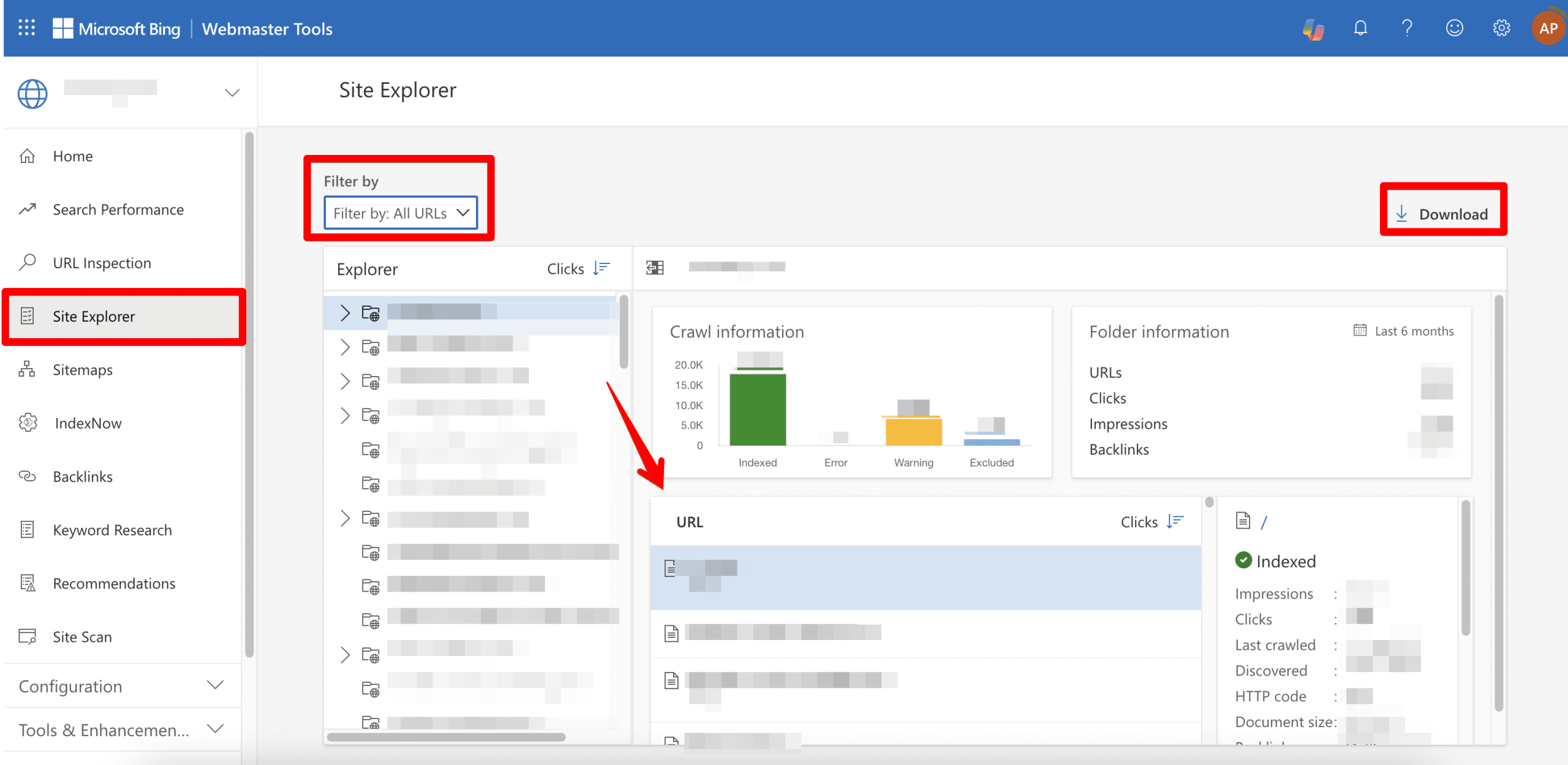

Mit den Bing Webmaster Tools kannst du alle URLs einer Website finden, die von Bing indexiert wurden. Voraussetzung ist, dass deine Website zuvor hinzugefügt und verifiziert wurde.

Rufe anschließend in der linken Navigation den Site Explorer auf und wähle den Filter „Alle URLs“. Der Bericht zeigt dir alle Seiten, die Bing auf deiner Website erkannt hat. Über die Export-Funktion kannst du die Daten herunterladen und für weitere Analysen nutzen.

Kommandozeile (Wget)

Eine technischere Möglichkeit, alle Seiten einer Website zu erfassen, ist die Nutzung der Kommandozeile. Dabei arbeitest du mit Textbefehlen direkt auf deinem Computer und kannst Websites automatisiert herunterladen und analysieren.

Eine gängige Lösung ist das Tool Wget, mit dem sich Websites rekursiv herunterladen lassen. Voraussetzung ist, dass Wget auf deinem System installiert ist.

Die Installation hängt vom verwendeten Betriebssystem ab. Unter macOS musst du zum Beispiel zunächst den Paketmanager Homebrew installieren, bevor du Kommandozeilentools wie Wget nutzen kannst.

Um Wget zu installieren, öffne ein Terminalfenster und gib folgenden Befehl ein:

brew install wget

Nach der Installation kannst du deine Website rekursiv herunterladen:

wget -r www.examplesite.com

Wget startet bei der angegebenen URL und lädt alle intern verlinkten Seiten sowie weitere Dateien herunter. Es folgt den Links automatisch, bis keine weiteren erreichbaren Seiten mehr gefunden werden.

Sobald der Download abgeschlossen ist, kannst du dir eine Liste aller gespeicherten URLs ausgeben lassen, zum Beispiel mit:

find www.examplesite.com

Sitemap.xml

Die XML-Sitemap ist eine einfache Möglichkeit, URLs einer Website zu erfassen. Sie enthält alle Seiten, die der Websitebetreiber aktiv zur Indexierung freigegeben hat, und dient Suchmaschinen als Orientierungshilfe für die Website-Struktur.

Wichtig: Die Sitemap zeigt nicht zwangsläufig alle existierenden Seiten, sondern nur jene, die bewusst aufgenommen wurden.

Sitemap finden

In den meisten Fällen ist die Sitemap über das Stammverzeichnis der Website erreichbar, zum Beispiel unter:

https://www.beispielseite.de/sitemap.xml

Verwendet eine Website mehrere Sitemaps, findest du diese meist in einer Sitemap-Index-Datei (häufig sitemap-index.xml). Dort kannst du die einzelnen Sitemaps aufrufen und die enthaltenen URLs einsehen.

Sitemap auslesen

Die URLs lassen sich direkt aus der Sitemap kopieren oder automatisiert weiterverarbeiten. Eine praktische Möglichkeit ist der Import in Google Sheets, um alle URLs gesammelt auszuwerten.

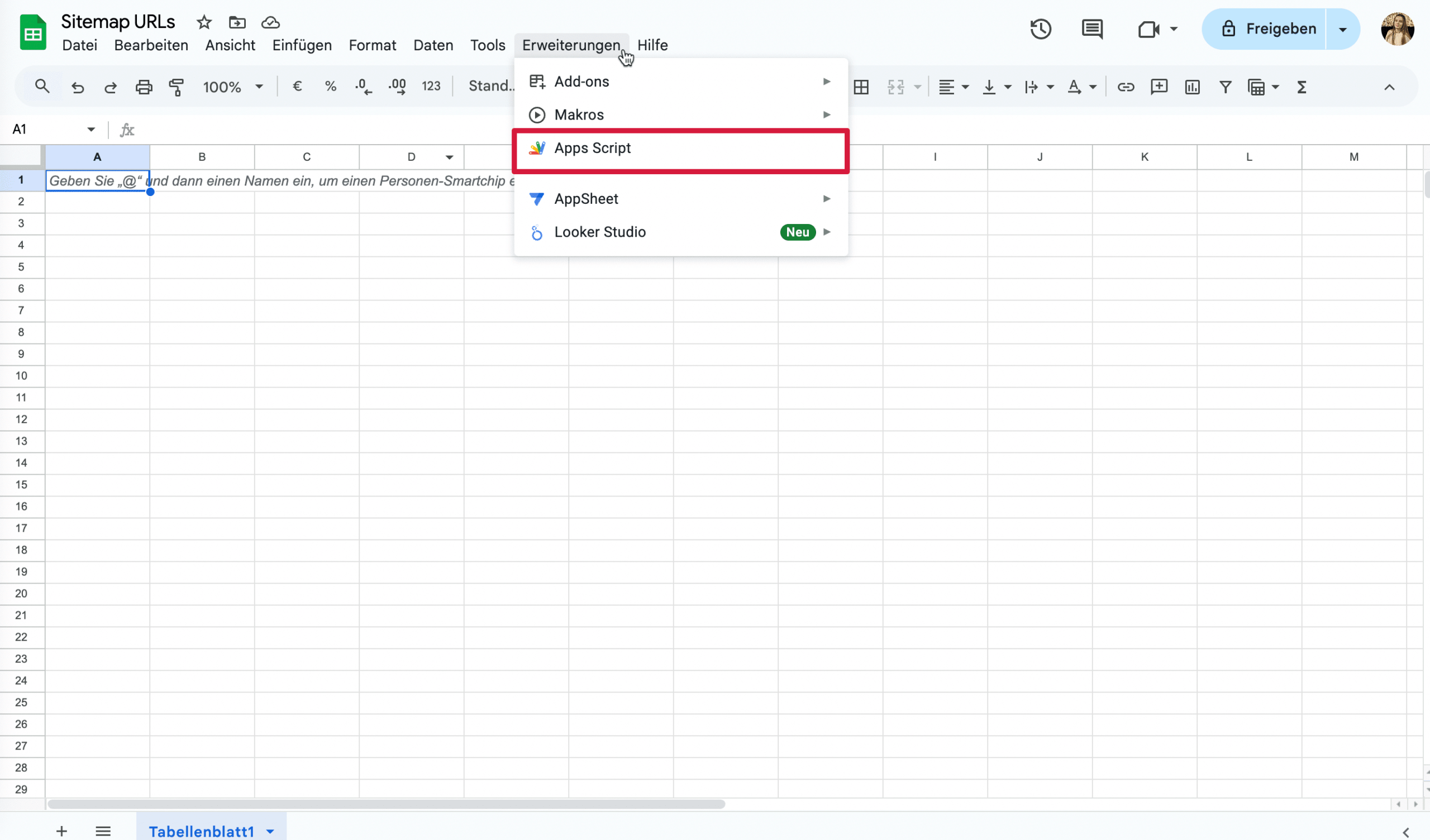

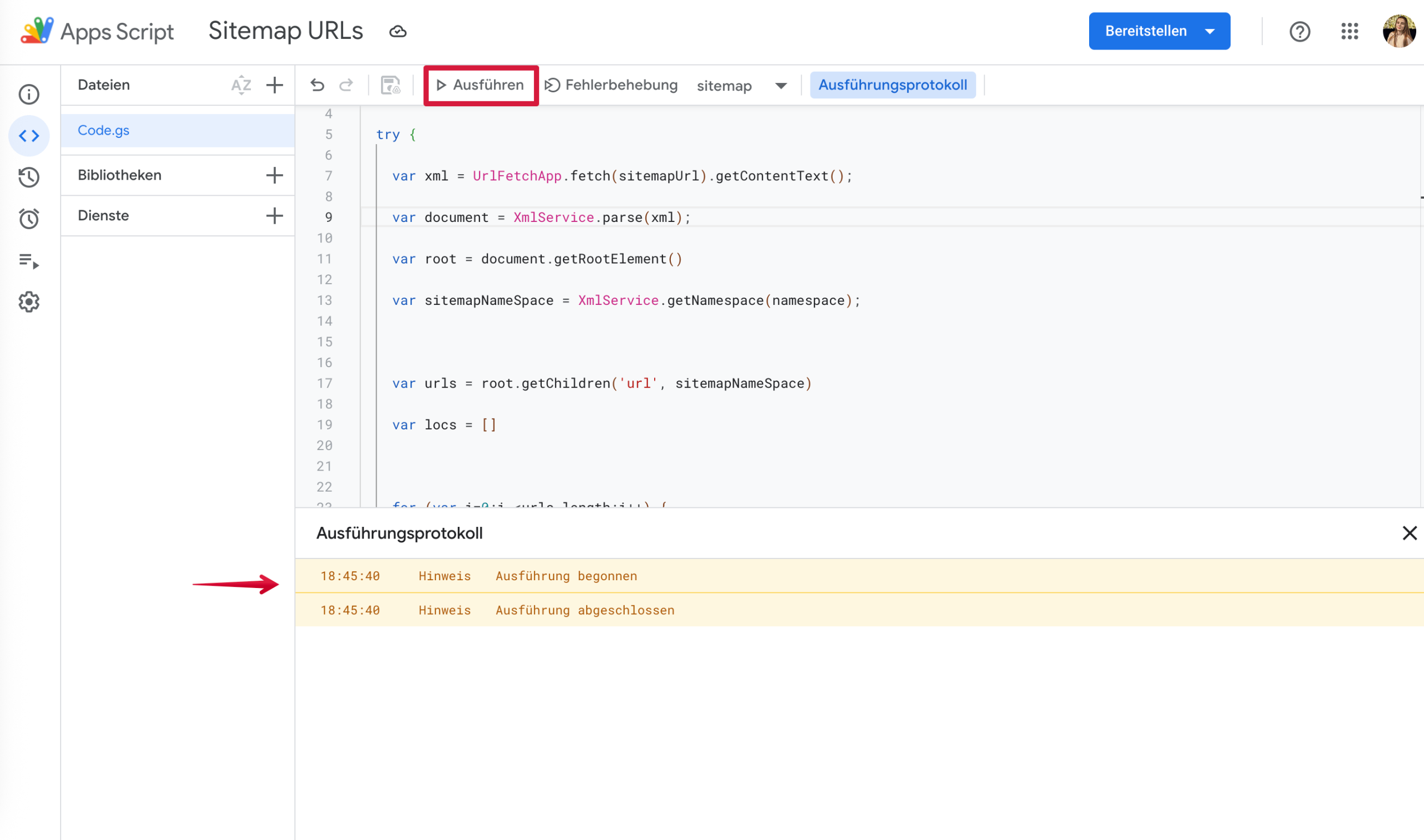

Diese Methode erfordert etwas technisches Know-how, spart aber viel Zeit, da du alle URLs in wenigen Sekunden in ein Google Sheet importieren kannst. Erstelle zunächst ein neues Google Sheet und gehe zu Erweiterungen → Apps Script.

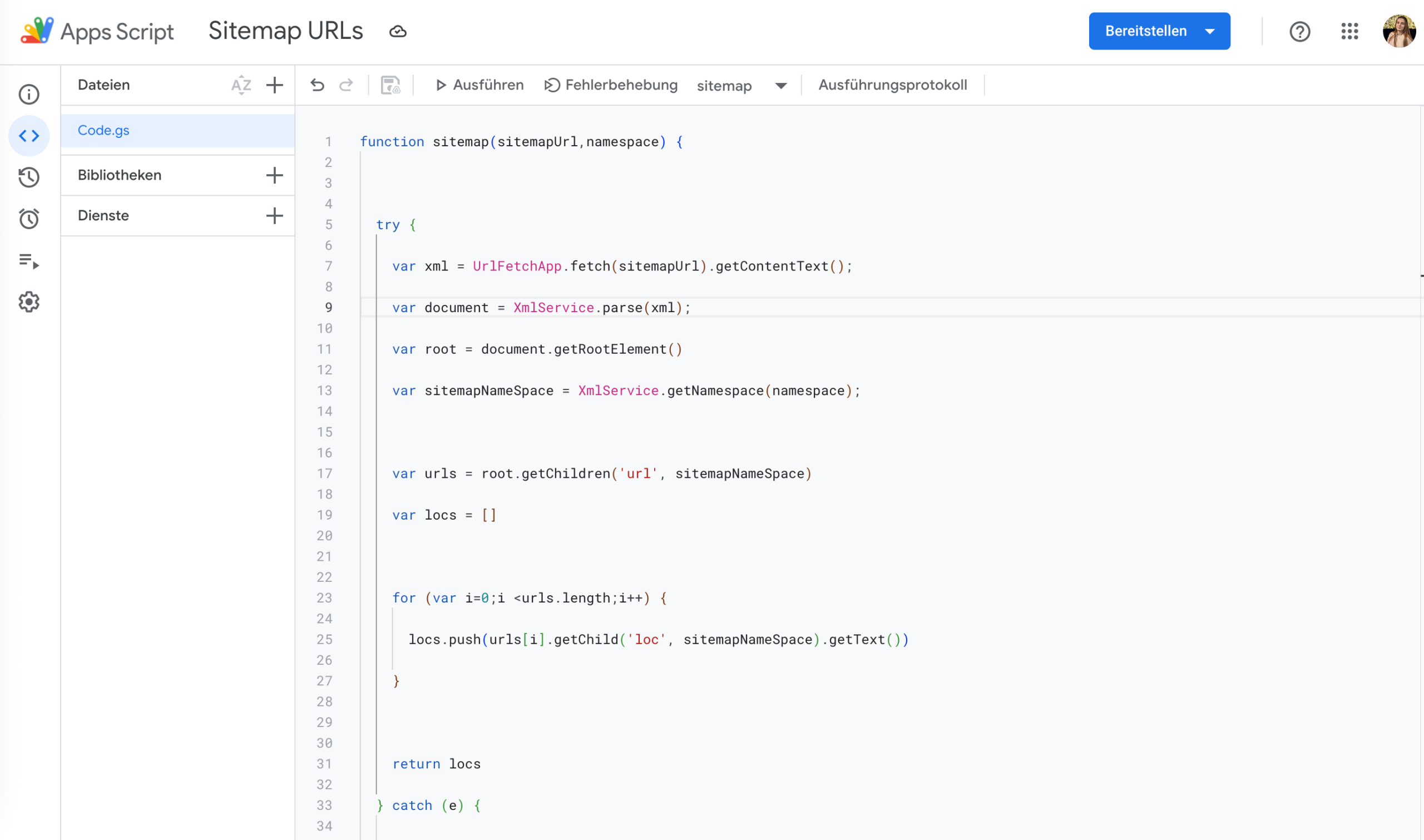

Füge dort folgenden benutzerdefinierten JavaScript-Code in den Script-Editor ein:

function sitemap(sitemapUrl,namespace) {

try {

var xml = UrlFetchApp.fetch(sitemapUrl).getContentText();

var document = XmlService.parse(xml);

var root = document.getRootElement()

var sitemapNameSpace = XmlService.getNamespace(namespace);

var urls = root.getChildren('url', sitemapNameSpace)

var locs = []

for (var i=0;i <urls.length;i++) {

locs.push(urls[i].getChild('loc', sitemapNameSpace).getText())

}

return locs

} catch (e) {

return e

}

}

Speichere das Skript und führe einen Test aus. Der Editor fordert dich dabei zur Vergabe von Zugriffsrechten auf. Wenn das Skript korrekt eingerichtet ist, wird es ohne Fehlermeldung ausgeführt.

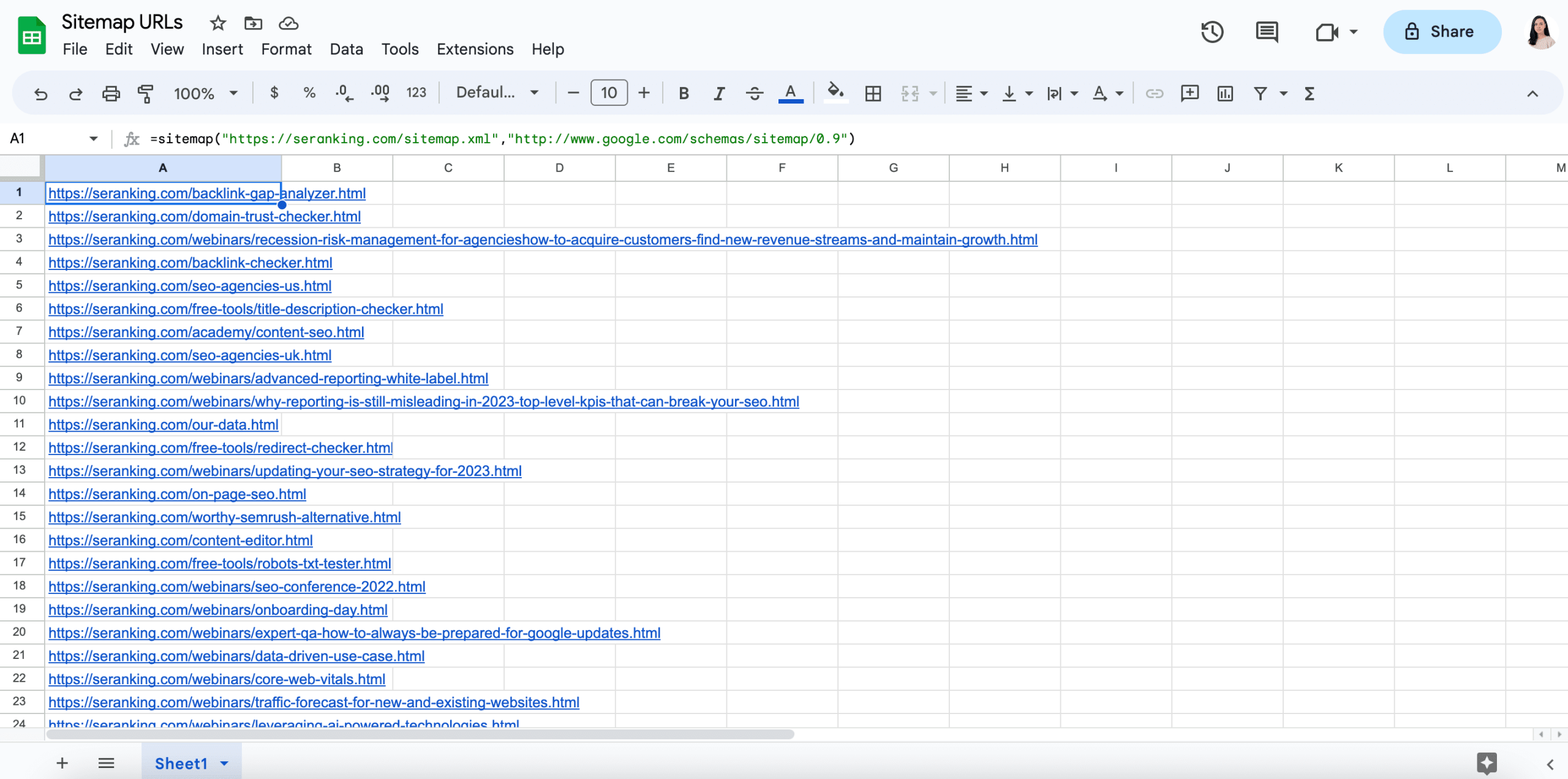

Wechsle anschließend zurück zu deinem Google Sheet und gib folgende Formel ein:

=sitemap("Sitemap Url","Namespace Url")

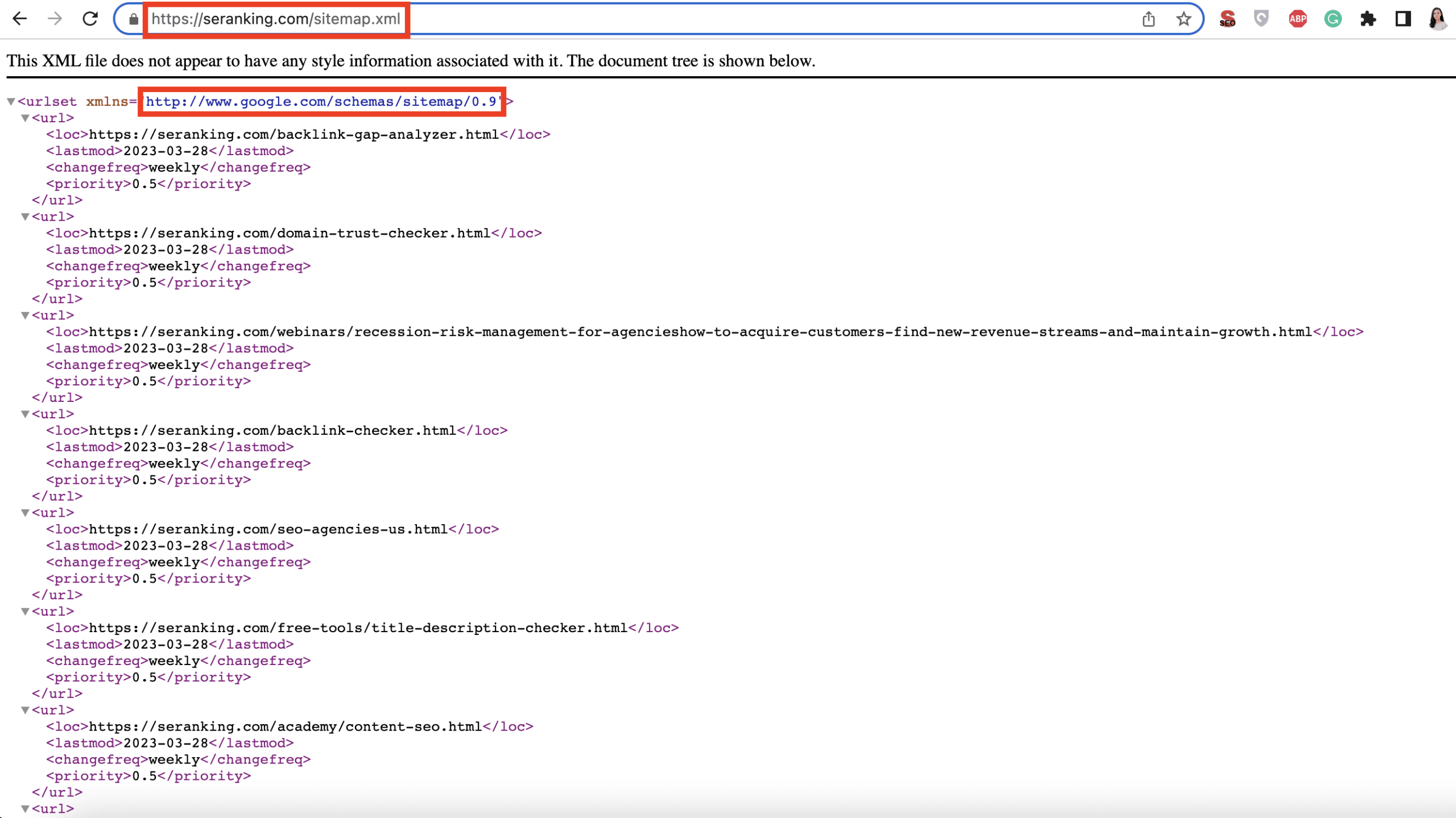

- Die Sitemap-URL befindet sich in der Adressleiste des Browsers.

- Die Namespace-URL steht in der ersten Zeile des Sitemap-Inhalts.

Kopiere beide URLs und füge sie in die Formel ein, zum Beispiel:

=sitemap("https://seranking.com/sitemap.xml","http://www.google.com/schemas/sitemap/0.9")

Nach dem Bestätigen mit Enter werden alle URLs aus der Sitemap automatisch in dein Google Sheet extrahiert.

WordPress-Plugins

Wenn deine Website auf WordPress basiert, kannst du Plugins nutzen, um alle Seiten schnell aufzulisten oder zu exportieren. Häufig verwendete Optionen sind zum Beispiel:

Um diese Plugins zu verwenden, lade sie herunter und installiere sie im Verzeichnis /wp-content/plugins/.

Sobald sie installiert sind, aktiviere sie auf der Plugins-Seite in WordPress. Nach der Aktivierung kannst du alle URLs auflisten oder exportieren.

Wenn du ein anderes CMS verwendest, prüfe, ob es integrierte Plugins für diesen Zweck gibt oder ob ein separates Plugin im Erweiterungsverzeichnis verfügbar ist.

Joomla beispielsweise bietet viele Plugins zur Generierung von Sitemaps, mit denen du eine Seitenliste erhalten kannst. Auch Drupal verfügt über ein Sitemap-Modul, das dir beim Sammeln der Seiten deiner Website helfen kann.

Google-Suchoperatoren (site:)

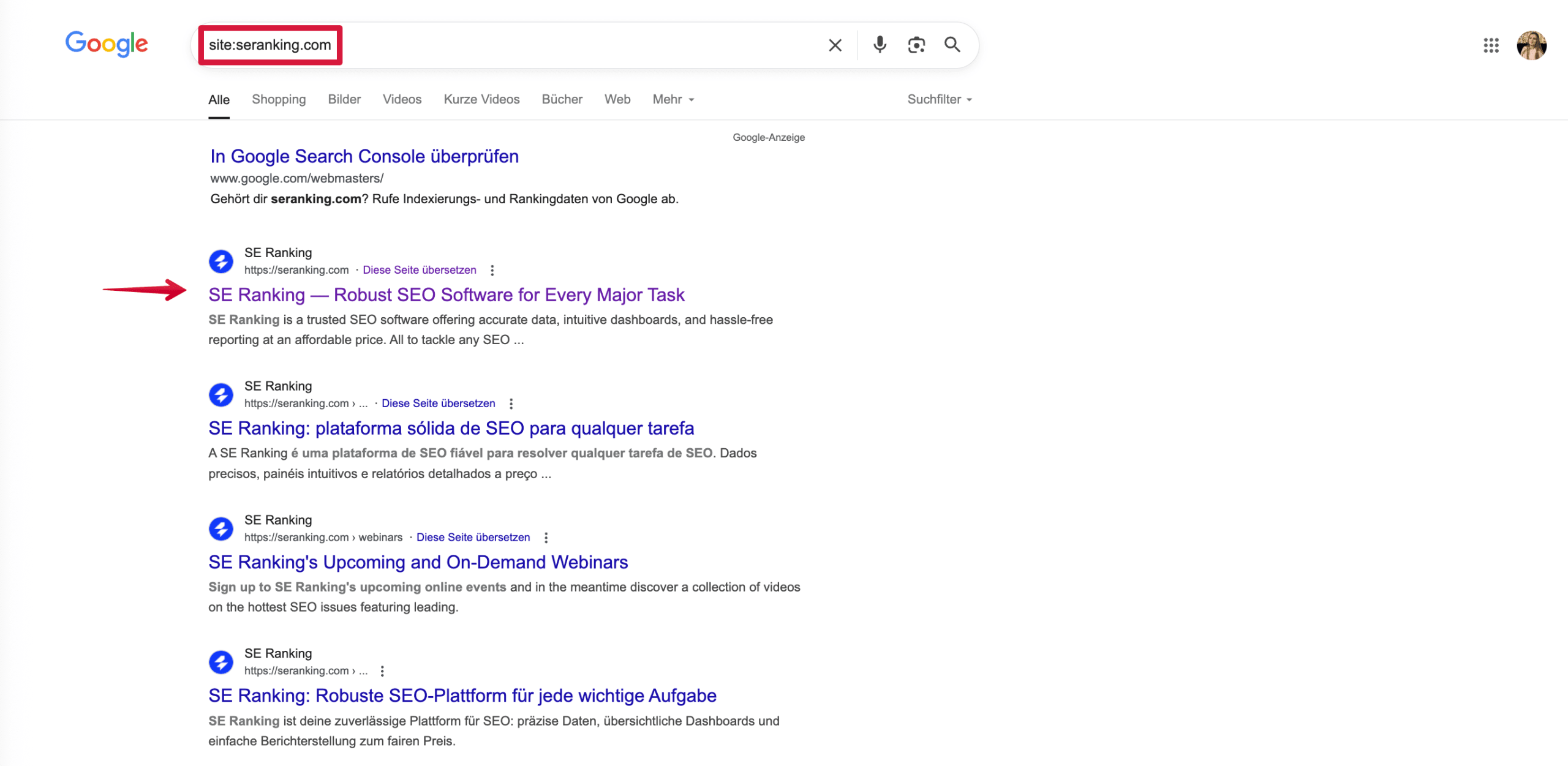

Neben spezialisierten Tools gibt es auch eine besonders einfache Möglichkeit, alle URLs einer Website zu finden: Google deine Website, aber richtig.

Über sogenannte Google-Suchoperatoren kannst du die Suchergebnisse gezielt einschränken. Der bekannteste Operator dafür ist site:.

Gib dazu in die Google-Suche ein:

site:beispielseite.com

Du musst dabei weder http:// noch www angeben. Wichtig ist lediglich, dass kein Leerzeichen zwischen dem Operator site: und der Domain steht, da Google die Anfrage sonst falsch interpretiert.

Beachte jedoch, dass dieser Befehl nicht dafür gedacht ist, alle indexierten Seiten einer Website anzuzeigen. Das hat auch John Mueller von Google bestätigt:

Warum es sich lohnt, alle URLs einer Website auszulesen

Alle Seiten deiner Website zu kennen, ist ein zentraler Bestandteil jeder erfolgreichen SEO-Strategie. So lassen sich technische Probleme frühzeitig erkennen, Inhalte gezielt optimieren und die interne Verlinkung sinnvoll steuern.

Wenn du die in diesem Artikel beschriebenen Tools und Methoden nutzt, findest du zügiger alle Seiten deiner Website und erhältst wertvolle Einblicke in ihre Performance. Wähle die Lösung, die am besten zu dir passt, oder teste die Tools von SE Ranking kostenlos – in der Testphase erhältst du Zugriff auf mehr Funktionen als nur das Auslesen von URLs.