¿Qué es el Crawl Depth o profundidad de rastreo para Google?

¿Cuántos clics tienen que hacer tus usuarios para acceder al contenido que busca? Hoy queremos hablarte del Crawl Depth, un factor de SEO que tiene relación directa con los bots de Google y los niveles de profundidad de rastreo dentro de una web.

Muchas veces jerarquizamos tanto las categorías y contenidos de una página web que, lejos de facilitar su rastreo y lectura, están dificultando la navegación.

Veremos cómo afecta esto a la indexación en Google, y te compartiremos 3 tips para que puedas tener una web amigable y fácilmente rastreable.

¡Comenzamos!

¿Qué significa la profundidad de rastreo de una web o Crawl Depth?

El crawl depth es el nivel de profundidad al que deben llegar los bots de los motores de búsqueda para encontrar una página, cuando hacen el rastreo de un sitio web. También se lo suele denominar como profundidad de clics.

La profundidad de rastreo nos dice hasta qué nivel han rastreado e indexado los bots de Google un sitio web.

Esto es algo que no solo tiene que ver con el posicionamiento SEO, también influye mucho en la experiencia de usuario.

Si un usuario entra en tu web y no encuentra lo que busca de forma rápida e intuitiva, teniendo que navegar por varias páginas diferentes hasta llegar al resultado deseado, es muy probable que abandone pronto la web para irse a otro sitio.

Para poner solución a estos posibles problemas, debes tener un buen diseño de arquitectura web en tu sitio.

¿Cuántos niveles de profundidad debe tener una web para que sea rastreada facílmente?

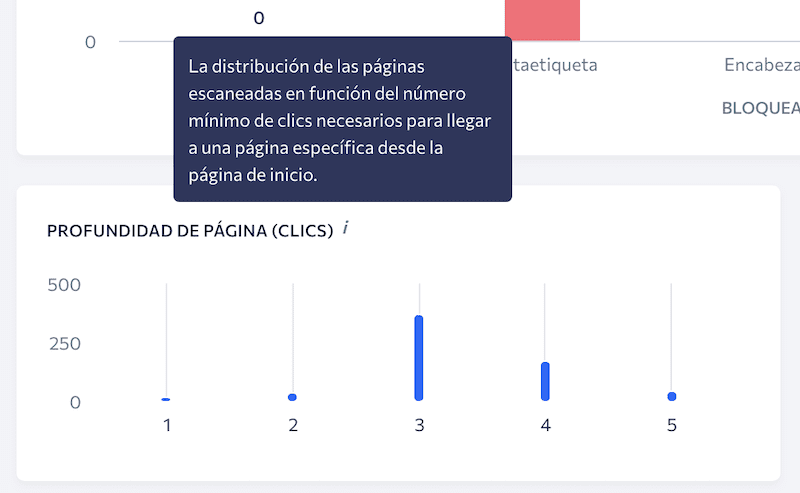

Hay muchos expertos de SEO que coinciden que cualquier contenido de una web debe estar accesible para los usuarios a menos de 3 clics, desde la Home.

Esta información no está confirmada por parte de Google, pero está demostrado que es muy fácil que el buscador indexe hasta los niveles más profundos una página que cumple con esta afirmación.

Poner en práctica todo esto hace que tu web sea mucho más accesible y amigable, tango para los bots de Google en su trabajo de rastreo, como para los propios usuarios, que consiguen moverse por la web de manera sencilla e intuitiva.

Por tanto, los niveles de profundidad ideales que debe tener una web, son 3. Desde el nivel cuatro en adelante, dichas páginas comienza a perder, nivel a nivel, su relevancia de cara a Google.

Veámoslo con un ejemplo. Imagina que tu página web es una tienda online de ropa, puedes crear estos niveles de profundidad:

- Nivel 0: es la página Home

- Nivel 1: aquí ponemos la primera categoría, que puede ser, por ejemplo, “abrigos de mujer”. Ya tenemos el primer clic que hace el usuario desde la Home.

- Nivel 2: abrimos otra categoría que podemos llamar “chaquetas y chaquetones” dentro de la anterior. En este caso, el usuario ha hecho 2 clics desde la Home para llegar aquí.

- Nivel 3: en este nivel es donde incluimos los productos. Siguiendo con el ejemplo, puede ser “Chaqueta roja de plumón con capucha”. Para llegar hasta los productos, los bots de Google y el usuario han hecho 3 clics.

¿Cómo afecta el crawl Depth o profundidad de rastreo a la indexación de un sitio web?

El hecho de que una página web tenga pocos, o ninguno, niveles de profundidad, no garantiza la indexación en Google de todas las URL. Aquí es donde entra en juego el enlazado interno, y donde se ve la eficacia de la estrategia de link building.

Puede que, a priori, pienses que los enlaces importantes para dar autoridad a tu web son los externos. Y no te falta razón; sin embargo, no podemos olvidar la importancia que tienen los enlaces internos, por estos motivos:

- Ayudan a los motores de búsqueda a comprender cómo está estructurada una página web.

- Los enlaces internos pasan autoridad a las páginas del sitio. Y gracias al PageRank, que evalúa la calidad y cantidad de los enlaces de cada URL, puedes identificar las páginas más importantes de tu sitio.

- Mejoran la experiencia de usuario: con los enlaces internos puedes ayudar a un usuario, llevándole a otras páginas de tu blog, por ejemplo, donde puede profundizar más sobre un tema. O también, puedes llevar a tus clientes potenciales de unos productos a otros dentro de tu e-commerce.

Una distribución coherente y equilibrada de los enlaces internos entre los diferentes niveles de profundidad, llevará a usuarios y bots hasta los contenidos que quieres destacar.

Los 6 errores SEO más habituales que afectan al Crawl Depth

A continuación, te compartimos los errores más frecuentes que afectan de manera negativa al crawl depth, con el riesgo de dejar fuera del rastreo e indexación de algunas páginas de tu sitio cuyo contenido es muy importante.

1. Enlaces internos que no se pueden rastrear o están rotos

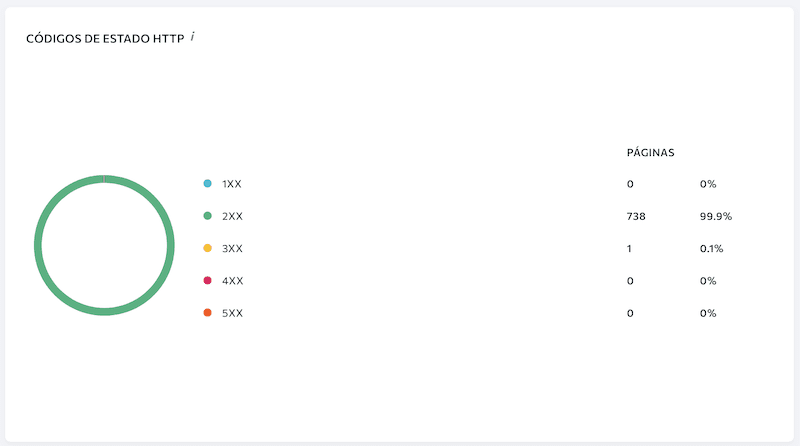

Esto provoca demasiados inconvenientes que suelen molestar a usuarios y crawlers. Debes vigilar que los enlaces internos de tu web están correctamente escritos y, por supuesto, no llevan a un error 404.

Nuestra herramienta SE Ranking te mantiene informado de los enlaces internos rotos o incompletos, para que puedas solucionar el problema cuanto antes.

2. Desequilibrio en el número de enlaces

En SEO, como en todo, los extremos no son buenos. Es cierto que no hay una norma específica sobre la cantidad máxima de enlaces internos que puede tener una página.

Y ya no es cuestión solo de SEO, sino también de usabilidad. Piensa que una página sobrecargada de enlaces no resulta cómoda para los usuarios que están descubriendo tu contenido.

Por poner unos límites y, en líneas muy generales, no excedas de 3.000 el número de enlaces en tu sitio web. Y, por supuesto, tampoco lo dejes con un único enlace interno.

3. Evita las páginas huérfanas

Una página huérfana es la que no está vinculada a ninguna otra dentro del sitio web. Esto supone que se queda fuera del rastreo de Google y, por tanto, de su indexación.

Debes vigilar esta situación porque puede que se trate de una página valiosa que sí debería ser rastreada. En ese caso, inclúyela en tu estrategia de enlazado interno.

Quizá se trata de una URL que no deseas que sea indexada. Para evitar que los bots de Google entren a rastrearla, agrégale la etiqueta “noindex”, pero no la dejes sin enlazado.

La auditoría web que puedes hacer con nuestra herramienta, SE Ranking, te facilita la información de las páginas de tu sitio que están indexadas. De esta manera, puedes tomar las mejores decisiones sobre todas las landings que forman tu página web.

4. Un exceso de redirecciones dificulta el rastreo

Este es otro factor que debes controlar al detalle. Y es que cada vez que el bot de Google accede a un enlace con demasiadas redirecciones, hace que no sea fácil llevar a cabo el rastreo, además de hacerle perder el valioso y escaso tiempo que puede dedicar a tu web.

Los usuarios también notan esta colección de redirecciones, haciendo que su experiencia en tu página empeore de manera notable.

5. Ten cuidado con el atributo NoFollow en los enlaces internos

En algunas páginas hay enlaces salientes que tienen el atributo rel=”nofollow”. Esto debes eliminarlo, porque estás restringiendo el movimiento de los bots de Google por tu sitio web.

Analiza bien los enlaces de tu web que tienen este atributo, y trata de eliminarlo en el máximo número posible de ocasiones.

6. Vigila los enlaces internos que apuntan a páginas HTTP

Este error es muy frecuente; y es que en webs seguras puede ocurrir que haya enlaces que apunten hacia páginas http, lo que puede provocar un redireccionamiento innecesario.

3 trucos para organizar el contenido en la arquitectura de la información de una web

El enlazado interno es uno de los factores que más afecta al posicionamiento de cualquier contenido dentro de una web. Por eso, es muy importante que inviertas tiempo en diseñar la arquitectura de la información de tu sitio.

Aquí tienes 3 tips que te ayudarán a organizar los contenidos de tu página:

- Las páginas que más tráfico reciben son las que tienen que estar a menos clics de la Home.

- Además, estas URL con mayor potencial de tráfico deben estar enlazadas mucho más que el resto.

- También es muy importante el anchor text que enlaza a estas landings. Trata de que sea la keyword más habitual que define la intención de búsqueda del usuario.

De esta manera, te aseguras la profundidad de rastreo hasta los contenidos con más relevancia, valor y visitas de tu web.

Conclusión

El crawl depth determina la profundidad que alcanzan los motores de búsqueda cuando rastrean una página web. Más allá del tercer nivel es muy difícil que los bots de Google indexen ningún contenido.

El mejor síntoma de conseguir la indexación en Google con una profundidad de rastreo adecuada está en tener una arquitectura web estudiada, donde los contenidos más relevantes queden a muy pocos clics de la Home.

¿Conocías el término Crawl Depth y cómo afecta al SEO en tu sitio web?

Comparte tu experiencia con nuestra comunidad.