Qu’est-ce que le référencement ?

Le référencement (optimisation pour les moteurs de recherche) signifie mettre une page Web dans les résultats de recherche afin de recevoir du trafic organique des chercheurs. Il n’y a pas eu un jour où des milliards de personnes n’ont pas tapé certaines requêtes dans les moteurs de recherche pour trouver des informations utiles. Pour être précis, Google à lui seul reçoit plus de 40 000 requêtes par seconde ! Le nombre de recherches augmente de façon exponentielle, ce qui donne aux sites Web un large public qu’ils peuvent potentiellement convertir en visiteurs réguliers ou en clients payants. Apprendre les règles pour arriver en haut des résultats de recherche et se conformer à ces règles est ce qu’est fondamentalement le référencement.

Comment fonctionne la recherche ?

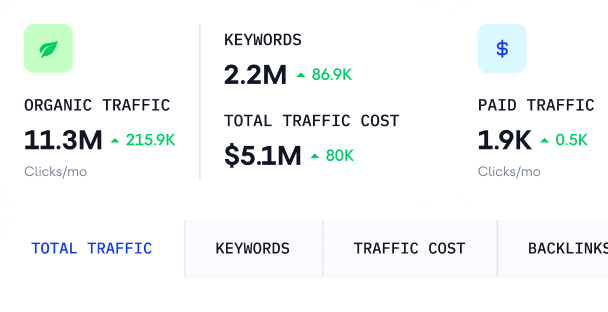

Lorsque vous ouvrez un moteur de recherche et tapez la requête qui vous intéresse, vous verrez la liste des 10 premiers résultats qui peuvent être organisés de manière différente. C’est ce qu’on appelle la SERP (page de résultats des moteurs de recherche). Il peut y avoir plus de 10 résultats si le SERP inclut des publicités payantes affichées ci-dessus, ci-dessous ou à droite des résultats organiques.

La place où se situe une page parmi les résultats est son classement dans les moteurs de recherche et plus le classement est élevé, plus la page a confiance et probablement plus elle est pertinente pour la requête. Pour définir l’ordre des pages à apparaître, les moteurs de recherche évaluent des centaines de facteurs de classement, que nous aborderons plus tard. Le processus de classement se fait de manière organique : contrairement aux annonces payantes, vous ne pouvez pas payer Google ou d’autres moteurs pour placer un site Web plus haut ou le réévaluer plus régulièrement.

Si vous êtes un chercheur actif qui connaît et remarque toutes les fonctionnalités de la page de résultats de recherche et les différences entre les différents types de requêtes, vous pouvez ignorer cette partie et passer à la section sur l’exploration et l’indexation.

Pour l’instant, voyons comment fonctionnent les différents types de recherches. Plus la requête est claire, plus grandes sont les chances de trouver rapidement la bonne information. Par exemple, si vous formatez votre requête sous forme de question, vous obtiendrez probablement de nombreuses fonctionnalités SERP (qui sont des blocs d’informations distinctifs qui aident à naviguer dans la recherche).

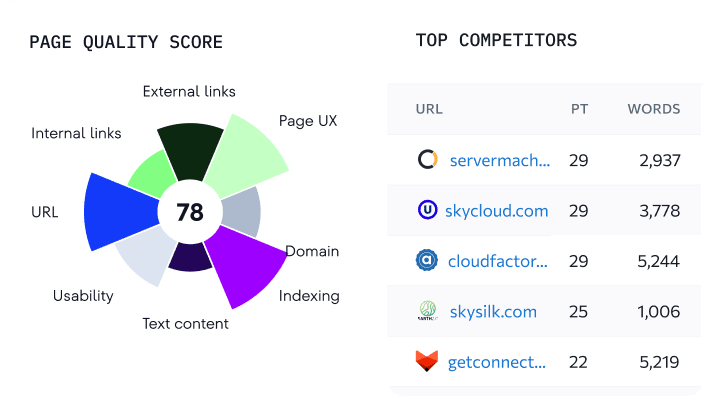

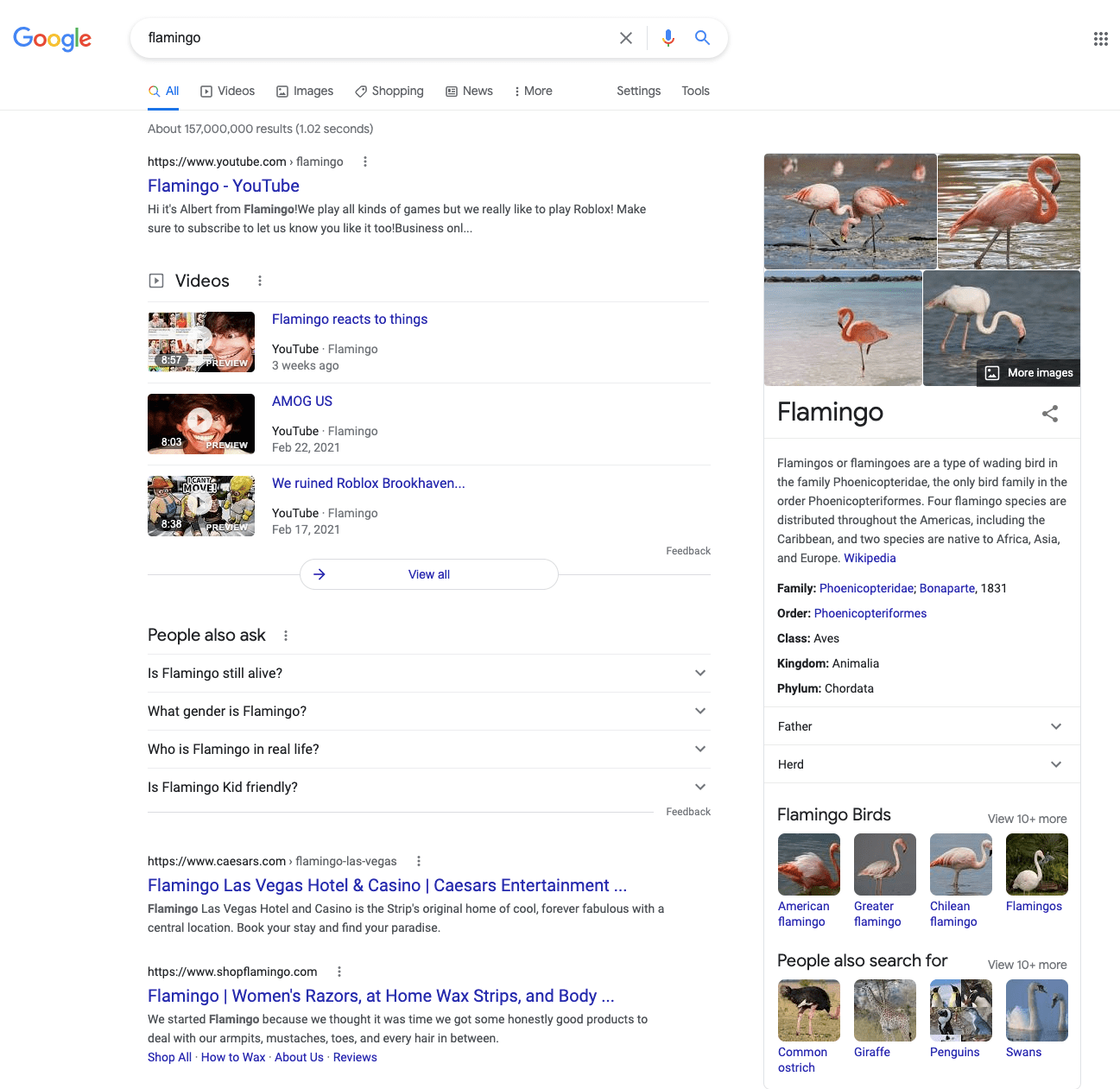

Dans la capture d’écran ci-dessus, vous pouvez voir les éléments suivants :

• une réponse courte (Google extrait les informations les plus pertinentes d’une page et les met dans un bloc de texte au-dessus du lien)

• une liste de recherches similaires (la section « Les gens demandent aussi » recueille les demandes pertinentes au sujet)

• une liste de vidéos suggérées (Google est même capable de diviser une vidéo sélectionnée en plusieurs parties)

Comme vous pouvez le voir, vous obtenez la réponse courte directement à partir des résultats de la recherche, puis vous pouvez cliquer sur différents types de sources pour obtenir plus de détails. Ainsi, le système est conçu pour répondre aux besoins des chercheurs le plus rapidement possible et leur fournir les informations les plus fiables et les plus utiles.

Voyons maintenant ce qui se passe si vous tapez une requête très générale :

Lorsque vous n’utilisez qu’un seul mot et qu’il ne s’agit pas d’un phénomène unique, Google peut être confus et vous donner des résultats très différents. Comme vous pouvez le voir sur la capture d’écran, la recherche de “flamant rose” affichera la chaîne YouTube éponyme, l’hôtel et la marque de soins du corps ainsi que des images d’oiseaux flamants roses. Si vous recherchez quelque chose de différent, vous devez rendre la requête plus spécifique.

Cela dit, les moteurs de recherche travaillent pour comprendre les chercheurs et leur donner les sources les plus pertinentes. Les fonctionnalités de recherche s’améliorent pour permettre aux utilisateurs d’accéder plus facilement au meilleur résultat approprié. Cela signifie pour les propriétaires de sites Web qu’ils doivent rechercher les requêtes susceptibles d’intéresser leur public cible et les placer sur le site Web. Mais plus important encore, ils doivent rendre ce contenu vraiment utile afin que lorsque les gens cliquent sur le site Web, ils reçoivent exactement ce qu’ils espéraient trouver.

Il s’agissait d’une explication très générique du fonctionnement de la recherche telle que vue par les utilisateurs. Plongeons maintenant dans la mécanique interne de la recherche telle qu’elle est effectuée par les moteurs de recherche.

Comment les moteurs de recherche organisent-ils les pages Web dans la recherche ?

Pour que les sites Web accèdent aux SERP, ils doivent être facilement détectables par les moteurs de recherche. Même si vous fournissez un contenu de haute qualité qui correspond à ce que les gens recherchent, vous ne pourrez pas vous classer haut sans être découvert grâce aux processus d’exploration et d’indexation.

Les mécanismes derrière les classements fonctionnent de la même manière parmi les moteurs de recherche. Étant donné que Google est le plus bruyant au sujet de ses outils et processus, nous allons illustrer l’exploration et l’indexation en fonction des explications de Google.

Qu’est-ce qui veut dire « ramper »?

Le processus consistant à établir qu’une certaine page Web est disponible sur le Web s’appelle l’exploration. En termes simples, ramper signifie être visité et analysé par un moteur de recherche.

Les moteurs de recherche agissent comme des répertoires de tous les sites Web existants mais, comme vous pouvez l’imaginer, ils doivent constamment mettre à jour leurs bases de données : il y a plus de 1,7 milliard de sites avec plus de 500 000 ajoutés chaque jour. Alors, comment un moteur de recherche sait-il qu’une page Web existe ?

- Il a déjà visité la page.

- Il suit le lien d’une page connue vers une nouvelle.

- Il traite une liste de pages dans un plan du site.

- Il suit les instructions des CMS concernant les pages nouvelles ou mises à jour.

- Il obtient les données des bureaux d’enregistrement de domaines et des fournisseurs d’hébergement.

Qu’est-ce que l’indexation ?

Après avoir trouvé une nouvelle page, un moteur de recherche analyse le contenu de la page, sa structure et sa mise en page pour la classer pour les requêtes pertinentes. Le processus pour comprendre de quoi parle cette page s’appelle l’indexation. Mieux Google ou un autre moteur comprend la page, mieux c’est pour cette page.

Quels éléments un moteur de recherche scanne pour comprendre une page :

- Sa structure globale

- Balises de titre et de description (il s’agit de balises html qui n’apparaissent pas sur la page elle-même mais qui apparaissent dans les résultats de recherche)

- Titres

- Texte

- Images (ou tout autre contenu visuel)

À la suite de ce processus, une page Web accède à l’index, qui est une base de données de tout le contenu Web. Pour maintenir ses énormes bases de données, Google, par exemple, dispose de millions de serveurs répartis dans 21 centres de données à travers le monde.

Qu’est-ce que le classement des moteurs de recherche ?

Chaque fois qu’un utilisateur tape une requête, un moteur de recherche extrait des informations de l’index, essayant de faire correspondre l’intention de recherche avec les réponses de la plus haute qualité. L’ordre des résultats affichés pour chaque requête particulière est appelé classement. Les moteurs de recherche évaluent un certain nombre de paramètres pour définir l’ordre. Ces paramètres sont appelés facteurs de classement ou signaux de classement et nous en parlerons plus tard. Les classements fluctuent tout le temps car les moteurs de recherche explorent et indexent un grand nombre de nouvelles pages Web et réindexent celles déjà existantes.

Pourquoi avez-vous besoin de référencement ?

Revenons un peu au terme SEO. Son utilisation a déjà été repérée dans les années 1990, même si à cette époque, les moteurs de recherche fonctionnaient comme des annuaires et que les sites Web ne pouvaient pas faire grand-chose pour « optimiser ». Au cours des dernières décennies, de multiples tentatives ont été faites pour renommer le référencement ou l’enterrer, mais il ne semble pas réaliste que la pratique de l’optimisation soit révolue depuis longtemps.

Les moteurs de recherche ne traitent pas seulement des tonnes de sources Web pour servir leur classement, ils s’efforcent également d’améliorer leurs algorithmes et, en fin de compte, de faire de la recherche un meilleur endroit. Les technologies innovantes remodèlent le paysage de la recherche, ajoutent de nouvelles opportunités pour les utilisateurs et apprennent à mieux comprendre les différentes recherches. Malgré le fait que le terme SEO ne dit rien sur les utilisateurs réels, la pratique du référencement consiste en fait à travailler au profit de l’utilisateur.

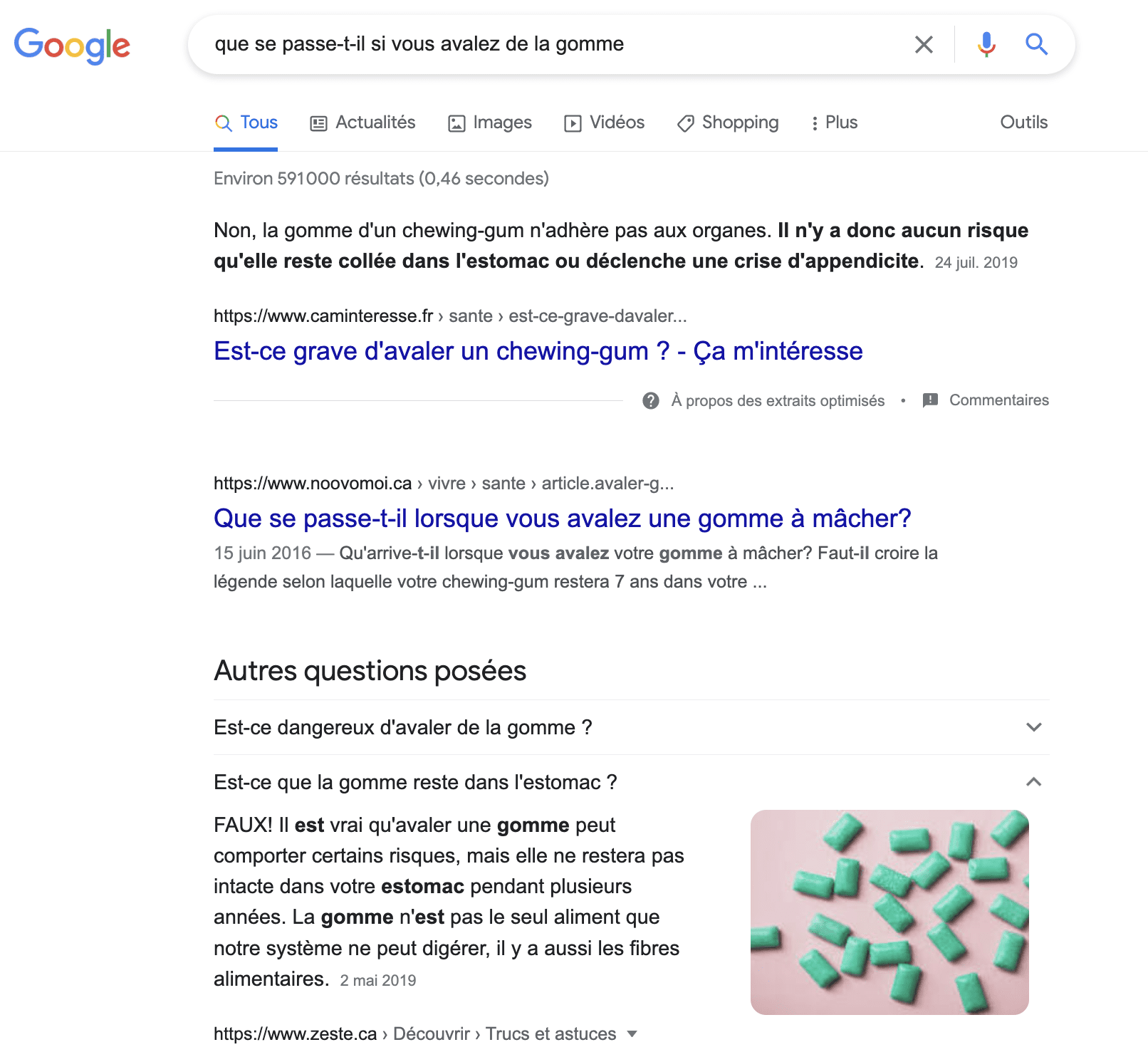

Le référencement est un outil puissant pour atteindre votre public cible. La recherche organique est le canal le plus efficace pour promouvoir un site Web. La recherche a montré qu’elle offre une opportunité de trafic 20 fois plus élevée que la recherche payante. Quels avantages l’optimisation de la recherche offre-t-elle ?

- Cibler le trafic. La recherche organique est une source principale de trafic Web et, au-delà, elle peut connecter des sites Web avec leur cible exacte. Avec un classement élevé, vous attirerez des visiteurs susceptibles d’être intéressés par votre contenu et vos produits ou services.

- Réputation en ligne. Être cité et mentionné sur différentes sources augmente le niveau de confiance que les utilisateurs accordent à votre site.

- Contrôle de la qualité du site Web. Lorsque vous faites tout ce qu’il faut pour le référencement, cela signifie que votre site Web est sécurisé, rapide, facile à utiliser et fiable, en d’autres termes, il est agréable pour les visiteurs.

- Promotion rentable. Même si le référencement nécessite un investissement financier et qu’il faut du temps pour que les résultats apparaissent, il est moins cher que les autres méthodes de marketing.

Pour attirer des visiteurs et atteindre les objectifs que vous poursuivez avec un site Web (augmenter la notoriété de la marque, les conversions, etc.), vous devrez suivre les meilleures pratiques de référencement et surveiller régulièrement les performances du site Web par rapport aux principaux paramètres de référencement.

Pour vous aider à vous faire une idée de ce que vous pouvez réaliser grâce à l’optimisation, avec nos partenaires de ThinkEngine, nous avons préparé ce chatbot interactif avec quelques faits et statistiques clés. Si ces données ne vous convaincront pas des fabuleuses possibilités du référencement, nous ne savons pas ce qui le fera ?

Qu’est-ce qui est considéré comme un facteur de classement ?

Voyons comment exactement se faire aimer par les moteurs de recherche. Les aspects des pages Web dont l’évaluation a un impact sur la position dans les SERP sont appelés facteurs de classement. Au début des moteurs de recherche, ils classaient les sites Web en fonction des paramètres du domaine, de la structure de base et des mots-clés. Si une page avait beaucoup de mots-clés cibles, elle réussirait dans la recherche. Depuis ce temps et jusqu’à maintenant, la situation a beaucoup changé. Les moteurs de recherche ont évolué pour répondre plus efficacement aux besoins des utilisateurs, repoussant les pages de mauvaise qualité et éliminant les techniques de référencement manipulatrices. Explorons les principaux signaux de classement dans le contexte des mises à jour et des améliorations des moteurs de recherche.

Dans un article d’introduction sur la façon de faire aimer un site Web par un moteur de recherche, Google cite 3 choses :

- Répondre aux intentions des utilisateurs. Un contenu de haute qualité qui donne les informations que les utilisateurs recherchent est la clé d’un classement élevé.

- Obtenir des liens à partir d’autres sites Web. Les liens placés naturellement à partir de sources externes indiquent aux moteurs de recherche qu’un site Web est fiable et contient des informations précieuses.

- Assurer l’accessibilité. Une structure logique qui n’a pas de pages orphelines ou sans issue (qui n’ont aucun lien pointant vers elles ou à partir d’elles) aide les moteurs de recherche à comprendre un site Web.

Naturellement, ces facteurs ne sont que la pointe de l’iceberg, mais à eux seuls, ils en disent long sur la réussite de la recherche : vous devez vous concentrer sur la fourniture des informations les plus utiles, le renforcement de la crédibilité et la facilité d’exploration de votre site Web. Examinons un peu plus en détail comment ces aspects et d’autres aspects essentiels auraient fonctionné plus tôt et fonctionnent maintenant.

Si vous ne souhaitez pas lire les détails sur les différents algorithmes et l’évolution de la recherche, consultez le récapitulatif des facteurs de classement pertinents pour 2021.

Quelle est l’importance du contenu d’une page Web ?

Vous avez peut-être entendu l’expression « le contenu est roi » – elle est dans la langue des spécialistes du marketing à partir de 1996, lorsque Bill Gates a exprimé sa conviction que le pouvoir du contenu était d’avoir un impact et de l’argent sur Internet. Le contenu est toujours le facteur de classement numéro un que vous trouverez mentionné dans toutes les listes de contrôle de référencement, mais la question se pose de savoir exactement comment les moteurs de recherche apprennent qu’une page contient des informations plus utiles qu’une autre page.

Au début de la recherche sur le Web, il était difficile de trouver des résultats correspondant à une requête trop abstraite ou mal formulée. Mais les gens viennent sur les moteurs de recherche sans savoir nécessairement comment formuler ce qu’ils recherchent et ils s’attendent de toute façon à voir les résultats les plus pertinents. Pour résoudre le problème de l’adaptation du système à la façon dont les gens recherchent, Google et ses concurrents ont amélioré leurs algorithmes.

À plusieurs reprises, Google a déclaré qu’il était capable de comprendre les recherches « mieux que jamais ». La première fois, il s’agissait de la mise à jour 2013 de Hummingbird. Cette mise à jour de l’algorithme a marqué le passage à la recherche sémantique, ce qui signifie que Google a compris l’intention derrière une requête et a pu distinguer les sous-thèmes liés à une requête. Le spam des pages avec des mots-clés pour une meilleure visibilité de la recherche était définitivement terminé. Ce n’est pas le nombre de correspondances exactes de mots-clés qui a été pris en compte, mais la pertinence du contenu par rapport à l’intention de recherche.

En 2019, Google a de nouveau annoncé qu’il allait révolutionner sa compréhension de la façon dont les utilisateurs recherchent. En investissant dans la recherche sur la compréhension du langage, Google a développé une nouvelle technique de traitement du langage naturel appelée BERT qui analyse le contexte autour des mots individuels. Ainsi, le moteur est capable de déchiffrer les requêtes mal orthographiées et de distiller des passages de pages Web qui répondent à des requêtes particulières, et de modifier les classements en fonction de cette analyse.

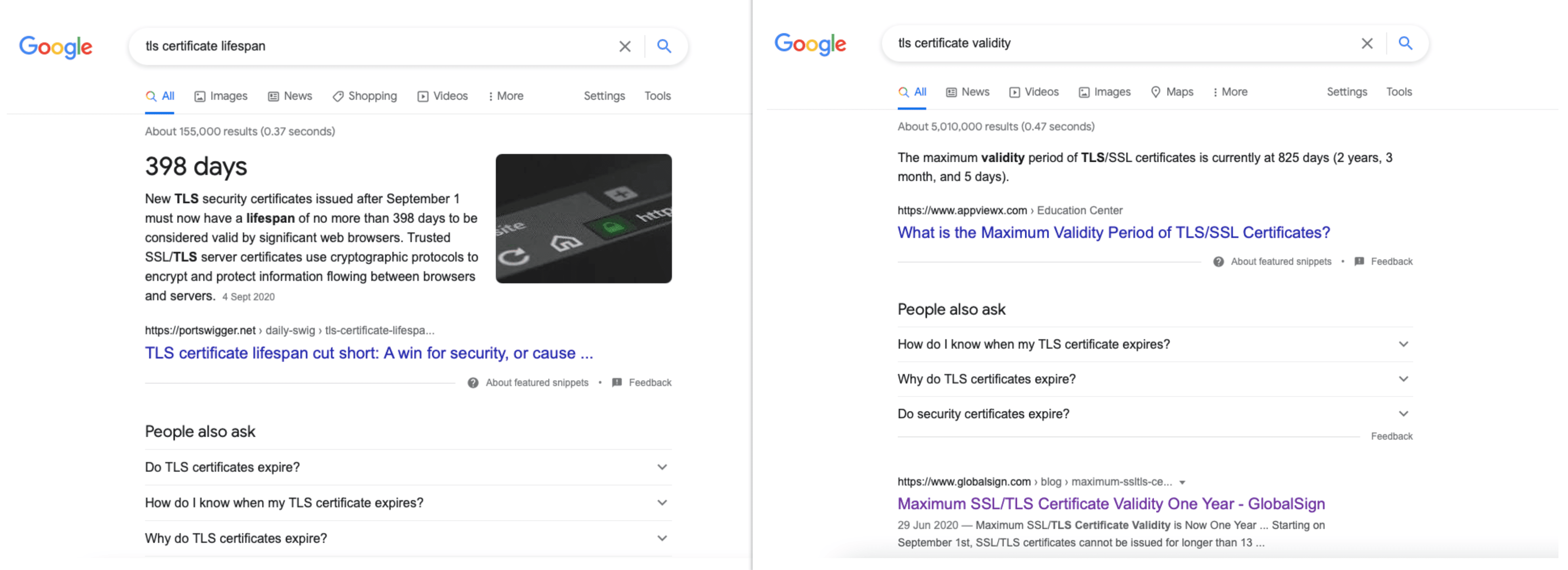

Pourtant, les algorithmes de recherche ne sont pas parfaits. Le système peut comprendre ce que vous demandez et les sujets et sous-sujets qui peuvent vous intéresser, mais vous fournir des informations obsolètes. Par exemple, lorsque j’ai tapé « durée de vie du certificat TLS » sur Google, l’extrait présenté incluait le résultat correct, mais lorsque j’ai tapé « validité du certificat TLS » signifiant trouver exactement la même réponse, le SERP a mis en évidence les informations qui ne sont plus pertinentes.

Avec tout ce qui a été dit sur l’évolution des moteurs de recherche pour faire correspondre les intentions des utilisateurs avec les meilleures réponses possibles, la tâche principale du contenu Web est d’être utile. Mais ce n’est pas la seule chose à considérer. En plus d’être pertinent par rapport aux intentions des utilisateurs, le contenu Web doit être :

- À jour. Depuis la mise à jour de 2010 sur la caféine, Google privilégie des résultats plus frais. À cet égard, il est important de mettre à jour votre contenu si quelque chose a changé dans ce que vous avez écrit. En outre, surveiller les tendances de l’industrie et transformer les dernières nouvelles en éléments de contenu peut vous permettre de gagner sur vos concurrents. Notez que la fréquence de publication de nouveau contenu n’est pas un facteur de classement, mais naturellement, si votre site Web n’obtient aucun nouveau contenu dans un laps de temps important, son classement est susceptible de baisser.

- Rédigé par des experts. Le niveau d’expertise démontré dans le contenu se traduit directement par la distribution du classement. Google propose des directives particulières appelées EAT (Expertise, Authoritativeness, and Trustworthiness) pour la crédibilité des sources Web évaluées au niveau de l’auteur, de la page et du site Web. Pour être bien perçu par rapport aux paramètres EAT, les informations sur une page doivent être exactes, l’ensemble du site Web doit être fiable et les auteurs doivent être reconnus comme des experts de l’industrie. Un autre système de qualité appelé YMYL (Your Money or Your Life) est appliqué aux recherches d’une manière ou d’une autre liées à la santé, aux détails financiers et à la sécurité. Google a besoin de la plus haute expertise des pages YMYL pour bien se classer.

- Conforme à la réglementation. Les moteurs de recherche peuvent supprimer des pages Web de l’index lorsque leur contenu enfreint les réglementations légales ou les politiques de droit d’auteur ou exploite des données personnelles (publier des informations identifiables sans le consentement de l’utilisateur).

Une autre chose à propos du contenu est sa lisibilité. Cette question est débattue depuis des années. À un moment donné, Google a même lancé le filtre de niveau de lecture pour que les utilisateurs s’en tiennent aux formats qu’ils sont susceptibles de comprendre. Cependant, la fonctionnalité n’était pas très utile et finalement, Google l’a arrêtée. De nombreux spécialistes du référencement et du marketing pensent que plus il est facile de digérer le contenu, mieux c’est pour les moteurs de recherche et les visiteurs du site Web. Le contenu doit être compréhensible à coup sûr, mais ce n’est pas considéré comme la meilleure pratique pour le rendre aussi facile à lire que possible. John Muller de Google déclare qu’il est préférable d’utiliser “la langue de votre public”, ce qui a beaucoup de sens : si vous ciblez des clients férus de technologie, par exemple, vous pouvez vous permettre d’aller jusqu’au bout des détails techniques.

Comment les backlinks participent-ils au processus de classement ?

À la fin des années 90, les analystes ont réfléchi à la manière d’intégrer la valeur des hyperliens dans le système de classement. Pour la première fois, des facteurs hors page (externes à la page elle-même) ont été utilisés. Larry Page et Sergey Brin de Google ont développé l’algorithme révolutionnaire PageRank qui comptabilise les liens pointant vers un site Web à partir d’une source externe (maintenant connu sous le nom de backlinks) en tant que « votes ». Google n’a pas été le premier moteur de recherche à considérer les liens, mais il a été le pionnier dans la création d’un algorithme fonctionnel pour évaluer les liens.

Les sites Web ont commencé à acquérir de manière agressive des backlinks et à participer à des échanges de liens, ne laissant à Google aucune chance d’arrêter les schémas de liens excessifs et de privilégier la qualité à la quantité. Maintenant, il est important de créer un profil de backlink sécurisé en obtenant des liens provenant des sources les plus fiables et en supprimant les spams. Les sites Web sont placés plus haut non pas parce qu’ils ont beaucoup de backlinks (comme c’était le cas au début des années 2000) mais parce qu’ils ont des liens pertinents provenant de pages faisant autorité.

Quelle est l’importance de la vitesse de chargement ?

En 2010, Google a annoncé que la vitesse du site est devenue un facteur de classement. Les sites Web présentant des problèmes de vitesse de chargement obtenaient des taux de rebond accrus et, par conséquent, des positions plus faibles dans les SERP. Depuis une décennie, les propriétaires de sites Web essaient de fournir aux visiteurs le chargement de page le plus rapide possible. Bien que la vitesse soit sans aucun doute un facteur important des performances du site Web, l’accent s’est récemment déplacé vers une interaction rapide avec le premier contenu rendu (au lieu de garantir un chargement rapide d’une page complète).

À partir de juin 2021, les signaux d’expérience de page de Google qui incluent Core Web Vitals influencent directement les classements. Ces signaux visent tous à améliorer l’expérience utilisateur et l’engagement avec le contenu Web. Ils incluent une navigation sécurisée, une conception adaptée aux mobiles et des mesures d’interactivité et de stabilité des pages Web. Si la première partie visible d’une page est chargée rapidement, devient rapidement possible de cliquer et ne dérange pas avec des publicités ou des fenêtres contextuelles qui modifient la mise en page, la page aura d’excellentes mesures Core Web Vitals et sera placée en haut de la recherche.

Quel rôle joue l’expérience utilisateur dans l’optimisation ?

Google utilise les données de trafic pour servir les classements, et plus les gens visitent un certain site Web, plus il est digne de confiance aux yeux de Google. Non seulement les visites de sites Web, mais l’engagement des utilisateurs avec le contenu sont pris en compte.

À partir de la mise à jour de RankBrain, Google a observé les signaux d’expérience utilisateur, évaluant la facilité d’interaction avec une page. Le moteur de recherche analyse le nombre de clics sur un résultat de recherche et le temps que les utilisateurs passent à l’explorer. Si Google apprend qu’une page Web obtient beaucoup de clics et un engagement élevé, cette page bénéficiera d’un meilleur classement. En revanche, les sites Web difficiles à naviguer et repoussant les utilisateurs vers les SERP ne sont pas susceptibles d’obtenir un classement élevé. Certains aspects de l’optimisation des pages, par exemple les balises de méta description, n’affectent pas directement les classements, mais ils ont toujours une certaine influence car ils ont un impact sur le nombre de clics qu’une page obtient des SERP.Les sites Web doivent-ils être adaptés aux mobiles ?

La recherche mobile est dominante depuis 2015 et à partir de la même année, Google a renforcé les pages qui ont une mise en page adaptée aux mobiles. En 2016, le moteur de recherche a introduit l’indexation mobile-first, ce qui signifie que l’index allait être construit principalement sur la base des versions mobiles des sites Web. Pour rester à flot, les sites Web modernes doivent offrir une expérience mobile robuste. Il est préférable d’adopter un design réactif qui ajuste la mise en page à n’importe quel appareil et taille d’écran.

Alors, quels sont les principaux facteurs de classement ?

En résumant tout ce qui précède et en ajoutant quelques paramètres de référencement qui n’ont pas changé de manière significative au fil des ans, voici les 10 aspects les plus importants qui influencent le classement du site Web :

- Métriques de domaine. L’histoire et la validité d’un domaine sont importantes pour le classement des moteurs de recherche. Google examine les dates d’enregistrement et de renouvellement, accordant plus de confiance aux domaines qui sont payés plusieurs années à l’avance. Si un domaine n’est pas tout neuf, son historique antérieur peut endommager le nouveau site Web occupant le domaine. D’un autre côté, les anciens domaines avec un historique sans pénalité peuvent avoir plus de valeur pour les moteurs de recherche, mais pas de manière significative.

- Sécurité du site. La sécurité est un aspect que vous ne voulez jamais compromettre. Google utilise un protocole HTTPS comme signal de classement depuis 2014, et d’autres moteurs de recherche privilégient également une connexion sécurisée. Si un site Web utilise un protocole HTTP ou si certaines des ressources qu’il contient sont chargées via HTTP, il existe une cryptographie obsolète ou toute autre vulnérabilité SSL/TLS qui pourrait exposer les données des utilisateurs, cela diminue le niveau de confiance et nuit au référencement.

- Optimisation mobile. Les recherches effectuées via des appareils mobiles sont dominantes depuis 2015 et continuent d’augmenter. La convivialité mobile fait partie des facteurs de classement sur tous les moteurs de recherche et votre site Web ne survivra probablement pas à la concurrence sans une version mobile fonctionnelle.

- Vitesse de chargement. La vitesse de chargement est importante pour un bon classement, mais il existe des paramètres spécifiques liés à la charge du site Web qui importent plus que la vitesse de chargement en soi. Il s’agit de Core Web Vitals qui mesurent le moment où une page Web devient accessible et interactive, ainsi que l’impact d’éventuels changements de mise en page.

- Structure du site. La disponibilité d’un plan de site correctement formaté et d’une structure de site Web complète divisée en catégories est cruciale pour un bon classement. Il est important d’être cohérent dans l’architecture du site et d’utiliser des éléments de navigation tels que le fil d’Ariane ou la table des matières.

- Teneur. Lorsque le contenu d’une page est bien structuré, bien documenté et complet pour le public cible, la page a de grandes chances de se classer parmi les premières. Les moteurs de recherche apprécient l’originalité, la qualité globale, l’utilité et la fraîcheur du contenu. En dehors du texte, ils analysent tout autre type de contenu sur les pages Web : images, gifs, vidéos, fichiers pdf. Ceux-ci doivent donc également être originaux, haute résolution et pertinents pour le contexte. Le contenu considéré comme dangereux, copié à partir d’autres sources ou qui semble être dupliqué sur un site Web envoie des signaux de classement négatifs.

- Mots clés. Différentes études montrent que les pages ont tendance à mieux performer dans la recherche qui ont un mot-clé placé au début de la balise de titre, dans l’en-tête H1 (et dans H2-H6) et dans tout le contenu de la page (en particulier dans les 100 premiers mots). En plus de cela, un mot-clé dans l’URL est un petit facteur de classement positif, et certains praticiens du référencement pensent qu’un mot-clé dans le premier mot du nom de domaine ou dans le sous-domaine peut améliorer le classement.

- Profil de backlink. Avoir des sources fiables menant à votre site Web est vital pour le référencement. Les moteurs de recherche évaluent le nombre de domaines et de pages référents, leur pertinence par rapport au contenu lié, leur qualité globale et leur âge. Lors de la création d’un profil de backlink, assurez-vous d’obtenir des liens provenant de divers sites Web, mais tous de haute qualité et liés à votre créneau. Une autre chose sur laquelle il faut attirer l’attention est le texte d’ancrage car il aide les moteurs de recherche à comprendre de quoi parle la page liée. Certaines techniques ou erreurs de création de liens peuvent entraîner une pénalisation du site Web : échange de liens excessif ; beaucoup de liens spammés ou non pertinents ; les liens partenaires payants et les liens placés par les utilisateurs non attribués respectivement comme Sponsorisé et UGC.

- Liens sur la page. Les liens que vous insérez dans le contenu du site Web ont également un impact sur le classement des moteurs de recherche. Même si les liens externes ne sont pas un signal de classement officiel, se référer à des sources faisant autorité aide à envoyer des signaux de confiance. À son tour, créer des liens vers vos propres pages permet d’établir des relations entre elles. Les liens internes permettent une exploration précise et une distribution de jus de liens sur le site Web indique aux moteurs de recherche quelles pages ont plus de valeur que d’autres. Il est important de suivre les liens : s’ils sont rompus et restent sur le site Web, ils agissent comme des signaux de classement négatifs.

- Expérience utilisateur. Les facteurs UX influencent les classements : par exemple, les algorithmes de Google évaluent le taux de clics et le pogo sticking des sites Web. Si les utilisateurs ne reviennent pas aux résultats de recherche peu de temps après avoir cliqué sur une page et passent suffisamment de temps à explorer le contenu de cette page, c’est certainement bon pour la présence dans la recherche. Les interstitiels tels que les fenêtres contextuelles et les publicités intrusives placées sur une page peuvent endommager l’expérience utilisateur et nuire au classement.

Dans quelle mesure Google est-il dominant et qu’en est-il des autres moteurs de recherche ?

L’histoire de la recherche sur le Web n’a pas commencé avec Google. Les proto-moteurs sont nés dans le milieu universitaire à partir de 1990, quand Alan Emtage a lancé Archie, un annuaire public de sites FTP. En 1994, les étudiants de l’Université de Stanford, Jerry Wang et David Filo, ont créé Yahoo. C’était un répertoire de sites Web qui se soumettaient manuellement. Certains autres moteurs de recherche ont également vu le jour cette année-là, mais ils n’ont pas eu d’impact réel.

En 1996, les étudiants de l’Université de Stanford, Larry Page et Sergey Brin, ont créé un nouveau moteur de recherche appelé Backrub, qui a finalement été renommé et enregistré sous le nom de Google. À partir de 2000, Google a alimenté les résultats de recherche de Yahoo, ce qui a marqué le début de la fin de la renommée de Yahoo.

En 1998, le monde a vu un prototype de recherche payante : le service Goto développé par l’incubateur basé à Pasadena a permis aux annonceurs de placer des enchères pour être affiché au-dessus des résultats organiques. En 2000, Google a introduit AdWords, maintenant connu sous le nom de Google Ads. Les publicités payantes et les classements organiques coexistent dans les SERP mais sont indépendants les uns des autres. En utilisant des publicités payantes dans différents moteurs de recherche, les sites Web sont présentés en fonction du montant qu’ils paient pour chaque clic, tandis que dans la recherche organique, vous ne pouvez pas payer pour être présenté ou améliorer votre classement.

Ce n’est qu’en 2009 que le plus grand rival actuel de Google a été introduit : Microsoft Live Search est devenu Bing. À l’époque, ce moteur de recherche comportait des fonctionnalités innovantes, par exemple des rubriques dédiées à différents types de recherche (achats, voyages, commerces de proximité, liés à la santé) ou un aperçu des résultats visibles au survol d’un internaute. Malgré ces fonctionnalités utiles, il ne s’est pas rapproché de Google en termes de nombre de recherches.

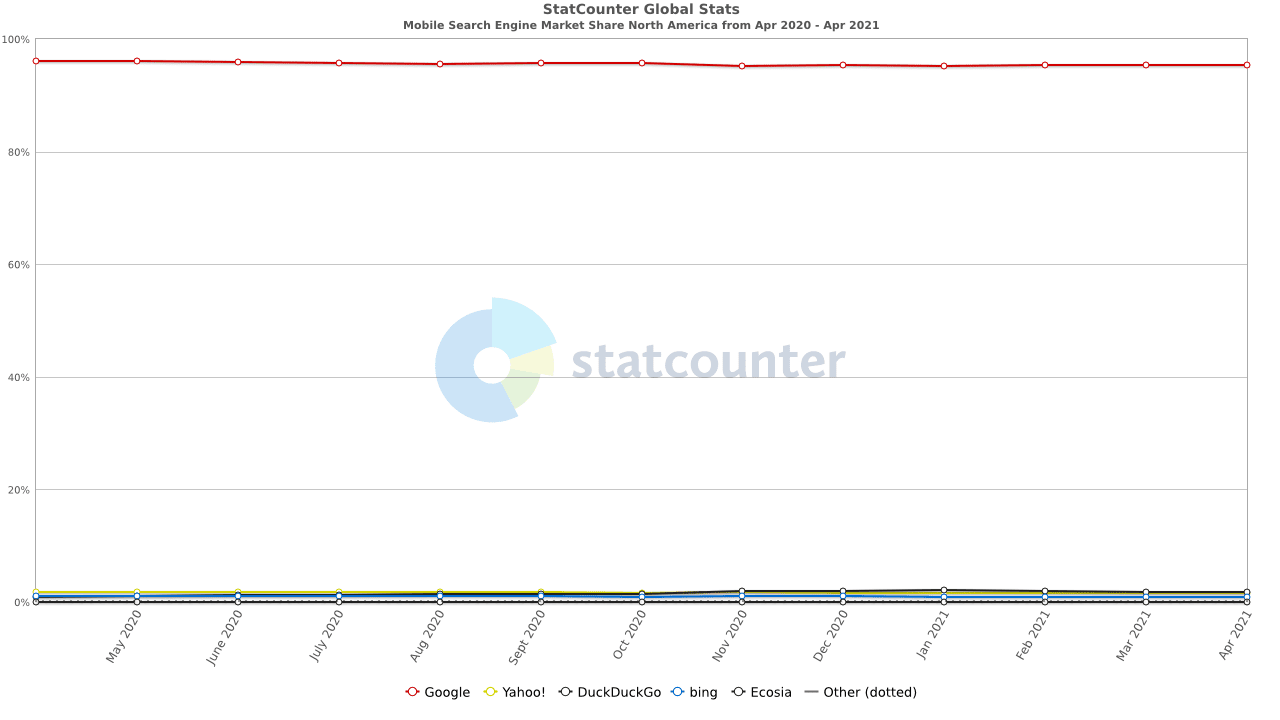

Au fil des ans et jusqu’à présent, tous les autres moteurs n’ont pas réussi à surpasser le géant de la recherche. Les statistiques de 2018 montrent qu’environ 70% de tout le trafic Web provient des moteurs de recherche, Google étant responsable de près de 60%. La comparaison des moteurs de recherche par StatCounter montre à quel point Google dépasse ses concurrents : il représente 95,8 % des recherches mobiles en Amérique du Nord (95,4 % dans le monde). Sur les ordinateurs de bureau, les utilisateurs Google leurs requêtes dans 87% des cas, Bing reçoit la part de bureau de plus de 10% en Amérique du Nord et de plus de 6% en Europe, et Yahoo et DuckDuckGo attirent environ 1 à 3% de l’attention des chercheurs.

Néanmoins, de nombreuses alternatives à Google existent et elles attirent un public qui n’est pas satisfait des politiques de Google, notamment en matière de confidentialité. DuckDuckGo est le moteur de recherche soucieux de la confidentialité le plus populaire utilisé par les personnes concernées par la quantité de leurs données suivies quotidiennement et vendues aux annonceurs. Le moteur intègre des données de plus de 400+ sources (y compris les sites participatifs et Bing et à l’exclusion de Google), tandis que son propre robot d’exploration, DuckDuckBot, fait son travail en donnant la priorité aux sites les plus sécurisés. En janvier 2021, DuckDuckGo a atteint 100 millions de recherches par jour. Ce n’est toujours pas autant que Google, Bing et Yahoo reçoivent, mais la tendance est claire : de nombreuses personnes recherchent une expérience de recherche plus privée et axée sur la sécurité.

DuckDuckGo n’est pas la seule alternative aux moteurs de recherche axés sur la confidentialité :

- StartPage n’enregistre pas les adresses IP et n’a pas de cookies, mais le fait que ses résultats proviennent de Google soulève un drapeau rouge. Sa part est assez petite par rapport aux gros moteurs de recherche : StartPage obtient 4,5 millions de recherches par jour.

- Quant ne collecte pas les données des utilisateurs et fournit les résultats recueillis auprès de Bing et de son propre robot d’exploration. Quant propose des raccourcis utiles qui fonctionnent de manière similaire aux opérateurs de Google et dispose également de sections de recherche dédiées (cartes, musique, informations scientifiques et médicales). En 2020, Quant a annoncé prendre un nouveau cap vers la monétisation et la création d’une plateforme publicitaire, générant des doutes sur son approche pro-privacy.

- Le navigateur anonyme Brave a lancé son propre moteur de recherche en 2021. Il alimente les résultats de son propre robot d’exploration et dispose du système qui analyse l’utilité des pages dans la recherche sans tracer les données spécifiques à l’utilisateur.

Le suivi des utilisateurs peut sembler être le plus gros problème avec Google et d’autres géants de la recherche, mais ce n’est pas le seul problème qui pousse les autres entreprises à créer des alternatives. Par exemple, Ecosia souhaite minimiser l’empreinte carbone en faisant fonctionner des serveurs sur des centrales solaires et en reversant 80 % de ses bénéfices à la plantation d’arbres. Ou, Swisscows, basé en Suisse, se concentre sur un contenu sûr et adapté aux familles et supprime automatiquement tout résultat violent ou explicite.

Même si les chiffres indiquent qu’il est difficile, voire impossible, de couper une partie du gâteau de Google, les entreprises prévoient toujours de conquérir la recherche avec leurs nouveaux moteurs de recherche. Le fondateur d’Ahrefs pense que son système pourra rivaliser avec Google. La vision d’Ahrefs est centrée sur deux choses : la confidentialité (qui est déjà un moteur important pour les alternatives de Google) et le partage des bénéfices (distribuer des revenus énormes sur des plateformes puissantes comme Wikipedia qui publient du contenu très populaire dans les recherches mais qui n’est pas destiné à être monétisé ). L’idée semble intrigante et un peu trop belle pour être vraie – ce qu’il en adviendra reste à voir.

C’est à vous de choisir si vous souhaitez cibler d’autres moteurs de recherche. Leurs mécanismes d’exploration et d’indexation sont à peu près les mêmes, donc si vous vous occupez du référencement de base, votre site Web sera probablement affiché dans les résultats de différents moteurs de recherche. Mais si vous savez qu’une partie de votre public cible préfère une alternative à Google, vous voudrez peut-être faire une petite recherche supplémentaire sur la façon de plaire à ce moteur de recherche particulier.

Pour résumer

Voici un bref résumé de ce dont nous avons discuté dans cet article :

- Le référencement (optimisation pour les moteurs de recherche) est une pratique consistant à afficher un site Web dans les résultats de recherche pour des requêtes d’utilisateurs particulières. Plus la position est élevée parmi les résultats, plus le trafic cible reçu par un site Web est important.

- Le référencement est la méthode la plus efficace pour promouvoir un site Web, obtenir du trafic et établir la confiance. Une stratégie de référencement solide garantit un succès à long terme pour attirer les visiteurs du site Web et les convertir en clients.

- Les moteurs de recherche répondent aux besoins des utilisateurs et évaluent les pages Web en fonction de leur utilité pour les chercheurs.

- Pour classer les pages Web, les moteurs de recherche doivent d’abord les parcourir (découvrir) et les indexer (comprendre).

- Des centaines de facteurs influencent les classements, mais plus important encore, une page Web doit donner la meilleure réponse possible à une requête d’un utilisateur. Outre la qualité et la pertinence du contenu, les paramètres cruciaux évalués par les moteurs de recherche incluent la sécurité, la structure du site, les mesures de l’expérience utilisateur et les backlinks.

- Google occupe la part du lion de toutes les recherches sur le Web, mais les sites Web peuvent également cibler des moteurs de recherche alternatifs et en tirer un trafic précieux.