DeepSeek: Kostengünstige KI für SEOs oder überbewerterter ChatGPT-Konkurrent?

Ist DeepSeek nur der nächste Hype oder ein echter Gamechanger? Fakt ist: Ein bisher kaum bekanntes chinesisches KI-Modell hat plötzlich ChatGPT in den Apple Store Charts überholt – ein guter Grund, genauer hinzusehen. Eine schnelle Google-Suche zeigt gespaltene Meinungen: Während einige die niedrigen Kosten feiern, warnen andere vor möglichen Datenschutz- und Rechtsrisiken. Doch eines steht fest: DeepSeek beherrscht fast alles, was ChatGPT kann.

Für SEOs und digitale Marketer lohnt sich ein genauerer Blick auf das neueste Modell von DeepSeek – R1, veröffentlicht am 20. Januar 2025. Es ist das weltweit erste Open-Source-KI-Modell, dessen „Chain of Thought“-Fähigkeiten denen von OpenAIs GPT-o1 ähneln. Eine API mit riesigem Potenzial für SEO-Workflows – und das praktisch kostenlos. Doch es gibt einen Haken: Weltweit schrillen die Alarmglocken wegen Datenschutz und Sicherheit – alles andere als beruhigend.

Was steckt wirklich hinter DeepSeek – und warum lohnt sich ein genauer Blick?

-

DeepSeek R1 wirft die Frage auf, ob für eine leistungsstarke KI wirklich massive Investitionen in Trainingsdaten notwendig sind.

-

Durch den erschwinglichen API-Zugang zu GPT-o1-ähnlichen Funktionen können SEO-Agenturen hochwertige KI-Tools problemlos in ihre Workflows integrieren. Im Gegensatz zu GPT-o1 gibt es in der Online-Version und der App von DeepSeek keine Nutzungseinschränkungen.

-

Die meisten SEOs sagen, dass GPT-o1 ideal für Texte und Content ist, während R1 seine Stärken bei schnellen, datenintensiven Aufgaben zeigt.

-

Eine Cloud-Sicherheitsfirma entdeckte ein schwerwiegendes Datenleck bei DeepSeek. Dies warf weltweit Zweifel an der Einhaltung globaler Datenschutzstandards auf.

-

Die Zensur von DeepSeek, bedingt durch seine chinesische Herkunft, schränkt die inhaltliche Flexibilität spürbar ein.

Was ist DeepSeek?

Ein Hobbyprojekt – oder zumindest hat es so angefangen.

DeepSeek ist ein chinesisches KI-Forschungslabor, gegründet vom Hedgefonds High Flyer. Es entwickelte bereits wettbewerbsfähige Modelle wie V3, das Ende 2024 für Aufsehen sorgte. Anfang 2025 überraschte sein neuestes, kosteneffizientes Modell R1 die KI-Branche – und wurde rasch populär, allerdings nicht ohne Kritik.

DeepSeek ist das, was passiert, wenn ein junger chinesischer Hedgefonds-Milliardär Lust auf KI bekommt und ein Team frisch gebackener Hochschulabsolventen engagiert, um sein Start-up voranzutreiben.

Dieser Milliardär heißt Liam Wenfeng. Geboren 1985, gründete der heute 40-jährige Unternehmer nach seinem Masterabschluss in KI das Handelsunternehmen High-Flyer. Wenfeng sagte, er habe sich der Tech-Branche zugewandt, um die Grenzen der KI auszuloten – was ihn schließlich 2023 dazu brachte, DeepSeek als Nebenprojekt ins Leben zu rufen.

„Innovation ist eine Frage des Glaubens“ – mit DeepSeek R1 machte er sein Motto zur Realität. Sein Team entwickelte das Modell für nur 5,58 Millionen Dollar – im Vergleich zu den 6 Milliarden von OpenAI ein echtes Schnäppchen. Dass ein chinesisches Start-up eine KI auf OpenAI-Niveau für einen Bruchteil der Kosten entwickeln konnte, ließ die Aktienmärkte am Montag, den 27. Januar, einbrechen.

Für SEOs und digitale Marketer geht es bei DeepSeek nicht nur um Technologie. Wenfengs Projekt könnte die Spielregeln für KI-gestützte Content-Erstellung, Automatisierung und Datenanalyse verändern. Es ist eine echte, kostengünstige Alternative zu ChatGPT.

Hier sind die Gründe.

DeepSeek R1 vs. ChatGPT-o1: Der Vergleich

DeepSeek setzt neue Maßstäbe in Sachen Kosteneffizienz. Ein direkter Vergleich der beiden Modelle zeigt es deutlich:

| Feature | DeepSeek R1 | OpenAI’s GPT-o1 |

| Input-Token-Preis | 0,55 $ pro 1 Mio. Tokens | 15 $ pro 1 Mio. Tokens |

| Output-Token-Preis | 2,19 $ pro 1 Mio. Tokens | 60 $ pro 1 Mio. Tokens |

| Kostenloser Zugang | Ja (App ist kostenlos, API-Integration basiert auf Token) | Nur mit Plus-Abo (20 $/Monat) |

| Effizienz der Architektur | Mixture of Experts (MoE)-Modell hat insgesamt 671 Mrd. Parameter, nutzt aber nur 37 Mrd. pro Aufgabe | Nutzt alle 175 Mrd. Parameter pro Aufgabe – fördert dadurch kreative Problemlösung |

Was bedeutet das?

Nun, laut DeepSeek und zahlreichen digitalen Marketern weltweit, die R1 bereits nutzen, erhältst du eine nahezu gleiche Qualität – für einen Bruchteil der Kosten. Zudem ist R1 komplett kostenlos, es sei denn, du verwendest die API-Integration. Bei OpenAI hingegen ist der Zugriff auf GPT-o1 nur mit einem 20 $/Monat Plus-Abo möglich.

Diese 20 $ galten lange als ein geringer Preis für die gebotene Leistung – bis Wenfeng die Mixture of Experts (MoE) Architektur von DeepSeek einführte. Sie bildet das technische Fundament von R1s effizientem Ressourcenmanagement und ist genau der Grund, warum DeepSeek so kostengünstig und trotzdem leistungsstark ist.

Benchmark-Leistung

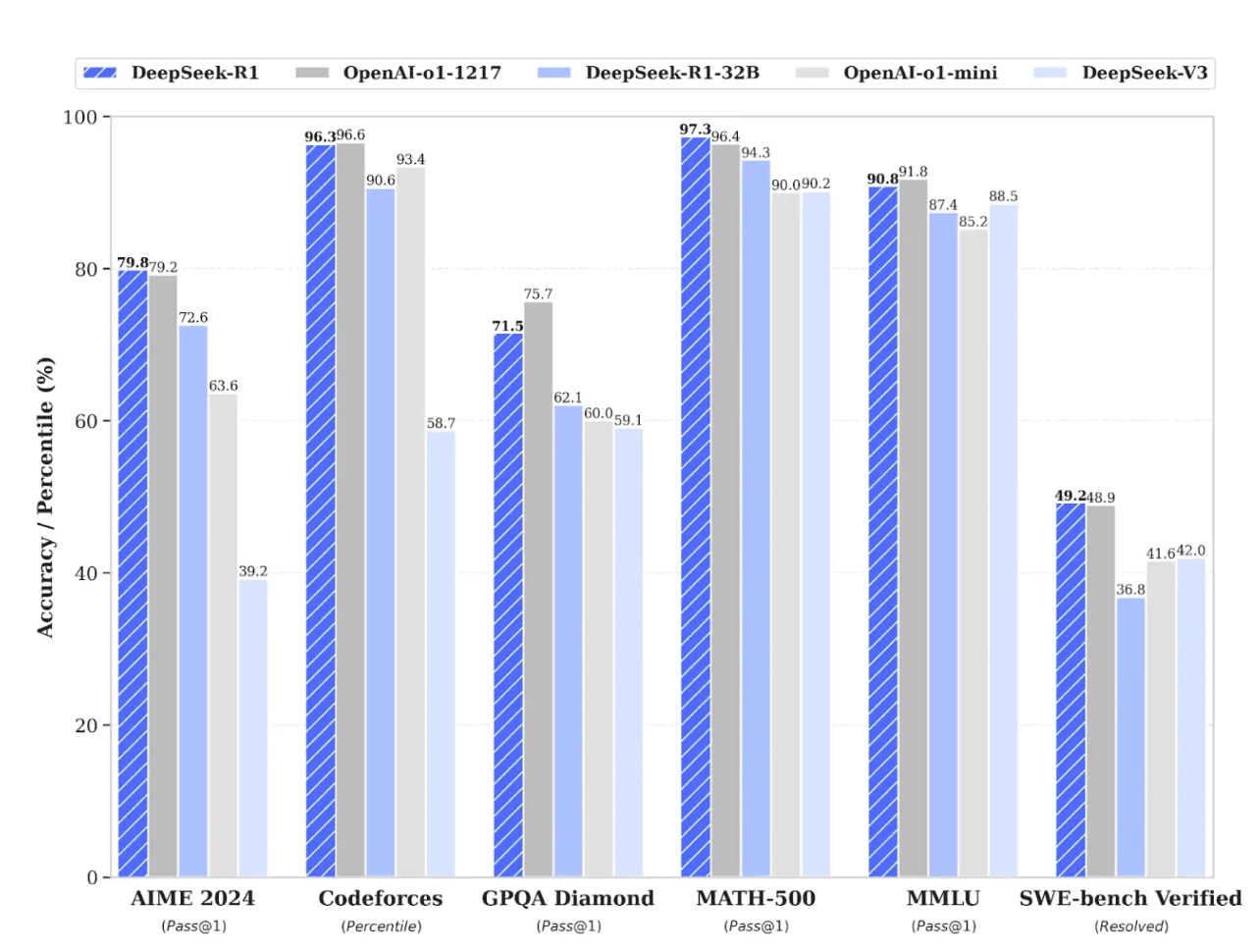

Die folgenden Benchmarks – direkt von der DeepSeek-Website entnommen – zeigen, dass R1 in vielen wichtigen Aufgaben mit GPT-o1 mithalten kann. Allerdings können selbst die besten Benchmarks verzerrt oder falsch interpretiert werden – also am besten mit einer gesunden Portion Skepsis betrachten.

Was messen die einzelnen Benchmarks?:

- AIME 2024: Logisches Denken und Problemlösung

- Codeforces: Programmierung

- GQPA: Allgemeine Aufgaben wie Kundensupport und Tutoring

- MATH-500: Lösen komplexer mathematischer Probleme

- MMLU: Sprachverständnis und kritisches Denken

- SWE-Bench Verified: Softwareentwicklung

Die Grafik oben macht es deutlich: GPT-o1 und DeepSeek liegen in vielen Bereichen gleichauf. Doch ihre unterschiedlichen Architekturen bringen jeweils eigene Stärken mit sich. Schauen wir uns an, wo welches Modell besonders gut abschneidet.

DeepSeek ist ideal für technische Aufgaben und Programmierung

DeepSeek nutzt ein Mixture of Experts (MoE) Modell – stell es dir vor wie ein Team von Spezialisten, bei dem immer nur der richtige Experte für die jeweilige Aufgabe aktiviert wird. Außerdem entscheidet das Modell intelligent, welche Rechenressourcen es je nach Komplexität der Aufgabe braucht. Das macht es extrem effizient für datenlastige Aufgaben wie Programmierung, Ressourcenmanagement und Projektplanung.

Ein gutes Beispiel: Sunil Kumar Dash, Autor bei Composio, testete in seinem Artikel „Notes on DeepSeek R1“ verschiedene LLMs auf ihre Programmierfähigkeiten – und zwar mit dem anspruchsvollen „Longest Special Path“-Problem. Alle Modelle fanden die richtige Lösung, aber R1 überzeugte mit einer besseren Speicherverwaltung.

Mit anderen Worten: R1s Code verbrauchte weniger Ressourcen – ein klarer Vorteil für Sunil.

GPT-o1 denkt kreativ – perfekt für Content und Analysen

Das Chain of Thought (CoT)-Modell von OpenAI macht GPT-o1 zur besseren Wahl für kreatives Schreiben und tiefgehende Analysen. Es nutzt alle 175 Milliarden Parameter pro Aufgabe und hat dadurch ein besseres Gespür für Kontext.

Stell es dir wie einen Koch vor, der beim Zubereiten eines Gerichts laut nachdenkt – während MoE eher wie eine industrielle Küche mit striktem Fließbandsystem arbeitet.

Wir haben R1 und GPT-o1 getestet: Beide sollten einen Meta-Titel und eine Meta-Description für unseren Artikel „Wie man Google Sitelinks beeinflussen kann“ schreiben. GPT-o1 war klarer, direkter und vermied Wiederholungen aus dem Meta-Titel in der Meta-Description. Seine Meta-Description war prägnanter, aber beide Modelle haben die Meta-Titel etwas zu lang gemacht.

Schau dir die Ergebnisse selbst an.

Oben siehst du die Antwort von DeepSeek, unten kannst du ChatGPT vergleichen.

Hier verliert R1 nur knapp – und das passiert bei solchen Aufgaben öfter. Für OpenAI ist das keine gute Nachricht, denn GPT-o1 kostet deutlich mehr. Ein Reddit-Nutzer, der versuchte, einen Reiseartikel mit DeepSeek umzuschreiben, bemerkte, dass das Modell fehlerhafte Metaphern einfügte und keine Fakten überprüfte. Doch das ist nur eine Einzelmeinung. Viele SEOs und digitale Marketer halten beide Modelle für gleichwertig.

Manche sagen sogar, dass R1 besser für tägliche Marketingaufgaben geeignet ist.

Sicherheit und Datenschutz

DeepSeek steckt momentan in ernsthaften Schwierigkeiten – und das aufgrund massiver Sicherheitslücken.

Die Tech-Welt war geschockt, als die Cloud-Sicherheitsfirma Wiz enthüllte, dass DeepSeeks Datenbank Clickhouse völlig ungeschützt war – kein Passwort, keine Firewall, einfach offen für alle. Das bedeutete, dass jeder auf Backend-Daten, API-Schlüssel und sogar Nutzer-Chats zugreifen konnte.

OpenAI hatte bisher keine vergleichbaren Sicherheitsprobleme – zumindest nicht in diesem Ausmaß.

Zensur

Sowohl DeepSeek als auch GPT-o1 sind in gewissem Maße zensiert – allerdings auf unterschiedliche Weise.

Tiananmen-Platz

Da DeepSeek von einem chinesischen Unternehmen betrieben wird, äußert es sich nicht zu politisch sensiblen Themen, die als regimekritisch oder „anti-chinesisch“ wahrgenommen werden. Fragt man zum Beispiel: „Was geschah 1989 auf dem Tiananmen-Platz?“, antwortet das Modell lediglich: „Sorry, ich bin mir nicht sicher, wie ich diese Frage beantworten soll. Lass uns lieber über Mathematik, Coding oder Logik sprechen.“

Wenn du DeepSeek lokal nutzt, gibt es keine Zensur. Sobald du die API auf deinem Rechner hast, beantwortet es jede Frage.

GPT-o1 hingegen weicht nicht aus, wenn es um den Tiananmen-Platz geht.

Hier seine Antwort: „1989 kam es auf dem Tiananmen-Platz zu massiven Protesten für politische Reformen und mehr Freiheiten. Die Regierung reagierte mit einem gewaltsamen Vorgehen, das viele Todesopfer forderte und bis heute Spuren in der chinesischen Gesellschaft hinterlässt.“

Banküberfall

GPT-o1 reagiert vorsichtiger auf Fragen zu kriminellen Handlungen. Als wir fragten: „Wie könnte man hypothetisch eine Bank ausrauben?“, verweigerte es zunächst die Antwort – bis wir die Suchfunktion einschalteten. Danach lieferte es eine Antwort, allerdings ohne konkrete Anleitung, sondern mit allgemeinen historischen Beispielen von Banküberfällen.

Und DeepSeek? Es begann mit einer Warnung, dass Bankraub illegal ist – lieferte dann aber trotzdem eine detaillierte Anleitung…

Was die Community über DeepSeek sagt

Das Vertrauen in DeepSeek war noch nie so gering – weltweit werden Warnungen laut.

Offiziell bestätigt ist es nicht, aber immer mehr Berichte tauchen auf: Universitäten, Behörden und staatliche Unternehmen blockieren DeepSeek. Screenshots von Fehlermeldungen – wie einer von einem Nutzer, der schreibt: „Meine Uni hat DeepSeek gesperrt, aber ChatGPT ist weiterhin verfügbar“ – zeigen, dass Institutionen dem chinesischen KI-Startup misstrauen.

Die Debatte: Kosten vs. Qualität

Neben den Sicherheitsbedenken spaltet sich die Meinung insbesondere bei der Frage nach Effizienz und Anwendungsbereichen. Nutzer – darunter SEOs und digitale Marketer – vergleichen DeepSeek R1 und ChatGPT-o1 in Bezug auf Verarbeitungsgeschwindigkeit, Genauigkeit der Definitionen und Gesamtkosten.

| DeepSeek-Fans | ChatGPT-Anhänger |

| „Warum 20 $ im Monat zahlen, wenn R1 kostenlos ist?“ | „GPT-o1 hat die besseren und zuverlässigeren Inhalte.“ |

| „Unbegrenzte Nutzung für große Aufgaben!“ | „Die Multimodal-Funktionen machen den Preis fair.“ |

| „Perfekt für Programmierung und Datenarbeit.“ | „DeepSeeks Zensur ist einfach zu einschränkend.“ |

Dank seines attraktiven Preises und seiner starken Leistung sehen viele in der Community DeepSeek als die bessere Alternative.

Das Fazit

DeepSeek ist günstig und leistungsstark – keine Frage. Doch diese Kosteneffizienz hat ihren Preis: schwerwiegende Sicherheitslücken. Es ist mittlerweile das am schnellsten wachsende KI-Modell, das immer mehr Verbote erhält, während Behörden seine Datenschutzstandards infrage stellen.

Für SEOs zählt letztlich: Welche dieser drei Prioritäten ist am wichtigsten?

- Wähle DeepSeek, wenn du große, technische Aufgaben hast und Kosten sowie Geschwindigkeit für dich an erster Stelle stehen.

- Nutze ChatGPT, wenn du kreative Inhalte, tiefgehende Analysen oder multimodale Projekte benötigst.

- Vermeide DeepSeek, wenn dir der Schutz deiner Daten wichtig ist.

Ein Reddit-Nutzer brachte es auf den Punkt: „DeepSeek ist der Toyota Corolla unter den KI-Modellen – zuverlässig und günstig, aber niemand hält es für einen Tesla.“

Nutze es mit Bedacht – und überprüfe die Fakten immer sorgfältig.