ChatGPT vs Perplexity vs Google vs Bing: Welche KI-Suchmaschine liefert die besten Antworten?

KI-Suchmaschinen werden immer populärer, doch nicht alle liefern gleich gute Ergebnisse. Während ständig neue Modelle auf den Markt kommen, bleiben Qualität und Verlässlichkeit zentrale Themen.

In unserem Vergleich haben wir untersucht, wie sich ChatGPT mit aktivierter Suchfunktion (früher bekannt als SearchGPT), Perplexity, Googles AI Overviews (AIOs) und Bing Search AI mit Copilot schlagen. Dabei haben wir Gemeinsamkeiten und Unterschiede in den Antworten analysiert und geprüft, wie die jeweiligen KI-Suchmaschinen ihre Quellen auswählen und zitieren.

Wichtiger Hinweis: Die Analyse basiert auf englischsprachigen Suchanfragen in den USA und spiegelt nicht zwangsläufig die Ergebnisse für deutschsprachige Suchmärkte wie Deutschland, Österreich oder die Schweiz wider. Dennoch bietet sie wertvolle Einblicke und eine gute Grundlage, um die Funktionsweise der verschiedenen KI-Systeme und -Tools besser zu verstehen.

Datenbasis der Analyse:

- Keywords: 2.000 Keywords aus 20 Branchen (jeweils 100 pro Branche)

- Region: USA

- Zeitraum: 26. Februar 2025 bis 3. März 2025

Antwortquote der Tools im Test:

- Perplexity: 1.999 Antworten (99,95 %)

- ChatGPT: 1.998 Antworten (99,90 %)

- Bing Copilot: 1.452 Antworten (72,60 %)

- Google AI Overviews: 1.163 Antworten (58,15 %)

Weitere Details zu unserer Methodik findest du am Ende dieses Artikels.

Diese Erkenntnisse sollen SEO-Profis und Content-Ersteller dabei helfen, ihre Strategien gezielt auf die jeweiligen Stärken und Besonderheiten der einzelnen KI-Suchtools im Bereich SEO auszurichten.

Kommen wir nun zu den Ergebnissen der Untersuchung.

-

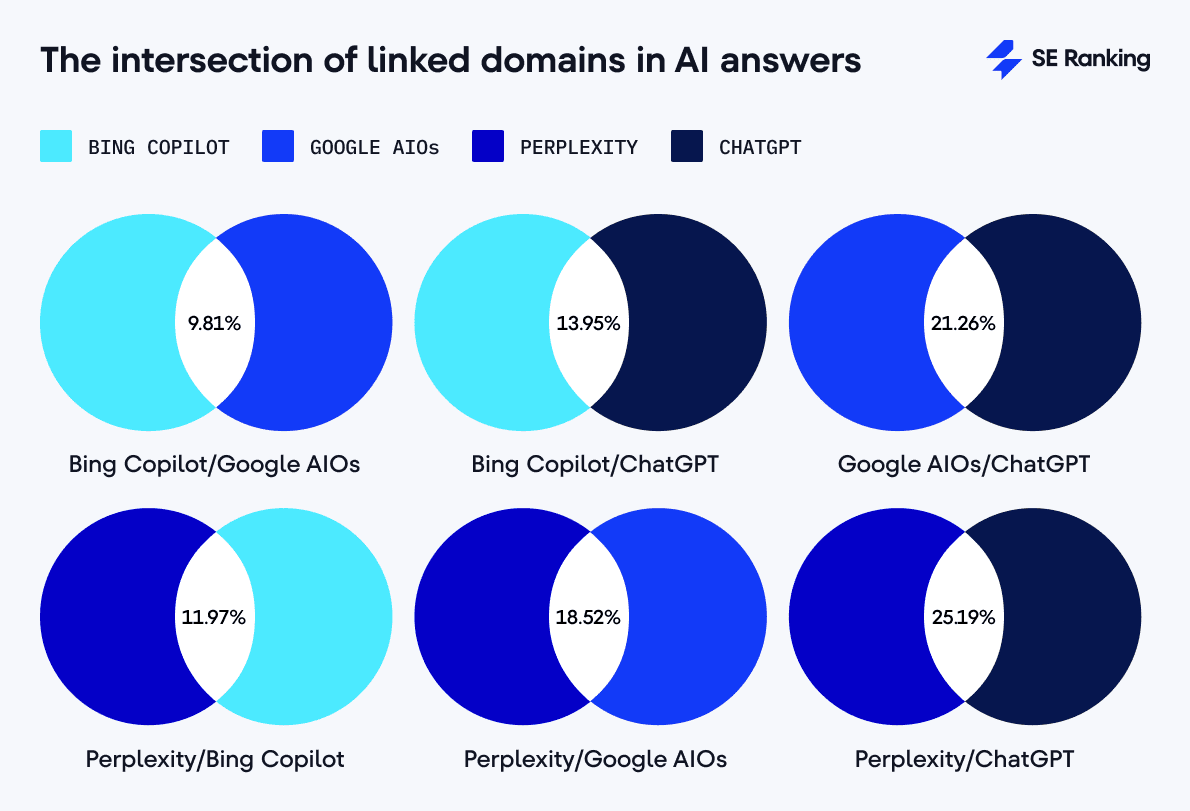

Perplexity und ChatGPT weisen mit 25,19 % die höchste Überschneidung bei referenzierten Domains auf. Auch zwischen Google AIO und ChatGPT besteht mit 21,26 % eine hohe Übereinstimmung. Die geringste Schnittmenge zeigt Bing Copilot: 9,81 % Überschneidung mit Google AIO, 11,97 % mit Perplexity und 13,95 % mit ChatGPT.

-

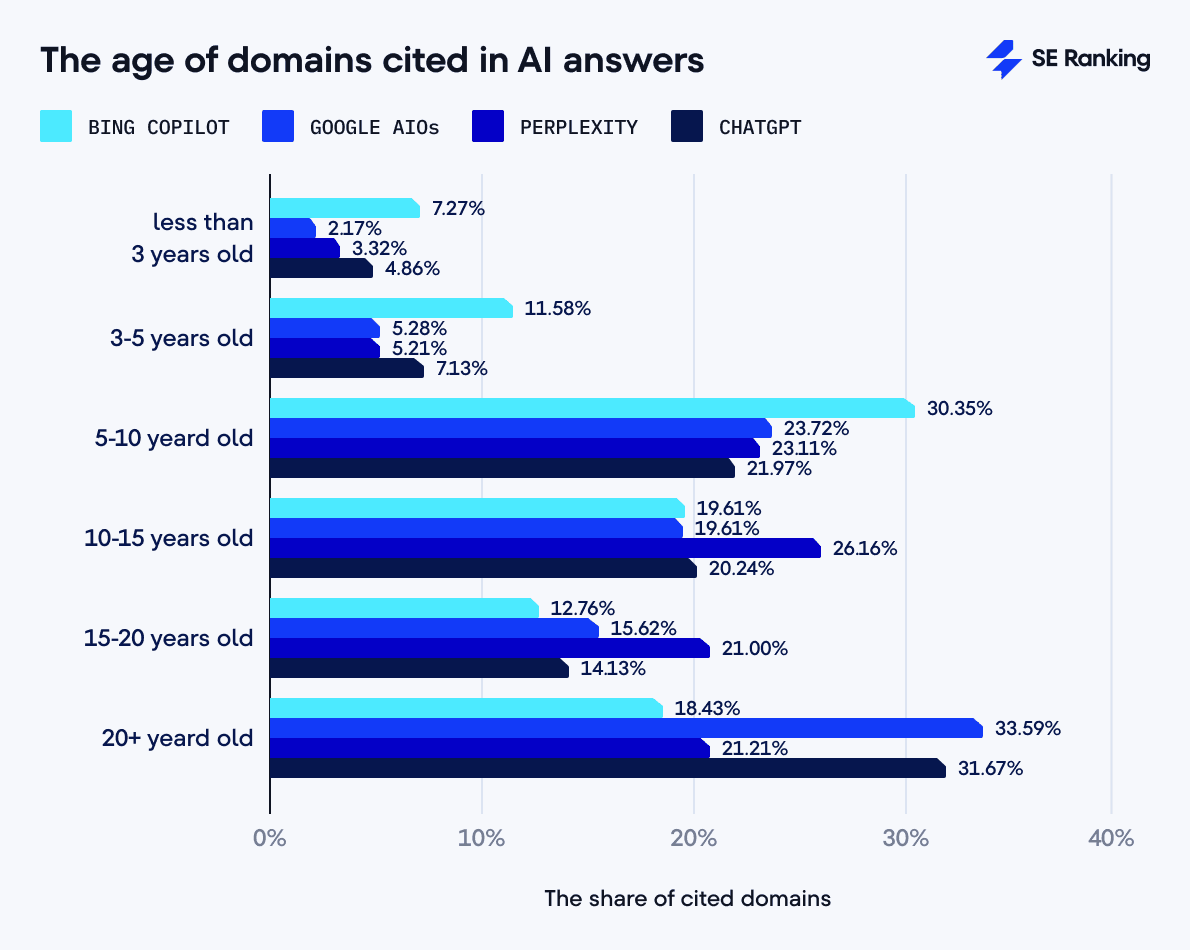

Bing Copilot verweist häufig auf jüngere Domains (unter 5 Jahren, 18,85 %), während Google AIOs am meisten ältere Domains zitieren (über 15 Jahre, 49,21 %). ChatGPT bevorzugt ältere Domains (45,8 % über 15 Jahre), nutzt aber auch viele neue Quellen (11,99 % unter 5 Jahren). Perplexity zitiert überwiegend Domains im Alter von 10 bis 15 Jahren (26,16 %).

-

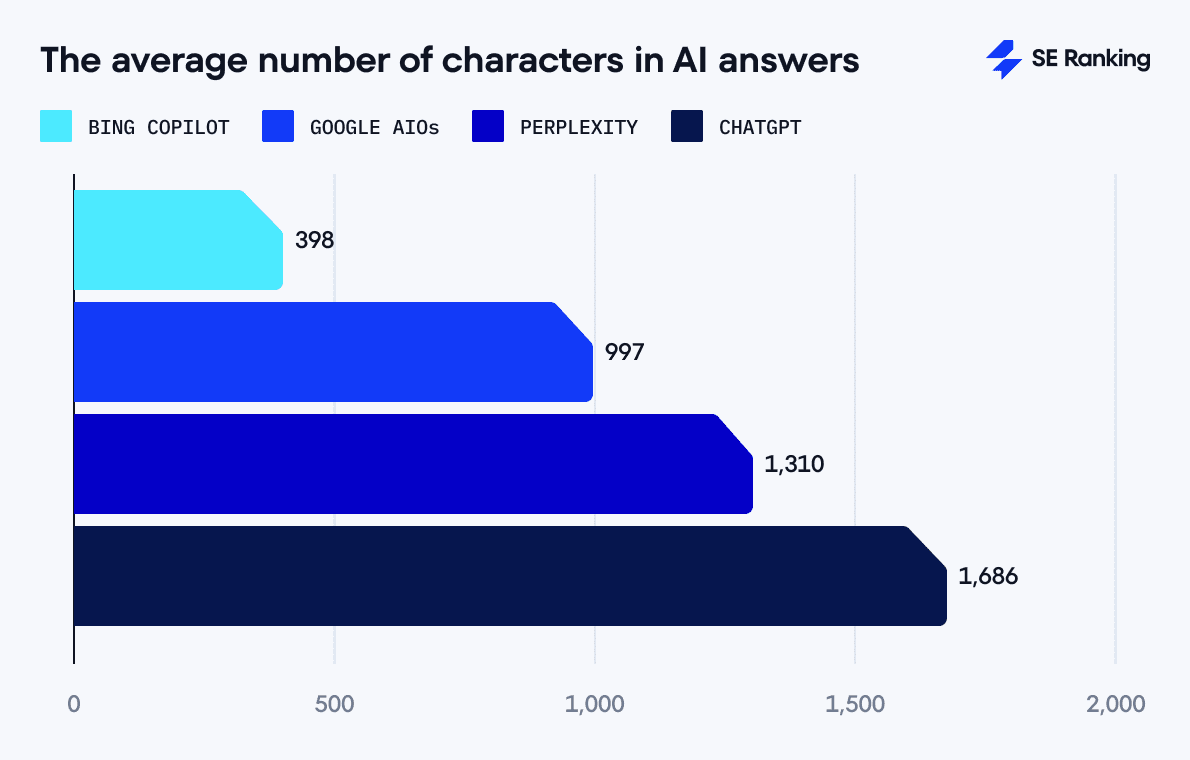

Bing Copilot liefert mit durchschnittlich 398 Zeichen die kürzesten Antworten, die einen mittleren Subjektivitätswert von 0,45 aufweisen. Mit 3,13 Links pro Antwort enthält Bing zudem die wenigsten Quellenverweise. Inhaltlich unterscheiden sich die Antworten moderat von Perplexity (0,57) und ChatGPT (0,56).

-

Die Antworten von Google AIO sind durchschnittlich lang (997 Zeichen), nutzen eine moderat subjektive Sprache (0,48) und stützen sich mit 9,26 Links stark auf externe Quellen. Inhaltlich sind sie mit einer semantischen Ähnlichkeit von 0,48 am wenigsten vergleichbar mit anderen KI-Suchmaschinen.

-

Perplexity erzeugt mittellange Antworten (1.310 Zeichen), wiederholt aber oft Informationen und zeigt mit 0,50 den höchsten Subjektivitätswert. Mit durchschnittlich 5,01 Links pro Antwort ist sein Zitierverhalten am konstantesten.

-

ChatGPT liefert die längsten Antworten (1.686 Zeichen) und weist den sachlichsten Stil auf (0,44). Mit durchschnittlich 10,42 Links pro Antwort verweist es am häufigsten auf externe Quellen.

-

Perplexity und ChatGPT ähneln sich in Antwortlänge, Stil und Inhalt besonders stark (semantische Übereinstimmung 0,82). Beide verlinken häufig auf Seiten mit geringem Traffic: bei Perplexity in 44,88 %, bei ChatGPT in 47,31 % der Fälle.

-

YouTube ist die meistverlinkte Website in Antworten von ChatGPT (11,30 %), Perplexity (11,11 %) und Google AIOs (6,31 %). Bing Copilot verweist dagegen nur in 0,86 % der Fälle auf YouTube, nennt stattdessen am häufigsten WikiHow (6,33 %).

Disclaimer:

Diese Analyse untersucht, wie die KI-Suchmaschinen Google AI Overviews, Bing Copilot, ChatGPT und Perplexity (jeweils mit aktivierter Suche) auf Suchanfragen reagieren und nach welchen Kriterien sie ihre Quellen auswählen.

Zu beachten ist, dass die Ergebnisse von Faktoren wie Keyword-Auswahl und Analysezeitraum abhängen. Die Datenerhebung fand vor Abschluss des Google Core Updates statt; seitdem erscheinen Google-AIO-Antworten bei rund 80 % der Suchanfragen.

Die dargestellten Erkenntnisse spiegeln unsere Auswertung wider, andere, ebenso valide Schlussfolgerungen sind möglich.

Quellenanalyse: Linkanzahl, zitierte Websites, Domain-Überschneidungen und mehr

Anzahl der Links in KI-Antworten

Die vier getesteten KI-Tools unterscheiden sich deutlich in der durchschnittlichen Anzahl der enthaltenen Links:

- ChatGPT: 10,42 Links pro Antwort – der höchste Wert, was auf besonders gut belegte Inhalte hinweist.

- Google AIOs: 9,26 Links pro Antwort – auch Google stützt seine Antworten stark auf externe Quellen.

- Perplexity: 5,01 Links pro Antwort – Perplexity untermauert seine Aussagen in moderatem Umfang mit Referenzen.

- Bing Copilot: 3,13 Links pro Antwort – Bing verwendet die wenigsten Quellen und liefert zudem die kürzesten Antworten (durchschnittlich 398 Zeichen).

ChatGPT (1.686 Zeichen) liefert die längsten Antworten und die meisten Links, Bing (398 Zeichen) die kürzesten Antworten mit den wenigsten Links. Bei Google AIOs und Perplexity trifft das jedoch nicht zu: AIOs sind kürzer (977 Zeichen), setzen aber fast doppelt so viele Verweise wie Perplexity (9,26 vs. 5,01).

Detaillierte Informationen zur Länge der KI-Antworten findest du später in dieser Studie im Abschnitt „Inhaltsanalyse“.

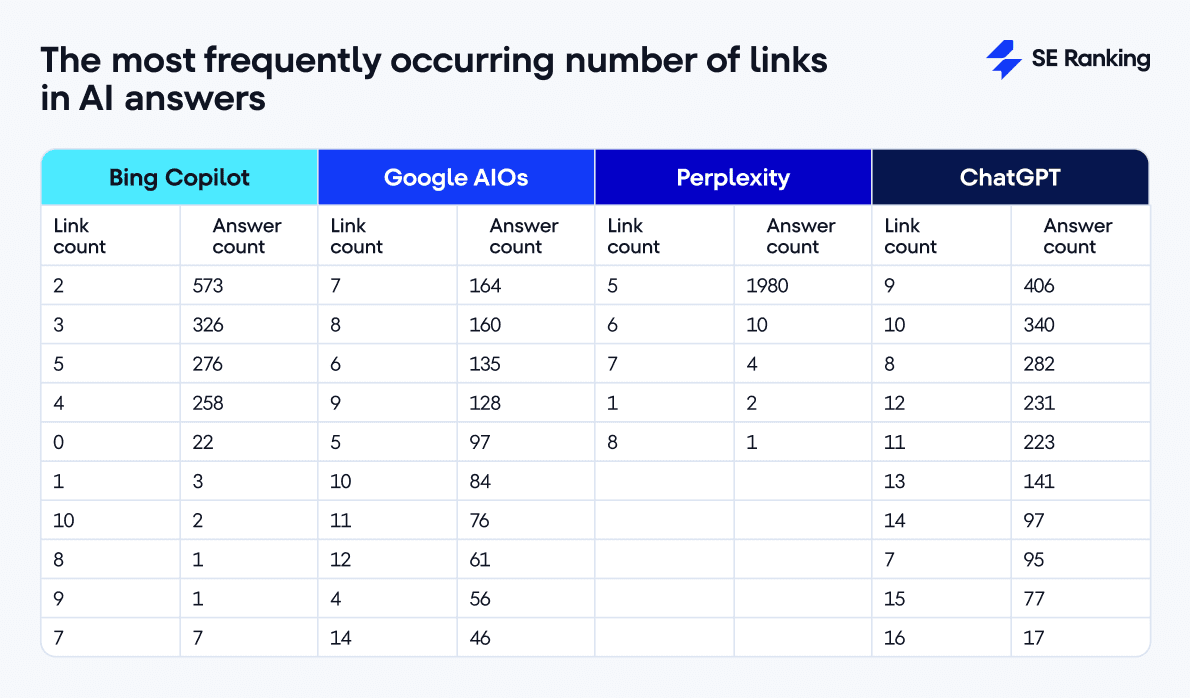

Die am häufigsten vorkommende Linkanzahl in KI-Antworten

Bing Copilot verfolgt einen minimalistischen Ansatz bei der Quellenangabe. Meist verwendet es 2 Links (573 Fälle), gefolgt von 3 (326 Fälle) und 5 Links (276 Fälle). In 22 Fällen wurden gar keine Links angegeben, vermutlich basieren diese Antworten nur auf dem internen Wissensbestand. Bing bevorzugt kompakte Antworten mit wenigen Quellen.

Google AIO zeigt eine breitere Verteilung: Am häufigsten kommen 7 Quellen (164 Fälle), gefolgt von 8 (160 Fälle) und 6 Links (135 Fälle) vor. Google verwendet deutlich mehr Quellen als Bing, was auf eine detailliertere Absicherung hinweist.

ChatGPT nennt am häufigsten 9 Links (406 Fälle), dann 10 (340 Fälle) und 8 Links (282 Fälle). Teilweise werden bis zu 24 Links pro Antwort angegeben. Das zeigt den Hang zu umfassenden, gut belegten Antworten.

Perplexity weist die homogenste Verteilung auf: In 1.980 Fällen enthielten Antworten exakt 5 Quellen. Das deutet auf eine klar definierte Zitierstrategie hin, im Gegensatz zu den variableren Ansätzen der anderen Tools.

Traffic, Keywords, Backlinks und verweisende Domains der in KI-Antworten zitierten URLs

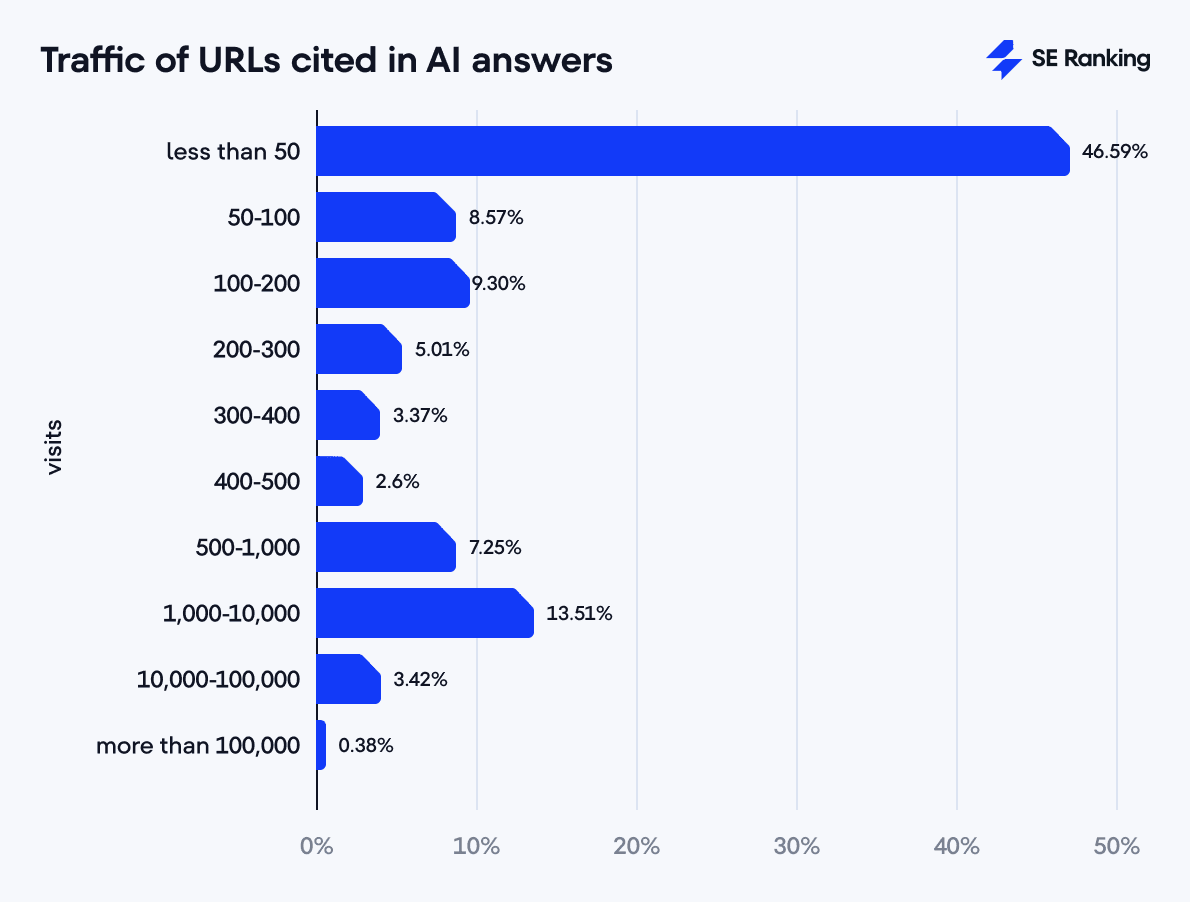

Wir haben die in KI-Antworten genannten Quellenlinks mithilfe der SE Ranking Wettbewerbsanalyse-Tools analysiert. Von 46.299 Links lagen uns für 33.508 URLs (72,37 %) Daten zum organischen Traffic vor. Davon erhalten 29.271 URLs (87,34 %) Traffic über die reguläre Google-Suche, während 4.237 URLs (12,64 %) keinen Google-Traffic verzeichnen.

Fast die Hälfte der Links (15.613 URLs, 46,59 %) erzielt nur sehr wenig Traffic (0–50 Besuche), darunter 4.237 URLs ohne Traffic. 13,51 % der URLs haben zwischen 1.000 und 10.000 Besuche, und nur 0,38 % erreichen über 100.000 Besuche.

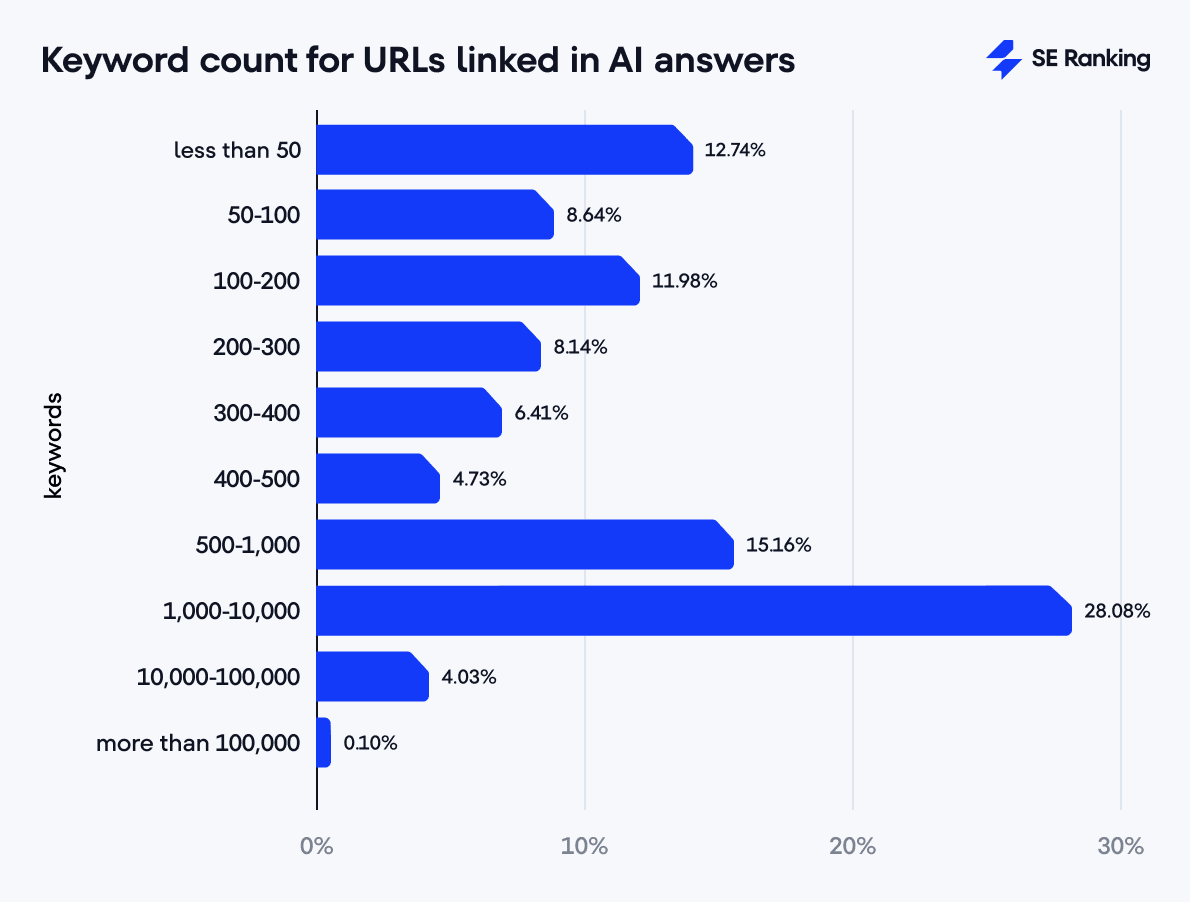

28,08 % der URLs ranken für 1.000 bis 10.000 Keywords, 12,74 % hingegen nur für wenige Keywords (0–50), meist hochspezialisierten Content.

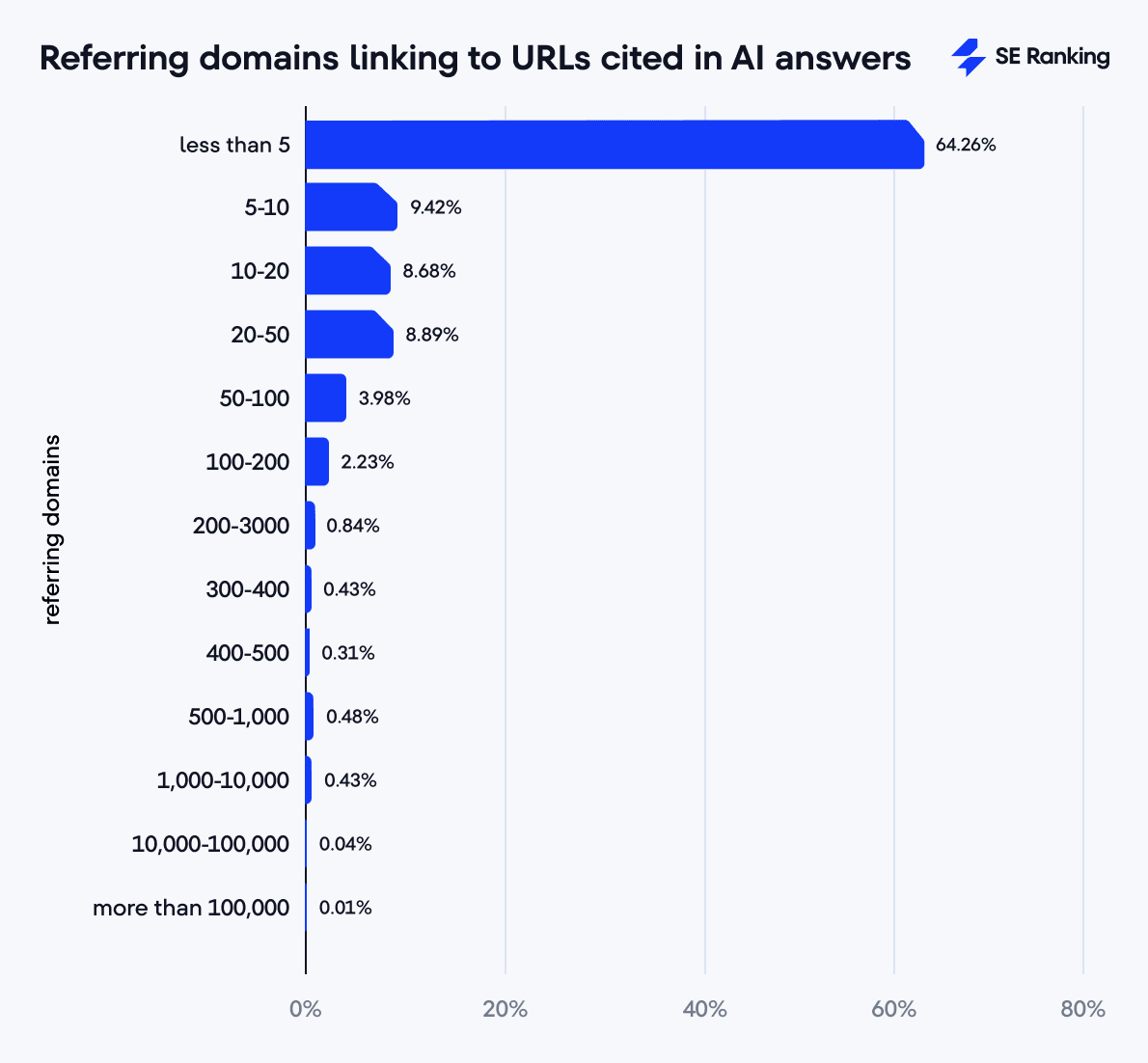

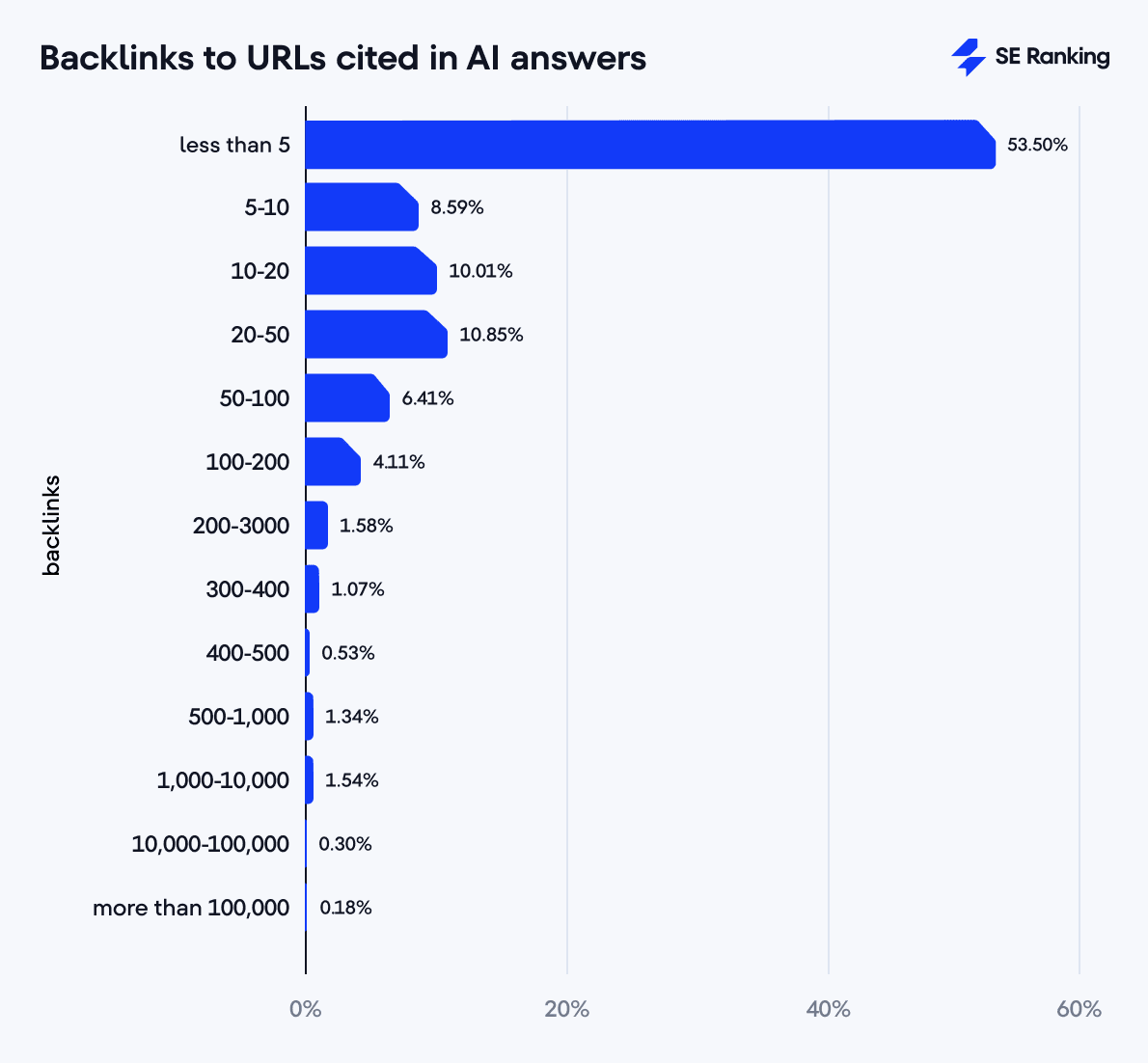

Die Daten unseres Backlink Checkers zeigen, dass die Mehrheit der URLs (64,26 %) über höchstens 5 verweisende Domains verfügt. Das ist plausibel, da die ausgewählten Keywords häufig informationsorientierte Inhalte wie Blogbeiträge auslösen. Die meisten verlinkten Seiten erhalten zudem nur wenig Traffic. Ein weiterer nennenswerter Anteil (27 %) der URLs hat zwischen 5 und 50 verweisenden Domains.

Die Backlink-Verteilung zeigt ein ähnliches Muster: 53,50 % der URLs verfügen über 0 bis 5 Backlinks, 29,45 % über 5 bis 50 Backlinks. Dabei ist zu beachten, dass nur für 75,67 % aller analysierten URLs (35.043 von 46.299) Daten zu Backlinks und verweisenden Domains vorliegen.

Die meisten zitierten URLs erhalten organischen Google-Traffic, oft jedoch in begrenztem Umfang. Dies deutet darauf hin, dass KI-Suchmaschinen sowohl bekannte als auch weniger populäre Quellen nutzen und dabei eher auf Relevanz als auf klassische SEO-Kennzahlen setzen. Gleichzeitig könnte unser Keyword-Sample die Ergebnisse beeinflusst haben.

Zudem zeigt sich eine bimodale Verteilung: Eine kleine Gruppe „elitärer“ URLs mit hohem Traffic, vielen Keywords und Backlinks steht einer deutlich größeren Gruppe mit eher schwacher Performance gegenüber.

Traffic, Keywords, Backlinks und verweisende Domains der von ChatGPT und Perplexity zitierten URLs

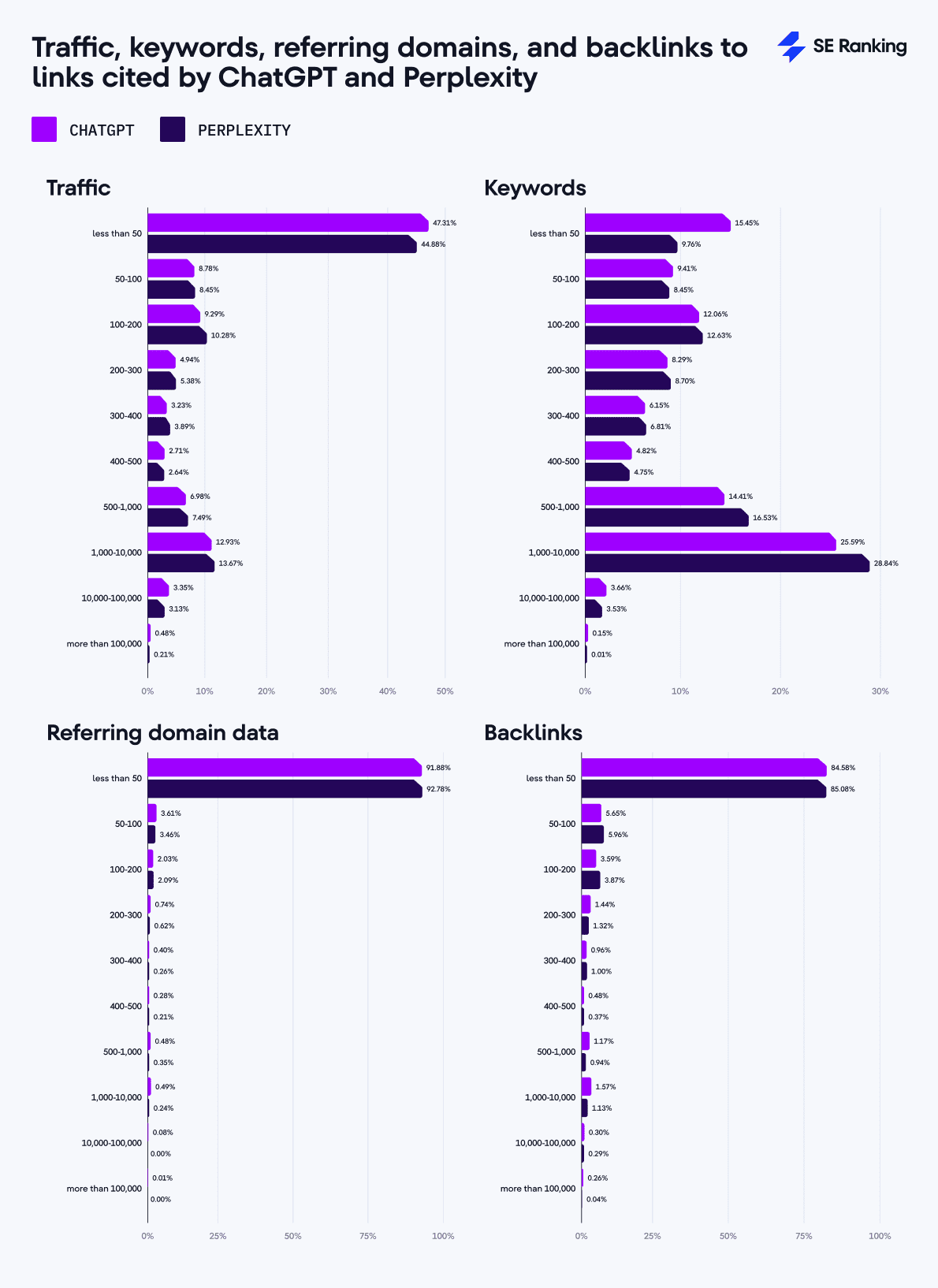

Laut unserem Datensatz hat ChatGPT insgesamt 20.811 Links referenziert. Für 15.520 dieser Links (74,57 %) liegen uns Traffic-Daten vor. Von diesen erhalten 13.564 URLs (87,40 %) organischen Traffic über die Google-Suche.

Der größte Anteil der verlinkten Seiten (47,31 %) verzeichnet nur minimalen Traffic bis zu 50 Besuche. Seiten mit sehr hohem Traffic (über 100.000 Besuche) machen lediglich 0,48 % aus.

Bezüglich der Keywords, für die diese Seiten bei Google ranken:

- 15,45 % ranken für bis zu 50 Keywords

- 25,59 % ranken für 1.000 bis 10.000 Keywords

- Nur 0,15 % ranken für über 100.000 Keywords

Bei Perplexity ergibt sich ein ähnliches Bild: Insgesamt wurden 9.999 Links referenziert, von denen für 6.714 (67,15 %) Traffic-Daten vorliegen. Davon verzeichnen 6.022 URLs (89,69 %) organischen Traffic über Google.

Auch hier hat der Großteil der verlinkten Seiten (44,88 %) nur sehr wenig Traffic.

Bezüglich des Keyword-Rankings:

- 9,76 % der Seiten ranken für bis zu 50 Keywords

- 28,84 % für 1.000 bis 10.000 Keywords

- Nur 0,01 % ranken für mehr als 100.000 Keywords

1.956 URLs (12,60 %), die von ChatGPT zitiert wurden, und 692 Links (10,30 %) aus Perplexity-Antworten erhalten keinen Google-Traffic, obwohl beide KI-Suchmaschinen diese Seiten als relevant einstufen. Das deutet darauf hin, dass KI-Suchmaschinen nützliche Inhalte identifizieren, die von herkömmlichen Suchmaschinen oft übersehen werden.

Beide KI-Systeme greifen häufig auf Seiten mit nur wenigen verweisenden Domains zurück: 92,78 % der von Perplexity zitierten Seiten und 91,88 % der von ChatGPT referenzierten Seiten haben weniger als 50 verweisende Domains.

Top-verlinkte Websites in KI-Antworten

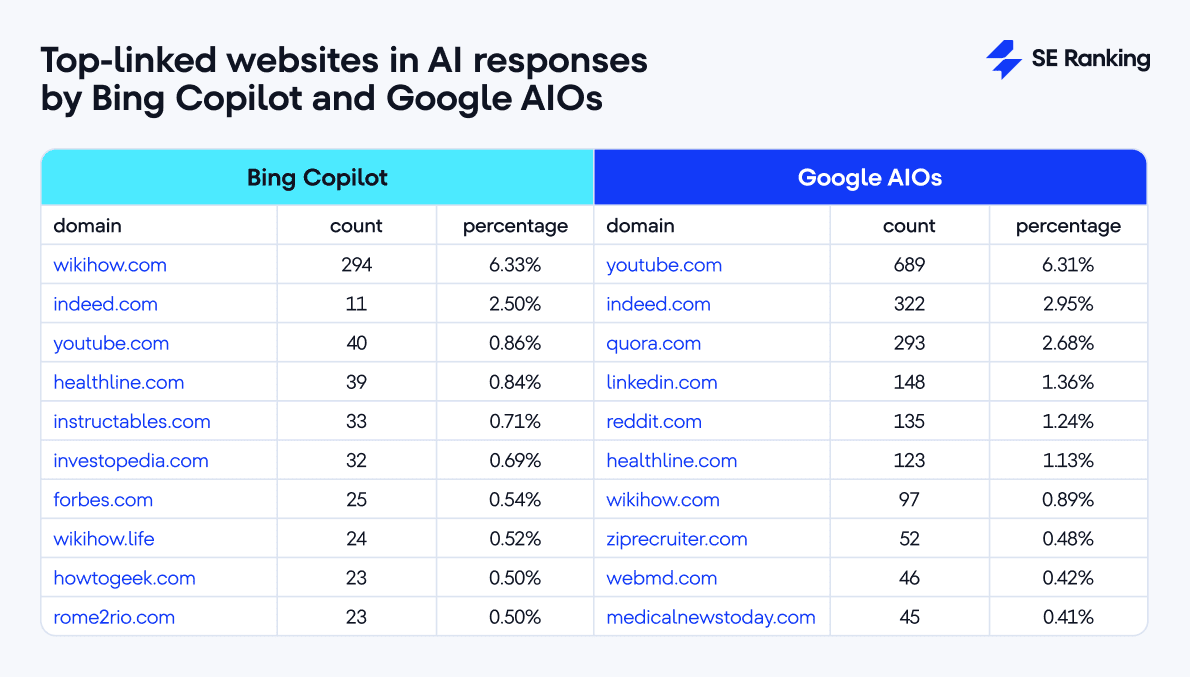

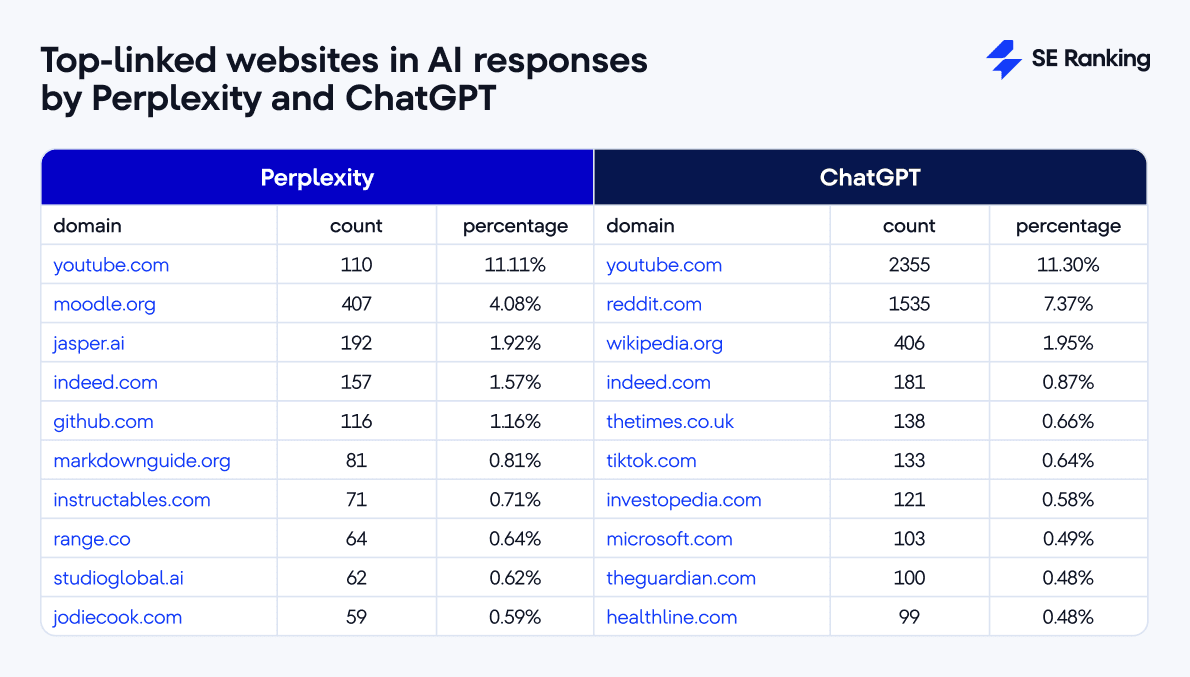

YouTube dominiert bei ChatGPT (11,3 %), Perplexity (11,11 %) und Google AIOs (6,31 %). Diese Plattformen bevorzugen Videoinhalte als unterstützendes Material. Bing Copilot verlinkt dagegen nur in 0,86 % der Fälle auf YouTube.

Bing Copilot verweist am häufigsten auf WikiHow (6,33 %), was zu seiner Strategie praktischer Schritt-für-Schritt-Anleitungen passt. Zudem verlinken Bing und Google AIOs oft auf Indeed (2,5 %) für Job- und Karrierethemen.

Google AIO ist die einzige Plattform mit LinkedIn (2,77 %) unter den Top 10, was auf den Fokus auf professionellen Content hinweist. Zusätzlich verweisen sie häufig auf Community-Seiten wie Quora (2,68 %) und Reddit (1,24 %).

Perplexity priorisiert Bildungsinhalte und Lernmaterialien, verlinkt häufig auf Moodle (4,08 %), als einzige KI-Plattform. Weitere spezialisierte Quellen sind GitHub, Instructables und Markdown Guide. 20 % der Top-10-Domains von Perplexity sind KI-bezogen (Jasper.ai, Studioglobal.ai).

ChatGPT setzt stark auf nutzergenerierte Inhalte wie Reddit (7,37 %), Wikipedia (1,95 %) und TikTok (knapp 1 %), ergänzt durch Nachrichtenquellen wie The Times (0,66 %) und The Guardian (0,48 %) sowie Fachplattformen wie Investopedia (0,58 %) und Microsoft (0,49 %).

Bei der Domainverteilung konzentrieren sich ChatGPT und Perplexity auf wenige Domains (17,07 % bzw. 20,63 % der Quellen), während Google AIOs (12,03 %) und Bing Copilot (9,69 %) eine gleichmäßigere Streuung zeigen. Das spiegelt unterschiedliche Ansätze bei der Bewertung und Auswahl relevanter Quellen wider.

Verweise auf Reddit, Quora, LinkedIn, Wikipedia und YouTube in KI-Antworten

YouTube ist mit Abstand die meistzitierte Domain aller analysierten Tools, besonders häufig in Antworten von ChatGPT und Perplexity.

Google AI Overviews empfehlen regelmäßig YouTube-Videos und verweisen sogar auf konkrete Zeitstempel. Diese lassen sich jedoch nicht direkt in den Suchergebnissen abspielen; Nutzer müssen YouTube.com besuchen. ChatGPT integriert Videos direkt in die Antworten, oft mit dem Hinweis „For a visual demonstration“, und ermöglicht das Abspielen direkt in der Chat-Oberfläche.

YouTube erhält auch in Nischen rund um Unterhaltung und Bildung die meisten Verweise:

- Games: 475 Zitationen insgesamt

- Hobbys und Freizeit: 434 Zitationen

- Fahrzeuge: 391 Zitationen

- Sport: 348 Zitationen

Reddit wird am häufigsten von ChatGPT zitiert (1.535 Mal). Auch bei Google AIOs gehört Reddit zu den Top 5 der verlinkten Seiten, allerdings deutlich seltener (135 Zitationen). In allen analysierten Nischen zitiert ChatGPT Reddit zwischen 28 und 101 Mal, am häufigsten in Haus und Garten (101), Hobbys und Freizeit (97) und Sport (95).

Wikipedia wird von allen KI-Tools relativ gleichmäßig genutzt, doch ChatGPT verweist hier am häufigsten darauf. Besonders viele Wikipedia-Zitationen gibt es in:

- Finanzen: 38 Zitationen durch ChatGPT

- Schwermaschinenbau und Ingenieurwesen: 39 Zitationen

- Wissenschaft und Bildung: 28 Zitationen

Quora wird fast ausschließlich von Google AIOs zitiert, vor allem in den Bereichen Gemeinschaft und Gesellschaft (55), Lifestyle (35) und Haus und Garten (24). Andere Tools verlinken Quora nur selten.

LinkedIn weist ein einzigartiges Zitiermuster auf: Nur Google AIOs greifen gezielt darauf zurück, vor allem bei beruflichen Suchanfragen. Die meisten Verweise stammen aus den Kategorien Jobs und Karriere (51), Business und Consumer Services (33) und Finanzen (16).

Überschneidungen bei verlinkten Domains in KI-Antworten

Wir haben untersucht, wie häufig Domains, die von einer KI-Suchmaschine zitiert werden, auch in den Antworten anderer Tools vorkommen. Je höher der Prozentwert, desto mehr gemeinsame Quellen nutzen die Tools.

So verteilen sich die gemeinsamen Domains:

- Bing Copilot / Google AIO: 9,81 %

- Perplexity / Bing Copilot: 11,97 %

- Bing Copilot / ChatGPT: 13,95 %

- Perplexity / Google AIO: 18,52 %

- Google AIO / ChatGPT: 21,26 %

- Perplexity / ChatGPT: 25,19 %

Perplexity und ChatGPT weisen mit 25,19 % die größte Überschneidung auf, obwohl sich nur etwa 20 % ihrer meistverlinkten Websites überschneiden.

Auch Google AI Overviews und ChatGPT zeigen mit 21,26 % eine hohe Übereinstimmung, was auf ähnliche Strategien bei der Quellenauswahl hinweist. Die Überschneidung zwischen Google AIO und Perplexity liegt mit 18,52 % etwas darunter.

ChatGPT hat insgesamt die größte Überschneidung mit anderen KI-Suchmaschinen. Dies könnte darauf hindeuten, dass es ein besonders vielseitiges Spektrum an Quellen nutzt oder einen ausgewogenen Algorithmus für die Quellenauswahl besitzt. Zudem weist ChatGPT die meisten Quellenverweise pro Antwort auf, was die Überschneidungen verstärken kann.

Bing Copilot zeigt die geringste Überschneidung mit den anderen Tools, was auf einen eigenständigen Ansatz bei der Quellenauswahl schließen lässt. Die niedrigste Übereinstimmung besteht zwischen Bing Copilot und Google AI Overviews mit nur 9,81 %, ein Hinweis auf sehr unterschiedliche Zitationsstrategien von Microsoft und Google. Auch die Überschneidung zwischen Bing Copilot und Perplexity ist mit 11,97 % vergleichsweise gering.

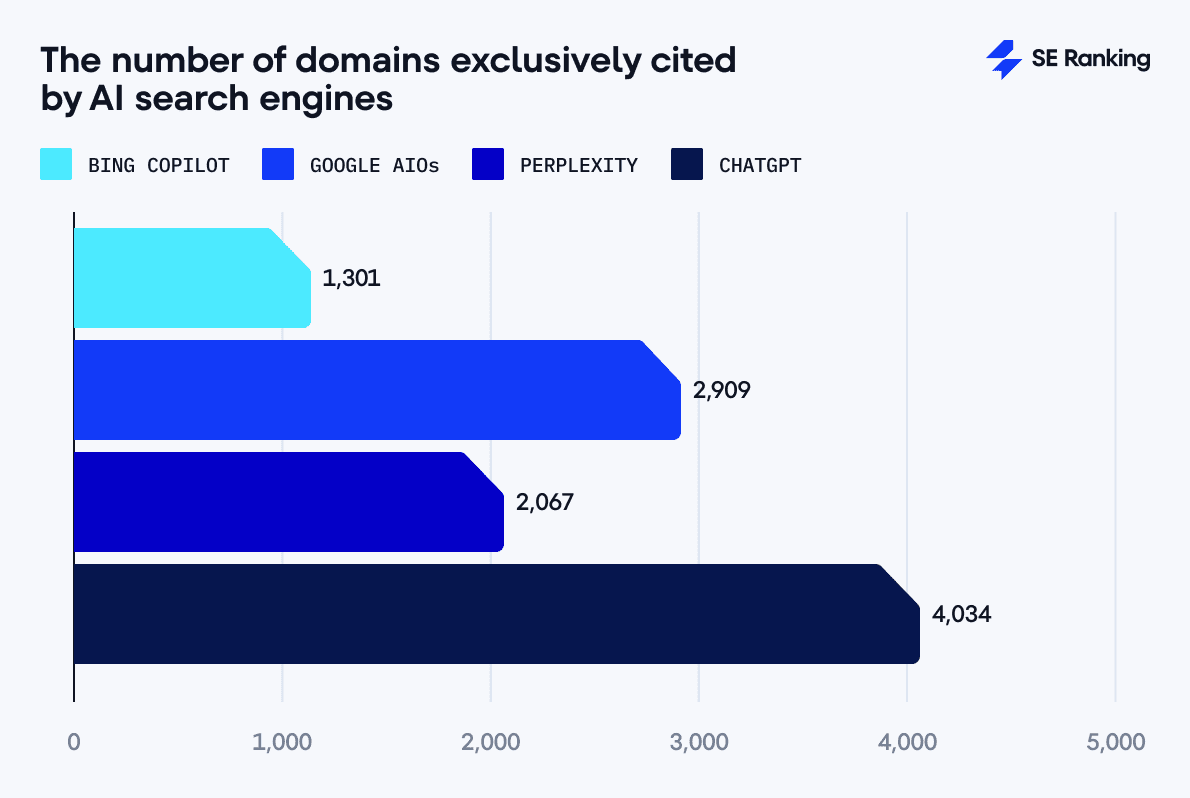

Einzigartige Domains in KI-Antworten

Eine Domain gilt als einzigartig oder exklusiv, wenn sie nur von einem der analysierten KI-Tools zitiert wird.

ChatGPT führt mit 4.034 einzigartigen Domains und nutzt damit deutlich mehr exklusive Quellen als andere Tools. Dies erklärt sich unter anderem dadurch, dass ChatGPT insgesamt mehr Quellen pro Antwort verwendet, viele davon ausschließlich von diesem Tool.

Die Zahlen im Vergleich:

- ChatGPT: 4.034 einzigartige Domains

- Google AIO: 2.909 einzigartige Domains

- Perplexity: 2.067 einzigartige Domains

- Bing Copilot: 1.301 einzigartige Domains

Google AIOs belegen den zweiten Platz, gefolgt von Perplexity und Bing Copilot. Wichtig ist jedoch, zwischen der Anzahl einzigartiger Domains und deren tatsächlicher Relevanz zu unterscheiden. So verlinken Google AIOs zwar viele exklusive Domains (2.909), doch wirklich häufig zitiert wird fast nur Quora.com (293-mal); die anderen Domains erscheinen deutlich seltener.

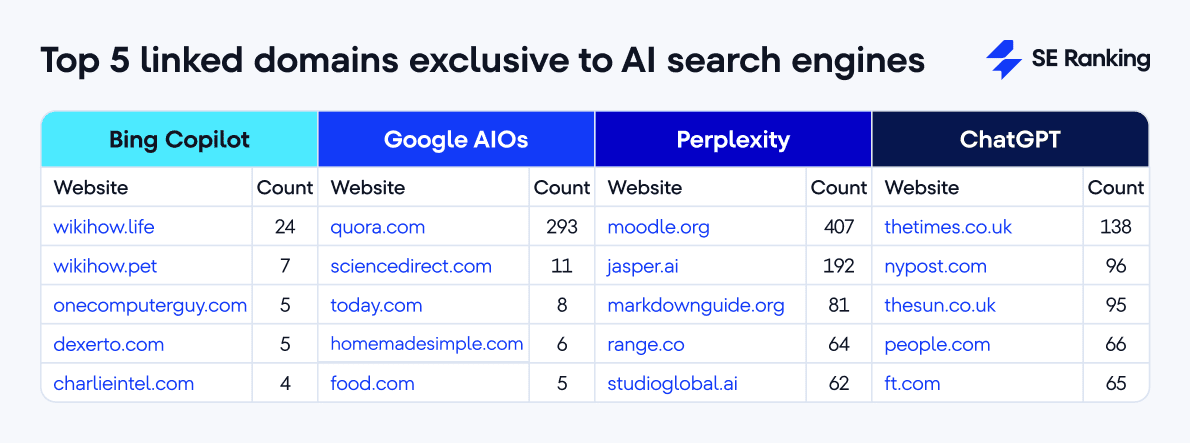

Hier sind die Top 5 einzigartigen Domains, die von den KI-Suchmaschinen verlinkt werden:

Ein Vergleich der exklusiven Top-5-Domains mit den Top-10 der insgesamt meistverlinkten Websites zeigt, dass viele populäre Domains von mehreren KI-Suchmaschinen genutzt werden. Dies deutet auf einen gemeinsamen Pool vertrauenswürdiger Quellen hin, mit einigen auffälligen Ausnahmen:

- Moodle.org: Exklusiv bei Perplexity und Teil der dort am häufigsten zitierten Domains

- Thetimes.co.uk: Einzigartig bei ChatGPT

- Quora.com: Exklusiv bei Google AIOs und dort die dritthäufigste verlinkte Seite

- Jasper.ai: Nur bei Perplexity zu finden und dort auf Platz 3 der meistzitierten Quellen

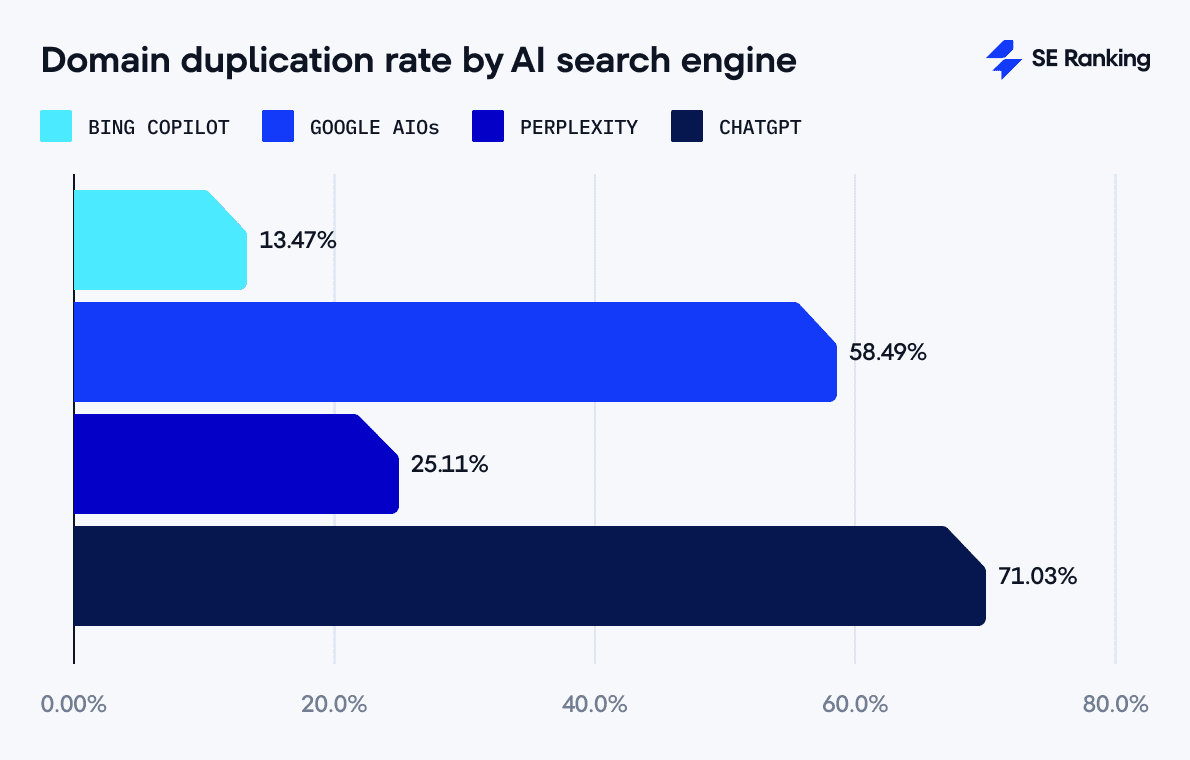

Doppelte Domains in KI-Antworten

Von den insgesamt 2.000 analysierten Suchanfragen enthielten:

- ChatGPT: 1.412 Antworten mit mindestens zwei URLs derselben Domain (71,03 %)

- Google AIOs: 689 Antworten mit doppelten Domains (58,49 %)

- Perplexity: 501 Antworten mit mehrfach verwendeten Domains (25,11 %)

- Bing Copilot: nur 203 Antworten mit Domain-Wiederholungen (13,47 %)

Die Ergebnisse zeigen, dass ChatGPT eine starke Tendenz hat, bestimmte Websites wiederholt zu zitieren. Auch Google AI Overviews bevorzugen einige Quellen, weisen jedoch eine größere inhaltliche Diversität auf als ChatGPT. Perplexity ist insgesamt ausgewogener, während Bing die vielfältigsten Quellen nutzt und Inhalte aus einem besonders breiten Spektrum an Websites bezieht.

Alter der in KI-Antworten zitierten Domains

Das durchschnittliche Alter der von den KI-Suchmaschinen verlinkten Domains zeigt folgendes Bild:

- ChatGPT: 17 Jahre

- Google AIO: 17 Jahre

- Perplexity: 14 Jahre

- Bing Copilot: 12 Jahre

Betrachtet man die Domains nach Alter in „jung“ (< 5 Jahre) und „alt“ (> 15 Jahre), zeigen sich deutliche Unterschiede:

Anteil junger Domains (< 5 Jahre):

- Bing Copilot: 18,85 %

- ChatGPT: 11,99 %

- Perplexity: 8,53 %

- Google AIO: 7,45 %

Anteil alter Domains (> 15 Jahre):

- Google AIO: 49,21 %

- ChatGPT: 45,80 %

- Perplexity: 42,31 %

- Bing Copilot: 31,19 %

Bing Copilot verlinkt besonders häufig auf Domains, die jünger als 5 Jahre sind (18,85 %), während Google AIOs in dieser Altersgruppe mit nur 7,45 % die niedrigste Quote aufweisen. Betrachtet man hingegen ältere Domains (15+ Jahre), liegt Google AIO mit 49,21 % vorn, Bing Copilot kommt hier nur auf 31,19 %.

ChatGPT verfolgt einen besonders kontrastreichen Ansatz bei der Quellenauswahl:

Es zitiert überdurchschnittlich häufig sehr alte Domains: 31,67 % der verlinkten Seiten sind über 20 Jahre alt. Gleichzeitig liegt es mit 4,86 % bei Domains unter 3 Jahren an zweiter Stelle. Auffällig ist auch die starke Nutzung von Domains im Alter von 5–10 Jahren (21,97 %) und 10–15 Jahren (20,24 %). Das legt nahe, dass ChatGPT bei etablierten Themen bevorzugt auf bewährte, lang bestehende Quellen zurückgreift.

Perplexity weist die ausgewogenste Verteilung über mittlere und ältere Domain-Altersklassen auf. Der höchste Anteil entfällt auf Domains im Alter von 10 bis 15 Jahren (26,16 %). Das ist der höchste Wert in dieser Kategorie im gesamten Vergleich. Auch Domains im Alter von 5–10 Jahren (23,11 %), 15–20 Jahren (21,00 %) und über 20 Jahren (21,21 %) sind stark vertreten. Im Gegensatz dazu ist der Anteil sehr junger Domains (0–3 Jahre) mit 3,32 % vergleichsweise gering.

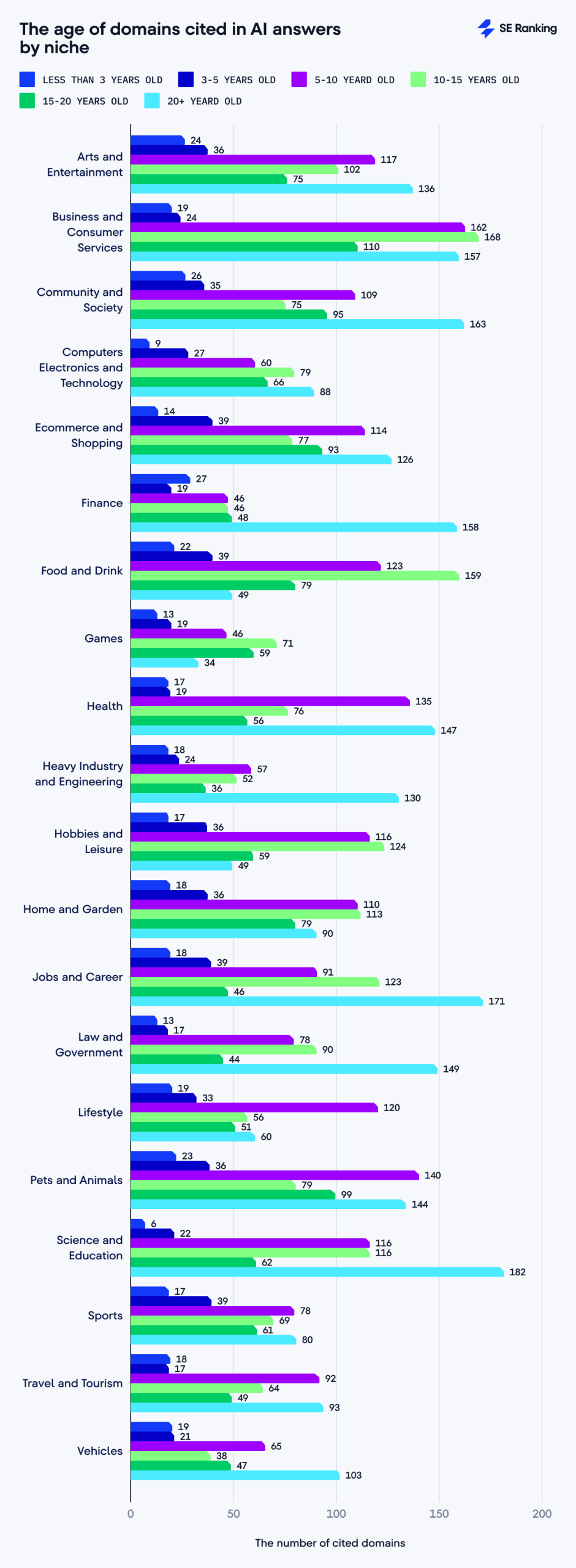

Alter der zitierten Domains nach Themenbereich

Nischen mit dem geringsten Anteil junger Domains (bis 5 Jahre):

- Wissenschaft und Bildung: 5,60 %

- Recht und Regierung: 7,70 %

- Gesundheit: 8,00 %

- Computer, Elektronik & Technologie: 11,00 %

Nischen mit dem geringsten Anteil sehr alter Domains (über 20 Jahre):

- Essen und Trinken: 10,40 %

- Spiele: 14,00 %

- Finanzen fällt durch einen besonders hohen Anteil älterer Domains auf: Rund 46 % der zitierten Quellen sind über 20 Jahre alt. Dagegen machen jüngere Domains (unter 5 Jahre) nur 13,50 % aus. Das spiegelt die starke Präferenz des Finanzsektors für etablierte und vertrauenswürdige Quellen wider, hier zählen Historie und Reputation besonders.

- Ein ähnliches Muster zeigt sich im Bereich Recht und Regierung: Etwa 38 % der Domains sind älter als 20 Jahre, während nur 7,70 % jünger als 5 Jahre sind.

- Auch im Bereich Jobs und Karriere liegt der Anteil älterer Domains bei rund 35 %, während jüngere Domains nur 11,70 % ausmachen.

- Anders sieht es in der Kategorie Hobbys und Freizeit aus: Hier dominieren mittelalte Domains. Allein Domains im Alter von 5–10 Jahren und 10–15 Jahren machen zusammen etwa 60 % aus.

- Ein ähnliches Bild zeigt sich bei Essen und Trinken sowie Haus und Garten, wo der Anteil mittelalter Domains ebenfalls bei jeweils 59 % liegt.

YouTube sticht als zentrale Quelle bei fast allen KI-Suchmaschinen hervor. ChatGPT verweist in 11,30 % der Fälle auf YouTube, Perplexity liegt mit 11,11 % nahezu gleichauf. Google AIOs verlinken in 6,31 % der Antworten auf YouTube, während Bing Copilot deutlich seltener darauf verweist: nur in 0,86 % der Fälle.

ChatGPT liefert besonders referenzstarke Antworten mit durchschnittlich 10,42 Links pro Antwort. Gleichzeitig zeigt es die höchste Domain-Duplikationsrate von 71,03 %, das heißt, es verweist häufig mehrfach auf dieselben Websites. Die Quellen umfassen nutzerbasierte Plattformen wie Reddit, Wikipedia und TikTok, etablierte Medien wie The Times und The Guardian sowie fachlich orientierte Seiten wie Investopedia und Microsoft. ChatGPT bevorzugt tendenziell ältere Domains (45,80 % über 15 Jahre), bezieht aber auch vergleichsweise viele neue Quellen ein (11,99 % unter 5 Jahre).

Google AI Overviews verfolgen einen ausgewogenen, quellenreichen Ansatz mit durchschnittlich 9,26 Links pro Antwort. Die Domain-Wiederholungsrate ist mit 58,49 % etwas niedriger als bei ChatGPT. Auffällig sind häufige Verlinkungen zu beruflichen Netzwerken wie LinkedIn und Indeed sowie community-basierten Plattformen wie Quora und Reddit. Google zitiert am häufigsten ältere Domains (49,21 % über 15 Jahre).

Perplexity verfolgt eine strukturierte und konsistente Zitationsstrategie, indem es in 1.980 Fällen genau fünf Quellen pro Antwort nennt. Die Domain-Wiederholungsrate liegt mit 25,11 % deutlich unter der von ChatGPT und Google. Thematisch fokussiert sich Perplexity stark auf Bildungs- und KI-Inhalte, etwa durch Verlinkungen zu Moodle, GitHub, Jasper.ai und Studioglobal.ai. Am häufigsten zitiert werden Domains im Alter von 10 bis 15 Jahren (26,16 %). Perplexity und ChatGPT teilen 25,19 % ihrer referenzierten Domains, der höchste Wert im Vergleich, was auf eine ähnliche Quellenauswahlstrategie hindeutet.

Bing Copilot verfolgt einen minimalistischen Ansatz: Es verwendet im Durchschnitt nur 3,13 Links pro Antwort (den niedrigsten Wert im Vergleich) und zeigt mit 13,47 % auch die geringste Domain-Wiederholungsrate. Oft greift Bing auf eine kleine Auswahl praktisch orientierter Websites zurück, darunter WikiHow, Indeed und Healthline. Im Unterschied zu den anderen KI-Suchmaschinen verweist Bing am häufigsten auf jüngere Domains: 18,85 % der verlinkten Seiten sind jünger als 5 Jahre. Zudem weist Bing die geringste Domain-Überschneidung mit den anderen Tools auf.

Inhaltsanalyse: Antwortlänge, Ähnlichkeit, Komplexität, Objektivität und mehr

Antwortlänge bei KI-Tools

Unsere Analyse zeigt deutliche Unterschiede in der durchschnittlichen Länge der Antworten je KI-Suchmaschine:

- Bing Copilot liefert die kürzesten Antworten mit durchschnittlich 398 Zeichen (83 Wörter).

- Perplexity liegt mit 1.310 Zeichen (257 Wörter) an zweiter Stelle.

- Google AI Overviews folgen mit 997 Zeichen (191 Wörter).

- ChatGPT erzeugt die längsten Antworten: durchschnittlich 1.686 Zeichen (318 Wörter), rund viermal so lang wie Bing.

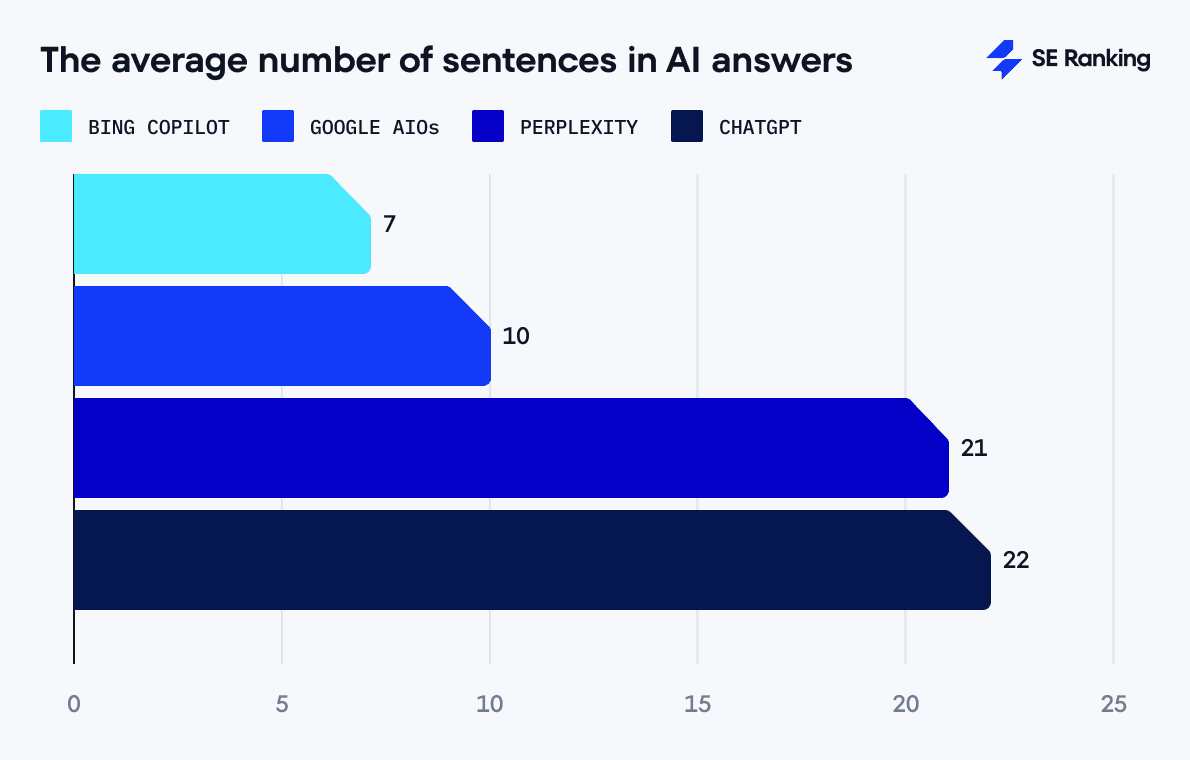

Bei der durchschnittlichen Satzanzahl pro Antwort sind ChatGPT und Perplexity mit 22 bzw. 21 Sätzen ähnlich, während Google AIOs auf 10 und Bing Copilot nur auf 7 Sätze kommen.

Die durchschnittliche Zeichenzahl pro Satz (Gesamtzeichenzahl geteilt durch Satzanzahl) zeigt folgendes Muster:

- Bing Copilot: 60 Zeichen pro Satz

- Perplexity: 63 Zeichen pro Satz

- ChatGPT: 78 Zeichen pro Satz

- Google AIO: 101 Zeichen pro Satz

Das bedeutet: KI-Suchmaschinen mit längeren Antworten verwenden tendenziell kürzere, leichter verdauliche Sätze.

ChatGPT und Perplexity liefern lange, detaillierte Antworten mit vielen kurzen Sätzen, was auf eine klare Gliederung in Unterpunkte oder Schritte hindeutet.

Google AIO bietet mit 997 Zeichen ebenfalls umfangreiche Antworten, verwendet jedoch nur 10 längere, oft komplexere Sätze pro Antwort.

Bing Copilot setzt auf kurze, prägnante Antworten mit wenigen und sehr kurzen Sätzen, was einen leicht überfliegbaren, aber weniger tiefgründigen Stil ergibt.

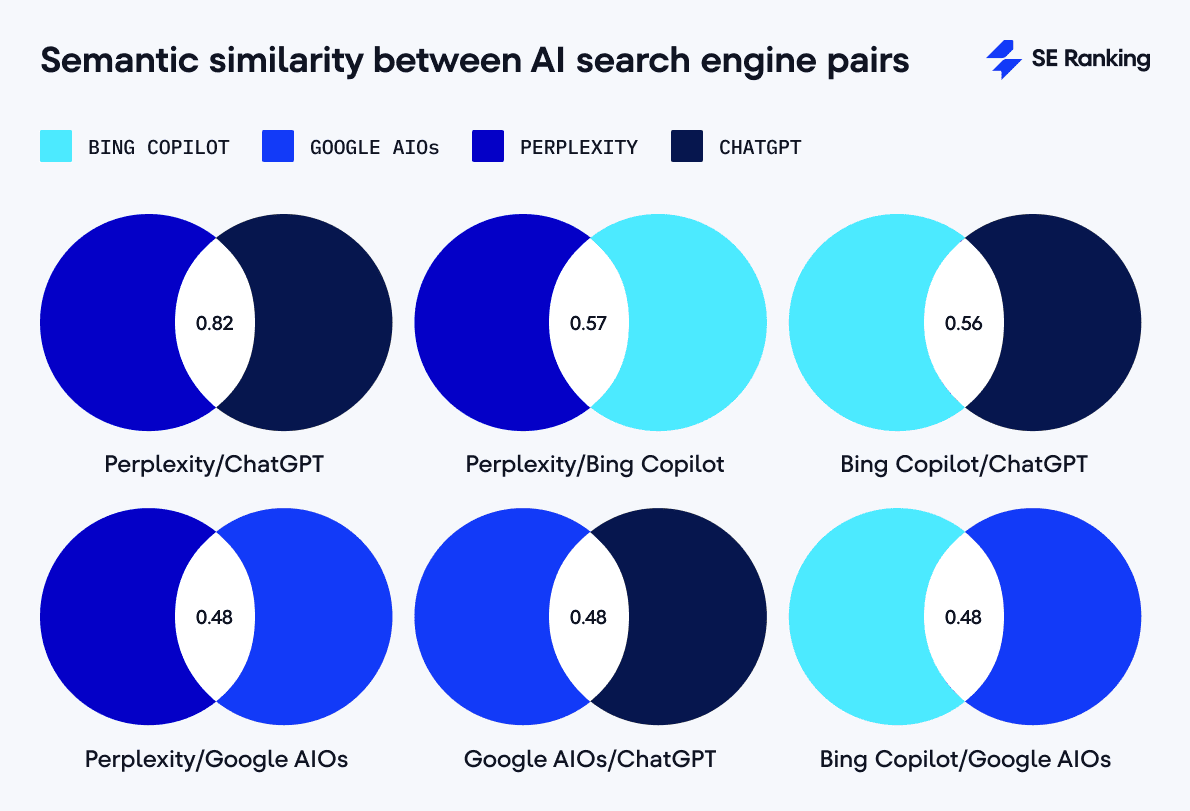

Semantische Ähnlichkeit von KI-Antworten

Zur Bewertung der semantischen Ähnlichkeit zwischen Antworten verschiedener KI-Tools nutzten wir einen zweistufigen Ansatz: Zunächst wurden die Antworten mit der sentence-transformers-Bibliothek in Vektor-Embeddings umgewandelt. Anschließend berechneten wir mit der Cosine Similarity-Funktion aus sklearn die Ähnlichkeit anhand des Winkels zwischen den Embeddings.

Ein höherer Wert auf einer Skala von 0 bis 1 zeigt eine größere semantische Nähe der Antworten.

Unsere Ergebnisse im Vergleich der KI-Tools:

- Perplexity / ChatGPT: 0,82

- Perplexity / Bing Copilot: 0,57

- Bing Copilot / ChatGPT: 0,56

- Perplexity / Google AIO: 0,48

- Google AIO / ChatGPT: 0,48

- Bing Copilot / Google AIO: 0,48

Perplexity und ChatGPT weisen mit 0,82 die höchste semantische Ähnlichkeit auf, was auf eine starke inhaltliche Übereinstimmung hindeutet. Beide nutzen vermutlich ähnliche generative KI-Technologien zur Verarbeitung und Modellierung.

Google AI Overviews zeigen mit 0,48 durchweg geringere Ähnlichkeit zu den anderen Tools, was für einen eigenständigen Antwortansatz spricht. Im Vergleich zu den ausführlichen Antworten von Perplexity und ChatGPT liefert Google eher moderate und anders strukturierte Inhalte.

Bing hat eine mittlere inhaltliche Nähe zu Perplexity und ChatGPT. Obwohl die Antworten kürzer sind, gibt es inhaltliche Überschneidungen, bleibt aber in der Tiefe hinter den ausführlicheren Tools zurück.

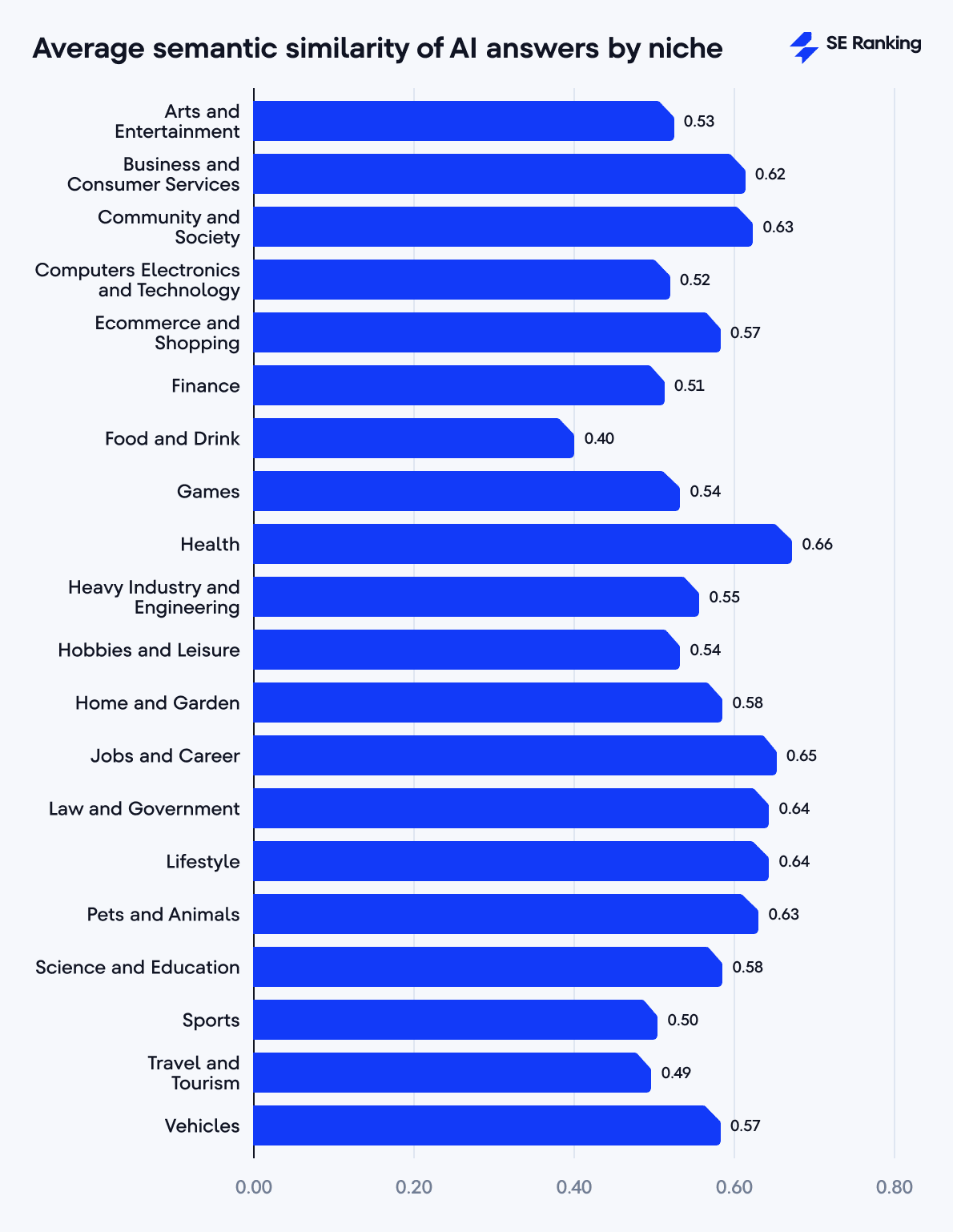

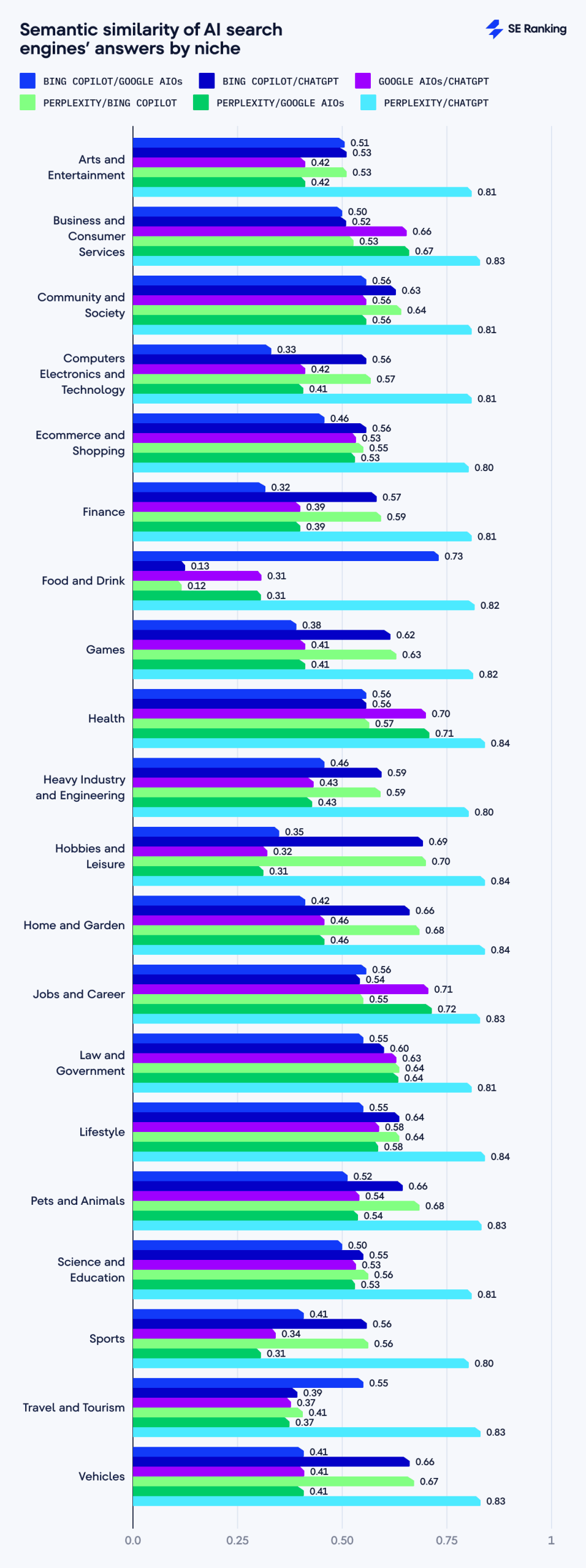

Semantische Ähnlichkeit von KI-Antworten nach Themenbereich und Tool

In folgenden Themenbereichen liefern die KI-Tools die inhaltlich ähnlichsten Antworten (Cosine-Similarity-Werte):

- Gesundheit: 0,66

- Jobs und Karriere: 0,65

- Recht und Regierung und Lifestyle: je 0,64

- Gemeinschaft und Gesellschaft sowie Haustiere und Tiere: je 0,63

- Business und Consumer Services: 0,62

Die geringste semantische Übereinstimmung zeigen die Bereiche:

- Computer, Elektronik und Technologie: 0,52

- Finanzen: 0,51

- Sport: 0,50

- Reisen und Tourismus: 0,49

- Essen und Trinken: 0,40

Die semantische Ähnlichkeit zwischen ChatGPT und Perplexity bleibt über alle Themenbereiche hinweg konstant hoch, mit Werten zwischen 0,80 und 0,84 selbst in Branchen, in denen andere Tool-Paare größere Unterschiede aufweisen.

Den höchsten Wert von 0,84 erreichen ChatGPT und Perplexity in den Bereichen Gesundheit, Hobbys und Freizeit, Haus und Garten sowie Lifestyle. Dies könnte an der subjektiveren Natur dieser Themen liegen, wodurch die Antworten beider Tools inhaltlich nahezu austauschbar sind.

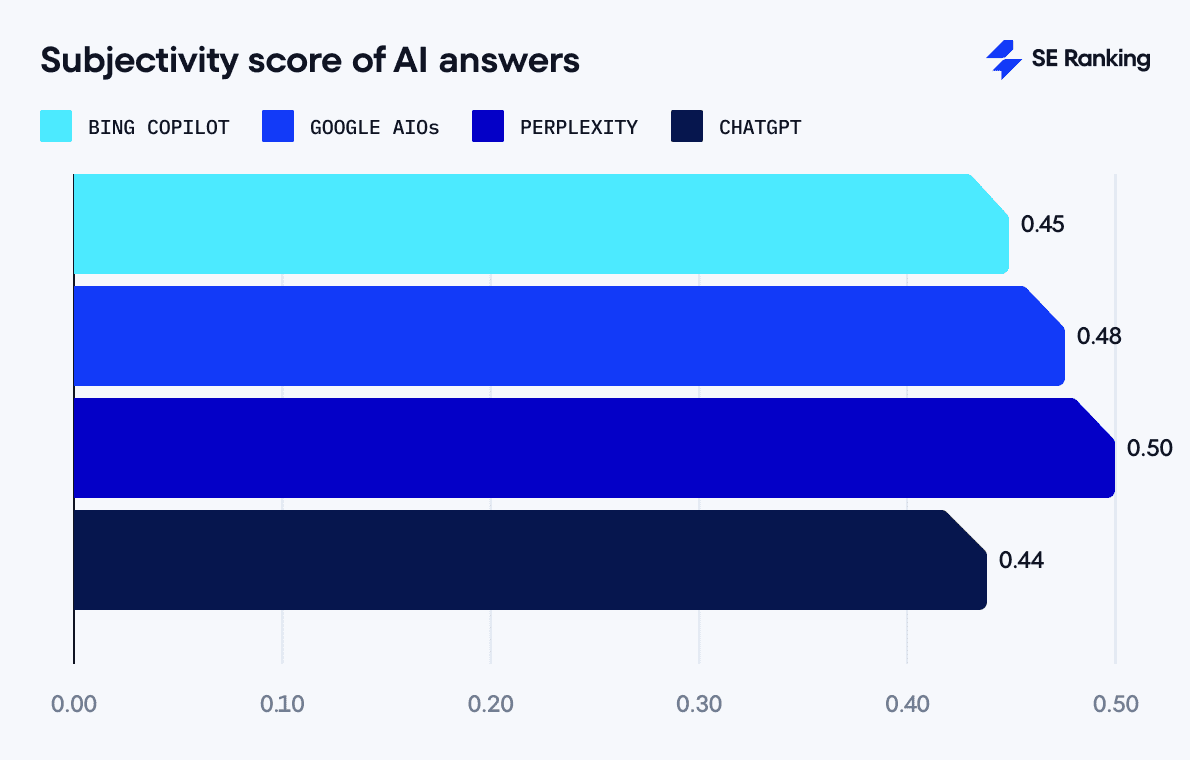

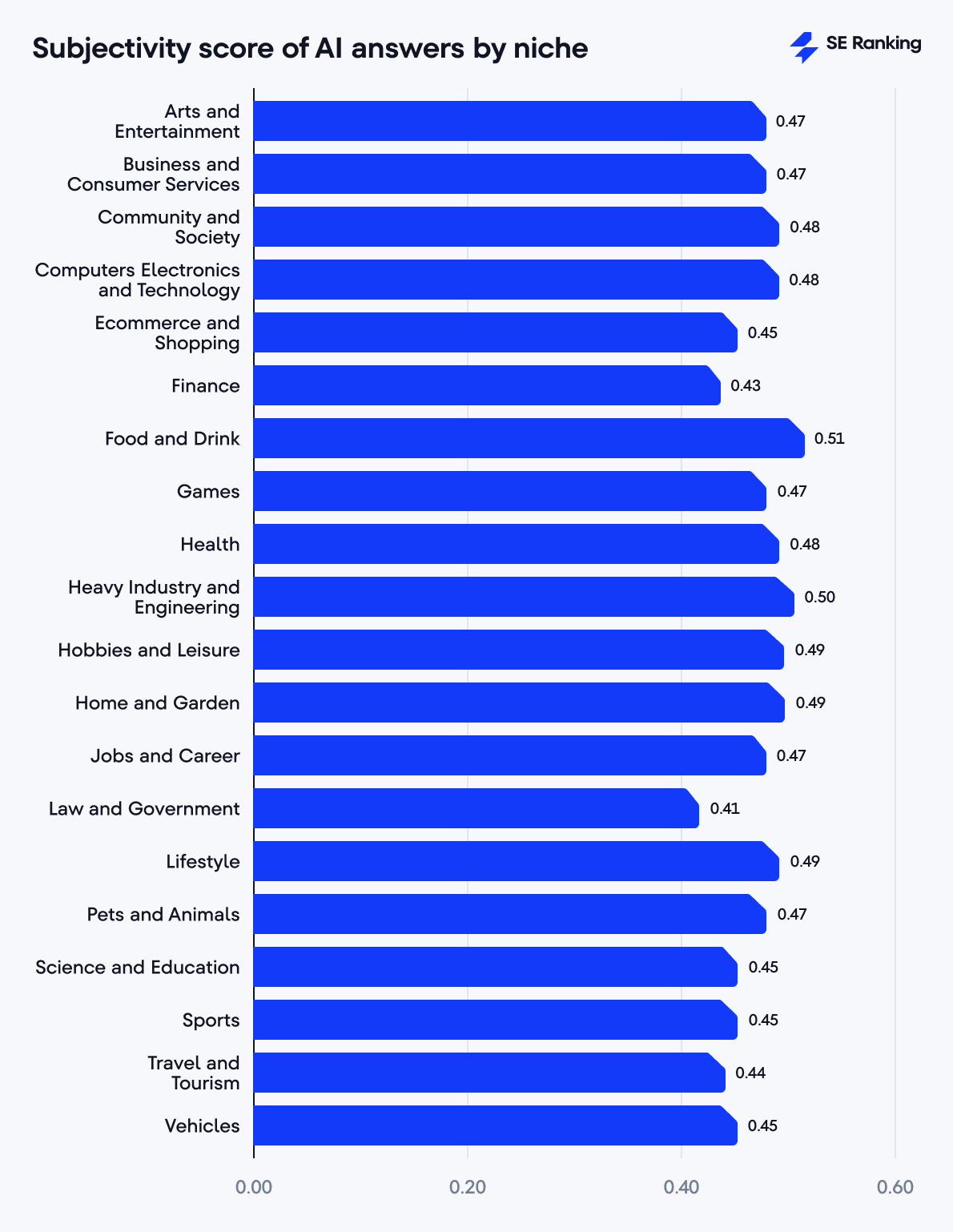

Objektivität von KI-Antworten

Zur Bewertung des Subjektivitätsgrads der KI-Antworten haben wir die TextBlob-Bibliothek genutzt, ein Python-basiertes Tool zur Textanalyse. Der ermittelte Wert misst den Anteil meinungsbetonter Sprache: Ein Score von 1 steht für maximale Subjektivität, 0 für vollständige Objektivität.

Der durchschnittliche Subjektivitätswert aller Tools liegt zwischen 0,44 und 0,50. Die Verteilung im Einzelnen:

- Perplexity (0,50 – höchste Subjektivität): Enthält häufiger Meinungen oder Interpretationen.

- Google AIOs (0,48 – mittlere Subjektivität): Mischt faktische Inhalte mit bewertender oder überzeugender Sprache.

- Bing Copilot (0,45 – mittlere Subjektivität): Verwendet gelegentlich meinungsgeprägte Formulierungen.

- ChatGPT (0,44 – niedrigste Subjektivität): Bedient sich eines faktenbasierten, sachlichen Stils.

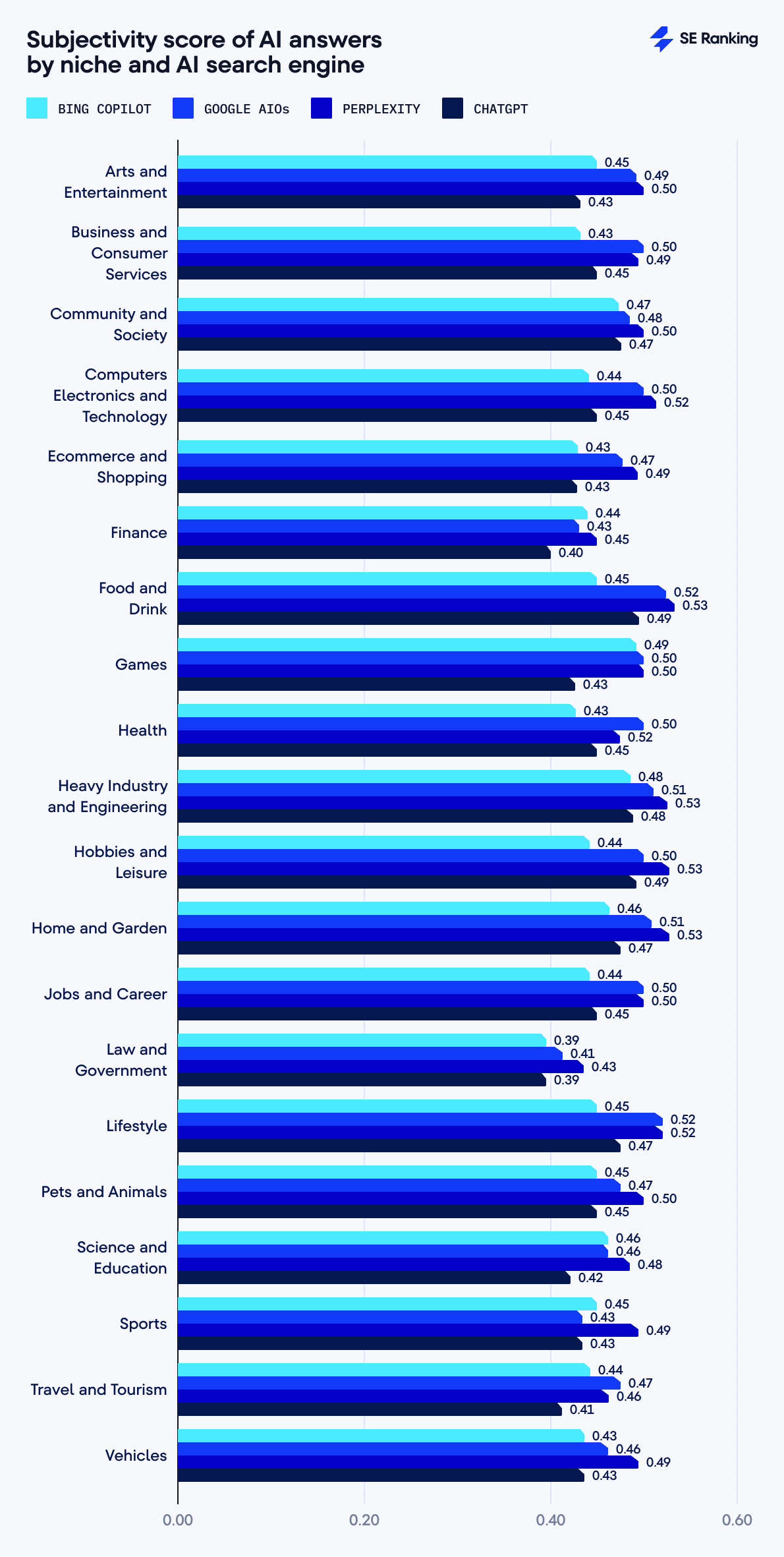

Objektivität von KI-Antworten nach Themenbereich und Tool

Die objektivsten KI-Antworten finden sich in den Bereichen Recht und Regierung (0,41), Finanzen (0,43) sowie Reisen und Tourismus (0,44). Besonders in YMYL-Kategorien („Your Money or Your Life“) wie Recht und Finanzen sind Genauigkeit und Neutralität entscheidend. Diese Themen sind stark informationsgetrieben, sachlich und prozessorientiert, mit wenig Raum für subjektive Interpretation.

Die höchsten Subjektivitätswerte weisen die Bereiche Hobbys und Freizeit (0,49), Schwermaschinenbau und Technik (0,50) und Essen und Trinken (0,51) auf.

Dies liegt daran, dass einige Themen von Natur aus empfehlende oder bewertende Inhalte enthalten. So sind Beiträge zu Essen und Trinken oft von Geschmacksbeschreibungen geprägt, während Hobbys und Freizeit häufig persönliche Empfehlungen enthalten.

So unterscheiden sich die Subjektivitätswerte je nach Themenbereich und KI-Tool:

- Bing Copilot liefert die objektivsten Antworten im Bereich Recht und Regierung (0,39) und die subjektivsten im Bereich Spiele (0,49).

- Google AIOs sind am objektivsten bei Recht und Regierung (0,41) und am subjektivsten bei Essen und Trinken sowie Lifestyle (je 0,52).

- Perplexity zeigt in vielen Bereichen die geringste Objektivität. Am objektivsten ist es noch bei Recht und Regierung (0,43), der höchste Wert aller Tools für diese Nische. Besonders subjektiv sind die Antworten in Essen und Trinken, Schwermaschinenbau und Technik, Haus und Garten sowie Hobbys und Freizeit (je 0,53).

- ChatGPT ist am objektivsten bei Recht und Regierung (0,39) und am subjektivsten bei Essen und Trinken sowie Hobbys und Freizeit (je 0,49).

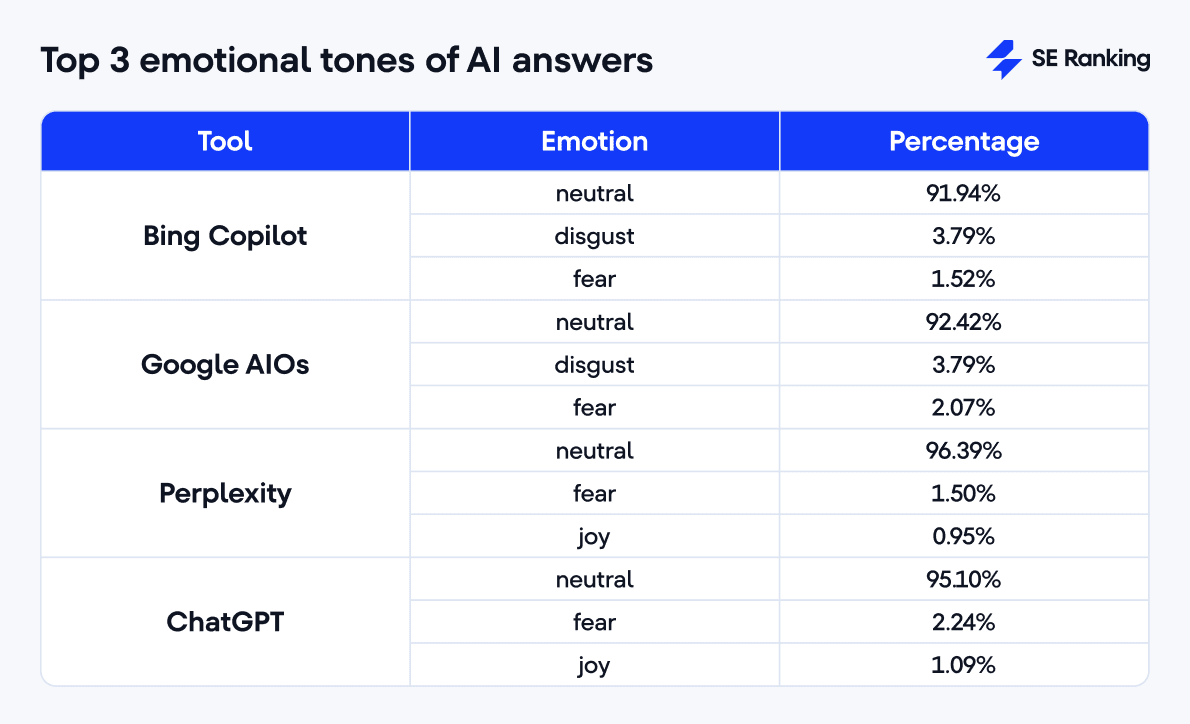

Emotionaler Tonfall von KI-Antworten

Zur Bewertung des emotionalen Tons verwendeten wir die Transformers-Bibliothek in Kombination mit dem vortrainierten Emotion English DistilRoBERTa-base-Modell zur Emotionserkennung. Das Ergebnis: Alle Tools zeigen einen hohen Grad an Neutralität in ihren Antworten, was für Suchmaschinen erwartbar und wünschenswert ist.

- Perplexity weist mit 96,39 % den höchsten Neutralitätswert auf.

- Bing Copilot liegt mit 91,94 % am unteren Ende des Vergleichs.

- ChatGPT liegt mit 95,10 % näher an Perplexity

- Google AI Overviews liegt mit 92,42 % näher bei Bing.

Neben Neutralität zeigen KI-Suchmaschinen auch andere emotionale Töne. Bei Perplexity und ChatGPT ist Freude die dritthäufigste erkannte Emotion. Alle vier Tools weisen zudem einen geringen Anteil negativer Emotionen wie Ekel oder Angst auf, besonders bei Bing Copilot und Google AI Overviews. Dies hängt mit einer vorsichtigen oder warnenden Sprache in sensiblen Themen wie körperlicher oder psychischer Gesundheit zusammen.

Perplexity und ChatGPT zeigen mit 0,82 die höchste semantische Ähnlichkeit und liefern besonders in Gesundheit und Freizeit fast identische Antworten. Beide nutzen einen ähnlichen Stil, mit längeren, ermutigenden Texten und mittlerer grammatikalischer Komplexität.

Bing Copilot verfolgt eine minimalistische Strategie mit hoher Lesbarkeit und vereinfachter Grammatik, richtet sich an ein breites Publikum und unterscheidet sich damit deutlich von ChatGPT.

Google AI Overviews weisen die geringste Ähnlichkeit auf, liefern mittel-lange, aber komplexe und schwer lesbare Antworten für eine gebildete Zielgruppe. Google legt besonderen Wert auf quellenbasierte Inhalte.

Die Themen beeinflussen die Antwortgestaltung: Fachbereiche wie Finanzen und Karriere sind komplexer und objektiver, Alltagsthemen wie Essen und Hobbys subjektiver. Soziale Themen sind emotional und tonal vielfältig.

Methodik

Für unsere Analyse wählten wir 2.000 How-to-Keywords aus 20 Themenbereichen (je 100 pro Kategorie).

Die Untersuchung fand vom 26.02. bis 03.03.2025 statt, mit diesen Parametern:

- Suchmaschinen: ChatGPT (SearchGPT), Google AI Overviews, Bing Copilot, Perplexity (mit aktiver Suche)

- Standort: USA

- Sprache: Englisch (en)

Verwendete SE Ranking Tools:

Zusätzliche Tools und Bibliotheken:

- sentence_transformers

- cosine_similarity (sklearn)

- yake (automatische Keyword-Extraktion)

- Stanza (Textanalyse)

- Coleman-Liau-Index

- spaCy library

- Transformers library

- Emotion English DistilRoBERTa-base

- TextBlob

Fazit

KI-Suchmaschinen unterscheiden sich stark in Inhalt, Quellenauswahl und Belegstrategie.

ChatGPT liefert ausführliche, gut belegte Antworten und ähnelt in Stil und Länge stark Perplexity. Bing Copilot verfolgt einen minimalistischen Ansatz mit kurzen, praxisnahen Antworten und wenigen Links. Google AI Overviews bieten mittellange, aber schwer lesbare Antworten.

Da Platzierungen in KI-Antworten die Online-Sichtbarkeit steigern, lohnt es sich, die Content-Strategie auf die Eigenheiten der einzelnen Tools auszurichten.

Bleib dran! In unserem Blog erscheinen regelmäßig neue Analysen und Insights zu diesem Thema.