DeepSeek: kosteneffectieve AI voor SEO’ers of een overgewaardeerde concurrent van ChatGPT?

Overhyped of niet, wanneer een weinig bekend Chinees AI-model ChatGPT plotseling van de troon stoot in de Apple Store hitlijsten, is het zaak om alert te zijn. Een snelle zoekopdracht op DeepSeek in Google onthult een waar konijnenhol van verdeelde meningen. Sommigen prijzen DeepSeek vanwege de kosteneffectiviteit, terwijl anderen waarschuwen voor potentiële juridische- en privacyproblemen. Iedereen lijkt het echter over één ding eens te zijn: DeepSeek kan bijna alles wat ChatGPT ook kan.

Voor SEO’ers en online marketeers is het nieuwste model van DeepSeek, R1 (gelanceerd op 20 januari 2025), een nadere blik waard. Het is ’s werelds eerste open-source AI-model waarvan de ‘chain of thought’-prompting de GPT-o1 van OpenAI weerspiegelt. Je kijkt naar een API die je SEO-workflow vrijwel kosteloos kan revolutioneren. Het addertje onder het gras? Negeer de alarmbellen over beveiliging en privacy die wereldwijd rinkelen niet. Het is een flinke kanttekening.

Wat is DeepSeek precies en waarom is het interessant?

-

Het R1-model van DeepSeek daagt het idee uit, dat AI een fortuin moet kosten bij het trainen van data om krachtig te zijn.

-

Goedkope API-toegang tot GPT-o1-level betekent dat SEO-bureaus betaalbare AI-tools in hun workflows kunnen integreren zonder dat dit ten koste gaat van de kwaliteit. De online versie en app hebben geen gebruikslimieten, in tegenstelling tot GPT-o1.

-

De meeste SEO’ers zeggen dat GPT-o1 beter is voor het schrijven van tekst en het maken van andersoortige content, terwijl R1 uitblinkt in het snel verwerken van grote hoeveelheden data.

-

Een bedrijf voor cloudbeveiliging ontdekte een groot datalek bij DeepSeek, waardoor de wereld zich afvraagt of DeepSeek wel voldoet aan de wereldwijde normen rond gegevensbescherming.

-

De censuur van DeepSeek vanwege de Chinese oorsprong beperkt de flexibiliteit van de content.

Wat is DeepSeek?

Een hobbyproject, of in ieder geval zo begon het.

DeepSeek is een Chinees AI-onderzoekslab dat is opgericht door hedgefonds High Flyer. Het heeft concurrerende modellen gecreëerd zoals V3, dat zich eind 2024 liet zien. R1, zijn nieuwe kostenefficiënte model, verraste de AI-industrie en won begin 2025 snel aan populariteit (en bekendheid).

DeepSeek is wat er gebeurt als een jonge Chinese hedgefonds miljardair zijn eerste stappen zet in de wereld van AI en een groep ‘verse afgestudeerden van topuniversiteiten’ inhuurt om zijn AI-startup een impuls te geven.

Die jonge miljardair is Liam Wenfeng. De 40-jarige ondernemer, geboren in 1985, richtte High-flyer, zijn handelsbedrijf in aandelen, op nadat hij was afgestudeerd met een masterdiploma in AI. Wenfeng zei dat hij de overstap naar tech maakte omdat hij de grenzen van AI wilde verkennen. Uiteindelijk richtte hij in 2023 DeepSeek op als zijn zijproject.

Zijn motto, “innovatie is een kwestie van geloof”, bewoog van aspiratie naar realiteit nadat hij de wereld op zijn kop zette met DeepSeek R1. Zijn team bouwde het product voor slechts $5,58 miljoen, wat niets is in vergelijking met de $6 miljard investering van OpenAI in het ChatGPT-ecosysteem. Het feit dat een Chinese startup een AI-model kon bouwen dat net zo goed was als dat van OpenAI, maar dan voor een fractie van de kosten, zorgde ervoor dat de aandelenmarkt kelderde op maandag 27 januari.

Voor SEO’ers en online marketeers is de opkomst van DeepSeek niet alleen een technisch verhaal. Wenfengs project heeft de manier veranderd waarop men AI-aangedreven content creatie, automatisering en data-analyse aanpakt. Het is een krachtig, kosteneffectief alternatief voor ChatGPT.

Dit is waarom.

Vergelijking tussen DeepSeek R1 en ChatGPT-o1

We beginnen met de olifant in de kamer: DeepSeek heeft kostenefficiëntie in AI opnieuw gedefinieerd. Dit is hoe de twee modellen zich verhouden:

| Functie | DeepSeek R1 | OpenAI’s GPT-o1 |

| Prijs van input tokens | $0.55 per 1M tokens | $15 per 1M tokens |

| Prijs van output tokens | $2.19 per 1M tokens | $60 per 1M tokens |

| Gratis toegang | Ja (de app is gratis te gebruiken, API-integratie is token-based) | Voor toegang tot de app is een Plus-abonnement van $20/maand vereist |

| Architectuur efficiëntie | De Mixture of Experts (MoE) heeft in totaal 671 miljard parameters, maar gebruikt 37 miljard per taak. | Maakt gebruik van alle 175 miljard parameters per taak, wat creatieve probleemoplossing bevordert |

Wat betekent dit?

Volgens DeepSeek en tal van wereldwijd opererende online marketeers die R1 gebruiken, krijg je bijna dezelfde kwaliteit voor slechts een fractie van de kosten van OpenAI. R1 is helemaal gratis, tenzij je de API integreert. OpenAI geeft je niet eens toegang tot het GPT-o1-model voordat je het Plus-abonnement voor $20 per maand aanschaft.

Die $20 werd gezien als kleingeld voor wat je krijgt totdat Wenfeng DeepSeek’s Mixture of Experts (MoE) architectuur introduceerde – de basis achter R1’s efficiënte computer resource management. Dit verklaart waarom DeepSeek zo weinig kost, maar zoveel kan.

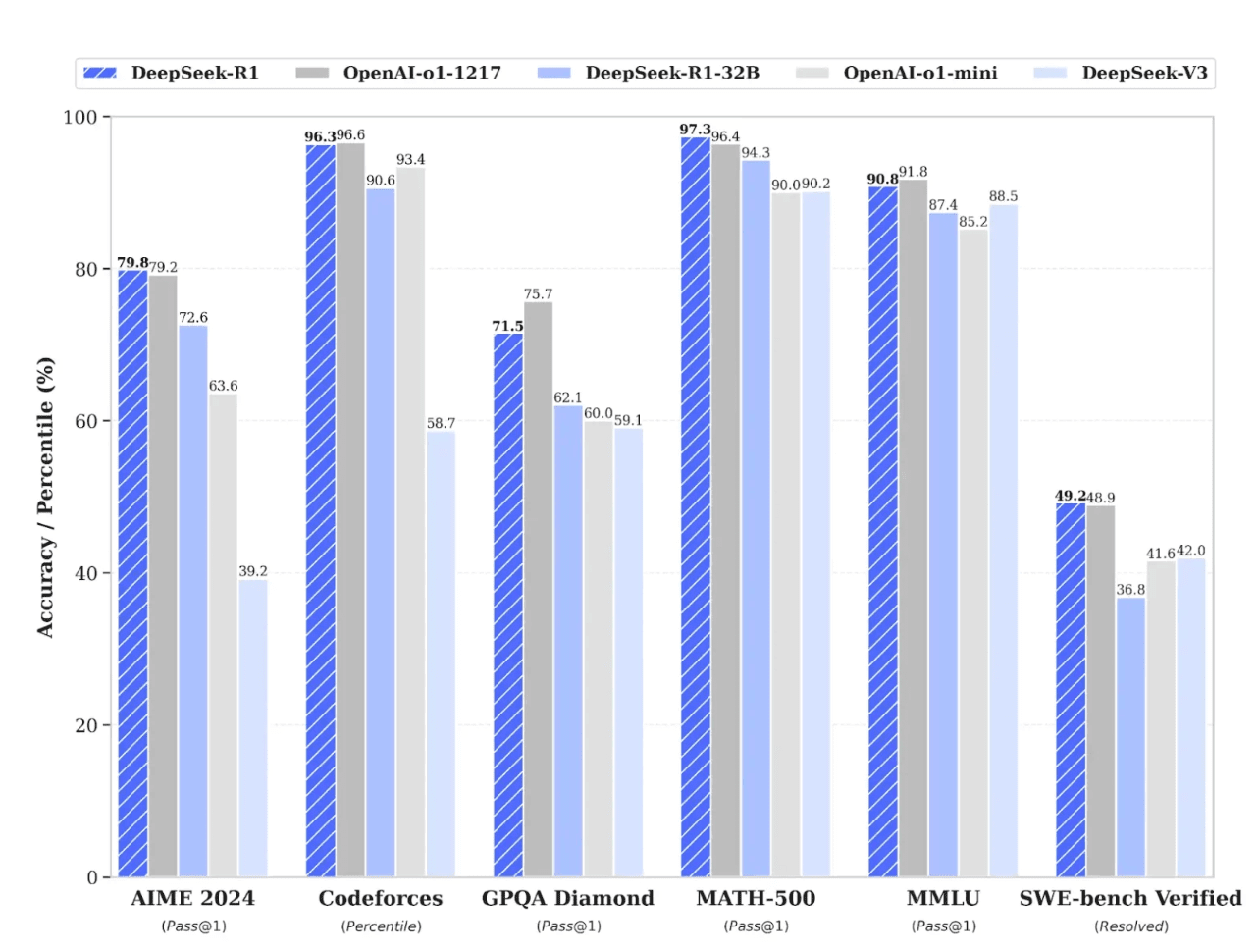

Benchmark prestaties

De onderstaande benchmarks, rechtstreeks afkomstig van de website van DeepSeek, suggereren dat R1 concurrerend is met GPT-o1 bij het uitvoeren van een reeks belangrijke taken. Maar zelfs de beste benchmarks kunnen bevooroordeeld of verkeerd gebruikt zijn. Neem ze met een korreltje zout.

Dit is wat elke benchmark meet:

- AIME 2024: Logisch redeneren en probleemoplossing

- Codeforces: Schrijven van code

- GQPA: Algemene taken zoals klantenondersteuning en het geven van instructies

- MATH-500: Complexe wiskundige problemen oplossen

- MMLU: Begrip van natuurlijke taal en kritisch denken

- SWE-Bench Verified: Software engineering

De grafiek hierboven laat duidelijk zien dat GPT-o1 en DeepSeek op de meeste gebieden nek aan nek gaan. Vanwege hun verschillende architecturen heeft elk model echter zijn eigen sterke punten. Laten we ze bekijken.

DeepSeek is het beste voor technische taken en het schrijven van code

DeepSeek werkt volgens een Mixture of Experts (MoE)-model. Vergelijk het eens met een team van specialisten, waarbij alleen de benodigde expert per taak ingezet wordt. Het geeft voortdurend aan welke delen van zijn rekenkracht moeten worden ingezet op basis van hoe complex de gegeven taak is. Dit maakt het systeem efficiënter voor data-intensieve taken zoals het genereren van code, het beheren van resources en bijvoorbeeld projectplanning.

Een voorbeeld: Composio-schrijver Sunil Kumar Dash testte in zijn artikel Notes on DeepSeek r1 de vaardigheden op het gebied van het schrijven van code van verschillende LLM’s op basis van het lastige “Longest Special Path”-probleem. Hij merkte op dat alle LLM’s die hij testte het goed hadden, maar dat R1’s “uitkomst beter was wat betreft het algehele geheugenverbruik.”

Dit betekent dat de code-uitvoer minder middelen gebruikte, wat Sunil meer waar voor zijn geld gaf.

GPT-o1 blinkt uit in het creëren en analyseren van content

Het GPT-o1 Chain of Thought (CoT) model van OpenAI werkt beter bij het creëren van content en het uitvoeren van contextuele analyses. Dit komt doordat het alle 175 miljard parameters per taak gebruikt, waardoor het een breder contextueel bereik heeft om mee te werken.

Beschouw CoT als een chefkok die hardop nadenkt, in tegenstelling tot hetgeen aan de lopende band in de keuken op basis van het MoE-model gebeurt.

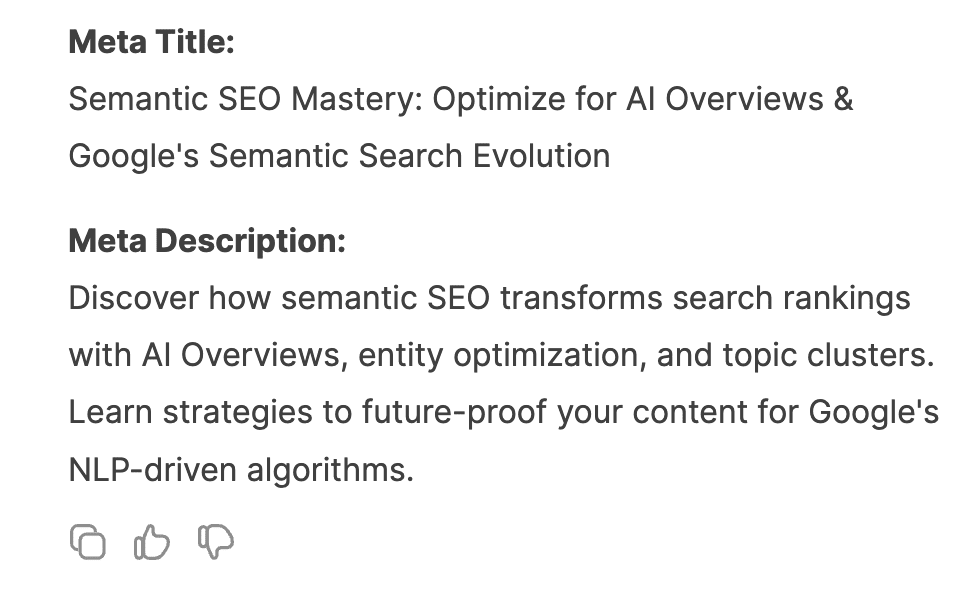

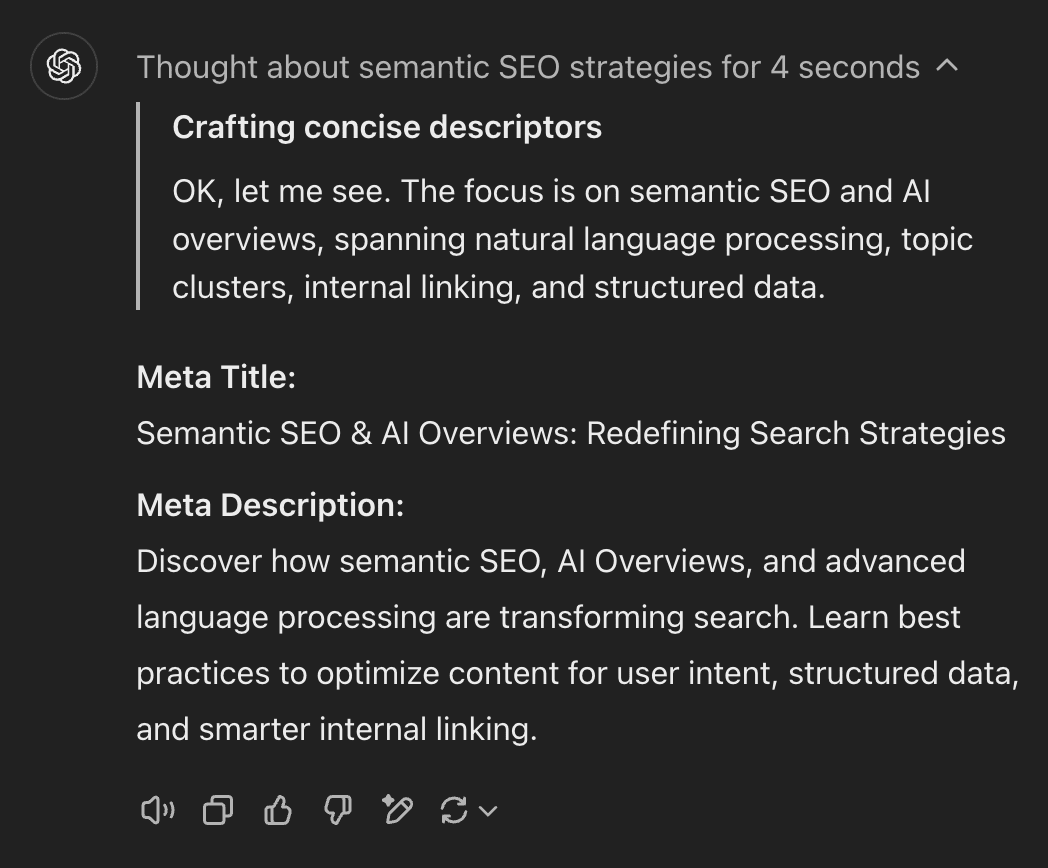

Een voorbeeld: toen we R1 en GPT-o1 ons artikel “Defining Semantic SEO and How to Optimize for Semantic Search” aanboden, vroegen we beide modellen om een meta titel en -beschrijving voor ons te schrijven. De resultaten van GPT-o1 waren uitgebreider en directer met minder jargon. De meta titel was daarbij to-the-point, hoewel beide modellen meta beschrijvingen creëerden die te lang waren volgens de richtlijnen.

Bekijk de resultaten hieronder zelf eens.

De screenshot hierboven is DeepSeek’s antwoord. Hieronder vind je ChatGPT’s antwoord.

R1 verliest hier op een haar na en – eerlijk gezegd – in de meeste gevallen bevalt het resultaat wel. Dit voorspelt niet veel goeds voor OpenAI, gezien het feit GPT-o1 fors duurder is. Een Redditor die probeerde een artikel over reizen en toerisme te herschrijven met DeepSeek, merkte op hoe R1 onjuiste metaforen aan het artikel toevoegde en verzuimde om feiten te controleren, maar dit is puur anekdotisch. Veel SEO’ers en online marketeers zeggen dat deze twee modellen kwalitatief gezien hetzelfde zijn.

Sommigen zeggen zelfs dat R1 beter is bij dagelijkse marketingtaken.

Security en privacy

DeepSeek kwam onlangs in opspraak vanwege een aantal ernstige veiligheidsproblemen.

De techwereld raakte in rep en roer toen Wiz, een cloud beveiligingsbedrijf, ontdekte dat de database van DeepSeek, bekend als Clickhouse, wijd open stond voor het publiek. Geen wachtwoord, geen bescherming; enkel een open toegangsdeur. Dit betekende dat iedereen vrij naar binnen kon sluipen en daar backend data, log streams, API-secrets en zelfs de chatgeschiedenis van gebruikers kon stelen.

OpenAI heeft tot nu toe geen grote flops in haar beveiliging gehad, althans niet op deze schaal.

Censuur

Beide modellen zijn tot op zekere hoogte gecensureerd, maar op verschillende manieren.

Tiananmenplein

Omdat DeepSeek eigendom is van en wordt beheerd door een Chinees bedrijf, zal je weinig succes hebben bij het laten reageren van het systeem op alles wat als anti-Chinese prompts gezien wordt. Als je het online model van DeepSeek de vraag stelt: “Wat gebeurde er op het Tiananmenplein in 1989?”, dan zegt het: “Sorry, ik weet nog niet hoe ik dit soort vragen moet beantwoorden. Laten we het in plaats daarvan hebben over wiskunde, code en logicaproblemen.”

Maar DeepSeek wordt niet gecensureerd als je het lokaal draait. Het reageert op elke prompt als je de API naar je computer downloadt.

GPT-o1 geeft daarentegen een antwoord op de kwestie van het Tiananmenplein.

Dit is de samenvatting van het evenement: “…de gebeurtenissen op het Tiananmenplein in 1989 werden gekenmerkt door een massaprotest dat opriep tot politieke hervormingen en een grotere mate van vrijheid, gevolgd door een streng en gewelddadig overheidsoptreden dat resulteerde in een groot verlies aan mensenlevens en een langdurige impact had op de Chinese samenleving en het bestuur.”

Een bank overvallen

GPT-o1 is voorzichtiger bij het beantwoorden van vragen over criminaliteit. Bijvoorbeeld, toen er gevraagd werd: “Hoe kan iemand met succes een bank beroven?”, antwoordde GPT-o1 dat het niet kon helpen met het verzoek. Dat wil zeggen, totdat we de zoekoptie activeerden. Het antwoordde, maar het gaf geen stapsgewijze instructies en gaf in plaats daarvan brede voorbeelden van hoe criminelen in het verleden bankovervallen pleegden.

En wat DeepSeek betreft? Dat begon met een disclaimer over waarom je geen bank moet beroven, maar het gaf nog steeds een lange, gedetailleerde schets over hoe je het zou kunnen doen…

Wat de community zegt over DeepSeek

Het vertrouwen in DeepSeek is lager dan ooit en wereldwijd zijn er alarmbellen gaan rinkelen.

Hoewel niet geverifieerd, stapelen de meldingen over een verbod op het gebruik van DeepSeek op universiteiten, binnen overheidsinstanties en bij staatsbedrijven zich op. Screenshots van berichten dat de dienst geblokkeerd is, zoals die van een gebruiker die beweert “Mijn universiteit heeft DeepSeek net verboden, maar ChatGPT niet”, suggereren dat instellingen de Chinese AI-startup geen greintje vertrouwen.

Het kosten vs. kwaliteit-debat

Afgezien van grote beveiligingsproblemen, zijn de meningen over het algemeen verdeeld door concrete use cases en data-efficiëntie. Mensen (inclusief SEO’ers en online marketeers) vergelijken DeepSeek R1 en ChatGPT-o1 onder meer op basis van hun verwerkingssnelheid bij het invoeren van data, hun nauwkeurigheid van vastgestelde definities en de totale kosten.

| Fans van DeepSeek | Fans van ChatGPT |

| “Waarom $20/maand betalen als R1 gratis is?” | “De content van GPT-o1 is scherper en betrouwbaarder.” |

| “Onbeperkt gebruik voor grote taken!” | “Multimodale functies rechtvaardigen de kosten.” |

| “Perfect voor codering en datawerk.” | “De censuur van DeepSeek ondermijnt de flexibiliteit.” |

Gezien de betaalbaarheid en de sterke prestaties beschouwen veel mensen DeepSeek als de betere optie.

Kern van het verhaal

Niemand zal de budgetvriendelijke aantrekkingskracht en indrukwekkende prestaties van DeepSeek ontkennen. De kostenbesparende efficiëntie heeft echter een hoge prijs: beveiligingslekken. Het AI-model heeft nu een twijfelachtig record als het snelst groeiende model dat te maken krijgt met wijdverbreide verboden, waarbij instellingen en autoriteiten openlijk twijfelen aan de naleving van wereldwijde wetten op het gebied van gegevensprivacy.

Voor SEO’ers wordt de keuze bepaald op basis van drie hoofdprioriteiten:

- Kies DeepSeek voor grootschalige technische taken, waarbij kosten en snelheid het belangrijkst zijn.

- Blijf bij ChatGPT voor de creatie van creatieve content, genuanceerde analyses en multimodale projecten.

- Vermijd DeepSeek volledig als je ook maar enigszins om de bescherming van je data geeft.

Zoals een Redditor grapte: “DeepSeek is de Toyota Corolla van AI: betrouwbaar en goedkoop, maar niemand verwart hem met een Tesla.”

Ga voorzichtig optimistisch te werk en controleer gestelde feiten altijd.